Pour une politique ambitieuse des données publiques (2011) chapitre 1

|

Les données publiques au service de l’innovation et de la transparence Partie 1 - « Open Data » : Contexte et enjeux d’une question sociétale Chapitre I. Données publiques : émergence d'une question sociétale |

Les évolutions technologiques récentes ont rendu possible le partage rapide et aisé de tous types de données. Elles réactivent, sous un jour nouveau, le débat déjà ancien sur l’accès aux documents administratifs, maintenant sous forme électronique et bien plus aisément diffusables.

L’Internet a fait apparaître une économie des données. Les stratégies de croissance des acteurs du Web, via l’ouverture de leurs interfaces de programmation (API), ont illustré le potentiel de la réutilisation des données, et suscité des attentes similaires des développeurs vis-à-vis du secteur public. Ils exercent une pression pour que les États, en facilitant l’accès à leurs informations, s’insèrent et tiennent leur rang dans ce « Web des Données ».

Ces ruptures technologiques ont accompagné par ailleurs une prise de conscience de l’importance des données produites par l’administration et le secteur public. La possibilité novatrice de réutiliser ces données sous forme brute, pour leur trouver de nouveaux usages utiles et instructifs, a abouti à l’émergence de la question des données publiques en tant que véritable question sociétale.

|

Le rapport

École des Ponts ParisTech. 2011. Pour une politique ambitieuse des données publiques : Les données publiques au service de l’innovation et de la transparence. Rapport à la Délégation aux usages de l’Internet, remis au Ministre de l’Industrie, de l’Énergie et de l’Économie numérique le 13 juillet 2011. Les auteurs

Table des matières

La réédition Wicri

Ce rapport fait l'objet d'une réédition et de réutilisations dans le réseau Wicri. Le texte a été importé dans son intégralité et mis en forme dans un contexte hypertexte. Ce travail a été réalisé par l'équipe Wicri et par des volontaires de l'INIST et du SGAR de Lorraine. Quelques adaptations légères ont du être opérées et figurent dans les pages de discussion. Les principales réutlisations de parties de document sont mentionnées en fin des pages correspondantes. |

La donnée au cœur des nouveaux usages

Internet et les ruptures technologiques récentes ont fait apparaître une nouvelle « économie des données ».

- (i) Le Web est structuré autour de l'échange de données

- Le génie informatique (computer science dans le monde anglo-saxon) est défini comme la manipulation algorithmique de données et de leurs structures de représentation. Le Web, avant d’être un phénomène social, est une architecture logicielle[1] conçue par un chercheur britannique en physique des hautes énergies au CERN, Sir Tim Berners-Lee[2]. Elle avait pour but de faciliter l’accès et le référencement de documents en symbolisant leur manipulation sous forme de phrases, liant verbes intuitifs (lire, afficher, remplacer, effacer) et métadonnées d’adressage universel (URL ou Uniform Resource Locator[3]).

- Bien que basées sur un réseau d’échange de documents, les techniques du Web ont naturellement développé un tropisme de plus en plus marqué vers les données elles-mêmes. L’introduction des bases de données relationnelles dans les outils de développement a permis la création de sites dynamiques, c’est-à-dire dont les pages s’adaptent aux circonstances (évolutions de prix, listes d’objets changeants, « unes » de journaux électroniques mises à jour fréquemment). À partir de 2004, une technique émergente a vu le jour qui consiste à utiliser les fonctionnalités de scripting[4] présentes dans les navigateurs pour permettre la mise à jour en temps réel de pages déjà chargées, en allant chercher en tâche de fond des données remises à jour. Nommée AJAX [5] pour JavaScript Asynchrone et XML (Asynchronous Javascript And XML), à partir du langage de scripting JavaScript et du format d’échanges de données XML, cette technique à la croisée de différentes technologies Web est reconnaissable derrière des applications Web hautement réactives dont les pages ont rarement besoin d’être rafraîchies – telles que GMail [6], Quora [7] ou Facebook [8].

- Pour supporter cette technologie, de plus en plus d’applications en ligne ont développé à la fois deux interfaces : une interface graphique classique accessible aux utilisateurs à travers leur navigateur, et une interface exclusivement consacrée aux machines, qui permet justement au moteur de scripting du navigateur de récupérer des données à la volée. C’est cette interface, qu’on peut se représenter comme un protocole d’échange de données de machine à machine, qu’on appelle interface de programmation ou API (sigle anglophone pour Application Programming Interface).

- (ii) La donnée, monnaie d'échange et levier d'influence sur le Web

- Les API sont devenues un véritable outil stratégique pour les sociétés de services en ligne [9]. Par exemple, c’est dans une large mesure grâce à l’ouverture de leur API [10] que Twitter a pu permettre à une communauté de développeurs de se créer, et de multiplier les applications permettant d’utiliser le service en dehors du site Web principal (notamment dans les premiers jours de l’App Store d’Apple durant l’été 2008). Ce grand nombre d’applications a servi de « force de vente » virtuelle pour Twitter, et est un des facteurs principaux qui expliquent son succès populaire.

- Bien documentées et basées sur des standards acceptés (tels que JSON ou XML) pour éviter les problèmes d’interopérabilité, ces interfaces s’adressent à des développeurs informaticiens. Selon le degré d’ouverture (fonction des choix stratégiques de la société) et les conditions de licences (souvent conçues pour encourager la réutilisation) consentis à ces derniers, ils peuvent extraire, éventuellement modifier, et transformer les données du service Web en question, pour les réutiliser, notamment à la construction de nouveaux services ou de nouvelles applications.

- L’échange est mutuellement bénéfique : le nouveau service, consommateur de données, gagne en utilité pour ses utilisateurs, et le système producteur voit sa position compétitive renforcée par la dépendance accrue du marché à ses services. En l’essence, c’est une transaction de marché où l’accès à des données est échangé contre leur diffusion à un nouveau public ou dans un nouveau contexte.

- L’exposition d’une interface API est aujourd’hui une étape presque obligée du développement d’un nouveau produit en ligne. La généralisation de ce phénomène est d’une grande importance pour la question des données publiques, car elle a permis de prendre conscience de l’omniprésence des données derrière les services qu’utilisent quotidiennement les internautes.

- En un mot, « l’économie des données » s’est construite autour de l’échange et de la fluidité sur le Web : les données ont souvent plus de valeur comme outil d’échange et d’influence qu’isolées au sein des entrepôts de données des entreprises[11].

- (iii) Avec le Web 2.0, la données devient collective

- Un corollaire de la montée en puissance de la donnée est son rôle de liant social sur le Web. En particulier, avec l’apparition de phénomènes de collaboration de masse tels que Wikipedia, on s’aperçoit que l’échelle d’échanges rendue possible par Internet ouvre des possibilités insoupçonnées jusqu’alors.

- Des services tels que Delicious (site de partage de bookmarks, qui agrège les catégories dans lesquelles les utilisateurs rangent différents liens, et permet ensuite de trouver des liens par catégorie d’intérêt) ou Flickr (qui permet de chercher des photographies libres de droits sur un sujet particulier, en se basant sur les tags de catégorisation produits par l’ensemble des utilisateurs) ont ainsi profité de ce phénomène de folksonomy, la taxonomie par les foules ou classification par l’intelligence collective[12].

- D’autres services tels qu’Amazon ou Netflix ont, eux, profité de la masse d’utilisateurs se servant de leurs sites pour en extraire des modèles de préférences des consommateurs, qui leur permettent de faire des recommandations hautement personnalisées selon les goûts de leurs clients.

- L’un des enseignements de la nouvelle incarnation sociale et collaborative du Web, c’est que la valeur des données n’est pas intrinsèque, mais dérive de leur agrégation, de leur recoupement, de leur analyse et de la réutilisation qui en est faite.

- Le Web a ainsi mis à jour une économie des données, qui joue un rôle de monnaie d’échange parmi les entreprises d’Internet et les services en ligne.

- (iv) Données géographiques et "mash-ups"

- L’autre développement technologique qui a conduit à prendre conscience de l’importance des données, c’est la démocratisation de l’information géographique.

- Google indique par exemple que son approche est « d’utiliser la géographie pour organiser toute l’information mondiale, qu’elle soit géographique ou non. C’est un principe d’organisation qui sera utilisé pour mieux comprendre l’information. »[11].

- Si les briques technologiques sont disponibles pour utiliser et manipuler la donnée géographique à loisir, ou même pour l’utiliser pour structurer d’autres données, le défi qui reste posé est celui de la constitution d’une véritable infrastructure des données géographiques. Ces données sont aujourd’hui accessibles en nombre et de qualité, mais les repérer et les réutiliser peut rester obscur et complexe[13].

- Conséquence récente des évolutions du Web, des applications cartographiques puissantes réservées jusque-là à des experts sont devenues accessibles à tous. Le monde du Web collaboratif a largement repris à son compte la possibilité de représenter des données sur des cartes. Grâce à l’ouverture gratuite (dans des limites relativement larges de volume) de son API, Google Maps est devenu une base de choix pour la création de « mashups », ces applications Web combinant « différentes sources au sein d’une seule plateforme, (…) l’une des facettes du design collaboratif sur le Web[14] ». Cette nouvelle tendance a connu un tel succès au tournant des années 2006 à 2008 que le prestigieux Museum of Modern Art de New York y a consacré une exposition phare[15].

- Au-delà de l’incidence culturelle de ce phénomène[16], la réappropriation du local et de l’espace géographique par le biais du Web et du mobile annonçait l’importance croissante de la donnée informatique géographique, et, au-delà, l’émergence du phénomène culturel du remix et de la réutilisation des données.

Les données publiques et leur réutilisation

La génération des digital natives, qui a grandi dans l’habitude de la réutilisation, du remix et de la recombinaison permanente, devait nécessairement s’intéresser aux informations collectées par l’État. L’émergence de la réutilisation des données publiques comme sujet de société, poussée par les nouveaux usages, a révélé une chaîne de valeur fondée sur ces données qui, lorsqu’elles sont mises à disposition de façon brute et réexploitable, permet aux développeurs et aux entrepreneurs de créer de nouveaux services.

- (i) Les données numériques ont vocation à la diffusion la plus large

- Contrairement aux documents papiers dont l’impression engendre des coûts variables conséquents et qui nécessitent des délais de traitement et d’acheminement, les données numériques ont un coût marginal de diffusion nul ou presque [17], et sont accessibles quasiment instantanément. Le travail éventuel de mise à disposition de données numériques est donc un coût fixe : la diffusion la plus large, en distribuant ce coût, est donc le modèle le plus efficace d’un point de vue économique.

- Le travail éventuel de mise à disposition de données numériques est donc un coût fixe : la diffusion la plus large, en distribuant ce coût, est donc le modèle le plus efficace d’un point de vue économique.

- L’instantanéité de diffusion et l’ubiquité d’accès offrent de plus des perspectives tout à fait nouvelles en terme de périmètre de diffusion et d’audience potentielle, notamment au regard de la démocratisation de l’Internet.

- (ii) Combiner les données brutes amplifie leur potentiel

- Marqué par les traditions et les habitudes d’un monde de communication par le papier, l’État diffuse le plus souvent ses informations sous forme de « produits finis », tels que des analyses, des pages Web explicatives ou des rapports écrits – en quelque sorte des données « retravaillées » afin d’être intelligibles par tous. À l’inverse, les données brutes qui sous-tendent ces études sont rarement mises à disposition du public, car leur intérêt pour une réutilisation potentielle est encore très inégalement perçu par les producteurs de données publiques.

- Aujourd’hui, les technologies de l’information permettent une mise à disposition des données à l’état brut. Loin d’être un obstacle à leur réutilisation ultérieurement à leur mise à disposition par l’administration, leur caractère brut permet au contraire de les recombiner plus facilement, ce qui amplifie leur potentiel et permet la création de services impossibles à réaliser sans ces croisements.

- Par exemple, des mesures locales de bruit permettent de mettre en perspective la corrélation positive mesurée entre les dépenses énergétiques d’un ménage et son taux d’équipement en doubles vitrages, paradoxale au premier abord. Dans le cadre d’un concours organisé par la ville de Washington, D.C., des données sur les vols, croisées avec les tracés des pistes cyclables, ont aussi permis de créer une carte des zones à éviter pour les cyclistes.

- Parce qu’elle favorise ces croisements et ces combinaisons fertiles sur des sujets recoupant des champs extrêmement vastes de l’économie, de la société et de l’environnement, la mise à disposition des données brutes de l’État et des collectivités est un terreau fertile pour des réutilisateurs, qui peuvent inventer de nouveaux usages à ces données.

- (iii) Les données publiques et leur réutilisation sont à l'origine d'une chaîne de valeur

- L’État et le secteur public au sens large, dans le cadre de leurs opérations, touchent à l’ensemble des secteurs de notre économie, notre société et notre environnement. Les données qu’il collecte sont donc naturellement riches et très variées ; certaines ont une forte valeur économique. Le marché de l’information est estimé en France à 3,7 milliards d’euros dont 60 % sont des données publiques[18]. Au niveau européen, ce chiffre représenterait près de 27 milliards d’euros[19] par an.

- La valorisation passe par différentes étapes nécessaires pour rendre les données publiques utilisables ou réutilisables. D’une part l’institution productrice doit définir précisément quelles données elle doit diffuser en ligne et de quelle manière, par un travail d’analyse et de collecte. S’imposent à ce stade le respect de critères de bon sens comme la protection de la vie privée, de la propriété intellectuelle des tiers, ou de la sécurité nationale.

- D’autre part, pour faciliter la réutilisation, l’institution productrice doit s’assurer de fournir une donnée qualifiée et mise à jour. Pour cela, il semble important de créer des lots de données cohérents et de s’assurer de la présence d’une légende et plus généralement de la présence des métadonnées.

- Il faut les mettre à disposition via un support adapté mais en réalisant un catalogage précis : il ne suffit pas de mettre à disposition des données, encore faut-il qu’elles puissent être découvertes et facilement accessibles grâce à un portail de données publiques ou un moteur de recherche.

- Enfin, les données publiques numériques mises à disposition peuvent être réutilisées par la communauté des développeurs et des entrepreneurs, qui peuvent leur inventer de nouveaux usages. Ces données représentent aussi un outil interne au service des administrations, qui peut leur permettre des échanges d’information plus fluides et efficaces.

- (iv) La visualisation de données joue un rôle structurant

- Les données géographiques ont un rôle structurant dans la chaîne de valeur. Elles rendent possible la spatialisation et la visualisation sur carte d’autres jeux de données, notamment géolocalisées. Selon l’Association Française pour l’Information Géographique (AFIGÉO)[20], 80 % des informations qui sont utilisées possèdent une dimension géographique. Cela leur confère donc une importance particulière à la fois d’un point de vue technique, mais aussi en tant qu’outil de recoupement et de recombinaison de données.

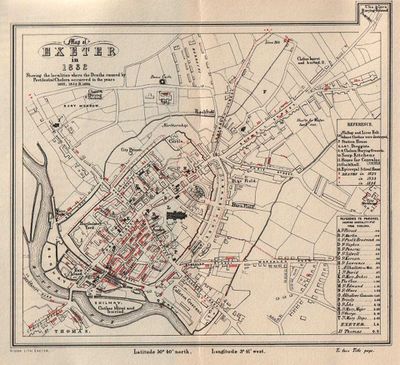

- Ainsi, dès 1854, John Snow détermina les causes de la propagation du choléra grâce à la visualisation de données sur une carte. À cette époque, on pensait que la maladie se propageait par inhalation. Le médecin superposa sur une carte les adresses des victimes du choléra à Exeter (quartier de Londres) durant un épisode aigu, et constata qu’elles coïncidaient avec l’accès à la pompe à eau de la Broad Street. Par déduction, il en conclut au rôle de l’eau et des conditions sanitaires dans la propagation de l’épidémie, ce qui permit de la contrôler, et de réduire drastiquement le taux de mortalité lié à cette pathologie dans les décennies qui suivirent.

- De manière plus générale, le succès de l’infographie en ligne et des nouveaux modes de visualisation dynamique ont amené les graphistes et designers à rechercher de nouvelles informations et de nouvelles sources de données à mettre en scène dans leurs productions.

- Le processus de recherche, d’analyse puis de représentation graphique synthétique des données sous forme interactive, qui s’apparente à du journalisme et qu’on appelle parfois « datajournalism » ou journalisme de données, a participé à créer une demande pour plus de transparence de la part des gouvernements, et à l’émergence du sujet de la réutilisation des données publiques.

Les données publiques offrent, par le biais des réutilisations qui peuvent en être faites, un fort potentiel d’innovation, tant à titre commercial que pour la recherche, le développement de nouveaux services aux citoyens ou l’amélioration du travail de l’administration.

Les nouvelles possibilités de recombinaison et de réutilisation offertes par les technologies de l’information ont révélé l’importance de leur réutilisation, et contribué à en faire une question sociétale.

Notes originales

- ↑ World Wide Web Consortium (W3C), 2010, HTTP – Hypertext Transfer Protocol Overview – draft 09.

<http://www.w3.org/Protocols/> - ↑ World Wide Web Consortium (W3C). Sir Tim Berners-Lee: Bio. Téléchargée le 10 janvier 2011.

- ↑ World Wide Web Consortium (W3C). 1994. Uniform Resource Locators (URL) : A Syntax for the Expression of Access Information of Objects on the Network.

<http://www.w3.org/Addressing/URL/url-spec.txt> - ↑ Capacité d’un navigateur à faire tourner dynamiquement un programme qui agit en temps réel sur la page affichée. Par exemple, une page qui affiche l’heure repose sur un script qui demande au navigateur de mettre à jour l’heure, les minutes et les secondes à mesure qu’elles s’écoulent. Dans le cas d’un service de courrier en ligne, c’est souvent un script qui réagit au click sur l’intitulé d’un email et change l’affichage pour détailler le contenu du mail plutôt que celui de la boîte de réception. C’est aussi un script qui vérifie automatiquement l’arrivée de nouveaux courriers en tâche de fond, et réintègre éventuellement ces nouvelles données dans le corps de la page affichée.

- ↑ Garrett, J.J. 18 février 2005. « Ajax : A New Approach To Web Applications ».

<http://www.adaptivepath.com/ideas/essays/archives/000385.php> - ↑ GMail, service de boîte de courrier électronique en ligne de Google, Inc.

- ↑ Quora, Inc., site de questions et réponses dynamique caractérisé par l’expertise pointue de sa communauté d’utilisateurs, fondé en 2009 et qui a connu une très forte croissance en 2010.

- ↑ Facebook, Inc., le réseau social dominant qu’on ne présente plus, fondé par Mark Zuckerberg en 2004 et approchant 600 millions d’utilisateurs début 2011.

- ↑ Shah S., 28 August 2010, « Cannibalize Business Development by Popularizing your API » :

<http://shaivalshah.com/cannabilize-business-developmentby-populariz> - ↑ Entretien le 12 novembre 2010 avec Henri Verdier, Président de Cap Digital

- ↑ 11,0 et 11,1 Ed Parsons - Geospatial Technologist for Europe, Middle East and Africa chez Google, au séminaire « Innovations et développement du secteur de l’information géographique » organisé le 5 octobre 2009 à la Grande Arche de la Défense par le Conseil National de l’Information Géographique (CNIG), l’AFIGÉO et l’Institut des Sciences et des Techniques de l’Équipement pour le Développement (ISTED)

- ↑ Tapscott, D. and Williams, A. 2006. Wikinomics : How Mass Collaboration Changes Everything.

- ↑ Voir l’intervention de Max Craglia, coordonnateur technique d’Inspire pour la Commission Européenne (centre commun de recherche) au séminaire « Innovations et développement du secteur de l’information géographique » organisé le 5 octobre 2009 à la Grande Arche de la Défense par le Conseil National de l’Information Géographique (CNIG), l’AFIGÉO et l’Institut des Sciences et des Techniques de l’Équipement pour le Développement (ISTED)

- ↑ Google Earth mashups 5 of 14, in « Design and the Elastic Mind. » Museum of Modern Art. New York, NY. 2008.

<http://www.moma.org/interactives/exhibitions/2008/elasticmind/#/98/> - ↑ « Design and the Elastic Mind. » Museum of Modern Art. New York, NY. 2008.

<http://www.moma.org/interactives/exhibitions/2008/elasticmind/> - ↑ Lessig, L. 2009. Remix : Making art and commerce thrive in the hybrid economy. http://remix.lessig.org/

- ↑ Les volumes qui peuvent être atteints font que le coût de diffusion n’est en revanche pas négligeable et peut dans certains cas devenir important.

- ↑ Voir à ce sujet le chantier ministériel initié le 30 juin 2010, Innover au service du citoyen.

- ↑ Dekkers, M. et al., 2006, « MEPSIR, Measuring Public

Sector Information Resources, Final Report of Study on Exploitation of public sector information »,

http://ec.europa.eu/information_society/policy/psi/docs/pdfs/mepsir/final_report.pdf - ↑ http://www.afigeo.asso.fr/