Une IA fiable et démocratique made in Europe est-elle possible ? (VSOC 1 2019-2020)

Benoît Hervieu

Fin du fin de l’intelligence artificielle, l’apprentissage profond – « deep learning »[1] - est gourmand en données. Si toutes ne sont pas fiables, nombreuses sont sujettes aux attaques et aux dévoiements. Comme démocratiser leur accès et leur traitement tout en les sécurisant ? La problématique engage la prochaine révolution de l’IA.

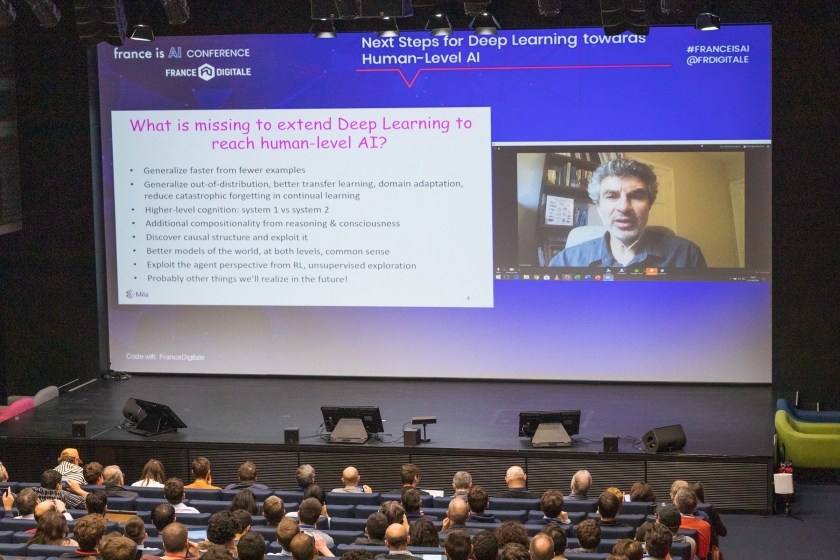

Un tournant de l’intelligence artificielle aurait-il commencé ? La quatrième édition de France is AI, qui a réuni à l’initiative de France Digitale le 23 octobre dernier près de 2 000 participants au sein de l’incubateur parisien Station F, en aura paradoxalement montré le chemin en déconstruisant la notion même d’intelligence « artificielle ». Le pari semblait risqué. Il était nécessaire, car le développement de l’IA rencontre aujourd’hui un tournant. « Les prochaines étapes de l’apprentissage profond consisteront en une IA à niveau humain », prédit le lauréat du prix Turing 2018 Yoshua Bengio. Une IA plus aussi « artificielle » que son nom l’indique. Qu’est-ce à dire ?

L’enjeu est autant politique que technologique. Les modèles d’apprentissage brassent beaucoup de données et de plus en plus. Dans ce flux massifié se pose la question de leur valeur. Moissonner des données, c’est déjà les traiter comme le rappelle l’ambassadeur de France pour les Affaires digitales Henri Verdier à l’appui d’un récent exemple à ne pas suivre survenu en Autriche. « L’utilisation de l’IA pour favoriser le retour à l’emploi a abouti à une discrimination de fait, au seul avantage des hommes blancs trentenaires. »

Cofondateur de la petite start-up Citrusbrain, vouée à l’accompagnement d’entreprises dans le développement de solutions IA, Mohamed Amghari recourt à une formule radicale. « L’IA n’existe pas. La machine n’invente rien toute seule. Elle prédit et produit à partir de ce qu’on lui donne. Comprendre l’algorithme ne suffit pas. Il faut comprendre le moment où la donnée va nourrir l’algorithme et pour cela, elle doit être fiable, avec le moins de biais possible. » Tout le monde n’étant pas Data Scientist[2] pour le vérifier.

Sommaire

Panda devenu gibbon

Il faut donc du nombre et de la qualité. L’or noir de la data ne se distribue pas si facilement comme en témoigne Valentine Brueziere, responsable produit chez Digitalent. « Nous développons de l’outil IA en fonction de ce que les entreprises que nous conseillons font le choix, ou non, de transmettre », explique-t-elle. « De données suffisantes, certifiées et variées dépendra le plus important : le paramétrage selon ce que l’on veut faire dire à l’IA. » Moment clé du processus, le data set[3], autrement dit la résolution des biais affectant l’utilisation des données, implique également de tenir compte de la variabilité de ces dernières. « C’est un impératif pour ne pas avoir des modèles d’apprentissage figés », insiste Naila Murray, directrice scientifique de Naver Labs Europe, spécialisé dans les projets de vision par ordinateur. L’enjeu, coûteux, de récupération de la donnée se repose ici avec acuité. Il se double d’une autre difficulté générée par ce que l’ingénieur de l’Université de Toronto et assistant du projet Google Brain Nicolas Papernot nomme « l’environnement hostile et l’adversité ».

L’or noir du futur se dispute âprement. Combien de données empoisonnées et de filtrages indus pourrissent l’apprentissage algorithmique ? Faussée, l’artificielle « intelligence » peut produire un modèle prédictif où la même photo d’un panda rassemblera 57,7% d’adhésions à la figure dudit animal, et 99,3% à celle d’un gibbon. « L’apprentissage machine ne généralise pas toujours au mieux », constate Nicolas Papernot. « La sécurité de cet apprentissage est-elle fondamentalement différente de la sécurité informatique ? »

La confidentialité de certaines données est promise à devenir le nerf d'un « modèle européen et démocratique de l’IA, avec un traitement des données situant en son cœur le consentement de l’usager » Deux types d’attaques soulèvent cette autre grande question. Les premières sont identifiées sous le terme d’attaques « en appartenance ». Une donnée ou un élément de donnée est alors utilisé de façon à « entraîner le réseau », explique Jamal Atif, chargé de mission sciences des données et IA au CNRS et professeur à l’Université Paris-Dauphine. « Des données comme la santé d’une personne, son orientation sexuelle ou ses opinions politiques vont être exploitées sans avoir été sollicitées. » La confidentialité de certaines données est promise à devenir le nerf de ce « modèle européen et démocratique de l’IA, avec un traitement des données situant en son cœur le consentement de l’usager », qu’Henri Verdier appelle de ses vœux contre l’exemple chinois du contrôle social.

D'autant que la France pourrait être l'une des locomotives de ce modèle : pour la première fois en 2019, les startups françaises de l'IA ont attiré plus d'investissement que leurs homologues britanniques ou israéliennes, apprend-on dans une étude toute récente de France Digitale/Roland Berger.

A plus près du cerveau

Condition nécessaire, un tel cadre ne sera sans doute pas suffisant pour contrer l’autre type de menace, les « attaques adverses ». « Même les algorithmes les plus sophistiqués peuvent être trompés très facilement », prévient Jamal Atif. « Un micro-perturbateur suffit à rendre le système fou et à faire tomber sa précision à 0%. » Des solutions mathématiques complexes permettent aujourd’hui de circonvenir le danger. « En créant de la nuisance “amie” pour contrer le bruit “ennemi” », schématise le spécialiste. La maîtrise de cette guerre du calcul a de quoi mobiliser ceux dont la guerre est justement le métier. « Les systèmes IA sont vulnérables, quand on sait qu’un panneau de limitation de vitesse avec un post-it collé dessus peut être confondu avec un sens interdit », s’inquiète Emmanuel Chiva, directeur de l’Agence Innovation Défense créée en septembre 2018 au sein du ministère des Armées. Les 100 millions d’euros supplémentaires annuels et les 200 recrutements dédiés à l’IA d’ici à 2023 ne seront pas de trop pour tenir des domaines aussi stratégiques que le combat collaboratif, le renseignement, la robotique, le soutien à la décision et à la planification ou encore la cyber-défense. Or, tous ces objectifs, avec tant d’autres, n’impliquent-ils pas de transformer l’IA, au plus près du changement et du non-appris ?

C’est à cette révolution qu’appelle Yoshua Bengio « Nos modèles actuels de Machine et Deep Learning ne font que relier des statistiques régulières et superficielles. Ils ne regardent qu’une distribution de données fixes quand cette distribution est en fait mouvante », déplore le chercheur canadien. « Il faut générer de l’explication causale et des formes de raisonnement. » Le « système 1 », intuitif, inconscient et non-linguistique dévolu à l’apprentissage approfondi ne suffit plus. Il appelle une interaction avec un « système 2 », lent, logique, séquentiel et linguistique. « Il faut se rapprocher de la complexité du cerveau humain où des fonctionnalités diverses sont engagées dans ce qu’on appelle la conscience, mobilisant un contexte individuel, des émotions et des affects. » Rendre l’IA réellement intelligente, en somme. Jusqu’à envisager qu’elle puisse répondre « non » à un ordre donné ?

Notes et références

Articles complémentaires

Les plateformes reposent sur des jeunes résignés dans leur rapport au salariat

« On imagine que les robots mèneront une guerre plus propre que les humains »

Nous sommes au Moyen Âge du numérique

- Est sorti en: 1 592

- A l'école de l'intelligence artificielle (VSOC 1 2020-2021)

- Big Data, l'ogre énergétique dans le cloud (VSOC 1 2018-2019)

- Bonnes pratiques en matière d'archivage des données : stratégies, planification et produits (VSOC 1 2018-2019)

- Données : Le Vertige (VSOC 1 2018-2019)

- Green IT : cap sur l'informatique durable ? (VSOC 1 2018-2019)

- L'ADN et le quartz pour stocker nos données pour l'éternité (VSOC 1 2018-2019)

- La révolution du stockage numérique (VSOC 1 2018-2019)

- La ville numérique a besoin d'une gouvernance publique des données (VSOC 1 2020-2021)

- Le blockchain, partie intégrante de la logistique mondiale d'ici 2025 (VSOC 1 2018-2019)

- Le coût caché de l'écosystème numérique (VSOC 1 2018-2019)

- Les enjeux liés aux applications dans le cloud : mythe ou réalité ? (VSOC 1 2018-2019)

- Nos données de santé sont-elles suffisamment protégées ? (VSOC 1 2020-2021)

- Sauvegarder la mémoire de l'humanité dans une mine de sel (VSOC 1 2018-2019)

- Technologies de surveillance : le risque d’une « dystopie par accident » (VSOC 1 2020-2021)

- Trois scénarios pour un numérique plus vert (VSOC 1 2020-2021)