AMESTIST 1 Elissalde

De la navigation au savoir

De la navigation au savoir

Réflexions sur les nouveaux comportements de diffusion et d'acquisition des connaissances à travers l'expérience d'Hypergeo

| Bernard Elissalde,i Bernard.Elissalde@univ-rouen.fr |

Christine Kosmopoulos.i Christine.kosmopoulos@parisgeo.cnrs.fr |

- i - UMR IDEES, Université de Rouen, France

- ii - CNRS-UMR Géographie-cités, France.

- Mots-clés

- épistémologie, hypertextualité, encyclopédie, NTIC, apprentissage, géographie, diffusion connaissance, acquisition connaissances, processus acquisition, technologie information communication, ressource électronique, hypertexte, système dynamique, projet, France, Hypergeo, CNRS (Centre national de la recherche scientifique)

- keywords

- knowledge dissemination, knowledge acquisition, acquisition process, epistemology, information communication technology, digital resource, encyclopedia, hypertext, dynamical system, project, France, Hypergeo, CNRS (Centre national de la recherche scientifique)

- Résumé

- A partir de l’exemple de l’encyclopédie électronique en accès libre Hypergeo, cet article mène une réflexion sur la question des conditions de diffusion de connaissances fiables par les documents mis en ligne et sur les modifications apparues dans les modes d’apprentissage en liaison avec de nouveaux instruments tels que les moteurs de recherche et les liens hypertextes.

Sommaire

- 1 Introduction

- 2 L'esprit d'Hypergeo : les interactions entre technologies et discursivité géographique

- 3 2 De la conception initiale d’Hypergeo, au système hypertextuel dynamique

- 4 L'architecture hypertextuelle et la production de sens

- 5 Les hyperdocuments ouvrent-ils la voie à une nouvelle forme d'accès au savoir ?

- 6 Conclusion

- 7 bibliographie

- 8 Notes

Introduction

Le projet Hypergeo[1] est né dans le cadre du Groupe de Recherche (GDR) Libergéo lancé en 2001. Il consiste à réaliser, à partir de textes originaux, une encyclopédie électronique, consultable en ligne en libre accès et présentant les principaux concepts et théories de la Géographie contemporaine. L’originalité technique d’un tel projet à vocation épistémologique repose sur l’utilisation de liens hypertextes permettant de naviguer entre les définitions organisées selon un réseau sémantique.

A la base de ce projet d'encyclopédie hypertextuelle, on retrouve l'idée, déjà ancienne, développée dans les années 60 par T .Nelson, consistant en une remise en cause de la linéarité de la lecture des supports papier traditionnels et de la hiérarchisation de l'accès au savoir (classement en rubriques, classes, sous-classes) par la communauté scientifique. La position critique, à l'origine de la remise en question de la forme adoptée par les textes traditionnels, se fonde sur l'observation du décalage entre les modes d'organisation classiques de transmission du savoir et le fonctionnement de l'esprit humain qui s'organise par associations d'idées et retours en arrière selon un réseau complexe et pluridimensionnel propre à chaque individu (Giry et Lucier, 1996) [9].

Les réflexions qui suivent se veulent une contribution aux débats sur les relations entre les possibilités offertes par les innovations technologiques, et d’éventuelles modifications dans l’acquisition des connaissances par les utilisateurs, et les contenus scientifiques eux-mêmes.

L'esprit d'Hypergeo : les interactions entre technologies et discursivité géographique

Le GDR Libergéo du CNRS (depuis 2006 il s'agit du GDRE S4 : European Research Group Spatial Simulation for Social Sciences), met en réseau des activités menées par des équipes de recherche française en géographie. Il s’agit, par la confrontation de perspectives théoriques, l’échange de méthodologies, la mise en commun des résultats et la valorisation, d’atteindre la masse critique qui confère une visibilité internationale. Son objectif est de faire travailler ensemble des laboratoires pour mener à bien des réalisations qui dépassent la capacité d’un seul, comme le développement d’outils interactifs pour la modélisation et la simulation, la mise en ligne d’une encyclopédie des concepts de la géographie, ou la diffusion sous forme d’atlas, d’ouvrages et de manuels, de résultats de recherche validés par des confrontations multiples.

Qu’en est-il des publications scientifiques francophones sur le web au moment où démarre le projet Hypergeo ? A travers une étude publiée en 2002 par Christine Kosmopoulos sur les revues francophones strictement électroniques en géographie, en accès libre, et comportant un comité de lecture, il s’avère que seule Cybergeo répond à l’ensemble de ces critères. Denise Pumain, la fondatrice, publie en 1997 un an après sa création, un article dans Environment and Planning A "Are cyberjournals a promised land for research communication ? ", où elle expose les avantages que la communauté scientifique peut tirer de cette nouvelle forme d'édition tout en insistant sur les risques que comporte cet immense potentiel d'informations et la difficulté de le réguler. Mais en dehors de ces rares pionniers, force est de constater que la France accuse un grand retard dans ce domaine, alors que dans les pays anglo-saxons la mise en ligne des cours et des revues s’est développée à une très grande échelle depuis plusieurs années.

Par la suite, d’autres initiatives locales au sein des laboratoires voient le jour comme revues.org fondée en 1999 par Marin Dacos, mais dans sa discipline Hypergeo reste une expérience inédite non seulement en France, mais aussi en Europe. Elle se distingue par la spécificité de son projet : une encyclopédie des concepts de la géographie, plurilingue, validée par un comité de lecture et en libre accès[2].

La finalité d’une encyclopédie consacrée aux concepts de la géographie, fonctionnant selon les principes de l’hypertextualité, est de permettre de reconstruire les éléments épars d’un discours disciplinaire, de replacer la disposition des différentes notions géographiques par rapport à des courants théoriques et d’organiser les positions relatives des unes par rapport aux autres, pour finalement mettre en évidence sous une forme dynamique les enjeux épistémologiques contemporains. A la différence d'un dictionnaire ou d'un livre dont l'organisation finie repose soit sur une seule indexation, soit sur une lecture linéaire, l'hyperdocument autorise une navigation entre les notions et la constitution de parcours d'apprentissages propres à chaque utilisateur.

Un des objectifs était donc de rendre compte d’un sens et d’une cohérence globale de la discipline, de ses problématiques, en s’appuyant sur les itinéraires de liens hypertextes proposés par les concepteurs. Dans cette perspective, l’adéquation entre l’écriture, le volume de chaque article et le type d’utilisateur potentiellement concerné, a été également une des préoccupations majeures des concepteurs. Il s'est agi de penser la relation entre l’objectif didactique et l’architecture du site de façon à ce qu’il n’existe aucune contradiction entre l’efficacité de l’apprentissage et les possibilités de navigation et de recherche offertes par l’encyclopédie. Le mode de fonctionnement et de relations propres aux GDR, ainsi que la nécessité de clarifier l’organisation en paradigmes des différentes notions et théories de la discipline géographique semblait se prêter à l’expérimentation, par l’intermédiaire des NTIC, à un nouveau mode d’accès aux corpus des notions géographiques.

On a pu observer à cette occasion, combien l'aspect technique (transmission) et l'aspect sémantique (information) se trouvent étroitement liés dans la conception d'un site. Au développement d’une certaine politique éditoriale, vient s’ajouter sur la toile une dimension nouvelle qui précisément associe la technique au contenu et qui n'a pas son équivalent dans l'édition papier. La prise de conscience de cette dimension conduit à des choix qui s'avèrent plus d'ordre philosophique qu'à proprement parler de ligne éditoriale et qui peuvent se traduire en marge de liberté laissée au lecteur dans sa navigation. Nous verrons plus loin que cette navigation s’exerce bien entendu à l’intérieur de contraintes, mais elle présente l’avantage de s’associer à la démarche heuristique de l’encyclopédie par l'observation du parcours propre à chaque internaute.

Du point de vue du contenu, les concepteurs ont pris soin d’éviter la reproduction d'une version multimédia de recueils des "grands textes" fondateurs de la discipline que l'existence d’ouvrages tel que Deux siècles de Géographie française (Pinchemel Ph., Robic M.-C., Tissier J.-L., 1984), aux qualités et à l'exhaustivité reconnues, aurait rendu inutile et "gratuite", même en y ajoutant la magie des nouvelles technologies. Afin de ne pas s'inspirer du caractère par trop "généalogique" d'autres livres d'initiation à la pensée géographique, l'accent a été mis principalement sur la diversité des approches contemporaines du discours géographique. Ce choix n'exclut pas, néanmoins, quelques références à des auteurs plus anciens qui permettent « d'historiciser » certains courants de pensée et certains concepts. Sur le plan théorique, le réseau notionnel d’Hypergeo a été construit autour de quatre champs disciplinaires : Spatialité des sociétés, Environnement et sociétés, Régions et territoires, et enfin Géographie, pour toutes les notions transversales. Ce découpage a été guidé par le souci principal des concepteurs de ne pas reproduire un panorama académique de la discipline fondé sur des entrées par "spécialités" : géographie physique/ géographie humaine, puis à l'intérieur de chacune les sous spécialités : géomorphologie, climatologie, géographie rurale, urbaine, sociale, etc. La démarche philosophique qui sous-tend le découpage choisi s'appuie plutôt sur le concept de "paradigme", exprimé par T.S. Kuhn (1983) [14], dans le cadre de ce qu’il nomme une "science normale"[3].

Par ailleurs, à la différence d'un dictionnaire rédigé par un auteur ou un petit groupe d'auteurs, cherchant à donner une forte tonalité personnelle à l’ouvrage réalisé, il nous a semblé nécessaire de replacer et de re-contextualiser les notions dans le cadre d'un texte dépassant en taille les quelques phrases d’une simple définition. Pour chaque concept, le rédacteur insiste sur sa généalogie et la pluralité des interprétations possibles afin, au final, de dresser une sorte de vue d'ensemble de la pensée géographique contemporaine. A ces éléments classiques, l’informatique ajoute la possibilité de mises à jour régulières en fonction de l’évolution des débats scientifiques. Bien entendu, il ne s’agit là que d’une exhaustivité partielle. Comme pour tout lexique, la patte de l'équipe éditoriale transparaît dans la sélection des termes présents ou dans l’absence d’autres notions qui ont été volontairement omises.

Les concepteurs d’Hypergeo n’ont donc pas souhaité, si tant est qu’ils en seraient capables, enfermer la totalité du savoir géographique établi et reconnu dans les limites du site. Même si le site reflète l’état des connaissances à un moment donné en rendant compte de la pluralité des discours géographiques, il possède avant tout des finalités pédagogiques. Le niveau scientifique visé est celui des étudiants de Géographie. Il s’agit donc d’une entreprise de diffusion du savoir, plus que de recherche épistémologique, de mise à disposition d’itinéraires didactiques plus que de la présentation d’une pensée fondatrice.

Enfin, comme tout travail universitaire rédigé à plusieurs mains, les textes inclus dans Hypergeo sont discutés et leur validité scientifique évaluée par un comité de lecture.

2 De la conception initiale d’Hypergeo, au système hypertextuel dynamique

En 2001, lors du lancement de la première version de l’encyclopédie, la question du format et de la présentation d'un document électronique n'était pas aussi cruciale qu'aujourd'hui. En effet, la mise en ligne d'un texte au format HTML directement traduit à partir d'un document par le logiciel Word et mis en ligne sur un site statique avait l'avantage inédit de permettre une visibilité immédiate sur le web et de répondre au moins provisoirement aux besoins émergeants de ce nouveau type d'édition. Cette révolution apportait une satisfaction certaine : la possibilité de s'auto-publier (autoritativité) et l'accès au document intégral de n'importe où dans le monde (visibilité). Pour la communauté scientifique, la nature oecuménique de la science trouvait là le support le plus adapté à sa mission. Depuis, les projets réalisés sur le web se sont multipliés et en particulier dans le domaine de l'édition scientifique. Devant cette inflation de sites, l'infrastructure des moteurs de recherche a dû elle aussi évoluer afin d'éviter à l'internaute de se trouver noyé dans la pléthore de réponses suscitées par une requête. Une "recherche avancée" est désormais proposée partout qui permet d'affiner la recherche et d'éviter le "bruit". Ceci est rendu possible grâce à de très puissants opérateurs booléens mais également aux métadonnées indiquées dans la "source de la page" indispensables pour un bon référencement.

Peu à peu donc, les formats de publication ont évolué pour se perfectionner c'est-à-dire pour permettre de répondre le plus précisément possible aux besoins des internautes. Face à cette évolution, un moment de réflexion s'est imposé en 2002 dans le développement du site Hypergeo qui est passé par deux principaux constats :

- la présentation sous forme de pages statiques, même si elles comportaient des liens hypertextuels, n'était pas adaptée à un contenu destiné à s'enrichir en permanence de nouvelles définitions. Les pages statiques s'avéraient de plus en plus lourdes à gérer avec une mise à jour "manuelle" ;

- de nouvelles pratiques spécifiquement liées aux pages dynamiques voyaient le jour sollicitant de plus en plus l’internaute et tendant à accroître sa part de décision. Or dans le cas d'Hypergeo, l'internaute pouvait effectivement circuler, mais en suivant un parcours conceptuel préalablement conçu, sans possibilité de formuler des requêtes.

Succédant à une démarche de simple mise en ligne et de mise en relation des définitions, il est apparu indispensable, dans un second temps, de faire un état du contenu d'Hypergeo à un moment donné dans le cadre d'une base de données : quels termes sont définis et publiés ? Quels termes sont liés ? Combien chaque définition comporte-t-elle de liens hypertexte ? Potentiels ? Actifs ? - les termes seront recensés pour chaque définition dans les deux cas - Quelles sont les définitions qui comportent des illustrations (qui seront recensées) ? Un historique ? Une bibliographie ? Une discussion ? Il s’agissait également de distinguer pour chaque terme sa position "hiérarchique" dans la rubrique concernée "premier niveau" (fondement épistémologique, concept, outil, théorie) ? "Second niveau" (liste de mots dans un index complémentaire) ? Pour finir chaque fichier accompagné de son adresse http a été recensé : définition, illustration, historique, discussion etc. Cet effort de rationalisation a permis de mettre en évidence la richesse des liens virtuels à travers les définitions, mais aussi certains points qui posaient problème et handicapaient la navigation. Le recensement dans une base de données a donc constitué une étape importante pour l’évaluation du site et l’évolution vers des pages dynamiques et non plus statiques comme celles que nous connaissions depuis l’origine.

Par la suite, des choix ont dû être faits quant aux formats, au type de navigation et à la présentation d'Hypergeo qui ont nécessité une analyse plus fine des différents paramètres en jeu. Si on se réfère à J.Nielsen (1995) [17], un système hypertexte dynamique se distingue par trois niveaux d'organisation : celui de la base de données, celui de la structure hypertextuelle et celui de l'interface avec l'utilisateur. Le niveau de la base de données concerne le stockage de l'information. Tant que l'on reste à ce premier niveau, les futurs nœuds et liens demeurent uniquement des sources avec un sens et une signification qui leur sont propres. Le second niveau de la structure concerne la façon dont se construit l'assemblage entre nœuds et liens. Les nœuds sont les unités fondamentales de tout hypertexte, ils matérialisent la façon dont les unités textuelles, que sont les articles de l’encyclopédie, sont organisées. Et enfin le troisième niveau, l'interface avec l'utilisateur, se rapporte à la convivialité des menus et des écrans d'accueil proposés.

En s'inspirant de cette vision, et à la lumière des éléments rassemblés dans notre base de données, nous avons établi un cahier des charges et évalué les différentes offres. Depuis plusieurs années, des logiciels d'édition libres de droits permettent à un nombre croissant de créateurs potentiels de développer des sites éditoriaux sans avoir une connaissance pointue en informatique. Notre choix s'est finalement porté sur SPIP[4]. Sa facilité d'emploi, sa gestion du multilinguisme ont été des atouts déterminants. La possibilité de disposer d'un espace commun privé accessible de n'importe où, et permettant aux membres du comité de lecture de venir chercher les derniers textes soumis, a également contribué à notre décision.

Un SGC (Systèmes de Gestion de Contenu) comme SPIP, nous a paru plus adapté à notre procédure de fonctionnement. En effet, à la différence d’un wiki, le directeur de la publication fait appel à des spécialistes de la discipline pour définir les notions sélectionnées par le comité de lecture. Le texte est ensuite examiné par les membres du comité de lecture qui se réunissent tous les deux mois. La commande, l'évaluation et la validation, qui suit souvent après des demandes de remaniements, sont le garant de la qualité scientifique de la publication. Un texte peut donc prendre parfois plusieurs mois avant d'être publié. Cette chaîne de publication fait défaut dans un wiki.

L’intérêt est également de recueillir l'ensemble de l’encyclopédie dans une base de données MySql ce qui confère une certaine pérennité au contenu et une facilité de transfert. Dans les mois qui viennent nous avons le projet de rapatrier l'encyclopédie sur un serveur du CNRS.

Par ailleurs, cette base de données contribue à structurer l’encyclopédie. Elle nous a permis de développer une fonctionnalité visant à repérer, dans le corps de chaque définition, les termes présents dans l’index de l’encyclopédie et de créer automatiquement un lien vers la page de référence. Sur le plan de l'interface, l'ergonomie a été pensée de telle sorte qu'à tout moment le lecteur ait le choix de sa navigation, non seulement à travers les liens insérés dans les définitions mais également dans l'arborescence du site. De la page d'accueil on peut choisir la langue, visualiser les liens entre les termes et entre les rubriques, naviguer à travers les réseaux sémantiques générés à partir d'une définition. On envisage par la suite d'étendre la recherche à des liens sur le web. Le plurilinguisme fait partie depuis l'origine du projet d'Hypergeo. Actuellement, il existe trois versions : la version originale française et deux versions traduites en anglais et en espagnol. L'équipe éditoriale s'intéresse à la possibilité de produire des textes originaux dans ces deux dernières langues et de développer des réseaux propres à chacune d'elle.

Le choix de définitions courtes, adapté à la mouvance du web, permet de lire en ligne et par conséquent de naviguer sans difficulté dans le corpus.

Les enjeux organisationnels d’Hypergeo ne relèvent pas simplement de l'ordre de la performance, la question de la mutualisation du savoir (inscrite depuis le début dans les principes de fonctionnement du GDR Libergeo) et du libre accès aux acquis scientifiques, issus de la collaboration entre des individus, a été intégrée dans la conception du site. Ce libre accès relève d’un choix délibéré en matière de diffusion des connaissances, et de relation entre innovation et société. Celle-ci suppose que la valeur ajoutée des nouvelles technologies ne se limite pas à un domaine purement technique, mais doit chercher à toucher le plus grand nombre. A cette occasion, rappelons qu'un mouvement s'est développé en 2002 connu sous le nom de l'Appel de Budapest qui prône le Libre Accès aux documents scientifiques (écrits, thèses, articles scientifiques etc.)[5] auxquels adhèrent désormais de nombreux instituts et universités en Europe.

L'architecture hypertextuelle et la production de sens

Lorsqu’on élabore une architecture hypertextuelle, se pose la question du choix d’un lien particulier dans un texte, parmi la multitude des occurrences notionnelles dans les textes sélectionnés et ensuite, de la signification de la relation créée. Le graphe, ainsi conçu est dès lors un graphe orienté, et les sens uniques ou doubles de circulation sont porteurs de signification, d'ouverture ou de limitation dans la circulation. En tout état de cause, ils complexifient la signification des connexions, puisqu’une même notion peut dans différents textes se trouver dans différentes situations sémantiques. La valeur et l’intérêt du lien sont évidemment créés par le niveau de pertinence de chaque connexion. Après analyse d’un échantillon significatif de textes, une occurrence de lien entre deux concepts présents dans Hypergeo peut correspondre à quelques grands types de situations sémantiques regroupés dans le tableau ci dessous :

| Types de relation | Situation |

|---|---|

| Association |

|

| Inclusion |

|

| Induction |

|

| Tableau 1 : Types de situations sémantiques des liens dans Hypergeo | |

Trois grands types de relations sémantiques (voir tableau 1) se dégagent de l’analyse des liens entre le mot source et le mot destination qui vont de la simple situation de proximité sémantique à la causalité explicative. Cette classification en trois catégories de liens n’est pas exhaustive et à l’intérieur de la relation de causalité, plusieurs formes spécifiques à chaque discipline co-existent.

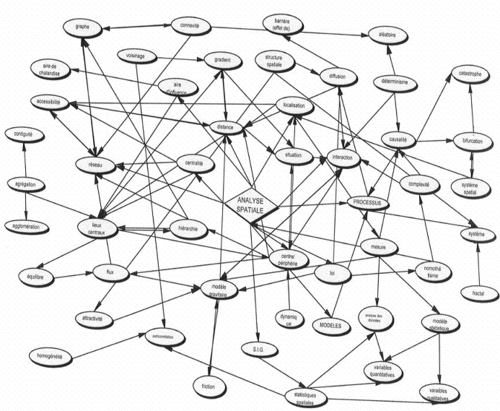

Au fur et à mesure de la construction de l'hyperdocument selon le schéma : noeud = texte puis texte = mots en gras, mots en gras = liens vers des noeuds qui eux-mêmes correspondent à des textes, le concepteur organise des itinéraires variés qui diversifient les appréhensions de chaque notion et démultiplient les itinéraires d’apprentissage. Le choix s’est porté jusqu'à présent exclusivement sur des liens internes à l’encyclopédie afin d’essayer de faire ressortir la cohérence globale des concepts disciplinaires. La sélection des articles et le réseau hypertextuel dessinent une grille de lecture parmi d’autres possibles d’une base de données. Le graphe permet d’afficher le réseau sémantique créé par l’ensemble des liens construits par les réalisateurs d’Hypergeo. Comme tout document de type lexical, celui-ci se caractérise par la multiplication des portes d’entrée en nombre équivalent aux définitions proposées et se différencie des arborescences des sites Web qui sont, pour la plupart, organisées selon le principe des « poupées russes ».

Ce réseau sémantique représente donc l’ensemble du système de relations entre les notions géographiques construit par Hypergeo dont seule une partie est montrée en exemple dans l'illustration ci-dessus. Il est l'expression d'une sorte de compromis entre les représentations des membres du comité de lecture et un consensus scientifique sur l’état de l’épistémologie de la discipline géographique à un moment donné.

L’affichage du graphe des concepts disciplinaires, quel que soit le champ disciplinaire, fait apparaître visuellement les proximités ou les éloignements entre les notions et les théories. Considéré comme un tout, il permet de faire ressortir les points d’incompatibilité théorique dans l’organisation conceptuelle d’une discipline, de montrer comment deux types d’énonciations ou deux concepts sont contradictoires et ne peuvent pas se trouver dans le même type d’énoncé. A l’inverse, le graphe permet de matérialiser les proximités ou les filiations entre des notions ou concepts. L’affichage d’un graphe représentant le réseau des liens hypertextes permet de déterminer ce que Michel Foucault appelait les « points de diffraction »[6] dans un discours disciplinaire. Outre ce premier réseau élaboré par les concepteurs de l’hypertexte, d’autres schémas réticulaires, fondés sur l’inégale fréquentation des différents articles de l’encyclopédie par les visiteurs du site Hypergeo et sur les parcours propres à chaque visiteur du site méritent d’être représentés. La comparaison entre l’organisation hiérarchique prévue par les concepteurs, où des concepts comme ceux de distance et d’interaction spatiale apparaissent centraux, et le classement et la circulation entre les notions les plus visitées (voir tableau 2) souligne les décalages entre une organisation théorique et les usages et les centres d’intérêt de l’outil par les utilisateurs.

|

| Tableau 2 : Liste des articles les plus visités en Français (situation 2006) |

En tant qu’élément novateur contribuant à de nouvelles productions de sens, la discursivité hypertextuelle est comparée par Clément (1995) [5] à deux figures de rhétorique : la synecdoque et l’asyndète. En simplifiant on peut considérer que la synecdoque consiste à assimiler la partie avec le tout et l’asyndète, une figure de grammaire consistant dans la suppression du terme de liaison entre deux propositions afin que leur rapport logique s’impose avec plus d’évidence à la pensée de l’interlocuteur. Avec une structure hypertextuelle, le lecteur pratique une forme de synecdoque en privilégiant la partie (l’extrait, le fragment ou le parcours réduit) par rapport à la totalité du site ou de la base de données mise à disposition. Pour le lecteur-utilisateur, l’hyperdocument est d’abord, et parfois se réduit, uniquement à ce qu’il en a lu, c’est-à-dire un morceau extrait en fonction de son itinéraire personnel d'un ensemble plus vaste. La figure de l’asyndète permet de construire un dialogue implicite entre les concepteurs et les utilisateurs. Le raccourci proposé au lecteur, au sein d’un texte par le lien hypertexte, l’invite à bifurquer vers d’autres parcours cognitifs que celui, éventuellement, initialement prévu, ou à faire prendre conscience qu’une notion n’est jamais isolée mais s’insère dans un réseau conceptuel. Les auteurs des textes interviennent donc une seconde fois dans l’apport de connaissances offert par les textes épistémologiques. Ces raccourcis jouent donc un double rôle du point de vue de l’apport de connaissances. Ils démultiplient les possibilités de navigation et entraînent le lecteur par l'intermédiaire d'un saut pertinent vers une autre notion, en ajoutant, par le texte rédigé, une dimension didactique à l’apport de connaissances.

L’illusion, donnée par le Web, d’un accès illimité à nos sources d’information est renforcée par l’outil que constituent les liens hypertextes. Les liens donnent l’impression de l’instantanéité dans la mise à disposition de l’information au moment même où notre esprit en manifeste le besoin, sans nécessiter de mettre en action des procédures longues et complexes pour y parvenir. En effet, il est libre de choisir d'explorer les liens qui l'intéressent, de faire des requêtes ou de se déplacer de façon transversale à travers les grands axes. Les constructions et la navigation par l’hypertextualité semblent permettre d’utiliser internet comme l’extension des impulsions et des sensations de notre propre cerveau. L’hypertextualité semble appliquer à la recherche d’information, la notion de « temps réel » utilisée dans les sciences de l’ingénieur. On touche pourtant là à une transposition hasardeuse de cette notion appliquée à la connaissance. Car le lien hypertexte n’est pas créé par l’utilisateur du Web mais bien par le concepteur du site. D’un côté la technologie numérique nous donne l’impression d’une extension considérable des associations d’idées potentielles liées à une procédure de recherche d’informations, de l’autre la grande simplicité de l’opération mécanique consistant à cliquer, n’est-elle pas une manifestation très réductrice de l’immense complexité des relations sémantiques qu’impliquent les associations de termes ?

Toutefois, il est important de noter qu'une nouvelle dimension du web est en train de s'organiser dans le cadre du W3C depuis 2001. Elle s'inscrit précisément dans l'approfondissement des notions et la visualisation des filiations : il s’agit du web sémantique. Sans entrer dans les détails, on retiendra que cette extension du web classique vise à développer des instruments qui pourraient eux-mêmes exploiter le contenu des textes intégraux au moment d'une recherche. Il repose sur une infrastructure constituée de trois composantes majeures : les métadonnées, les ontologies (langage documentaire pour le web introduisant une dimension sémantique dans le cadre d'un réseau conceptuel et une dimension lexicale) et des agents intelligents (systèmes de raisonnement et de calcul). De ce point de vue, la structure sémantique qu'expriment les liens construits dans Hypergeo pourrait contribuer à mettre en place une ontologie.

Les métadonnées, comme leur nom l'indique, concernent des données élaborées à propos d'autres données. Plus précisément il s'agit d'un ensemble structuré d'informations visant à décrire un contenu. Les métadonnées se situent en haut des pages HTML d'un fichier. Elles visent à faciliter le référencement par les moteurs de recherche. Elles peuvent être créées manuellement par les rédacteurs des pages. Le développement des métadonnées est devenu impératif dans un web de plus en plus riche. Elles permettent d'extraire plus rapidement l'information pertinente. En ce sens, elles participent à l'émergence du web sémantique et participent à l'autogénération de représentations dynamiques pluridimensionnelles appelées "topic maps"[7] dans le prolongement des graphes.

Le web sémantique, qui constitue une nouvelle étape dans la transmission de l'information, permet de révéler, grâce au travail sur les métadonnées, des réseaux sémantiques dont le résultat issu d'un calcul complexe n'est pas d'emblée visible par le(s) concepteur(s). C’est donc à la fois un instrument efficace et intelligent d’accompagnement de la recherche documentaire mais aussi un objet d'étude pour la recherche.

Les hyperdocuments ouvrent-ils la voie à une nouvelle forme d'accès au savoir ?

On ne peut pas considérer Hypergeo simplement comme un outil ou une base de données classique stockant de l’information à usage informatique. Elle se veut l’expression d’un panorama de l’ensemble de la discipline dans une vision renouvelée, élargie et ouverte. Comme on l'a vu, la dimension réticulaire ne signifie pas purement et simplement une absence de hiérarchie, un démantèlement des catégories dans une liste de référencement désordonnée. Au contraire, chacune des définitions est liée aux autres, soit transversalement, soit de manière « hiérarchique » sur la base de quatre grands axes. La structure est donc bien visible, on n’y dispense pas un savoir épars, mais une connaissance systématisée quoique non exclusive. Parce qu’on ne saurait réduire non plus l’encyclopédie à un savoir figé, abouti, conforme à une représentation totalisante, l’encyclopédie a pour mission de mettre en évidence l’unité et la pluralité des approches de la géographie et de transmettre largement le savoir de la discipline, tout en favorisant l’émergence de nouvelles cohérences à travers la richesse de ses liens. Autrement dit, c’est forte de ses liens qu’Hypergeo en tant qu’encyclopédie électronique puise sa capacité d’enrichissement et de renouvellement, mais également cimente l’identité de la discipline.

La création d’un ensemble de documents structurés par des liens hypertextes débouche sur des réflexions plus générales qui ne portent pas spécifiquement sur la géographie. S’interroger sur la capacité des hyperdocuments à créer de nouvelles formes d’accès au savoir revient à se poser la question de la réponse apportée à de nouveaux besoins par ce type d’instrument. La consultation de documents sur le Web offre l’accès à une masse considérable d’informations, régulièrement réactualisées. Ces documents sont stockés, classés, et les moteurs de recherche permettent de les localiser. Les besoins spécifiques de chaque individu semblent en passe d’être satisfaits par les nouvelles technologies, et les possibilités apparemment infinies offertes sur le Web semblent s’ajuster à l’émergence et à l’épanouissement de la « société des individus » (N.Elias). L’interactivité de la plupart des sites répondrait ainsi, à sa manière, à la satisfaction des besoins nés du mouvement profond d’individualisation de nos sociétés.

L’impression d’avoir potentiellement accès à une bibliothèque et à une médiathèque illimitée ne doit cependant pas faire illusion. Les documents disponibles sur le Web ne prennent sens que par rapport à un savoir constitué qui seul permet de mettre en relation et d’ordonner ce puzzle. Chacun de ces documents « en ligne » a été élaboré dans un contexte et en vue d’un projet spécifique. L’hypothèse qui sous-tend l’impression d’une meilleure communication, d’une meilleure transparence dans l’accès au savoir, grâce aux machines et aux nouvelles technologies, repose sur l’idée d’une absence de décalage entre l’émetteur, le message et le récepteur. Or, la compatibilité des significations entre les messages émis et les utilisateurs ne va pas de soi, car la mise en place des connaissances disciplinaires suppose une élaboration méthodique. A propos de la mise en ordre du savoir acquis à la suite d’une construction inorganisée d’éléments disparates, S.Proulx (1999) [21] souligne la difficulté pour le citoyen de trouver du sens dans un environnement saturé d'informations : "il apparaît de plus en plus difficile aux sujets individuels de construire de manière autonome des significations à partir des ensembles de signes qui les atteignent dans un environnement informationnel devenu saturé par les medias.[… ] Ce trop-plein communicationnel risque en effet d'entraîner un accroissement de la confusion mentale chez les personnes ne possédant pas la capacité de discriminer judicieusement ce qui constitue pour elles l'information pertinente parmi la masse de signes qui est offerte". La capacité à remettre en ordre les parcelles de savoir est indispensable pour éviter de ne posséder que des informations éparses et éclatées. Ce n’est que lorsqu’il y a intégration de l’information dans un système cognitif qu’elle devient une connaissance pour celui qui apprend. Les données, les textes et les documents sur le Web ne prennent sens que par rapport à un savoir constitué qui seul permet de les interpréter.

Comment dès lors concilier les exigences scientifiques et les habitudes de « butinage » sur le Web ? L’agir et la communication ne risquent-ils pas de devenir plus importants que la réflexion. On touche là à une ligne de démarcation importante entre information et connaissance. Le risque existe, en effet, d’une confusion entre la démultiplication des sources d’accès à l’information et l’acquisition d’un savoir réel. Le problème semble d’autant plus central puisque avec les hyperdocuments, le savoir se construit dans la non-linéarité. L’approche séquentielle découlant de cette non-linéarité est souvent assimilée à un apprentissage parcellisé, à un émiettement des connaissances lié à la navigation hypertextuelle et donc aboutissant à un volume de connaissances plus faible que la succession des chapitres dans un texte papier. Contrairement à une idée fort répandue dans l’univers académique, la collecte de textes et d’informations sur le Web ne débouche pas, par principe, sur une réduction du volume des connaissances acquises. Comme le suggère Ollivier Dyens , le fait de naviguer au sein d’unités d’informations plus réduites que le livre traditionnel engendrerait une nouvelle structure d'acquisition de connaissances dont l'essence serait le mouvement, la réactivité mais dont le volume final ne serait pas nécessairement plus réduit. Nous faisons donc l’hypothèse que la non-linéarité autorise l’accumulation d’informations, certes composées d’unités plus réduites mais autorise également de la part de l’utilisateur l’éviction d’un certain nombre de scories perçues comme non essentielles dans l’addition des « copier/coller », alors qu’elles demeurent indissolublement présentes dans les chapitres des ouvrages papier. Serait-ce une forme de revanche du lecteur/utilisateur par rapport à l’auteur ?

Nous retrouvons ici l’idée initialement exprimée de l’association irréductible de la technologie au mode de pensée, de l’interactivité à la boucle rétroactive du raisonnement en gestation. Est-on en train d'engendrer, de cette façon, une nouvelle structure d'acquisition de connaissances ? Dans le cas d’Hypergeo, un certain nombre de fonctionnalités (plan du site, graphe des liens, etc.) proposées à l’utilisateur, permettent des sélections initiales puis des « raccourcis » dans le travail d’accès à l’information recherchée.

Conclusion

Le projet Hypergeo s'inscrit dans un espace renouvelé de l'accès au savoir géographique ; un espace, en apparence, non hiérarchisé et non-linéaire dans lequel s'articulent les éléments d’une structure conceptuelle dynamique qui incarne l'état de la discipline à un moment donné. Cette structure est l'expression d'un réseau sémantique élaboré par le comité de lecture et rappelle par bien des aspects la forme des ontologies qui se mettent en place dans le cadre du web sémantique. Une telle démarche implique des méthodes d’investigation très différentes des constructions linéaires classiques, tant du point de vue des concepteurs/rédacteurs que des lecteurs. Elle fait appel à des modes nouveaux d'appréhension des contenus, précisément décomposés et mobiles.

Le lecteur est introduit dans un espace où la discontinuité et le saut font sens dans l'acquisition du savoir et où sa marge de liberté se trouve dans une certaine mesure accrue. Même si, comme nous l'avons souligné, cette part de décision est toute relative puisqu'elle n'est rendue possible que par l'élaboration au préalable des connexions entre les textes, définies par les concepteurs. De cette relative autonomisation d’un utilisateur devenu sujet actif découle deux conséquences : en amont elle requiert une attention particulière des concepteurs concernant l’adéquation de l’architecture du site aux finalités et au public visés ; en aval la question du savoir faire et/ou de l’accoutumance des utilisateurs est posée. Des expérimentations sont en cours pour étudier les « parcours » des utilisateurs après une première requête de connexion à l’encyclopédie. Elles devraient déboucher dans les prochains mois sur des informations précieuses en matière de relations entre outils de connaissances et pratiques d’apprentissage. Au-delà du cas d’Hypergeo, la réflexion sur les hyperdocuments débouche sur deux enjeux : celui du développement de l’interactivité et de la connectivité en tant que vecteur de la croissance accélérée de l’activité intellectuelle humaine et celui de l’émergence, par les nouvelles technologies, de nouvelles formes d’apprentissage des connaissances académiques, et donc subsidiairement d’une évolution des modes d’évaluation.

bibliographie

- [1] Butler D., 2001, “The future of the electronic scientific literature”, Nature, 6th September,

< http://www.nature.com/nature/debates/e-access/Articles/opinion2.html > - [2] Buttterworth I. (ed.), 1997, The Impact of Electronic Publishing on the Academic Community, London, Portland Press.

- [3] Charton G, Salaun J.M., 2000, “La reconstruction de l'économie politique des publications scientifiques”, Bulletin des Bibliothèques de France, vol.2.

- [4] Castells M., 1998, La société en réseaux, Paris, Fayard.

- [5] Clément. J., 1995, "Du texte à l’hypertexte : vers un épistémologie de la discursivité hypertextuelle", in : Balpe.J-P, Lelu A. , Saleh.I ; Hypertextes et Hypermedias, Paris, ed. Hermès.

- [6] Dyens O , 2002, Le web et l'émergence d'une nouvelle structure de connaissances, http : //archivesic.ccsd.cnrs.fr/sic_00000267.html

- [7] Flichy P, 1999, “Internet ou la communauté scientifique idéale”, Réseaux, n°97.

- [8] Flichy P, 2001, L'imaginaire d'internet, Paris, La Découverte.

- [9] Giry.J.P, Lucier J.C., 1996, Navigation en hypermedias et construction du savoir,in Hypermedias et apprentissages, INRP/EPI.

- [10] Harnad S., 2000, “The Invisible Hand of Peer Review”, Exploit Interactive, Issue 5, April :

< http://www.exploit-lib.org/issue5/peer-review/ > - [11] Harnad S., Hemus M., 1997, “All-or-none : no stable hybrid or half-way solutions for launching the learned periodical literature into the postgutenberg galaxy”, In : Butterworth I (ed), The Impact of Electronic Publishing on the Academic Community, London, Portland Press :

< http : //cogsci.soton.ac.uk/harnad/harnad97.hybrid.pub.html > - [12] Kerckhove de D., 2000, L’Intelligence des réseaux, Paris, Odile Jacob.

- [13] Kosmopoulos C., 2002, “Cybergeo et les périodiques électroniques scientifiques”, Cybergeo : Revue européenne de géographie, n 218, 30/02/2006 :

< http : //www.cybergeo.presse.fr > - [14] Kuhn T.S., 1983, La structure des révolutions scientifiques, Paris, Flammarion. (1ére édition : 1962 ; Chicago univ Press)

- [15] Link-Pezet J. (dir), “Coopération et auto-organisation : éléments de réflexion pour approche du travail intellectuel”, Solaris dossier n°5 :

< http://www.info.unicaen.fr/bnum/jelec/Solaris/d05/index.html > - [16] Mayer T., 1993, "Hypermedias et outils cognitifs", in : G.L.Baron et al, Hypermedias et apprentissages, INRP.

- [17] Nielsen J., 1995, Hypertext and Hypermedia, San Diego, Academic Press.

- [18] Odlyzko A, 2001, The Rapid Evolution of Scholarly Communication, Learned Publishing, ResearchIndex.

Notes

- ↑ < http://hypergeo.free.fr >

- ↑ Le comité de lecture d’Hypergeo est composé de : Th. Saint-Julien, M.C.Robic, D.Pumain, C.Rozenblat, C.Kosmopoulos, F.Durand-Dastes, H.Chamussy, J.L.Tissier, G.Hugonie, C.Grataloup, N.Verdier, J.M.Besse, D.Eckert, B.Elissalde.

- ↑ Ce terme désigne selon Kuhn, un domaine scientifique, lorsque celui-ci s’appuie sur des réalisations, considérées suffisamment fiables par la communauté scientifique pour fournir de points d’appui pour de nouveaux travaux.

- ↑ < http://www.spip.net/ >

- ↑ < http://www.soros.org/openaccess/fr/read.shtml >

- ↑ C'est-à-dire les incompatibilités théoriques et les rattachements à des paradigmes différents des notions référencées

- ↑ En français on dirait "cartes topiques" ou cartes thématiques. Elles permettent d'organiser sous une forme cartographique dynamique des représentations autour d'un thème, d'un domaine ou d'un mot. Le point d'indexation de départ peut se développer selon un réseau sémantique composé d'associations et d'occurrences. La sémantique est liée à l'ontologie ou les ontologies du domaine concerné.