Serveur d'exploration hypertexte et hypermédia

|

Ancien démonstrateur : Serveur d'exploration sur l'hypertexte, Pour mémoire : première maquette (2012) |

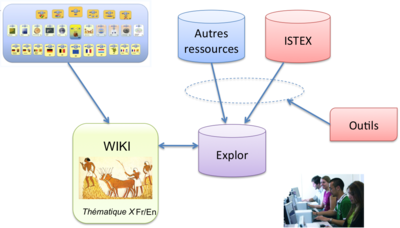

Cette page introduit un serveur d'exploration centré sur la thématique qui est au cœur des colloques H2PTM : « hypertexte et hypermédia ».

Sommaire

Formation à l'ingénierie de la connaissance numérique pour les métiers de l'information scientifique

Le Serveur d'exploration « hypertexte et hypermédia » vient compléter un ensemble de ressources valorisables pour la formation des ingénieurs et chercheurs en sciences de l'information.

Avec la souche de base (MediaWiki), les étudiants peuvent expérimenter la construction collective de documents, éventuellement complexes, dans un environnement hypertexte. Avec les extensions sémantiques, ils apprennent à structurer des ensembles informationnels. Le contenu du wiki H2PTM donne aux étudiants en sciences de l'information un paysage thématique qu'ils vont pouvoir enrichir[1]. L'ensemble du réseau Wicri leur permet d'utiliser des ressources générales comme des entités géographiques ou des références de laboratoires.

Les serveurs d'exploration leur ouvrent à l'exploration de vastes corpus de textes scientifiques pour découvrir les informations dont ils ont besoin pour ces rédactions collectives. Pour cela, ils disposent d'un ensemble d'outils statistiques simples, comme des listes de caractéristiques par fréquence décroissante, ou plus complexes comme des clusterisations. Ils peuvent également réaliser des filtrages sur texte intégral.

Enfin, pour améliorer la performance des outils statistiques ou de recherche d'information, ils peuvent mettre en œuvre des mécanismes de curation de données. Avec ses 30.000 documents cette plateforme est relativement complexe à appréhender. Ils vont alors pouvoir travailler sur des serveurs de taille plus limitée (entre 500 et 1500 documents par exemple[2]), sur des thématiques plus spécialisées.

Exemple d'outil de découverte

Les 2 cartes ci-dessous montrent une projection géographique des affiliations des auteurs par régions françaises ou pays d'Europe (ces cartes sont filtrées[3], des cartes plus complètes sont visibles plus bas dans les menus déroulants).

Ces cartes sont établies de façon automatique lors de la génération d'un serveur.

|

|

|

Un exemple avec manipulation du texte intégral

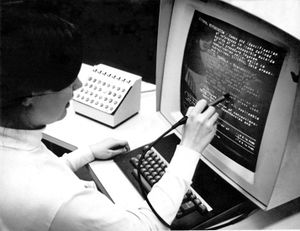

- Recherche des plus anciennes références à l'hypertexte

Pour cette opération, une première exploration a été faite sur le serveur pour détecter les références les plus anciennes.

Puis, dans un environnement Unix, un utilitaire de repérage dans le texte intégral a ensuite été utilisé pour localiser les paragraphes traitant directement de l'hypertexte.

Cela a mis en évidence deux citations relatives au projet HES.

- 2 citations avec deux regards complémentaires sur le projet HES (Hypertext Editing System).

- Computer graphics — A status report from the USA par R.Elliot Green, dans : Computer-Aided Design [ 0010-4485 ] ; 1970.

- Data structures are not necessarily related to drawing complicated pictures. At Brown they are being used for a comprehensive text editing scheme, which they call the Hypertext Editing System (Fig. 12). The operator can insert or delete arbitrary sized blocks of text at any point and can easily, for example, move a paragraph from one position to another. Using this system, the delay between the draft stage of a document and final typing can be reduced from days to hours. The original draft is entered into the machine by a typist; the author can then view the whole draft on the screen either by flipping pages or by scrolling. He can add text, move sentences or paragraphs from one position to another, correct spelling, etc. When he is satisfied with the final version on the screen, all he has to do, is call for line printer output of the final document. The system is now available to IBM users as a type 4 library program. Van Dam also keeps all systems manuals on discs; these can be both referred to and up-dated by the display torminal.

Pertinent concepts in computer graphics: Proceedings of the Second University of Illinois Conference on Computer Graphics Andrew J. McErlean, dans : Chesapeake Science [ 0009-3262 ] ; 1970.

- Two articles presented deal with computerized editing or text preparation. Although these may be harbingers of things to come, one article titled "Hypertext Editing System for the / 360" is marred by poor reproduction. The article, which was prepared by the Hypertext method, paradoxically, is difficult to read because of weak character impressions. Nevertheless,the article is interesting in that, with creative writing, it allows the computer to function as a giant layout table; text may be inserted or deleted, rearranged infinitely and stored materials such as quotations inserted at will.

En réalité le serveur dit d'exploration est représenté par une icône de livre ouvert. C'est le résultat d'un ensemble d'étapes où les données sont traitées.

Le tableau ci-dessous permet au « contributeur curateur » de naviguer dans cet ensemble.

| icône | signification |

|---|---|

|

Cette icône identifie l'étape qui permet de naviguer dans l'ensemble des 30 000 notices bibliographiques issues des différents corpus. |

|

Cette icône identifie le flux principal (Main) d'un serveur d'exploration. Ce flux se compose d'une étape de fusion, suivie d'une de curation pour produire le site d'exploration. Au moment de la rédaction de ce paragraphe, il n'y a pas encore de traitements de curation installés sur ce flux. |

Cette icône identifie la première étape d'un flux. Cette étape se limite généralement à un reformatage en TEI. A noter sur ce serveur :

| |

| Cette icône indique une étape de confluence. Dans le cas du flux Pascal/Francis, il s'agit surtout de dédoublonner les notices Pascal et Francis. On peut comparer le nombre de documents dans l'étape Corpus, puis dans l'étape Merge de ce flux. | |

|

Cette icône indique une phase de curation. En fait, les actions de curation démarrent sur cette étape pointée par cette icône et se poursuivent sur la suivante. Par exemple, pour le flux ISTEX, comparer par exemple le nombre de villes repérées dans l'étape Curation et dans Checkpoint. |

|

Cette icône indique une étape de vérification en fin de traitement d'un flux primaire. En fait, elle permet également une analyse partielle d'une thématique à partir du point de vue privilégié par la source. |

|

Cette icône introduit un flux de type Zoom. Au moment de la rédaction de ce paragraphe, les traitements de curation ne sont pas réellement introduits à ce niveau. |

| Cette icône permet d'atteindre l'étape d'extraction d'un flus Zoom. Sur la page de paramétrage du serveur (Wicri:HypertextV7/Paramètres, data), un paragraphe contient des exemples de critères (encore élémentaires) de sélection. | |

| Cette icône permet d'atteindre l'étape finale d'analyse d'un flux de type Zoom, et donc de permettre une analyse plus fine et comparative. |

| Pascal Francis |

Ce flux traite un ensemble initial de 5510 notices extraites des bases Pascal (4702) et Francis (573). Après dédoublonnage, le corpus final rassemble 5275 notices. | ||

|---|---|---|---|

HAL |

Ce flux traite un ensemble de 655 notices extraites de Hyper article en ligne (HAL)[4] | ||

HAL INRA |

Ce flux traite un ensemble de 33 notices extraites de Prod INRA | ||

| Medline | Ce flux traite 829 documents en provenance de la base PubMed (MEDLINE). | ||

| PubMed Central |

Ce flux traite 2138 documents en provenance de l'archive PubMed Central. | ||

| Convergence NCBI | Ce flux fusionne les 2 flux précédents (soit 2967 documents) pour arriver à 2138 après résolution des doublons. | ||

| H2PTM | Ce flux vise à introduire dans le serveur les documents qui proviennent de ce wiki - il n'est pas encore opérationnel. | ||

| ISTEX | Ce flux introduit un corpus d'environ 22752 documents ISTEX. Le texte intégral peut être exploité sur un site à accès restreint. | ||

| Flux principal | Ce flux regroupe les 29 669 notices sur la thématique Hypertexte et Hypermédia. | ||

| Zoom | France | Ce flux donne accès à 1875 documents qui ont été extraits sur le critère : au moins un auteur ayant une affiliation française. | |

| Zoom | Allemagne | Ce flux donne accès à 1829 documents qui ont été extraits sur le critère : au moins un auteur ayant une affiliation allemande. | |

| Zoom | USA | Ce flux donne accès à 7064 documents qui ont été extraits sur le critère : au moins un auteur ayant une affiliation des États-Unis. | |

| Zoom | WWW | Ce flux donne accès à 1464 documents qui contiennent explicitement le mot clé World wide web. | |

Projections géographiques

Cette partie introduit un ensemble de projections géographiques sur les activités de recherche autour de la thématique « hypertexte et hypermédia ».

|

|

|

Voir aussi des projections géographiques dans les pages Allemagne et Espagne.

Les serveurs d'explorations offrent un ensemble varié de mécanismes d'exploration de connaissances. Dans la phase actuelle, ils n'en contiennent qu'un échantillon, à titre de démonstration.

Par exemple, de simples listes de descripteurs triés par ordre de fréquence décroissantes permettre de se faire une idée sur un sujet donné.

On peut ainsi comparer la répartition des pays privilégiés respectivement sur les bases Pascal/Francis, PubMed et ISTEX.

On peut associer ce type de liste à un élément, par exemple à un auteur. Voici par exemple, à la suite de la bibliographie proprement dite, le profil thématique de Vincent Quint sur le Zoom France[5].

Enfin, dans le cadre de l'évolution du projet LorExplor, il sera possible d'introduire des outils graphiques ou statistiques. A titre d'exemple de faisabilité[6], il est possible de visualiser une association, comme celle qui relient Ergonomie et Télématique sur le Zoom France. Un exemple d'algorithme de clusterisation est en début de mise au point (Voir par exemple une classification sur les auteurs du Zoom France avec la distance dite des cosinus.).

Paramétrage et curation des données

Une grande partie des travaux d'exploitation autour d'un serveur se font dans un environnement Unix en utilisant une bibliothèque de composants XML, la bibliothèque Dilib (Data & Information LIBrary).

En revanche les données proprement dites sont gérées dans les pages de ce wiki ou des wikis communs du réseau Wicri.

Paramétrage d'une plateforme d'exploration

Le paramétrage d'un serveur d'exploration donne un exemple de cette approche. Les paramètres et les consignes sont déclarées sur le wiki. En revanche, la réalisation proprement dite est effectuée sur une machine Unix.

- Initialisations et récupération des corpus.

Chaque plateforme possède un nom de code (ici HypertextV7). La page nommée Wicri:HypertextV7 contient un ensemble de consignes pour la génération d'un serveur. Elle contient également les critères de sélection à partir desquels les corpus ont été téléchargés.

Compte tenu du volume du corpus ISTEX, la procédure est relativement complexe. Pour les travaux pratiques, les étudiants vont travailler sur des exemples plus simples (voir Wicri:HyperBrazilV1).

- Paramétrage du traitement des données

Le paramétrage du serveur est réalisé sur la page : Wicri:HypertextV7/Paramètres, data. On remarquera notamment la description des flux de la plateforme (paramètre listStream).

La multiplicité des flux rend le paramétrage relativement complexe. Pour les travaux pratiques sur petits corpus qui ne portent que sur un seul flux, le paramétrage est nettement plus simple, voir : Wicri:HyperBrazilV1/Paramètres, data.

- Paramétrage de l'interface de navigation

La paramétrage de l'interface de navigation est réalisé sur la page Wicri:HypertextV7/Paramètres, fr.

Le principe utilisé est un mécanisme multilingue en cascade.

- Génération des cartes géographiques

Les projections géographiques sont réalisées à l'aide de modèles qui utilisent les mécanismes de géolocalisation de Wikipédia (voir la commande MediaWikiGeoStatMap)

La page Wicri:HypertextV7/Paramètres, génération des cartes contient les commandes qui permettent de créer ces modèles.

Curation des données

Ce serveur donne quelques exemples de curation de données. Il s'agit généralement de mécanismes permettant d'identifier des concepts autour d'une graphie unique.

- Curation des noms de pays

Comme pour l'ensemble du réseau Wicri, pour l'identification des noms de pays, nous avons choisi d'utiliser les entrées de Wikipédia (en liaison avec le web sémantique). Différents mécanismes de curation sont utilisés.

- Pour les flux, comme HAL ou Pascal/Francis, dans lesquels les pays d'affiliation sont repérés par les codes ISO, on utilise une copie, légèrement adaptée, de la page Wikipédia relative à la norme ISO 3166-1 (voir cette page sur Wicri/Métadonnées).

- Pour les autres flux, les adresses d'affiliation sont analysées (sachant que le nom de pays figure généralement à la fin). Exemples :

Max Planck ... 72076 Tübingen, Germany

- Dans ce cas la première entrée est une table alimentée par les contributeurs du réseau Wicri. Elle est également rangée sur Wicri/Métadonnées.

- Dans certains cas, la mention de pays est omise dans les adresses quand il s'agit d'une ville importante. Là encore des tables sont utilisées, voir par exemple, sur Wicri/Europe la liste de villes universitaires européennes. L'extrait ci-dessous montre l'opportunité alors offerte de renseigner sur d'autres éléments comme la mention de région.

| Copenhague | Copenhagen ; Kopenhagen ; København ; Copenhague |

country : Danemark ; region @type=région @nuts=2 : Hovedstaden |

| Erlangen | Erlangen | country : Allemagne ; region @type=land @nuts=1 : Bavière ; region region @type=district @nuts=2 : District de Moyenne-Franconie |

| Grenoble | Grenoble | country : France ; region @type=région @nuts=2 : Rhône-Alpes |

- Les notations utilisées dans la colonne de droite sont en fait une codification « TEI simplifiée » pour produire une table interne qui contient des entrées telles que :

Kopenhagen

|

<place>

|

Pour identifier les pays non reconnus, le contributeur dispose d'index signalant les graphies rencontrées en position finale des adresses d'affiliation (voir par exemple la liste des pays inconnus dans l'étape curation du flux ISTEX).

- Autres ressources utilisées en curation

Des mécanismes analogues sont utilisés pour d'autres situations.

Par exemple les codes postaux, lorsque le pays est reconnu, permettent d'identifier des villes (et des régions). Voir par exemple, sur le wiki Wicri/Allemagne :

Sur ce wiki, on trouvera une table de curation pour les personnes qui renseigne en même temps sur les institutions : Wicri:Liste de personnalités de l'hypertexte.

Exploitation des données

Au delà de la navigation dans les serveurs, l'exploitation des données est généralement réalisée dans un environnement Unix pour produire des résultats qui seront finalisés dans les wikis.

Deux premiers exemples sont limités à des actions dans les wikis.

Il sont suivis par un autre plus complexe, impliquant des manipulations sous Unix.

Repérage des grandes entités

Les listes classées par fréquence décroissantes permettent de repérer les entités les plus importantes.

Par exemple, la liste des organismes de l'étape Exploration du flux global [7] démarre ainsi :

- 99 Université de Toronto

- 85 Université de Pittsburgh

- 64 Université de Washington

- 63 Université de Twente

- 62 Université Carnegie-Mellon

- 60 Université nationale de Singapour

- 60 Université de Kyoto

- 59 Université de Manchester

- 58 Université de Londres

- 56 Centre national de la recherche scientifique

- 55 Université Louis-et-Maximilien de Munich

- 53 Université de Leeds

- 53 Université d'État de Pennsylvanie

- 50 Université de Californie du Sud

- 47 Université Paris 8

- 44 Université de Grenade

- 42 Université de l'Iowa

- 42 Université d'Oxford

- 41 Université de Nottingham

- 37 Université Joseph Fourier

Cette liste permet de repérer par exemple les pages wiki à créer en priorité.

Les zooms donnent des points de vue complémentaires, ainsi :

Liens pérennes des wikis vers les serveurs

L'architecture MediaWiki offre des mécanismes pérennes à travers les liens interwikis. Cette possibilité a été adaptée aux liens vers les serveurs. Un modèle wiki nommé « Explor lien » permet de réaliser un ensemble de liens pérennes vers des concepts clairement identifiés.

Cette page contient quelques liens de ce type comme par exemple :

* {{Explor lien

|wiki= Ticri/H2ptm

|area= HypertextV7

|flux= Main

|étape= Exploration

|type= RBID

|clé= ISTEX:DCCD88B37CFA0322B27DBEC829585925186475EA

|texte= Computer graphics — A status report from the USA

}} par R.Elliot Green, dans : Computer-Aided Design [ 0010-4485 ] ; 1970.

Ce code génère :

- Computer graphics — A status report from the USA par R.Elliot Green, dans : Computer-Aided Design [ 0010-4485 ] ; 1970.

En allant sur la page, on remarquera, tout en bas, un modèle de ce lien que le rédacteur peut copier/coller dans une page wiki.

Couplages entre les serveurs et les wikis

Réciproquement, des mécanismes de liens entre les serveurs et les wikis sont envisagés.

Ce qui suit est un exemple dans lequel, sous Unix, les outils Dilib produisent une liste de régions, avec des attributs sémantiques.

La boîte déroulante ci-dessous contient la liste de toutes les régions repérées dans le serveur. Chaque région produit un lien sémantique, comme par exemple :

[[A pour région repérée sur HypertextV7::Alsace]]

, Alabama , Alagoas , Alsace , Alsace-Champagne-Ardenne-Lorraine , Amazonas (Brésil) , Andalousie , Angleterre , Anhui , Aquitaine , Aquitaine-Limousin-Poitou-Charentes , Aragon , Aragon (communauté autonome) , Arizona , Arkansas , Australie-Occidentale , Auvergne , Auvergne-Rhône-Alpes , Bade-Wurtemberg , Bahia , Basse-Normandie , Basse-Saxe , Bavière , Berlin , Bohême centrale , Bourgogne , Bourgogne-Franche-Comté , Brême (Land) , Californie , Canaries , Canton de Berne , Canton de Bâle-Ville , Canton de Fribourg , Canton de Genève , Canton de Neuchâtel , Canton de Vaud , Canton de Zurich , Canton du Tessin , Caroline du Nord , Caroline du Sud , Castille-La Manche , Castille-et-León , Catalogne , Ceará , Centre-Val de Loire , Champagne-Ardenne , Colorado , Communauté de Madrid , Communauté valencienne , Comté de Stockholm , Connecticut , Dakota du Nord , Dakota du Sud , Delaware , District d'Arnsberg , District de Basse-Franconie , District de Cologne , District de Columbia , District de Darmstadt , District de Dresde , District de Fribourg-en-Brisgau , District de Giessen , District de Haute-Bavière , District de Karlsruhe , District de Kassel , District de Leipzig , District de Moyenne-Franconie , District de Münster , District de Souabe , District de Stuttgart , District de Tübingen , District fédéral central , Dongbei , East Middle Sweden , Espírito Santo , Estrémadure , Finlande occidentale , Finlande-Centrale , Floride , Franche-Comté , Galice , Gauteng , Gouvernorat de La Manouba , Grand Londres , Grand Manchester , Groningue (province) , Guangdong , Gueldre , Géorgie (États-Unis) , Götaland , Hambourg , Haute-Autriche , Haute-Normandie , Hawaï , Hesse (Land) , Hollande-Méridionale , Hollande-Septentrionale , Hongrie centrale , Hovedstaden , Idaho , Illinois , Indiana , Iowa , Irlande du Nord , Jilin , Jutland du Nord , Kansas , Kentucky , La Rioja , Languedoc-Roussillon , Languedoc-Roussillon-Midi-Pyrénées , Latium , Limousin , Lorraine , Louisiane , Maine (État) , Maryland , Massachusetts , Michigan , Midi-Pyrénées , Minas Gerais , Minnesota , Missouri (État) , Montana , Moravie , Nebraska , Nevada , New Hampshire , New Jersey , Nord-Pas-de-Calais , Nord-Pas-de-Calais-Picardie , Nottinghamshire , Nouveau-Mexique , Ohio , Oklahoma , Ontario , Oregon , Overijssel , Oxfordshire , Paraná (État) , Paraíba , Pará , Pays basque , Pays de la Loire , Pennsylvanie , Pernambuco , Picardie , Piémont , Poitou-Charentes , Principauté des Asturies , Provence-Alpes-Côte d'Azur , Province d'Anvers , Province de Flandre-Orientale , Province de Liège , Province de Namur , Province du Brabant flamand , Province du Brabant wallon , Préfecture d'Iwate , Pékin , Québec , Rhode Island , Rhénanie-Palatinat , Rhénanie-du-Nord-Westphalie , Rhône-Alpes , Rio Grande do Norte , Rio Grande do Sul , Région Bourgogne , Région Bretagne , Région Centre , Région Lorraine , Région Nord (Portugal) , Région Normandie , Région de Bruxelles-Capitale , Région de Murcie , Région de Tōhoku , Région du Kansai , Région wallonne , Santa Catarina , Sarre (Land) , Saxe (Land) , Saxe-Anhalt , Schleswig-Holstein , Shanghai , Sicile , Sofia-ville (oblast) , Sussex de l'Est , Suède occidentale , Svealand , Tennessee , Texas , Utah , Utrecht (province) , Uusimaa , Vermont , Vienne (Autriche) , Virginie , Virginie-Occidentale , Vénétie , Washington (État) , Wisconsin , Wyoming , Yorkshire-et-Humber , Zhejiang , Écosse , Émilie-Romagne , État d'Oyo , État de New York , État de Rio de Janeiro , État de São Paulo , État du Mississippi , Île-de-France

, Îles BaléaresCes liens sémantiques sont repérables en fin de cette page dans la listes des propriétés associées. Ceci permet notamment de créer très rapidement une page relative à une région et d'y insérer des liens de façon automatique. Par exemple, au moment où ce paragraphe est rédigé, le contenu de la page Alsace est réduit à :

<small>{{Accès géographique}} > [[Europe]] > [[France]] > [[Alsace]]</small><hr/>

==Voir aussi==

{{H2ptm région|référence=Alsace}}

En allant sur cette page, on peut vérifier l'ensemble des listes produites par le modèle H2ptm région qui utilise les relations sémantiques pour calculer le contenu. En particulier, tous les serveurs ayant une page relative à l'Alsace sur ce wiki sont automatiquement signalés.

Pour fabriquer cette liste, on utilise les fichiers inverses du serveur d'exploration (pour en voir un extrait). Ceux-ci sont codés en XML et contiennent des lignes telles que :

<idx><kw>Alaska</kw><lc>alaska</lc><f>1</f><l><e>011E46</e></l></idx>

Elle nous indique que le document de numéro interne 011E46 est le seul à contenir un auteur ayant une affiliation de l'Alaska.

Ce fichier est exploité sous une fenêtre shell, dans la machine de production du serveur, par le script :

HfdCat $EXPLOR_AREA/Data/Main/Exploration/AffRegion.i.hfd \

| SxmlSelect -g idx/kw/1 -p ", [[A pour région repérée sur HypertextV7::@g1]]"

La première commande (HfdCat) balaye le fichier pour créer un flux de données. La deuxième (SxmlSelect) extrait le nom de la région repéré par le xPath « idx/kw/1 » pour produire un lien sémantique. Le résultat est alors traité par un simple copier/coller.

Production de listes spécifiques

Les outils de la bibliothèque Dilib peuvent être utilisées pour réaliser des listes très spécialisées.

Par exemple : dans quelles revues publie l'Université de Pittsburgh ?

Pour cela on visualise la page de l' Université de Pittsburgh sur le serveur.

En bas de page, on trouve début de script qui permet de générer un flux contenant les documents correspondants :

HfdIndexSelect -h $EXPLOR_AREA/Data/Main/Exploration/AffOrg.i \

-Sk "Université de Pittsburgh" \

| HfdSelect -Kh $EXPLOR_AREA/Data/Main/Exploration/biblio.hfd

On peut alors utiliser une commande (SxmlSelect) pour extraire le titre de la revue à partir de son XPath en TEI :

TEI/teiHeader/fileDesc/sourceDesc/biblStruct/series/title

On obtient alors une liste de titres (ou plus précisément de couples « titre - numéro interne »). On utilise l'outil de construction d'index (IndexBuildRec) pour constituer des listes telles que :

<idx>

<k>Artificial Intelligence In Medicine</k>

<f>2</f>

<l>

<e>00B776</e>

<e>00F328</e>

</l>

</idx>

On procède alors à une nouvelle extraction.

La commande complète est ici :

HfdIndexSelect -h $EXPLOR_AREA/Data/Main/Exploration/AffOrg.i \

-Sk "Université de Pittsburgh" \

| HfdSelect -Kh $EXPLOR_AREA/Data/Main/Exploration/biblio.hfd \

| SxmlSelect -g record/TEI/teiHeader/fileDesc/sourceDesc/biblStruct/series/title/1 -p @g1 -p @1 \

| sort -u | IndexBuildRec | SxmlSelect -g idx/f/1 -p @g1 -p @1 | sort -rn \

| SxmlSelect -g idx/k/1 -p "* [[@g1]] (@1)"

Sous la version V6 (sans dédoublonnage) le résultat était :

* [[Lecture Notes in Computer Science]] (36)

* [[New review of hypermedia and multimedia]] (4)

* [[Journal of the American Society for Information Science and Technology]] (2)

* [[Multimedia Systems]] (2)

...

On remarque un problème de synonymie et la liste finale a été ajustée « à la main » pour produire :

- Lecture Notes in Computer Science (44)

- New Review of Hypermedia and Multimedia (6)

- Journal of the American Society for Information Science and Technology (3)

- Multimedia Systems (2)

...

Sous la version V7, le résultat devient :

* [[Lecture Notes in Computer Science]] (36)

* [[New review of hypermedia and multimedia]] (4)

* [[Multimedia Systems]] (2)

* [[Journal of the American Society for Information Science and Technology]] (2)

* [[Journal of Visual Languages and Computing]] (2)

* [[Information Systems]] (2)

Il n'y a plus de problèmes de synonymie, et le résultat final est :

- Lecture Notes in Computer Science (36)

- New review of hypermedia and multimedia (4)

- Multimedia Systems (2)

- Journal of the American Society for Information Science and Technology (2)

- Journal of Visual Languages and Computing (2)

- Information Systems (2)

- British Journal of Educational Technology (2)

- BMJ (2)

- BMC Cancer (2)

- Artificial Intelligence In Medicine (2)

Voir aussi

- Éléments techniques

- Wicri:HypertextV7 - introduction

- Wicri:HypertextV7/Paramètres, data - génération des données

- Wicri:HypertextV7/Paramètres, fr - génération de l'interface

- Wicri:HypertextV7/Paramètres, génération des cartes - génération de cartes géographiques

- Wicri:HypertextV7/Études techniques

- En archive

- Notes

- ↑ . Le réseau Wicri est utilisable de la même façon pour d'autres spécialités.

- ↑ Un expérience est en cours sur la revue Journal of the Association for Information Science and Technology

- ↑ Plus précisément, seules les régions ou les pays dont la fréquence d'affiliation est supérieure à un seuil ont été retenus.

- ↑ Ce flux est extrait de la nouvelle API de HAL.

- ↑ Les croisements de ce type sont relativement longs à générer. Ils ne sont pas déclenchés en standard sur le flux d'exploration, mais sur les sites d'analyse

- ↑ Cette partie est en cours de mise au point et comporte des erreurs algorithmiques et des défauts de mise en page.

- ↑ Attention, cette liste est très dépendante de l'état des règles de curation (ici au 5 octobre 2015).