H2PTM (2007) Ayadi

Conception d’un module de traitement de bas niveau

Application à l’extraction de la sémantique des objets

|

Sommaire

- Résumé

- Nous présentons dans ce papier notre proposition d’annotation semi-automatique des documents multimédia de type images. Le but de ce travail est d’effectuer automatiquement une tâche d’identification d’objets à l’intérieur d’une catégorie (exemple : Véhicule). L’objectif est de produire un système capable d’extraire le maximum d’information de l’image

- Mots-clés

- Annotation automatique, Descripteur MPEG-7, Sémantique, image

- Abstract

- In this paper, we present a study of the image semantic annotation and we propose an automatic annotation process. The goal of this work is to identify automatically the objects inside a category (example: Car). The objective is to produce a system able to extract the information from the image

- Keywords

- Automatic annotation, Descriptor MPEG-7, Semantic, image

Introduction

Un des moyens possibles permettant de faciliter la recherche dans des documents multimédia est l’annotation. L’annotation des images, dans les différents travaux antérieurs vient comme étape intermédiaire entre un traitement automatique sur le signal (indexation et segmentation) et l’interrogation. Une fois les documents sont annotés, ils peuvent être interrogés en utilisant n’importe quel moteur de recherche. Les méthodes de traitement d’images, basées sur le contenu, comme QBIC (Niblack, 1993), VisualSEEK (Smith, 1996), ne font qu’associer à chaque image un ou plusieurs vecteurs calculés à la base des caractéristiques dites de "bas niveau" (couleur, texture, voire la forme de l’objet principal de l’image. etc.) (Zlatoff, 2004). La question qui reste à élucider, à savoir, comment peut-on extraire le contenu sémantique des documents multimédia d’une manière automatique pour en assurer et faciliter la recherche ultérieure par des utilisateurs Pour ce faire, nous nous basons sur les annotations des documents par des descripteurs représentant le contenu et les concepts. Nous présentons, dans la deuxième section de cet article, notre approche d’annotation des images. La troisième section, présente le module de traitement. Nous terminons par une conclusion et quelques perspectives de nos travaux.

Approche d’annotation semi-automatique des images

L’approche d’annotation semi-automatique des documents images que nous proposons se base essentiellement sur les résultats que peut fournir un module de traitement de bas niveau. Les descripteurs, extraits et instanciés automatiquement à partir d’un tel module, permettent de construire notre premier plan de travail (Ayadi, 2007). Ce module consiste à extraire automatiquement les descripteurs de bas niveau et de déduire les composants de l’image. La confrontation et la mise en relation de ces descripteurs dans le contexte choisi, permettent la définition d’un groupe d’objets par un processus incrémental à la fois de construction d’une base de connaissances et d’apprentissage. L’indexation nécessite l’utilisation des techniques de traitement du signal et de l’image pour extraire les descripteurs visuels pertinents (couleur, forme, texture, etc.). Les descripteurs extraits et instanciés automatiquement à partir d’un tel module permettent de construire le premier niveau d’annotation dans le processus incrémental de description. A partir de ces descripteurs, nous proposons un ensemble de règles permettant de passer aux niveaux plus haut, décrivant de plus en plus les objets, les catégories d’objets et les relations contextuelles et sémantiques entre ces objets. Chaque élément peut avoir une sémantique bien déterminée et peut faire référence à un objet ou une région pouvant avoir une sémantique (une personne, une voiture, un immeuble,…). Plusieurs travaux existent parmi lesquels nous citons QBIC, Visual SEEK, qui traitent l’image à bas niveau et la représente sous forme de valeurs des vecteurs descriptifs. Autrement dans cette approche, le module de traitement se base essentiellement sur les descripteurs de bas niveau de MPEG-7. A partir de ces descripteurs, nous proposons de trouver un ensemble de règles permettant de passer au niveau sémantique, en tenant compte les objets ou les éléments constituant notre image. La combinaison de ces éléments avec des relations spatiales (Ayadi, 2006), permet la création du premier niveau des règles d'inférence décrivant le contenu de l'image. Ce premier niveau est créé manuellement. Les connaissances requises par les règles précédentes vont permettre la création de nouvelles règles par le principe d’inférence. Ainsi le processus d’annotation permet d’inférer différentes autres règles décrivant le document de manière de plus en plus abstraite.

Module de traitement de bas niveau des images

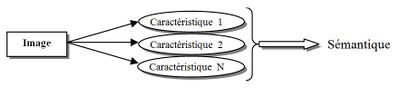

Le module de traitement décrit précédemment, se compose de trois phases : La première phase commence par un ensemble d’images, que nous appelons les images d’apprentissage. Dans cette phase nous commençons par l’extraction de l’image un certain nombre de caractéristiques (‘Features’). Ces caractéristiques vont fournir par la suite l’information de sémantique. (Figure 1). Les différentes caractéristiques seront extraites à partir de différentes fonctions de bas niveau classique du traitement d’image. Partons d’une description ‘syntaxique’ la plus riche que possible, nous essaierons d’apprendre des concepts sémantiques.

La deuxième phase consiste à construire une matrice de valeurs de descripteurs de bas niveau décrivant l’objet recherché. Cette matrice représente le résultat de plusieurs itérations de la première phase sur la base d’images pour le même objet. Dans un premier temps, il est nécessaire de créer une base de données correspondantes à notre problématique. En effet, nous souhaiterons pouvoir différencier des objets appartenant à une même classe et représentant des caractéristiques structurées. Plus précisément, nous nous intéressons dans un premier temps à l’identification de véhicules, panneau de circulation et personnes. Il n’existe pas actuellement une base de données qui permet de résoudre ce problème. Après la phase d’apprentissage, le système procède à la création automatiquement d’une ou de plusieurs règles décrivant l’objet choisi dès la première phase.

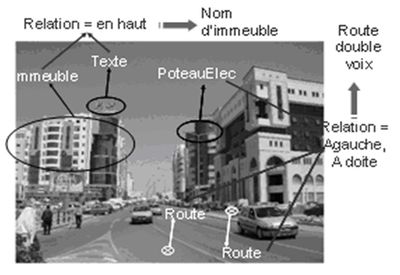

Figure 2. Exemple de la base de données d’images Nous tenterons d’avoir une annotation riche, et si possible pouvant être enrichie par l’utilisateur en ligne ou automatiquement. Pour chaque objet nous considérons l’annotation en se basant sur les descripteurs de MPEG-7. Le résultat du module de traitement de bas niveau, appliqué sur l’image de la figure 3, est l’extraction des différents concepts de cette image, à savoir : Route, Immeuble, Texte, Poteau d’électricité, voiture, … (Ayadi, 2006)

Conclusion

Ce travail se distingue des techniques classiques de reconnaissance d’objet consistant à faire une classification directe à partir des caractéristiques de bas niveau extraite de l’image. Le but général de ce travail est d’aider le processus d’annotation automatique de la sémantique des images. Actuellement, nous travaux de recherche concernant la finalisation de l’annotation semi-automatique de la sémantique des documents images s’appuyant sur les deux phases d’apprentissage et d’ajout du premier niveau de règles sémantiques.

Bibliographie

[Ayadi, 2006] ↑ Ayadi Y., Ammous I., Jedidi A. et Gargouri F., « Annotation automatique des documents multimédia de type image », Maghrebian Conference on Information Tecnologies MCSEAI 06. Agadir – Morocco. December 07 – 09 2006.

[Ayadi, 2007] ↑ Ayadi Y., Ammous I., Jedidi A. et Gargouri F., « Towards a semi-automatic Description of the multimedia Image Document », International Business Information Management Conference (8th IBIMA) on June 20, 21, and 22, 2007 in Dublin, Ireland

[Niblack, 1993] ↑ Niblack W., Barber R. et Equitz W., « The QBIC Project: Querying Images by Content Using Color, Texture and Shape », Proceedings of Storage and Retrieval for Image and Video Databases (pp. 173-187), Bellingham, WA. April 1993.

[Smith, 1996] ↑ Smith J.R. et Chang S.F., « Tools and Techniques for Color Image Retrieval », In IS&T/SPIE Symposium on Electronic Imaging: Science and Technology (EI'96) - Storage and Retrieval for Image and Video Databases IV, Volume 2670, San Jose, CA, February 1996.

[Zlatoff, 2004] ↑ Zlatoff N. et Baskurt A., « Exploitation de connaissances domaine pour l’interprétation d’images », Conférence francophone en recherche d’information et applications – CORIA 2004. Avignon (Vaucluse), France Avril 26-28, 2004.