H2PTM (2003) Réty

Coopération entre un hypermédia adaptatif éducatif et un agent pédagogique

https://perso.limsi.fr/Individu/martin/research/articles/rety-et-al-2003.pdf |

Sommaire

- Résumé

- Les recherches en Environnement Interactif d’Apprentissage Humain se développent dans deux directions ; les hypermédias adaptatifs qui permettent une présentation hypermédia de documents pédagogiques adaptée au niveau et aux besoins de l’apprenant, et les agents pédagogiques animés qui visent à expliquer le cours et à motiver les apprenants par des aspects communicationnels et émotionnels via des signes de communication verbaux et non-verbaux. Nous présentons dans cet article une nouvelle approche visant à intégrer les agents pédagogiques et les hypermédias qui sont en fait complémentaires mais qui ne sont pas encore intégrés de manière satisfaisante dans les systèmes actuels. Notre démarche globale repose sur des études issues du domaine de la communication multimodale interpersonnelle, ainsi qu’à long terme sur des analyses fines du comportement multimodal des enseignants face aux apprenants. Nous décrivons dans cet articles un programme permettant, pour une situation pédagogique donnée (niveau de l’apprenant, contenu à présenter), de répartir la présentation adaptative entre l’hypermédia et l’agent pédagogique.

- Mots-clés

- Hyperdocument dynamique, Agent pédagogique, Technologie XML.

- Abstract

- Research in Intelligent Tutoring Systems are developing in two directions: adaptive hypermedia, which adapts an hypermedia presentation to the level and the need of the learner, and pedagogical agents, which are used to explain the course and motivate the learner with communicational and emotional features of both verbal and non verbal communication. We present a new approach for the integration of pedagogical agents and hypermedia which happen to be complementary but not deeply integrated in existing systems. We make use of the literature on interpersonal multimodal communication, and as for long-term research of fine-grained analysis of teachers’ behavioral patterns. The software module we present aims at assigning presentation sub-tasks to either the hypermedia or the pedagogical agent depending on the teaching setting (learner level, data to be presented).

- Keywords

- Dynamic hyperdocument, Pedagogical agent, XML technology.

Introduction

Dans l'enseignement traditionnel, les interactions entre apprenants et enseignants (ou entre apprenants travaillant en groupe) sont multi-support (dessins au tableau, polycopiés, documents audio-visuel), multimodales (parole, gestes, postures, regard), coopératives (échanges ayant a priori un but commun comme la compréhension d'une partie du cours) et adaptatives (par exemple, l'enseignant modifie le déroulement de son cours pour répondre aux questions). Une des difficultés pour l'enseignant consiste aussi à savoir adapter sa communication à des apprenants ayant des niveaux très différents. Vis à vis de cette multimodalité et du caractère coopératif et adaptatif de ces interactions humaines, les outils actuels des Environnements Interactifs pour l'Apprentissage Humain (EIAH) semblent limités.

Quelles sont les impacts de la multimodalité, de l’adaptabilité et de la coopérativité sur la pédagogie (qualité de l'enseignement, attention des apprenants, interactivité du cours, adaptation à différents niveaux et filières d'apprenants) ? Le projet MICAME (http://www.iut.univ-paris8.fr/~martin/recherche/micame/) – Modélisation Informatique de la Coopération, de l'Adaptativité et de la Multimodalité dans l'Enseignement – a pour objectif de mieux comprendre la nature et les mécanismes qui sous-tendent ces interactions multimodales et coopératives afin d'envisager la spécification d'Interfaces Homme-Machine multimodales (clarification, empathie et encouragement), plus conviviales, plus pédagogiques, plus efficaces mais aussi permettant d'adapter non seulement le contenu d'un cours à différents niveaux d'apprenants, mais surtout la communication de ce cours. Le projet que nous avons défini se décompose en plusieurs étapes (Figure 1) : 1) construction d'un corpus vidéo pédagogique [MAR 02] 2) élaboration d'un modèle de communication multimodale pédagogique, 3) spécification et implémentation d’un système intégrant un hypermédia adaptatif [KEN 00]et un agent conversationnel [ABR 02] , 4) évaluation du système par des apprenants. Dans cet article, nous décrivons le point 3) qui nécessite de pouvoir faire coopérer un agent pédagogique et un hypermédia adaptatif (Figure 2). Nous nous focalisons sur les problèmes posés par la coopération à mettre en œuvre entre ces composants qui avaient été développés jusqu'à maintenant de manière indépendante sans avoir été intégrés dans une application. La section 2 présente les domaines des hypermédia adaptatifs éducatifs et des agents pédagogiques. La section 3 décrit comment notre système intègre ces deux composants.

Etude de l’existant

L'enseignement constitue un domaine privilégié d'application des hypermédias adaptatifs [BRU 01]. L’objectif dans ce contexte est de présenter des documents pédagogiques multimédias d’une manière individuelle, adaptée à l’apprenant. Cette adaptation s’effectue le plus souvent en fonction des connaissances acquises que le système détermine par validation de tests et/ou en fonction de la liste des éléments pédagogiques déjà consultés. Elle peut affecter la présentation des documents multimédias (présentation adaptative) ou bien les possibilités de navigation offertes à l’apprenant (support de navigation adaptatif). De nombreuses recherches sont menées dans cette direction depuis le milieu des années 90. Citons le cours hypermédia adaptatif "2L690: Hypermedia structures and systems" de Paul De Bra (http://wwwis.win.tue.nl/2L690/) basé sur le système AHA [BRA 02] ou bien le système TANGOW [CAR 99].

L’architecture des systèmes d’hypermédia adaptatifs pour l'enseignement est généralement basée sur trois composants : a) un modèle de l’apprenant qui représente les informations connues par le système à propos de l’utilisateur. Ces informations peuvent être directement entrées par l’utilisateur (par exemple en réponse à des questions posées par le système), calculées à partir de résultats à des tests ou exercices, ou bien déduites du comportement de l’utilisateur en terme d’interaction avec le système (choix de navigation, temps de lecture de documents, etc.) ; b) un modèle du domaine qui structure les éléments pédagogiques auxquels l’utilisateur peut accéder et les possibilités de navigation parmi ces éléments. Le domaine est le plus souvent structuré selon une hiérarchie de concepts qui représentent des entités pédagogiques que l'apprenant doit valider soit simplement en parcourant des éléments de cours, soit en réussissant des tests. L'ensemble de ces concepts est muni d'un ensemble de relations (par exemple, relations de pré-requis) ; c) un moteur qui détermine quels éléments pédagogiques et quelles possibilités de navigation sont proposés à l’utilisateur à un moment donné. Ces trois composants sont étroitement liés, le modèle du domaine étant structuré en fonction du type d’information pris en compte par le modèle de l’apprenant.

Certains travaux utilisent XML pour représenter le modèle du domaine et/ou le modèle de l’apprenant, ainsi que pour décrire la structure des documents pédagogiques eux-mêmes. Ainsi, la DTD de [BON 00] comprend des balises comme <EXERCISE></EXERCISE>, <EXAMPLE></EXAMPLE> ou bien <EXPLANATION> </EXPLANATION> permettant de définir la structure d’un document, ainsi que des balises <CONCEPT></CONCEPT> permettant d’associer un concept à un document, et <CONDITION></CONDITION> servant à spécifier les pré-requis nécessaires pour permettre l’activation d’un lien ou la présentation d’un élément. Dans [MOU 00], les auteurs définissent une balise <ACTIVITY> dont la fonction pédagogique peut être précisée par un attribut activity-type, par exemple activity-type = "definition". D'autres attributs peuvent spécifier des conditions portant sur le modèle de l'apprenant, comme level = "medium".

L’agent pédagogique se situe à la croisée de deux directions de recherche : les agents conversationnels et les environnements d’apprentissage à base de connaissance. Un agent pédagogique est un personnage animé, affiché à côté d’un support de formation ou intégré dans un environnement 3D, qui vise à fournir des signes de communication non-verbales (regard, expressions faciales, gestes de la main, postures) tout en cherchant à motiver les apprenants par des aspects communicationnels et émotionnels [JOH 00]. Plusieurs équipes développent actuellement des agents pédagogiques1 qui diffèrent selon leurs caractéristiques graphiques (juste une tête parlante ou un corps complet, 2D ou 3D) et les algorithmes qu’ils utilisent pour générer un comportement multimodal en fonction d’une tâche communicative. La réalisation multimodale des actes pédagogiques peut être atténuée ou exagérée suivant le contexte. Les modalités non verbales sont utilisées par les agents conversationnels pour réguler les tours de parole et fournir un retour sans interrompre l’utilisateur, ponctuer une phrase, mettre de l’emphase, indiquer une question [CAS 00], [PEL 02].Outre ces actes communicationnels généraux, les agents pédagogiques peuvent utiliser la communication non-verbale pour montrer comment exécuter une action physique dans un environnement 3D simulé (gestes de la main, postures), porter l'attention de l'apprenant sur un point précis d’un environnement complexe source d’ambiguïtés (déictique via les gestes de la main mais aussi via le regard, la locomotion et les mouvements de la tête), le féliciter (expressions faciales, gestes de la main), l’encourager à se poser des questions(gesticuler, se gratter la tête) [RIC 99]; [LES 00].Plusieurs études ont été menées afin d’évaluer l’utilité de ces agents pédagogiques sur l’apprenant [LES 97]; [DEH 00]; [WON 02]. Certains observent par exemple un impact de l’agent sur la motivation des étudiants et sur la qualité de transfert d’apprentissage [MOR 01]. D’autres n’observent pas cet effet même si une préférence pour l’agent ressort de l’analyse des questionnaires remplis par les étudiants [AND 99].

Ces différents projets d’agents pédagogiques présentent certaines limites. Ainsi, le comportement de l’agent pédagogique et de l’application pédagogique sont généralement intégrés dans le logiciel et ne bénéficient pas des avancées plus récentes en terme de spécifications (par exemple en utilisant XML) plus facilement ré-utilisables pour générer différents cours. D’autre part, l’utilisation possible de l'agent pour personnaliser, de manière générique et indépendante de l’application pédagogique, la présentation du cours aux besoins spécifiques d’un apprenant donné (par exemple avec différentes personnalités d’agent) ou via des capacités adaptatives de l’application pédagogique (génération dynamique d’hyperliens et de parcours) est peu décrite. Enfin, le comportement multimodal des agents est souvent fondé sur des règles générales issues de la littérature en sociolinguistique et non sur une analyse contextuelle des stratégies communicatives multimodales d’enseignants observées en situation d’enseignement telles que l’on peut les observer dans des vidéos.

Description du système MICAME

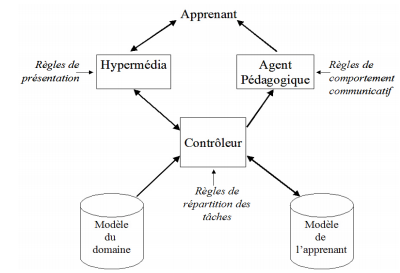

L’architecture du système adaptatif que nous développons est représentée par la Figure 3. Le système est composé d’un modèle du domaine, d’un modèle de l’apprenant et d’un contrôleur qui détermine les éléments de cours à présenter par l’hypermédia d’une part, et par l’agent pédagogique d’autre part. Cette séparation vise à permettre une ré-utilisabilité pour différents cours et supports.

L’objet de notre travail étant d’étudier l’intégration d’un hypermédia et d’un agent pédagogique dans le cadre d’un système adaptatif pour l’enseignement, nous considérons dans un premier temps un modèle de l’apprenant simplifié qui prend en compte une évaluation du niveau de l’apprenant (par exemple saisie initialement ou résultant d’évaluations préalables) : faible, moyen, bon ; un ensemble de concepts à valeurs booléennes (non validé, validé), ainsi que l’historique des sections parcourues dans le document pédagogique. Les documents pédagogiques présentés à l’apprenant doivent être interprétés d’une part par l’hypermédia, et d’autre part par l’agent pédagogique. Leur représentation dans le système ne doit donc pas se situer au niveau des détails de présentation dans l’un ou l’autre des médias de sortie, mais au niveau de la structure des documents. Nous nous sommes orientés vers une représentation XML : le cours est organisé en documents pédagogiques appelés sections, chaque section pouvant contenir les éléments suivants : définition, explication, exemple ou image. Des éléments de type lien déterminent les possibilités de navigation. A chaque élément de cours peut être associé un ensemble de concepts pré-requis, ainsi qu’un niveau minimum requis (Table 1). Nous avons choisi trois dimensions sur lesquelles l’adaptabilité du système peut intervenir en fonction du niveau de l’apprenant et de sa fréquence de consultation du cours (Table 2) : les modalités utilisées, le détail des informations communiquées et le type de parcours. Ces dimensions regroupent celles étudiées classiquement dans les interfaces multimodales d’une part, et dans les hypermédias d’autre part. L’adaptativité est gérée à plusieurs niveaux : dans la sélection et dansl’ordonnancement des étapes communicatives, mais aussi dans la réalisation interne de chacune de ces étapes. A la première exécution du système, l’algorithme déroule les étapes communicatives suivantes : message de bienvenue, introduction au cours, choix de la 1ère section (par le système ou par l’apprenant). Ensuite, pour chaque section sélectionnée, les étapes sont les suivantes : introduction à cette section, présentation du contenu de la section, présentation des liens possibles vers les autres sections. A titre d’exemple nous expliquons le fonctionnement du système lors de la présentation d’une section du cours. Une section peut être composée d’éléments atomiques et de sous-sections. Pour tous les éléments el de la section

Si el.niveau <= apprenant.niveau Alors présenter el dans l’hypermédia Si el.niveau == apprenant.niveau Alors présenter el via l’agent pédagogique Si el.niveau > apprenant.niveau Alors ne pas présenter el

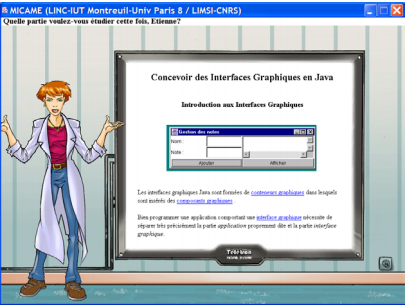

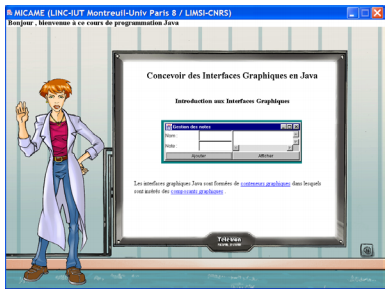

Dans la Figure 2, l’apprenant avait un niveau faible et consultait le cours pour la première fois. Le système génère alors un parcours fortement guidé afin que l’apprenant ne se perde pas, des pages peu denses dans la partie hypermédia en se limitant aux éléments pour lesquels l’apprenant a validé les pré-requis et une contribution importante verbale et non-verbale de l’agent pédagogique. Dans le deuxième exemple (Figure 4), l’apprenant a un bon niveau et a déjà consulté le cours. Le système génère alors une partie hypermédia plus dense complétée par une contribution essentiellement non-verbale de la part de l’agent pédagogique.

<definition terme ="interface graphique"> Les interfaces graphiques Java sont formées de <lien destination="conteneurs">conteneurs graphiques</lien> dans lesquels sont insérés des <lien destination="composants">composants graphiques</lien> </definition> <explication niveau="moyen"> Bien programmer une application comportant une <lien destination="interfaces"> interface graphique</lien > nécessite de séparer très précisément la partie application proprement dite et la partie interface graphique. </explication>

Table 1. Exemple de représentation XML d'une section de cours composée de deux sous-éléments:définition et explication d’ordre méthodologique.

| Modalités | Hypermédia seul |

| Agent avec Hypermédia | |

| Niveau de détail des informations communiquées | Hypermédia : simple / détaillé |

| Agent : simple / détaillé (nombre et longueur des interventions, activité non-verbale) | |

| Parcours | Très guidé par le système |

| Liberté de parcours importante laissée à l’apprenant |

Table 2. Dimensions sur lesquelles l’adaptativité du système peut intervenir en fonction du niveau de l’apprenant et de sa fréquence de consultation du cours.

Conclusions et perspectives

Nous avons décrit l'intégration d'un agent pédagogique et d'un hypermédia adaptatif éducatif. Le système que nous proposons repose sur un modèle du domaine spécifié en XML dans lequel les documents sont représentés en fonction d'un modèle de structure pédagogique. Un module de contrôle est chargé de répartir les tâches de présentation à l'apprenant entre l'hypermédia et l'agent. Ce travail ouvre de nombreuses perspectives de recherche.

La structure pédagogique simplifiée de document que nous avons pris en compte pour l'instant devra être complétée. D'autre part, le prototype actuel ne permettant l'action de l'apprenant sur le système que par l'intermédiaire des liens dans l'hypermédia, il serait intéressant d'étudier les possibilités d'une action en entrée sur l'agent. La question de l'influence du degré de coopération/redondance entre l'agent et l'hypermédia dans les informations présentées à l'apprenant reste ouverte. Certaines informations peuvent être présentées par l'hypermédia et reprises par l'agent, d'autres informations peuvent être présentées par l'un des deux seulement. Nous envisageons d'utiliser le prototype actuel pour réaliser une étude d'évaluation de différents scénarios de répartition des tâches pour laquelle nous ferons appel à un public d'apprenants avec un protocole s’inspirant par exemple de [BUI 02]. En situation d'enseignement classique, les interactions entre enseignants et apprenants font intervenir plusieurs modalités communicatives (parole, gestes, regard, posture, expressions faciales, dessin sur un tableau, transparents). Bien que l'utilisation de vidéos éducatives se développe dans le domaine des EIAH, elles sont rarement utilisées comme des ressources permettant d'annoter et de mieux comprendre la multimodalité de la communication dans ce contexte pédagogique. Comme nous l’avons vu plus haut, même dans le domaine des agents pédagogiques, le comportement multimodal de l'agent est souvent limité en expressivité et n'est pas fondé sur une analyse fine de comportements multimodaux d'enseignants, mais plutôt sur des règles générales issues par exemple de la littérature en sociolinguistique. Un travail futur consistera à étudier l’apport que peut amener l’utilisation de corpus vidéo pour la détermination de scénario pédagogiques [VER 01], la spécification du comportement multimodal de l'agent, et plus généralement les conséquences pour la production de contenus pédagogiques interactifs.

Remerciements : MICAME a été soutenu par le BQR de l’Univ. Paris 8. L’agent LEA a été développé au LIMSI-CNRS par S. Abrilian, S. Buisine, C. Rendu et J.-C. Martin dans le projet NICE ( http://www.niceproject.com ). L’hypermédia adaptatif utilisé dans le projet MICAME a été développé au LINC par J.-H. Réty et J.-C. Martin.

Biliographie

[ABR 02] ↑ ABRILIAN, S., BUSINE, S., RENDU, C. et MARTIN, J.-C., "Specifying Cooperation between Modalities in Lifelike Animated Agents". Int. Workshop on Lifelike Animated Agents: Tools, Functions, and Applications, 7th Pacific Rim International Conference on Artificial Intelligence (PRICAI'02), Tokyo, Japan, 2002.

[AND 99] ↑ ANDRÉ, E., "Introduction to the special issue on 'Animated interface agents'", Applied Artificial Intelligence, vol. 13, 1999.

[BON 00] ↑ BONFIGLI, M. E., CASADEI, G. et SALOMONI, P., "Adaptive Intelligent Hypermedia using XML". Proc. of SAC 2000 - ACM Symp. on Applied Computing, Como, Italy, 2000.

[BRU 01] ↑ BRUSILOVSKY, P., "Adaptive Hypermedia." User Modeling and User-Adapted Interaction, vol. 11, pp. 87-110, 2001.

[BUI 02] ↑ BUSINE, S., ABRILIAN, S., RENDU, C. et MARTIN, J.-C., "Towards Experimental Specification and Evaluation of Lifelike Multimodal Behavior", Workshop on Embodied conversational agents - let's specify and evaluate them!, First International Joint Conference on Autonomous Agents & Multi-Agent Systems, Bologna, Italy, 2002.

[CAR 99] ↑ CARRO, R. M., PULIDO, E. et RODRÍGUEZ, P., "Task-based Adaptive learner Guidance On the WWW: the TANGOW System", Proceedings of the 8th International Conference on Human-Computer Interaction (HCI'99), 1999.

[CAS 00] ↑ CASSELL, J., SULLIVAN, J., PREVOST, S. et CHURCHILL, E., Embodied Conversational Agents, MIT Press, 2000.

[BRA 02] ↑ DE BRA, P. et STASH, N., "AHA! Adaptive Hypermedia for All", Proceedings of the SANE 2002 Conference, Maastricht, 2002

[DEH 00] ↑ DEHN, D. et MULKEN., S., "The impact of animated interface agents: a review of empirical research.", International Journal of Human-Computer Studies, vol. 52, pp. 1-22, 2000.

[JOH 00] ↑ JOHNSON, W. L., RICKEL, J. W. et LESTER, J. C., "Animated Pedagogical Agents:Face-to-Face Interaction in Interactive Learning Environments", International Journal of Artificial Intelligence in Education, vol. 11, pp. 47-78, 2000.

[KEN 00] ↑ KENDALL, R. et RÉTY, J.-H., "Toward an Organic Hypertext", Proceedings of the ACM Conference on Hypertext and Hypermedia (Hypertext'00), 2000.

[LES 97] ↑ LESTER, J., CONVERSE, S., KAHLER, S., BARLOW, T., STONE, B. et BHOGAL, R., "The Persona Effect: Affective Impact of Animated Pedagogical Agents". CHI '97, Atlanta,1997.

[LES 00] ↑ LESTER, J. C., TOWNS, S.G., CALLAWAY, C.B., VOERMAN, J.L. et FITZGERALD P., "Deictic and emotive communication in animated pedagogical agents". Embodied Conversational Agents, Cassell J., Sullivan, J., Prevost, S., Churchill, E. (Eds.). The MIT Press: p 123-154, 2000.

[MAR 02] ↑ MARTIN, J.-C., RÉTY, J.-H. et BENSIMON, N., "Multimodal and Adaptative Pedagogical Resources", Electronic proceedings of the 3rd International Conference on Language Resources and Evaluation (LREC'2002), Las Palmas, Spain, 2002.

[MOR 01] ↑ MORENO, R., MAYER, R., SPIRES, H. A. et LESTER, J. C., "The case for social agency in computer-based teaching: do students learn more deeply when they interact with animated pedagogical agents?" Cognition and Instruction, vol. 19, pp. 177-213, 2001.

[MOU 00] ↑ MOULIN, C. et PAZZAGLIA, J.-C., "Création dynamique d'activités adaptées dans un environnement d'apprentissage à distance", Actes de TICE 2000 (Technologies of Information and Communication in Education for engineering and industry), 2000.

[PEL 02] ↑ PELACHAUD, C., CAROFIGLIO, V., DE CAROLIS, B., DE ROSIS, F. et POGGI, I., "Embodied Contextual Agent in Information Delivering Application", First International Joint Conference on Autonomous Agent and Multiagent Systems (AAMAS'02), Bologna, Italy, ACM Press, 2002.

[RIC 99] ↑ RICKEL, J. et JOHNSON, W. L., "Animated agents for procedural training in virtual reality: Perception, cognition, and motor control." Applied Artificial Intelligence, vol.13, pp. 343-382, 1999.

[VER 01] ↑ VERCLYTTE, L., USEILLE, P. et LABOUR, M., "Scénario Interactif/scénario pédagogique interactif : convergence et divergence d'une écriture", H2PTM'01, 2001.

[WON 02] ↑ WONISCH, D. et COOPER, G., "Interface Agents: preferred appearance charactersistics based upon context". Virtual Conversational Characters: Applications, Methods, and Research Challenges, in conjunction with HF2002 and OZCHI2002, Melbourne, Australia, 2002.