H2PTM (1989) Daoust

ACTE : l'ingénierie textuelle et cognitive pour l'indexation hypertextuelle

|

Sommaire

Introduction

L'hypertexte est une technologie de l'information qui s'inscrit dans la thématique du Centre d'Analyse de Textes par Ordinateur de l'Université du Québec à Montréal. Notre approche (de type « ingénierie ») est tributaire de deux composantes : une composante textuelle et une composante cognitive. Elle est textuelle en ce que l’analyse prend en compte deux dimensions importantes : l'enchaînement des mots dans les phrases et les conditions de production du projet communicationnel instancié par le texte. Elle est cognitive parce que la délimitation de l'extension des concepts et leurs manipulations prime sur l'analyse des modalités linguistiques tout en y prenant appui. La méthodologie d'analyse qui découle de cette approche nous offre un cadre intéressant pour penser le passage efficace et viable du texte vers l'hypertexte.

Cette contribution vise à montrer à partir des caractéristiques de la textualité et de celles de l'hypertextualité que le passage du texte à l'hypertexte doit être inséré dans une démarche d'analyse sémantique. Pour le passage du texte à l'hypertexte l'opération importante est l'établissement de relations multiples mais sélectives entre n'importe quel terme ou segment et n'importe quel autre terme ou segment, à l'intérieur comme à l'extérieur de l'espace textuel, à partir de n'importe quel point du texte analysé. Pour être pertinente, la sélection des relations doit être faite à partir d'un modèle du texte; celui-ci doit intégrer les différents niveaux de l'organisation textuelle.

Le texte qui suit présente quelques éléments pour une réflexion autour de la pertinence de la notion d'hypertexte dans l'élaboration de l'Atelier Cognitif et TExtuel. Après avoir examiné certains aspects de la textualité et de l'hypertextualité, nous présentons le cadre d'analyse de textes envisagé pour l'indexation hypertextuelle : la logique naturelle qui s’applique aux sché-matisations. Les caractéristiques de l'ACTE sont finalement présentés comme un environnement computationnel permettant l'opérationnalisation du travail d'indexation hypertextuelle.

Le travail du texte comme réalité incontournable

Dans les grands organismes, dont ceux de l’appareil gouvernemental, la production textuelle -faite de rapports, de directives, de projets, de correspondance, etc. - connaît un volume grandissant qui rend de plus en plus difficile leur exploitation. Ainsi, les « travailleurs du texte », chercheurs, gestionnaires, décideurs, etc., dont l'analyse de données textuelles (lecture d'archives et de documents, rédaction de rapports, etc.) constitue l'activité principale, sont débordés par une masse de documents qu'ils doivent analyser en fonction d’objectifs qui leur sont spécifiques : accumulation de faits, d'événements ou de connaissances, interprétation, élaboration de stratégies, prise de décision, etc.

Les données textuelles représentent des données à part entière. Si elles ne correspondent pas au format préféré par les environnements des SGBD, elles représentent paradoxalement le format le plus répandu des données manipulées quotidiennement par les intervenants des grandes bureaucraties. Pour ce genre de données, la tradition des bases de données nous a habitué au vocable de format libre. Pourtant, l'examen des différents matériaux documentaires révèle des régularités et laisse à penser que la liberté des formats est une notion bien imprécise. Il est en effet difficile de confondre la lettre et le rapport d'analyse. Mais il faut également reconnaître que l'univers documentaire oblige un travail important de réflexion pour prendre en compte la diversité et la variété que l'on peut y retrouver.

Le format des données du texte est tributaire de contraintes tout aussi spécifiques que celles retrouvées du côté des données numériques. Toutefois, cette rationalité n'a pas encore été suffisamment analysée. La notion même de texte demeure généralement une donnée implicite comme en fait foi l'ouvrage récent d'Edward Barret[1] où on ne trouve pas de définition formelle de la notion de texte. Le texte prend des formes très différentes en fonction du projet communicationnel qui lui est assigné : études, rapports, directives, décrets, réponses à des questions ouvertes, retranscription d'entrevues, etc. Mais curieusement, de nombreux spécialistes2 de la problématique d'hypertexte semblent sous-estimer la nature et la complexité des éléments de la textualité; les analyses portent quasi exclusivement sur la question des structures de données et les moyens pour caractériser les types de nœuds et les relations inter-nodales.

Si les données textuelles doivent être structurées au même titre que les données de type numériques ou alpha-numériques, la question se pose alors de savoir quelle métaphore computationnelle doit être élaborée. Nous pensons que la piste ouverte par la problématique de l'hyper-texte présente des éléments de solution. L'hypertexte est comme on le sait cette approche du traitement de l'information qui vise à opérationnaliser l'accès aux textes en tirant profit du potentiel informatique. Celui-ci permet de définir des structures de données (nœuds et relations inter-nodales) qui restructurent plus efficacement l'organisation des téches de lecture et d'écriture. Et, il faut bien le voir, cette re-structuration est particulièrement intéressante dans la mesure où elle laisse aux structures textuelles leur format « naturel » . Aussi, nous pensons que le développement des questions de recherche doit justement prendre en compte les aspects de cette « logique naturelle »[2] qui est le principal mécanisme à l’œuvre dans la structuration des textes. Ce type de logique vise l'analyse des caractères fondamentaux [3] de cohésion, de cohérence, d'acceptabilité, de pertinence informationnelle, etc.

La textualité

Le texte n'est pas un univers de données discrètes ou numériques. Il est d'abord et avant tout discours et acte de langage organisé à partir d'un domaine de savoir[4]. Le texte est, au-delà de son apparence première, un objet stratifié qui ne se réduit pas plus à l'ensemble des mots qui le composent qu'aux relations réunissant ceux-ci en énoncés ou encore à un contenu pur et simple.

Le modèle du texte préconisé ici est un ensemble des systèmes interreliés. Le terme ensemble est préféré à celui de hiérarchie parce que les systèmes entretiennent entre eux de multiples relations de dépendances mutuelles. Qui plus est, ces systèmes (que l’on peut désigner comme les micro-structures) organisent la textualité à partir de leur spécificité. La compréhension de la parole relève du système phonologique. La référence des mots au monde par le dictionnaire constitue le système lexical; le rôle de chacun des mots dans l'énoncé est le fait de deux systèmes coordonnés : le système morpho-lexical, c’est-à-dire le système des marques que portent les mots et le système syntaxique, celui qui régit la combinatoire des mots dans les énoncés. Le système propositionnel est pensé comme une sorte de calcul sur les propriétés lexicales des mots et leur position morpho-syntaxique dans un segment donné. Il est à noter que la complexité graduelle est dû à l’aspect sériel de l'exposé des notions. Dans les conditions normales de lecture il nous faut composer avec l'intrication des différents systèmes. Il est par exemple virtuellement impossible de choisir automatiquement entre deux ou plus de catégorisation de surface potentiellement contradictoire sans une description de la structure profonde de l’énoncé. Telle est la conception d’une linguistique du texte.

Au niveau informatique nous disposons depuis longtemps de systèmes fabriquant des index (tri et comptage de formes) et des concordances, c'est-à-dire l'extraction par patron de fouille de mots qui apparaissent dans un contexte donné. Ces opérations ont rendu possible une analyse de type quantitatif qui a essuyé des critiques justifiées en raison du peu de sensibilité linguistique de la définition des formes à compter « suite de caractères délimitée par un blanc séparateur ». On a très tôt pensé que les dénombrements analysés devraient être préalablement syntaxiquement décrits pour que tant la catégorisation que les résultats obtenus tiennent compte du contexte des populations de mots filtrées. Il y a cependant peu de programmes qui effectuent la description arborescente de la syntaxe réalisée dans des énoncés parcourus ou parsés. Après plus de trente ans de recherches dans le domaine du traitement automatique de la langue naturelle, J. Sowa un membre de l'équipe de recherche en systèmes de IBM affirme que les succès sur un domaine restreint et leur échec lorsque le domaine est sans restrictions s'explique par la nature fondamentale du langage. Une grammaire volumineuse ne suffit pas à étendre la couverture d’un petit système en un traitement de la langue naturelle sans aucune restriction[5].

Il n'a jusqu’à présent été question que des micro-structures du texte. Le texte est analysé sous l'angle de la distribution de fréquences d'apparition des mots désignant des concepts dans diverses parties d'un corpus de textes. Avec le premier type d'outil, les fréquences retenues sont brutes; dans le second, elles sont qualifiées à la syntaxe, c'est-à-dire elles gardent la trace de la structure et du contenu de leur contexte dénonciation. Une analyse de texte, telle que pratiquée dans les sciences humaines, demande des niveaux de description supplémentaires, proprement textuels, appelés macro-structures[6]. Parmi ces derniers mentionnons les figures de style ou de pensées, la logique du réseau d'argumentation, l'environnement communicationnel, la thématique, etc. Ces systèmes s'appliquent à des unités d'une autre nature : à géométrie variable tels la phrase, le paragraphe ou encore tout autre découpage arbitraire justifié par une grille ou d'autres critères. Leur description ne semble pas uniquement dépendre de la structure arborescente de la description lexico-syntaxique. Dans la plupart des cas, les indices ne sont pas assez nombreux pour qu'une analyse puisse se faire. Par contre, lorsqu'il y a des indices, un filtrage basé sur des séquences de patrons morphologiques semble suffisant. Une connaissance du cadre formel propre au type de texte est de plus requise. Celui-ci varie selon que le texte est une lettre, un mémo, une documentation, un règlement, un article de loi, le résumé d'un texte, etc. cette note de page est introuvable dans le texte:Foucault, M., (1969) L'archéologie du savoir, 'Editions Gallimard,1969,275 pages.

Qui plus est, non seulement une connaissance de l'univers particulier du texte est requise, mais le lecture doit être informée des conventions sociales qui ont présidé à l'émergence du texte. Cette dimension, appelée intertextualité, situe le texte à dé-coder au-delà des systèmes linguistiques; là notion d'intertextualité[7] concerne la manière dont les documents se font écho les uns aux autres. La seule façon de contourner l'incertitude quant aux indices nécessaires et fournir quand même un cadre computationnel cohérent, c'est d'inclure le lecteur dans le processus de la fabrication du sens. Cette intuition est confirmée par les théories[8] d'analyse du discours qui affirment que les textes n'ont pas un sens univoque; le sens est plutôt construit par le lecteur au travers de ses structures socio-cognitives et culturelles résultant de la socialisation de celui-ci. Dans cette perspective, l'expertise de la lecture doit être prise en compte par le système. Pour ce faire, les techniques d'ingénierie cognitive utilisées pour construire les systèmes (experts) à base de connaissance : l'entrevue, l'analyse de protocoles (verbalisations durant l'accomplissement d'une action), ou d'interruption (questionnement).

Les systèmes à base de connaissance résolvent des problèmes en parcourant une chaîne d'informations générée à partir des faits de l'espace de problème (base de faits). Cette façon de faire nous a inspiré un renversement d'approche computationnelle, le passage d'une stratégie de parsage déterministe pour une sémantique procédurale. Par ce terme nous entendons la reconstruction de la signification au moyen d'une chaîne inférentielle dirigée par un but particulier: l'hypothèse de lecture. Cette chaîne est faite par le déclenchement de règles d'interprétation ou de recatégorisation des segments à partir des faits dont on dispose. D'un côté, la configuration d'indices relevés dans les descriptions disponibles (morphologiques, syntaxiques, sémantiques) et les heuristiques du lecteur (sens commun). Cette stratégie présente l'attrait de respecter le caractère hautement associatif des propriétés associées aux unités lexicales.

A base de connaissance ou non, l’analyse de texte par ordinateur doit être encadrée par une méthodologie fiable et appropriée. On doit y retrouver minimalement les étapes suivantes: la formulation d’hypothèses, la description des documents, l’extraction des données et l'analyse proprement dite. La plupart du temps, l'analyse de texte est un processus cyclique où les résultats d'une précédente analyse participent récursivement à la reformulation des hypothèses de lecture et d'écriture.

L'hypertextualité

Dans la perspective de la documentation logicielle, l’hypertexte[9] est défini comme l’ensemble des ressources documentaires « on-line » auxquelles il est possible d'accéder de multiples façons. Le stockage et l'exploitation de documents structurés en réseau de références s'est généralisé et répandu. Les nœuds du réseau sont des segments de textes à géométrie variable; leurs liens sont les chemins possible d'exploration. Ce dispositif dégage le texte de ses contraintes linéaire et séquentielle imposées par le format du support « livre » pour l'inscrire dans un espace multidimentionnel où la recherche n'est plus filtrage mais navigation. L'hypertexte séduit parce qu'il va à rencontre de la thèse skinnérienne de la formation aux activités documentaires : l'utilisation de la documentation sous format textuel qui nous condamne à des parcours fixes et déterminés comme ceux que l'on retrouve dans les mécanismes d'aide dits « sensibles au contexte ». Le modèle proposé est plutôt celui de co-opérations : les parcours thématiques et sémantiques et la production de liens entre ces parcours. Cette architecture permet une production (écriture) et une consommation (lecture) de textes non plus linéaires mais associatives. Le concept de navigation, typique de l'environnement des SGBD, permet présentement un accès plus « intelligent » aux archives ou banques documentaires.

Une première revue de la littérature nous montre cependant l'existence d'une opposition importante entre la définition de l'hypertexte comme stratégie d'écriture et celle où l'on insiste plutôt sur le processus de lecture comme stratégie de navigation dans le contenu des textes. Cette opposition est-elle attribuable aux caractéristiques intrinsèques du médium hypertexte plutôt qu'à des pratiques différentes ? La dimension de la vitesse d'accès à l'information n'est pas le seul critère démarquant les documents de la génération hypertexte des documents de la génération Gutenberg. Si la notion d'hypertexte est prometteuse du point de vue d'une nouvelle structuration de l'espace de lecture/écriture, elle se fonde para-doxalement sur des applications logicielles, certes rapides, mais qui sont loin d'offrir les avantages du format livre dans un espace à trois dimensions (je pense ici aux différents PIMs -Personal information management systems - qui ont certes leur pertinence mais qui reposent largement sur la notion plutôt limitée de fiche ou d'article de base de donnée). Pour satisfaire les besoins de la lecture comme acte d'interprétation des textes (vision du lecteur humaniste), l'hypertexte doit être assujetti à une méthodologie qui respecte les schèmes socio-culturels régissant l'acte de lecture/écriture.

La critique que les humanistes[10] font des présupposés modernistes (instantanéité et multi-accès) est pertinente. En effet, ils nous rappellent qu'un livre n'est jamais lu strictement de façon linéaire; l'acte de lecture est un contrat narratologique dynamique. Il est un dialogue entre le lecteur et l'auteur. La lecture d'un texte relève d'un processus itératif d'avancées et de retours arrière. Il reste qu’elle met justement en lumière une des forces de l'hypertextualité : l'accès aux hypertextes est supporté précisément par des procédures d'accès plus efficaces que le recours aux tables onomastiques ou index thématiques ou analytiques. Les entités identifiées dans la structure de définition de l'espace textuel deviennent les portes d’entrée pour avoir accès au texte. A cet égard, les hypertextes tirent profit des acquis de l'environnement des SGBD. D'une certaine manière, le modèle entités-relations (re)donne aux données textuelles leur troisième dimension, voire leur nième dimension. A la différence des index référentiels (onomastiques, conceptuels) fondés largement sur la notion de concordance (ou adjacences explicitement réalisées dans le texte) les index hypertextuels reposent sur la notion d'accès transversaux aux documents, accès réalisés selon une logique de type associative.

Toutefois, le modèle hypertexte ne fournit pas a priori de cadre formel pour « bien » articuler les nœuds et les segments de textes ou encore pour « bien » établir et classer les liens. Nous pensons que la conjonction de l'analyse des aspects de la textualité définis dans le modèle textuel[11] et du cadre élaboré autour de la logique naturelle[12] pourrait être un travail des plus profitable. Les partitions (ou domaines de textes) sont alors définies à partir des points de convergence thématiques, argumentatifs, rhétoriques, etc. Celles-ci peuvent être intra-textuelles ou inter-textuelles. Dans le premier cas, il s'agit d'ajouter au sein même du texte la représentation des structures thématiques ainsi que les éléments définitoires ou co-référentiels; dans le second, il s'agit d'organiser en réseaux les références externes au texte. Ces deux dimensions organisent en quelque sorte les itinéraires textuels; elles structurent la discursivité textuelle. Donc, jusqu'à un certain point, le succès de l’indexation hypertexte repose sur la richesse des relations conceptuelles explicitées dans le discours mais définies pour et dans un domaine de savoir[13]. Pour permettre l'explicitation des éléments d'un domaine de savoir, l'hypertexte doit refléter la structure d'un discours socialement construit et partagé par un ensemble d'utilisateurs et non pas d'un discours issu d'une socialisation solitaire de l'acte d’écriture.

La navigation dans les archives textuelles suppose la clarification et l’explicitation d'un projet spécifique de lecture ou d’écriture partagé par un groupe donné de personnes. L’indexation hypertextuelle nécessite d’une part l’analyse des textes et de l’autre la délimitation, le réseau social de l’acte de lecture.

L'hypertexte pose le problème fondamental d'une organisation sémantique et pragmatique de l'information. L'information est un rapport problématologique qui s'est matérialisé sous forme de texte; c'est en fait le principe même du cycle de développement et de vue du texte, cette idée de mise en forme définie non comme état mais comme processus. La production d’un hypertexte suppose donc que ce rapport problématologique en fasse intégralement partie.

Indexation hypertextuelle

La construction d'un hypertexte à partir d’un corpus de textes repose sur un mécanisme nodal : l'indexation hypertextuelle. Celle-ci comporte deux opérations fondamentales : segment» le texte et établir le réseau des liens entre ces segments. Le découpage des segments destinés à devenir des unités hypertextuelles, appelées nœuds de base, doit répondre aux deux critères suivants: d'une part leur format doit pouvoir s'afficher à l'écran et/ou être imprimé sur une page; d'autre part il doit être cohérent et complet, c'est-à-dire compréhensible par lui-même. Une bonne façon de respecter le contenu du texte serait de faire de chacun des paragraphes du texte un nœud hypertextuel. Cependant comme les paragraphes sont contigus, une économie de dénotation est établie, les concepts en présence dans l'énoncé sont remplacés par des mots-outils (anaphores) ou des concepts associés (re-catégorisation.). Il n'existe pas, à notre connaissance, de programmes d'analyse syntaxique qui puisse désanaphoriser le texte. Les nœuds doivent donc être revus par un lecteur/auteur qui « intervient » dans le texte officiel. L'intervention est double : rétablir la référence au contexte en désambiguisant l'anaphorisation et en restituant la chaîne de re-catégorisation; indiquer pour la recherche la place du segment dans la structure du document par l'assignation d'une étiquette unique. Il est à noter que le principe-même de découpage implique un démembrement des macro-structures du texte. Pour pallier cette perte, nous proposons le recours à l’analyse de textes.

L’autre opération de l’indexation hypertextuelle est le liage des nœuds. Un lien est un chemin possible d’exploration entre un nœud de départ et un nœud d’arrivée. A chacun de ces types, on associe une opération logico-rhétorique (abstraction, généralisation, spécification, extraction, localisation, etc.), c’est-à-dire un ensemble de règles ou critères régissant soit l’émission d'un lien, soit sa réception. Les critères d'association des liens hypertextuels ne reposent plus que sur leur contiguïté. Les nœuds sont assemblés en Texte italiquemodules; il s'agit d'une activité de classification qui demande de l'évaluation, donc difficilement transposable en algorithme. La typologie des liens hypertextuels n’est pas figée. Deux classes tendent à s'établir : les liens par la référence, par la hiérarchie. Les liens par la référence sont explicites ou implicites c'est-à-dire que dans le premier cas il existe dans le texte lui-même des indications facilitant leur repérage automatique alors que dans le second il n'y en a pas. Les références sont explicites soit typographiquement (par ex: entourés de parenthèses « (Paquin 1988, p. 37) » soit par des suites de caractères isolés des autres mots par un alinéa (par ex: l'article de la loi de la Protection de l’environnement « Q q a 4 »), soit au moyen d'expressions (par ex: « comme le dit Minsky ».

Les références explicites peuvent avoir pour destination: soi-même (par ex: une autre partie du texte où le concept employé est défini); d'autres textes à l’intérieur du corpus. Si les références sont précédées du texte, il s'agit d'une citation. Les références implicites ne présentent pas comme telles de marques textuelles, ce qui les rend très difficiles à dépister automatiquement Leur dépistage requiert le jugement et l’intuition d'un lecteur/auteur hypertextuel. A titre d'illustration, deux types de références implicites. Au niveau micro-textuel le regroupement des synonymes : la tâche consiste à reconnaître, à faire valider et à documenter la similitude observée, à sélectionner un terme qui sera préféré et à le relier aux autres termes qui se trouvent à être non préférés. Au niveau macro-textuel le discours indirect libre: une citation sans référence. Le dépistage et le marquage du discours indirect libre apporte à l'hypertexte une dimension importante. Les passages du texte qui sont rapportés sont reliés aux textes-sources.

Les liens hiérarchiques servent à rattacher les concepts manipulées dans le discours à une structure conceptuelle, la plupart du temps hiérarchique. Ainsi un objet se trouve rattaché à son générique (sous-classe) et cette dernière à l’instance (classe). Ce type de lien est pertinent dans les domaines déjà structurés: la description de mécanismes par exemple. Par ailleurs, il y a des domaines où le concept de hiérarchie n'est pas pertinent : les décrets ministériels tombent souvent dans cette catégorie. La description d'autres domaines demandera l'entrecroisement de plusieurs hiérarchies. Dans les textes, les liens hiérarchiques établis entre les concept sont, la plupart du temps, énoncés par des marques linguistiques, telles: est un (le moineau EST UN oiseau), partie (le fer fait partie de l'acier), etc. Dans tous les cas, il s'agit d’une structure externe au texte lui-même que l'hypertextualité permet de rajouter. D’autres peuvent être établis à la discrétion du lecteur/auteur; on les dira procéduraux lorsque leur destination sera déterminée par l'exécution d'une fonction avec des paramètres donnés.

Le lecteur/auteur qui transforme le texte en l'hypertexte, révise la formulation du texte des nœuds, lie les textes entre eux en opérationnalisant le jeu des références croisées, rattache les concepts en présence à leurs synonymes, à leur générique ou encore à leur définition. De plus, celui-ci peut annoter les textes, c'est-à-dire lier un commentaire à un passage du texte. Il va sans dire que le passage du textuel à l’hypertextuel requiert une planification basée sur une étude de besoins. Cette activité exige de la part du lecteur/auteur outre des compétences en analyse de textes, les connaissances suivantes: les dimensions critiques de l'espace notionnel concerné; les caractéristiques qui distinguent une idée d’une autre et enfin les schèmès de dénomination appropriés. De plus, le réseau construit doit être validé par une représentation graphique.

La logique naturelle comme cadre d'analyse

Le concept d’hypertexte met en évidence le fait fondamental que tout texte est un parcours organisé, une suite « réglée » d'éléments. Ceux-ci trouvent leur identité non seulement à l'intérieur de ce parcours, le contexte, mais ils sont également déterminés par le co-texte, c'est-à-dire l'ensemble de tous les textes avoisinants. Avoisinant car c'est d'un espace qu’il s'agit. La lecture et l'écriture sont toujours topiques, localisés dans un espace textuel en fonction de la structure pressentie. Cet idée d'espace textuel est très près de celle d'un réseau hypertextuel; la métaphore spatiale constitue un point de contact, de passage de l'un à l'autre. Notre modèle du texte (cf. supra) présente le texte comme un révélateur des rapports sociaux de production de l'information; le cadre de notre analyse doit donc mettre à jour les transactions et les tractations au milieu desquelles se construisent les concepts au travers un corpus.

Les logiques formelles[14] font généralement abstraction de la nature des objets qu'elles manipulent Dans les situations discursives, les objets manipulés ne sont jamais quelconques, ils sont toujours spécifiés (mis en contexte) à un certain degré. Les concepts sont efficacement représentés comme des objets symboliques dotés de plusieurs variables dont les valeurs ne sont pas booléennes mais scalaires. Par exemple le concept de température pourrait être vu comme un doublet de variables. La première variable serait la mesure en degré centigrades avec comme valeur un nombre avec une précision de deux chiffres. La seconde variable serait l'appréciation avec comme valeur un élément de l’ensemble « suivant: bouillant, chaud, tiède, froid, glacé ». Comme on peut le voir, la variable ne s'évalue pas de façon booléenne (par oui ou par non), mais par la sélection d'un élément dans un ensemble. La notion ensembliste d’élément discrets n'est pas adéquate pour décrire l'attribution d'une position sur une échelle parce qu’il s'agit de la graduation continue d'une qualité. On appelle classe méréologique le complexe de relations entre un tout et ses parties, entre les parties de parties; voici un exemple simple: la main et ses doigts; chacun des doigts n’est pas tant une partie de la main que son prolongement L'échelle est une espèce très contrainte de classe méréonomique.

Dans les textes les concepts ne sont pas strictement manipulés à des fins de démonstration[15] mais de schématisation des processus argumentatifs. Les schématisations sont des opérations discursives structurant des objets cognitifs et les articulant dans l’espace d’un savoir. Ainsi nous avons recours à la logique naturelle parce qu’elle s'intéresse à de telles opérations mises en jeu par les locuteurs impliqués dans une pratique discursive. Quatre postulats caractérisent cette approche :

- ) Chaque fois qu’un locuteur A fait un discours, il propose une schématisation à un interlocuteur B.

- ) Les activités logico-discursives de A s'exercent dans une situation d'interlocution déterminée.

- ) La schématisation que A propose à B est fonction de la finalité de A mais aussi des représentations qu'il se fait de B, de la relation qu'il soutient avec B et de ce dont il est question, c’est-à-dire du thème T.

- ) La schématisation comporte des images de A, de B et de T. Elle contient aussi des marques de son élaboration[16].

Dans le cadre de la logique naturelle, les propriétés des objets d'une schématisation, de même que les relations qui peuvent exister entre eux, sont représentées par des prédicats. En plus des relations utilisées dans le cadre des logiques formelles (implication, relation de contraire, d'équivalence, etc.), on retrouve des relations de transformation d'objets, des relations méta-fonctionnelles (l'introduction d'un texte, d'un auteur, etc.).

L'opération d'ancrage est le processus par lequel l'unité sémantico-cognitive vient prendre place dans un processus de schématisation. Les unités se trouvent à être stabilisées à l'intérieur des formes linguistiques soit nominales soit verbales. Les ancrages nominaux matérialisent au sein du discours des classes méréologiques d'objets. On comprendra qu'une notion comme celle de projet n'a pas en soi de « sens »; elle trouve son sens seulement à partir des éléments (ingrédients) qui en précisent les limites (par ex.: «Le projet à l’étude consiste en la réfection de l'émissaire d'eaux usées de l'usine de pâtes à papier »). Les ancrages verbaux fournissent les éléments de la dynamique des objets: les propriétés et les relations (par ex.: « Le projet a pour objectif d'améliorer la production de sauvagine du marais »). Dans la perspective où la langue naturelle est à elle-même son propre métalangage, l'analyse de texte consiste à utiliser ce métalangage pour isoler, par leur configuration et leur récurrence, des noyaux conceptuels. Suite à une classification des contextes, ces noyaux sont transformés en concepts multi-facettes et hiérarchisés. Par l'examen des séquences où apparaissent les concepts-clé, les concepts sont insérés des transitions d'états telles la modification, l'accroissement, l'intervention, etc. Ainsi, une analyse conforme aux principes de la logique naturelle s'intéresse aux entités nominales et aux entités verbales.

L'analyse des entités nominales d'un corpus de textes permet le dépistage des termes et leur structuration en concepts. L'effet de référence au réel dans un discours donné est tributaire de formes nominales qui consolident d'autres formes nominales en classes-objets. Ainsi, les marques référentielles proviennent des configurations d'énoncés et des transformations linéaires engendrant la dynamique textuelle. Ces marques sont identifiables linguistiquement à partir des stratégies discursives qui confèrent à certaines formes nominales une fonction de régie textuelle. Une fois que, parmi tous les substantifs, les concepts pertinents ont été retenus, les configurations nominales, appelés ingrédients, qui leur sont associés sont recherchées. Ainsi, par exemple pour le substantif «projet » on aura des configurations telles, l'assujettissement d'un projet, la pertinence d'un projet, etc. Les formes adjectivales présentes dans les contextes dépistés font apparaître les quantifications et les échelles argumentatíves qui positionnent virtuellement les autres valeurs qualitatives ou quantitatives possibles.

L’analyse des groupes verbaux permet le dépistage transitions d'état (opérations) définies sur les concepts. Les verbes jugés pertinents au domaine servent à sélectionner des segments. Leurs flexions et leur contexte fournissent la modulation (actif, passif, nécessaire, facultatif, etc.), la localisation et la temporalité du processus en cours. La classification des segments est une opération qui consiste d’abord à examiner un large contexte des verbes jugés représentatifs, puis à délimiter le segment, selon un critère d'homogénéité, des bornes inférieure et supérieures sont assignées parfois arbitrairement et enfin à caractériser la structure du segment. Les énoncés peuvent être structurés en segments de textes significatifs de manière plus ou moins complexe (configurations à 1,2,..., n énoncés) suivant le type de connecteurs les reliant (connecteurs de conjonction, de concession, de restriction, de transitions, etc.).

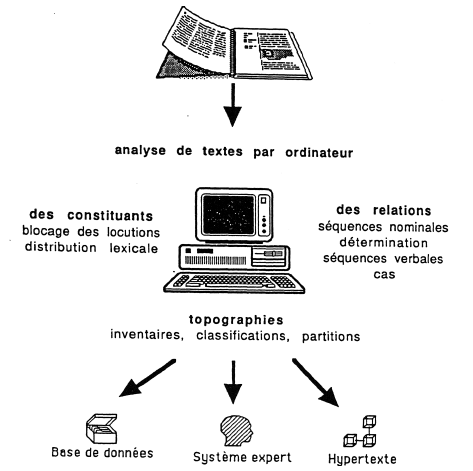

Au lieu d'une description arborescente de chacune des phrases qui s'avère lourde et difficile à valoriser l'analyse par la logique naturelle produit des inventaires, des classifications ou encore des partitions du texte. Cette approche de l'analyse de texte dans le cadre de la construction d'un hypertexte permettrait une indexation des itinéraires de lecture selon un classement méréologique s'approchant de la pensée naturelle. Ces itinéraires instancient en quelque sorte une forme de représentation socio-cognitive en offrant la dynamique d'un espace topologique[17].

Le passage du texte à l'hypertexte, dans le cadre d'une analyse des schématisations, est constitué d'une suite d'opérations: la description morpho-syntaxique, l'extraction des termes pertinents, la classification des contextes dépistés, délimitation du segment, étiquetage des liens. Plutôt que de dessiner et développer un logiciel offrant un ensemble de fonctions permettant d'appliquer un modèle théorique donné, nous avons privilégié une approche interactive « atelier logiciel » où la dimension heuristique prime. Nous croyons fermement que non seulement la validation, mais aussi la gouverne (contrôle) des opérations doit être laissée aux lecteurs/auteurs chargés de la construction de l'hypertexte. Notre contribution consiste à développer des logiciels utiles pour analyser les textes, à assister les lecteurs/auteurs dans leur démarche avec nos outils, et à adapter ces applications à leurs besoins spécifiques dans la mesure du possible. Ces trois temps caractérisent une démarche de type recherche-action : les outils sont en évolution constante, la méthodologie est redéfinie par les nouveaux contextes d'application et enfin les buts de la recherches sont dictés en permanence par un besoin concret dans les organisations gouvernementales commanditaires.

ACTE : un outil pour l'indexation hypertextuelle

Le projet d'atelier cognitif et textuel (ACTE) est commandité par un consortium interministériel du Gouvernement du Québec. Cet atelier intègre un générateur de systèmes experts (D_expert; Paquin, L.-C.) et un système d’analyse de textes par ordinateur (SATO; Daoust,F.)[18].

L'idée de développer un environnement computationnel intégré pour effectuer de l'analyse de textes par ordinateur est dans l'air depuis 1986. Le projet SACAO[19] visait à définir un Système d'Analyse de Contenu Assisté par Ordinateur avec les contraintes suivantes : convivialité de l'interface, précision, régularité, transparence et validité des procédures. Il s'en est suivi une réflexion sur les fonctionnalités de base de l'analyse de textes par ordinateur et leur combinaison en des opérations complexes. Ces fonctionnalités (et les opérations qui y corres-pondent) sont en nombre limité : le tri, l'étiquetage, le filtrage, le stockage doivent cependant être effectuées très rapidement et sur de très très grandes masses de textes. Pour qu'un outil interactif soit intéressant, il faut une grande rapidité d’exécution entre les interactions, sinon perte d'intérêt Pour que les indications soient repérables, l'analyse doit être menée sur un vaste échantillonnage représentatif de textes : le vocabulaire doit être représentatif.

Les opérations complexes doivent être signifiées à l'aide d'un formalisme. Ce formalisme doit être associé à une structure de contrôle sur le déroulement de ces opérations. Nous avons retenu l'approche système expert et non pas un (autre) langage ad hoc, pourquoi? D'une part parce que les règles d'inférences en tant que moyen de modélisation tendent à se répandre de façon constante. Comme aucun apprentissage de langage de programmation n'est requis, il facilite le transfert de technologie qui doit s'effectuer à l'usager-final afin que celui-ci soit en mesure d'être son propre développeur. D'autre part, en autant que le moteur d'inférences offre des performances satisfaisantes, l'approche par les règles permet un développement modulaire et par tentative (« trial and error»). L'assemblage de règles d'inférences construites en pointant avec la souris dans les options d'un menu ou dans le dictionnaire de connaissance permet la construction graduelle d'analyseurs plus sophistiqués et plus spécifiques basés sur des stratégies de contrôle sensibles au contexte. Ces analyseurs pourront par la suite être incorporés en exécutable (« run-time »).

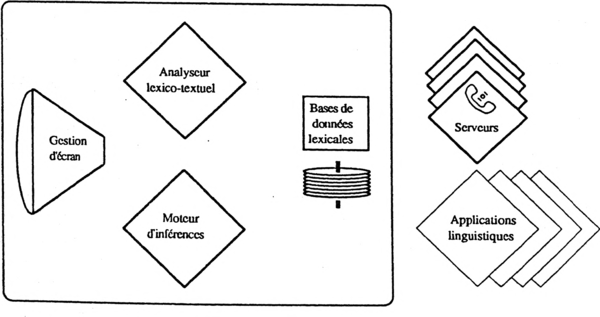

Le devis de acte, un acronyme pour Atelier Cognitif et Textuel, a été conçu en 1989; il a été accepté par un consortium de ministères du Gouvernement du Québec; il est entré en phase développement depuis février 1990. L’objectif poursuivi par la mise au point de l'ACTE est l'accomplissement efficace en temps réel et sur de très larges corpus de textes des opérations fondamentales de l’analyse de texte. L'originalité du projet, en tant qu'approche computationnelle à l'analyse de texte, repose sur l’intégration de deux logiciels et d'une base de données lexicales. L’ACTE intègre SATO, un logiciel de base pour l'analyse des données textuelles et un ensemble de fontionnalités pour l'analyse de textes. Il intègre le D—expert qui est un générateur de systèmes à base de connaissances. ACTE intègre finalement une bases de données lexicales comprenant des items lexicaux munis de leurs catégories morphologiques, une liste de locutions figées et une liste d'items lexicaux indexés à partir d'une grille de catégories sociologiques, etc. L'interaction avec le système est standardisée : menus déroulants emboîtés et souris, les messages et requêtes explicités on-line, etc. ACTE est conçu comme un atelier ouvert. Ainsi, il pourra communiquer avec des serveurs d'information, intégrer l'information obtenue au traitement en cours d'une part et de l'autre accueillir des descriptions linguistiques complexes. Voici un schéma des modules décrits :

L’intégration des fonctionnalités permet l'extension de l'espace de recherche (base de faits) usuel au texte dans son plein format. La prémisse des règles d'inférences peuvent filtrer des configurations complexes d'énoncés. Les registre des actions est étendu à la manipulation des textes: la catégorisation, le filtrage, la comparaison de lexiques ou sous-textes. Les résultats de ces actions des valeurs numériques ou symboliques, des sous-lexiques, des segments de texte (concordance), peuvent devenir des faits. C'est ainsi que s'effectue une chaîne interprétative. Plus profondément, le recours à la technique des systèmes experts change la façon dont les analyses sont menées. Dans le domaine des analyseurs syntaxiques (parseurs), l'utilisation de PROLOG, un moteur d’inférence avec variables dont le principe est l'unification, rétro-agit sur la théorie du parsage voire la théorie syntaxique; on parle maintenant de « grammaire d'unification ». L'analyse n'est plus conçue comme un algorithme avec des stratégies de contrôle peut-être souples (sensibilité aux contexte), mais toujours déterministes, modulaire certes, mais monolithique; le contrôle est assuré par les faits dont la présence fait déclencher des règles d'inférences dont les actions consistent en des interventions textuelles ou l'ajout de faits qui, à leur tour feront déclencher d'autres règles.

SATO (Système d'Analyse de Textes par Ordinateur) produit des lexiques et des concordances à partir d'une chaîne comportant jusqu'à 7 patrons de fouilles complexes sur de larges corpus de textes. SATO est doté de fonctionnalités permettant non seulement l'annota-tion de mots ou de segments de textes, mais aussi la constitution de dictionnaires d'items lexicaux. L'inscription de propriétés (annotations symboliques ou numériques) autant au lexique qu'au texte qui peuvent ensuite être questionnées, permet le dépassement du mot à mot du texte, des formes différentes d'un même mot. Les propriétés permettent l'annotation des aspects paradigmatiques, c'est-à-dire les classes d'unités réunies à partir d'un critère de similarité et des aspects syntagmatiques, c'est-à-dire l'association des unités dans un contexte don-né. L'usager peut très facilement projeter sur le texte des systèmes catégoriels issus des hypo-thèses hypothèses d'analyse ou du cadre d'interprétation du texte. Ainsi, les dénombrements pourront être effectués non seulement sur les formes lexicales réalisées dans le texte mais également sur les catégories (ou attributs symboliques et numériques) indexant ces formes.

Cette façon de faire amène le lecteur à expliciter les éléments textuels susceptibles d'être porteurs de sens et à arrêter les critères à partir desquels ceux-ci seront retenus et comptabilisés. La neutralité de l'instrument, qui permet la coexistence de plusieurs niveaux d'analyse potentiellement contradictoires, favorise une démarche d'aller-retour entre la constitution de modèles sur les textes et leur validation empirique. Il faut voir en effet, qu'il n'y a pas dans ACTE de projection déterministe d'un modèle pré-construit qui agirait sur l'interprétation du texte. Le savoir sémantique et procédural, qui sera inscrit dans le format de règles d'inférences appartient complètement à l'usager. L'approche privilégiée par l'atelier est donc la mise à jour de l'organisation du texte par l'ajout de descriptions successives du texte en alternance avec l'exploration de résultats provisoires.

La référence au réel est le fait des éléments nominaux. Le dépistage et la structuration des concepts en vue d'une indexation hypertextuelle, passe donc par une catégorisation morphologique des mots du texte. SATO permet la projection de dictionnaires ou bases de données lexicales; dont celle des parties du discours : « nom, pronom, adjectif, verbe,adverbe, préposition, conjonction, etc. ». Sur la base de configurations morphologiques, le dépistage des concepts et leurs relations sera exhaustif, objectif, reproductible parce qu’indépendant des problématiques définies dans les textes. Ces configurations sont formulées sous forme séquence de patron de fouille filtrant la co-occurrence de catégories particulières (par ex: traitement de textes « nom de nom »). Lorsque les patrons de fouilles sont réalisés, SATO permet l'assignation de valeur à des propriétés. Il en va ainsi pour le blocage des locutions : SATO dispose d'une système d'annotations des aspects de l'édition permettant de lier les éléments dépistés par une fouille.

SATO permet de re-catégoriser un mot ou un segment de texte n'importe où dans le texte ou encore dans le dictionnaire des mots à partir d’un certain point et selon certaines conditions dont les seuil peuvent être exprimés sous forme de règle d'inférences :

- Si <condidon> et <condition> ... alors <action> ...

- condition ::= test sur les faits / patron SATO

- action ::= inférence / question / action SATO (fouille, catégorisation)

Le moteur d'inférence en chaînage avant de l'Atelier Cognitif et TExtuel offre une structure de contrôle qui permet le dépassement d'une lecture linéaire, du début à la fin du texte. Une hypothèse est d'abord formulée sous forme de patron de fouille; puis, de multiples analyses approfondies sont menées séquentiellement sur chacun des contextes proches. Chacune des analyse peut mener à une re-catégorisation et est susceptible d'aboutir dans la formulation d’un autre patron de fouille, etc.

La tâche finale du moteur d'inférences sera la génération des codes nécessaires pour la conversion en hypertexte. Les principaux standards d'importation des fichiers textes déjà formattés seront appris, c'est-à-dire convertis en forme de règles d'inférences. Ultérieurement une révision pourra se faire par l'éditeur hypertextuel du système utilisé.

Conclusion

Depuis plus de deux ans nous intervenons au sein de la structure administrative du Gouvernement du Québec à titre d'analystes-conseils en ingénierie textuelle et cognitive. Dans tous les cas, le mandat de superviser la construction d'un système expert, qui constituait le point d'en-trée de notre intervention, a été élargi en une intervention cognitive en profondeur : analyse documentaire, constitution d'une base de données textuelles, consolidation terminologique; blocage des multi-termes, constitution d’un dictionnaire de concept (index a posteriori), etc. Face à l'intérêt suscité par la démonstration de l'analyse de texte, la demande se fait forte pour des plate-forme de livraison du corpus de textes alternatives aux bases de données. Au cours de la prochaine année, une ou plusieurs implantations hypertextuelles expérimentales seront faites sur des corpus tels: la politique administrative, les lois et règlements relatifs à la loi sur l’impôt, les avertissements agricoles, etc.

En dernière analyse, au même titre que les systèmes experts et les bases de données « plein texte » mais avec des modalités différentes, nous considérons l'hypertexte comme une plate-forme d'accès à l'information qui répond à une gamme de besoin dans les organisations où les objets et concepts manipulés sont si complexes que leur documentation sur les supports séquentiels conventionnels comme le livre imprimé fait problème.

Voici en terminant un schéma de l'ingénierie textuelle :

Notre contribution consiste d'une part à mettre en relief le caractère « textuel » des documents mis en réseaux et, d'autre part, à proposer, et ceci de façon très exploratoire, les éléments d'une réflexion pour définir approche computationnelle de l'analyse des aspects de la textualité. Nous pensons qu'il faut intégrer au développement informatique le savoir et l’expertise développée par les analystes en sciences humaines dont la pratique d'analyse de texte est forte d’une tradition déjà plusieurs fois centenaire.

Notes

- ↑ Barret, E., TEd., (1988) Text, ConText, and HyperText. Wriüng with and for the Computer, MIT Press Sériés in Information Systems, Cambridge, Massachusetts, The MIT Press,1988,368 pages.

- ↑ Smith, John B., et Weiss, Stephen F., HYPERTEXT, Communications of the ACM, July 1988, Volume 31, n°7.

- ↑ Borel, M., Grize.J., Miéville, D., (1983) Essai de logique naturelle, Berne, ’Editions Peter Lang SA,1983, Sciences pour la communication, No 4,241 pages.

- ↑ Beaugrande, R.(L, Dressler, W.U., (1981) Introduction to TextLinguistics, London and New York,Longman,1981,270 pages.

- ↑ "... the successes of language processors on small domains and their failure on unrestricted domains result from the fundamental nature of language. In particular, a large grammar are not sufficient to scale up a small system to an unrestricted natural language processor" in SOWA, J. F. "Multi-Domain Semantic Theory" copie de travail fourni par l'auteur lors d'une conférence à Montréal et daté du 28 novembre 1988.

- ↑ Dijk, T Av., (1977) Text and Context. Explorations in the semantics and pragmatics of discourse, London and New York, Longman,1977,261 pages.

- ↑ Beaugrande, R.d., Dressler, W.U., op. cit. pp. 182-208.

- ↑ Maingueneau, D., (1976) Initiation aux méthodes de l'analyse du discours, Paris, Librairie Hachette,1976, 191 pages; Maingueneau, D., (1987) Nouvelles tendances en analyse du discours, Paris, Librairie Hachette,1987,144 pages.

- ↑ Barret, E-, éd. sc., (1989) The Society ofText. Hypertext, Hypermedia, and the Social Construction of Information, MIT Press Sériés in Information Systems, Cambridge, Massachusetts, Hie MIT Press,1989, 459 pages; Barret, éd. sc., (1988) Text, ConText, and HyperText. Writing with and for the Computer, MIT Press Saies in Information Systems, Cambridge, Massachusetts, The MIT Press,1988,368 pages.

- ↑ McCarty, W., 1988, notes parues sur le réseau électronique HUMANISTS sur le réseau BITNET.

- ↑ Beaugrande, R.d., Dressier, W.U., (1981) Introduction to Text Linguistics, London and New York, Longman,1981, 270 pages.

- ↑ Borel, M.-J.; Grize, J.-B.; Miéville, D. Essai de logique naturelle. Berne: 'Editions Peter Lang SA; 1983; Sciences pour la communication (4), 241 pages.

- ↑ Foucault, M., (1969) L'archéÉologie du savoir, Éditions Gallimard,1969,275 pages.

- ↑ Pour une classification voir Susan Haack, Philosophy ofLogics. Great Britain: Cambridge University Press; 1978; 276.

- ↑ Borel, M.-J.; Grize, J.-B.; Miéville, D. Essai de logique naturelle. Berne: 'Editions Peter Lang SA; 1983; Sciences pour la communication (4), L'idée d'argumentation, pp. 9-52.

- ↑ Borel, M.-J.; Grize, J.-B.; Miéville, D. Essai de logique naturelle. Berne: 'Editions Peter Lang SA; 1983; Sciences pour la communication (4): p. 99.

- ↑ Lecomte, Alain (1986), «Espace des séquences; approche topologique et informatique de la séquence», Dans : Maldidier, Denise et al. Langages, n°81,1986, Analyse de discours, nouveaux parcours. Hommage à Michel Pêcheux, pp. 91-110.

- ↑ Paquin, Louis-Claude, Daoust François, «Construction d’un atelier cognitif et textuel (ACTE)», Texte présenté par le Centre d'ATO le 20 juin 1989 en contribution au projet DELTA coordonné par le Ministère des Communications du Québec, 20 pages.

- ↑ Ce projet a été initié en 1986. Une subvention de type «Action spontanée» a été attribué pour deux ans (1987-1989) par l'organisme provincial FCAR. Le responsable était J. Duchastel, professeur de sociologie et directeur du Centre d'ATO. Le projet SACAO a été présenté au congrès du SCACC tenu à Trêves (Trier -RFA) en 1987; voir aussi Daoust F., Duchastel J., Dupuy L. «Système d'analyse de contenu assistée par ordinateur» Actes du Colloque La description des langues naturelles en vue d'applications linguistiques, Centre international de recherche sur le bilinguisme, Québec, 1989,197-210.