CIDE (2003) Michel

Génération de documents d'évaluation des connaissances pour l'e-learning

|

Sommaire

- Node de l'éditeur Wicri

- Les images sont renumérotées à partir de 7 (doublon dans l'article initial).

- Résumé

- Notre propos dans cet article est de présenter la spécification IMS Question & Test Interoperability Specification (IMS-QTI). Celle-ci décrit des méthodes et contenus d’évaluation dans un contexte d’enseignement à distance. Un prototype expérimental dénommé G-QTI est présenté ici. Il permet de générer des documents d’évaluation conformes à la spécification dans une perspective d’échange de ressources entre systèmes.

Introduction

Les spécifications en matière d’e-learning sont proposées par l’Instructional Management System Global Learning Consortium (IMS[1]) [IMS02]. L’IMS est un groupe de travail né en 1997 et composé de membres issus de l’éducation, des entreprises et des organisations gouvernementales. IMS a pour objectifs principaux de définir des spécifications techniques pour l’interopérabilité des applications et services de l’éducation distribuée et de supporter l’incorporation des spécifications dans les technologies du web. Ces dernières sont formalisées puis transmises à l'Institute of Electrical and Electronics Engineers (IEEE[2]) qui se charge de faire des propositions à l'International Standard Organization en particulier à son comité technique JTC1 (Joint Technical Committee) au niveau du groupe SC36 (Sub Committee 36 « IT for learning, education and training »[3]) afin de les faire passer du statut de standard à celui de norme. Un historique détaillé du processus de construction de ces groupes de réflexion est présenté dans [MIC02].

La spécification la plus aboutie et qui est en passe de devenir une norme est le LOM (Learning Object Metadata). Il définit l’ensemble minimal de caractéristiques indispensables pour gérer les objets pédagogiques. Il considère qu’un objet pédagogique est « toute entité, sur un support numérique ou non (informatique), pouvant être utilisée pour l'apprentissage, l'enseignement ou la formation » [LOM01]. Neuf catégories de descripteurs [IMS01a] [LOM01] sont prises en compte selon une structure hiérarchique (contrairement au modèle Dublin Core). Pour une présentation détaillée des descripteurs on se réfèrera à [MIC02]. Le LOM, bien que très complet et permettant une variété de description large et personnalisée n’est pas apte à caractériser correctement des ressources de type évaluation ou tests interactifs. Or, la question de l’évaluation est un des enjeux majeurs dans le domaine de la formation et de l’enseignement. Selon Hadji, « l’évaluation dans un contexte d’enseignement a pour fin légitime de contribuer à la réussite de l’enseignement, c’est à dire à la construction de ces savoirs et compétences par les élèves ». Selon lui, l’évaluation est au service de l’apprentissage et « l’évaluation formative est l’horizon logique d’une pratique évaluative » [HAD97]. En effet, l’évaluation peut avoir plusieurs objectifs :

- L’évaluation diagnostique, mise en œuvre en début de formation, permet de définir des parcours individualisés.

- L’évaluation formative qui a lieu avant et pendant le cours permet d’effectuer des ajustements si nécessaire. Le formateur et l’apprenant sont tous deux informés des étapes ou paliers franchis (modification sur l’action pédagogique). A ce titre, l’évaluation formative joue un rôle de régulation et d’aide à l’apprentissage.

- L’évaluation sommative permet de mesurer des acquis d’un apprenant en fin de formation [HAD00]. C’est cette évaluation qui souvent permet l’obtention d’un diplôme ou certificat.

On peut remarquer que les systèmes e-learning se modifient et intègrent de plus en plus des modules d’évaluation. En effet, bon nombre d’entre eux permettent d’intégrer des systèmes d’autotests avec feedback, accompagnant le cours ou diffusés avant le cours, de manière à saisir le niveau de l’apprenant et éventuellement lui indiquer les points de cours à approfondir. Cette évaluation peut également intervenir après le cours pour l'obtention d'un diplôme ou certificat comme le PCIE (Passeport de Compétences Informatique Européen[4]).

Outre les qualités didactiques et pédagogiques de ces actions, on peut voir qu’elles permettent de faire évoluer les systèmes d’apprentissage vers des systèmes dits adaptatifs, comme les systèmes tutoriels intelligents (STI) [NKA96], c’est à dire capable de gérer du matériel didactique selon le comportement global de l’apprenant. On comprend donc bien l’extrême nécessité de caractériser le plus précisément possible ce type de ressource, et de le faire selon des normes ou spécifications universellement employées de manière à favoriser l'interopérabilité entre les systèmes. C'est pourquoi nous nous sommes orientés vers l'étude des spécifications en cours d’élaboration. Celle qui est la plus aboutie est IMS-QTI (Question & Test Interoperability). Nous allons la présenter plus précisément.

Une spécification pour l'évaluation des connaissances

La spécification IMS-QTI

La spécification Question & Test Interoperability (QTI) de l’IMS permet de représenter la structure de données d’une question et d’un test ainsi que de leurs résultats correspondants. En effet, un test est codé comme un assessment. Il peut se composer de plusieurs Item qui sont les objets servant à l’évaluation c’est à dire généralement les questions. L'item est accompagné de sa présentation (rendering) et des informations pour sa notation (scoring). Ces éléments, combinés et intégrés dans des documents écrits en XML, doivent permettre l’échange des contenus de type évaluation entre les plates-formes d’enseignement à distance et leur intégration avec d’autres contenus. Tout comme pour le LOM, le choix de XML pour présenter la spécification QTI dénote l’intention d’ouverture et de facilitation sans prédire des choix techniques d’implémentation à mettre en œuvre.

A l’instar de XML, la spécification IMS-QTI est extensible et adaptable pour des applications spécifiques. Comme c’est le cas pour les autres spécifications, celle-ci n’influe pas sur les concepts pédagogiques ni sur les choix techniques de programmation et/ou d’interface graphique laissés à la libre appréciation des concepteurs d’outils logiciels et des producteurs de contenus. QTI concerne les fournisseurs de contenus (éditeurs d’évaluations, de tests...), les éditeurs de plates-formes d’enseignement à distance (VLE Virtual Learning Environment ou LMS Learning Management System), les éditeurs d’outils logiciels d’évaluation et les utilisateurs (apprenants et enseignants/concepteurs d’évaluation).

La spécification QTI est encore jeune, la première version publique v 1.0 a été présentée au mois de mai 2000 et nous nous appuyons ici sur la version v 1.2 datée de janvier 2002. La documentation sur la spécification se présente en plusieurs documents, en particulier [SMY02a] donne une vue d’ensemble sur la spécification, [SMY02b] présente les concepts principaux regroupés sous l’acronyme ASI pour Assessment-Section-Item, [SMY02c] décrit comment s’implémente le modèle à l’aide de XML et enfin [SMY02d] et [SMY02e] complètent la présentation des concepts et aident à la mise en œuvre. Tous les documents cités ici sont mis à disposition sur le serveur Web de l’IMS[5].

La spécification est en fait très complexe et va bien au-delà qu'un simple système de méta-description des questions, des éléments de réponse et des résultats correspondants. Pour en faciliter le développement et l’usage, l’IMS a prévu une version allégée : « QTI Lite Specification » qui peut être un point de départ d’implémentation. Selon la spécification IMS QTI Lite 1.2 [SMY02i] un item se décrit selon plusieurs éléments dont :

- objectives qui permet d’indiquer les buts éducatifs (objectif pédagogique) de la question

- rubric qui permet de définir des éléments d’information liés au contexte

- presentation qui comprend aussi bien l’énoncé de la question que les choix de réponses possibles

- resprocessing gère le processus de notation et les solutions de la question

- itemfeedback gère les retours écran des utilisateurs en fonction de leur réponse.

La spécification prévoit plusieurs types de questions : «True/false», «Multiple-choice», «Multiple-response», «FIB-string», «FIB-numeric», « Image hot-spot », «Drag-and-drop », «Essay» qui correspondent respectivement à « question vrai/faux», « QCM à réponse unique », « QCM à plusieurs réponses», «Texte à trous pour du texte ou un nombre», «image cliquable», «déplacer les objets», «question ouverte». Les réponses aux questions peuvent être simples, multiples ou ordonnées et s'expriment par « single », « multiple », « ordered », « proprietary » dans <qmd_responsetype>, <qmd_responsetype> et <qmd_rendering type>. Ces éléments jouent le rôle de métadescripteurs pour la ressource d'évaluation. Ils favorisent l'indexation de l'item et sont placés dans la partie réservée aux métadonnées : <qtimetadata>.

La déclaration des types de question et des types de réponses attendues se font par les balises de type render et response. Ces balises permettent de gérer le format de données et le mode de présentation proposé au participant à l'évaluation.

Ainsi le type de réponse est défini par les éléments suivants :

- <response_lid> si la réponse simple ou multiple) est la sélection d'un identificateur (répétée ou non) parmi les réponses possibles proposées au participant (choix décrits par <response_label>),

- <response_xy> si la réponse se formule par des coordonnées dans une image,

- <response_str> si c'est une chaîne de caractères,

- <response_num> si c'est une valeur numérique,

- <response_grp> si on est dans le cas décrit dans <response_lid> mais avec une possibilité d'avoir une liste d'identificateurs pour décrire un choix possible (les propositions de réponse sont en fait des listes et non pas un élément unique pour chaque modalité).

Le type de présentation est géré par les éléments suivants :

- <render_choice> pour une présentation de type vrai/faux ou à choix multiple (et réponse multiple), comme les figures 1 et 2.

- <render_hotspot> pour une image sensible (déplacement d'objets ou clic sur une zone de l'image...),

- <render_fib> pour une question ouverte (ou à trous), comme la figure 3

- <render_slider> pour une échelle de valeurs (jauge ou règle à activer) comme la figure 4

La combinaison des balises de type render et response permet ainsi une grande richesse dans les types de questions pouvant être déclarées. En effet, considérons l'exemple suivant : L'étudiant doit placer son curseur sur le globe oculaire dans une image représentant la photo d'un visage. La réponse attendue est une position (définie par l'auteur). La solution est prise en compte par la balise <respcondition> qui indique quelle zone à l'écran doit être cliquée. Les codes suivants vont permettre de décrire ce cas de figure.

Méta-description de la question

|

<itemmetadata>

<qmd_itemtype>XY-coordinate</qmd_itemtype>

<qmd_renderingtype>Hot spot</qmd_renderingtype>

<qmd_responsetype>Single</qmd_responsetype>

</itemmetadata>

|

| Code XML 1 |

|---|

Description de la question et de la présentation du type de réponse attendue

|

<presentation>

<material>

<mattext texttype="text/plain">

Placez le curseur sur le globe oculaire.

</mattext>

</material>

<response_xy ident="1 " rcardinality="Single">

<render_hotspot>

<material>

<matimage imagtype="image/jpg " uri="photo.jpg " height="200" width="200"/>

</material>

</render_hotspot>

</response_xy>

</presentation>

|

| Code XML 2 |

|---|

Description de la solution à la question posée

|

<respcondition title="right" >

<conditionvar>

<varinside respident="1" areatype="Rectangle">48,50 67,74</varinside>

</conditionvar>

<setvar>1</setvar>

<displayfeedback linkrefid="right"/>

</respcondition>

|

| Code XML 3 |

|---|

Dans <itemmetadata> le niveau de difficulté peut-être indiqué par <qmd_levelofdifficulty> selon les valeurs : «Pre-school», «School», «Higher/further education », « Vocational », «Professional Development » (c’est à dire respectivement différents niveaux de scolarité ou formation professionnelle).

La spécification permet de contrôler l'ordre et le type de sélection des objets [SMY02e] et intègre des algorithmes complets et pré -définis de calcul des scores [SMY02f]. Ce principe est mis en place de façon à éviter les transformations et manipulations sur le document XML tout en offrant des systèmes de notation de référence. Les algorithmes proposés sont suffisamment larges pour limiter le recours à des adaptations trop spécifiques et ainsi plus difficilement inter échangeables. Les résultats obtenus par les participants peuvent eux aussi être caractérisés [SMY02g]. La mise en œuvre en XML est facilitée par le « Results Reporting XML Binding » [SMY02h] et « Results Reporting Best Practices & Implementation Guide » [SMY02i] qui s'inspirent d'expériences des utilisateurs de la spécification.

L’utilisateur en interaction avec un exercice (assessment) est appelé participant. Le modèle de données se décrit de la manière suivante. Un assessment est l’unité de base pour un test (évaluation). Une section est une enveloppe pouvant contenir des groupes de sections et des items qui vérifient un même objectif. L’item est un bloc contenant la question (mais également la réponse, les aides... comme nous l'avons dit précédemment). Un object bank est un ensemble de sections et/ou d’items qui peut être échangé en tant que base de données d’objets d’évaluations. C’est au niveau du Content Packaging [AND01a] que l’intégration peut être effectuée de manière à permettre l’échange entre applications. Ce principe est le même que pour les objets pédagogiques du curriculum [MIC02]. En effet, selon la spécification IMS Content Packaging un package peut être organisé dans un seul fichier PIF (Package Interchange File) qui est de type archive compressée (format ZIP) pour faciliter son échange entre plates-formes. Mais un package peut également être présenté sous la forme d'un ensemble de fichiers (sur un cédérom par exemple). Un package est composé de deux parties : le manifest et les fichiers physiques. Le manifest est un document XML (appelé imsmanifest.xml) qui décrit l'organisation du contenu ainsi que les ressources. Il est situé à la racine du package. Il est accompagné des fichiers physiques (fichiers textes, html, graphiques, vidéos) caractérisés par les éléments du LOM. Ce package est autonome et constitue une ressource ré-utilisable incorporable dans une plate-forme d'enseignement ou pouvant être incorporée dans un autre manifeste [AND01b] [AND01c]. Il peut être aussi simple qu'une simple image et sa description (en tant qu'objet pédagogique) que contenir un cours complet. De la même façon, les évaluations décrites avec QTI peuvent être incorporées dans le manifest (donc dans le package) en étant référencées comme les autres éléments (ressources physiques) car codées dans un fichier au format XML.

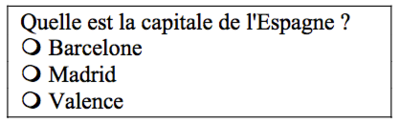

Un exemple

Voyons maintenant sur un exemple complet comment coder une question ainsi que les possibles réaction selon la réponse du participant. Nous choisissons volontairement une question simple à choix unique :

L'objectif de la question est pour l'enseignant de savoir si les connaissances du cours ont été mémorisées, et pour l'élève de connaître la capitale de l'Espagne, il se voit attribuer 3 points s'il répond Madrid. Un message de félicitations lui est envoyé et l'enseignant est prévenu que pour cet élève la connaissance est acquise. Il se voit attribuer -2 points s'il répond autre chose, un message d'alerte lui est envoyé, l'enseignant est prévenu qu'il doit envoyer la carte de l'Espagne à l'élève comme information complémentaire du cours. Il se voit attribuer -1 point s'il ne répond rien, reçoit un message d'alerte et l'enseignant est prévenu que cet élève ne travaille pas suffisamment. Avec la spécification IMS-QTI le document descriptif au format XML correspondant à cette question et aux paramètres d'apprentissage qui sont définis est:

|

<?xml version="1.0" encoding="iso-8859-1"?>

<questestinterop>

<item ident="1 ">

<objectives view="Candidate">

<material>

<mattext texttype="text/plain" charset="ascii-us" xml:lang="fr-FRA">

Connaissance des capitales</mattext>

</material>

</objectives>

<objectives view="Tutor ">

<material>

<mattext texttype="text/plain" charset="ascii-us" xml:lang="fr-FRA">

Validation de la mémorisation </mattext>

</material>

</objectives>

<rubric view="Candidate ">

<material>

<mattext texttype="text/plain" charset="ascii-us" xml:lang="fr-FRA" />

</material>

</rubric>

<rubric view="Tutor ">

<material>

<mattext texttype="text/plain" charset="ascii-us" xml:lang="fr-FRA"/>

</material>

</rubric>

<presentation>

<material>

<mattext texttype="text/plain" charset="ascii-us" xml:lang="fr-FRA">

Quelle est la capitale de l'Espagne ?</mattext>

</material>

<response_lid ident="RLID_1" rcardinality="Single" rtiming="No">

<render_choice shuffle="No" minnumber="1 " maxnumber="1">

<response_label ident="RLBL_ 1" rshuffle="Yes">

<material>

<mattext texttype="text/plain" charset="ascii-us" xml:lang="fr-FRA">

Barcelone </mattext>

</material>

</response_label>

<response_label ident="RLBL_ 2 " rshuffle="Yes">

<material>

<mattext texttype="text/plain" charset="ascii-us" xml:lang="fr-FRA">

Madrid</mattext>

</material>

</response_label>

<response_label ident="RLBL_ 3" rshuffle="Yes">

<material>

<mattext texttype="text/plain" charset="ascii-us" xml:lang="fr-FRA">

Valence</mattext>

</material>

</response_label>

</render_choice>

</response_lid>

</presentation>

<resprocessing>

<outcomes>

<decvar vartype="Integer" defaultval="0"/>

</outcomes>

<respcondition title="Correct ">

<conditionvar>

<varequal respident="RLID_1 ">RLBL_ 2</varequal>

</conditionvar>

<setvar action="Set">3</setvar>

<displayfeedback feedbacktype="Response " linkrefid="CorrectEl"/>

<displayfeedback feedbacktype="Response" linkrefid="CorrectEns"/>

</respcondition>

<respcondition title="Incorrect">

<conditionvar>

<not>

<varequal respident="RLID_1 ">RLBL_2</varequal>

</not>

</conditionvar>

<setvar action="Set ">- 2</setvar>

<displayfeedback feedbacktype="Response" linkrefid="IncorrectEl"/>

<displayfeedback feedbacktype="Response" linkrefid="IncorrectEns"/>

</respcondition>

<respcondition title="Unans">

<conditionvar>

<unanswered respident="RLID _ 1" />

</conditionvar>

<setvar action="Set">-1</setvar>

<displayfeedback feedbacktype="Response" linkrefid="UnansweredEl" />

<displayfeedback feedbacktype="Response" linkrefid="UnansweredEns" />

</respcondition>

</resprocessing>

<itemfeedback ident="Correct El" view="Candidate ">

<material>

<mattext texttype="text/plain" charset="ascii-us" xml:lang="fr-FRA">

La question était facile </mattext>

</material>

</itemfeedback>

<itemfeedback ident="CorrectEns" view="Tutor ">

<material>

<mattext texttype="text/plain" charset="ascii-us" xml:lang="fr-FRA">

Connaissance acquise </mattext>

</material>

</itemfeedback>

<itemfeedback ident="IncorrectEl" view="Candidate">

<material>

<mattext texttype="text/plain" charset="ascii-us" xml:lang="fr-FRA">

Revoir votre cours sur l'Espagne </mattext>

</material>

</itemfeedback>

<itemfeedback ident="IncorrectEns" view="Tutor ">

<material>

<mattext texttype="text/plain" charset="ascii-us" xml:lang="fr-FRA">

Mauvaise acquisition, envoyez la carte d 'Espagne par mail</mattext>

</material>

</itemfeedback>

<itemfeedback ident="Un answered El" view="Candidate ">

<material>

<mattext texttype="text/plain" charset="ascii-us" xml:lang="fr-FRA">

Revoir votre cours sur les capitales Européennes</mattext>

</material>

</itemfeedback>

<itemfeedback ident="Unanswered Ens" view="Tutor">

<material>

<mattext texttype="text/plain" charset="ascii-us" xml:lang="fr-FRA">Manque de travail</mattext>

</material>

</itemfeedback>

</item>

</questestinterop>

|

| Code XML 4 |

|---|

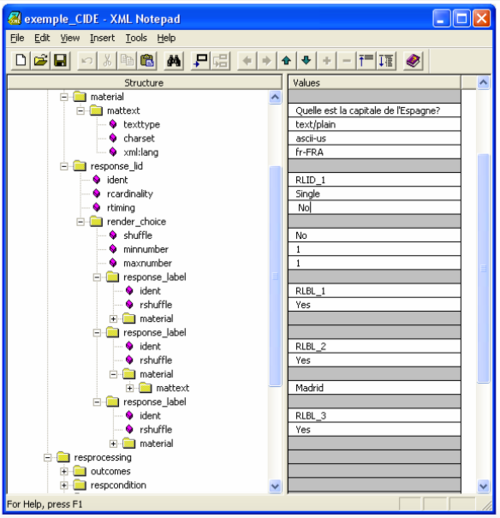

Comme nous pouvons le voir, le code nécessaire pour décrire cette question est complètement démesuré par rapport à sa brièveté et sa simplicité. Cette observation nous permet de formuler une critique fondamentale : la démarche de caractérisation de ressources d'évaluation ne sera effectivement réalisée que si l’on développe des outils logiciels de génération automatique de balises plus évolués que les éditeurs XML actuellement proposés. De nombreux outils d'édition de code XML existent aujourd'hui. Les fonctionnalités essentielles proposées sont la possibilité de visualiser le document selon son arborescence, de vérifier que le document est "bien formé", de créer ou de valider la DTD ou le schéma. Mais ces fonctionnalités ne sont pas adaptées à notre problème. Dans la copie d'écran nous donnons un aperçu de notre code dans un éditeur XML, en l'occurrence XML Notepad[6].

Nous le voyons bien, les documents XML devant contenir les éléments d'information décrivant l'évaluation doivent être produits et gérés par des applications restant à développer car les éditeurs actuellement disponibles sont incapables de le faire. La richesse et la complexité des spécifications nécessitent une intelligence logicielle capable à la fois de générer les balises suffisantes et d’accompagner l’auteur dans sa tâche de conception de ressources pédagogiques.

Mise en œuvre de la spécification IMS-QTI

Présentation du prototype G-QTI

Nous proposons un prototype de génération de questionnaire G-QTI (Générateur-QTI) conforme à IMS -QTI. Il est consultable à l'adresse : http://www.evaluation-online.com/enaction.html. Ce prototype, encore en cours de développement, a été créé comme un outil de découverte et d’apprentissage de la spécification IMS-QTI en travaillant par l’exemple. Il s'appuie sur des technologies de programmation de pages dynamiques de type ASP et Javascript. Ses fonctionnalités sont doubles :

- Il permet de générer le code correspondant à des questionnaires type QCM pouvant être incorporés dans des plates-formes d'e-learning disposant d’un outil d’importation conforme à IMS-QTI (exportation du document généré).

- Il permet aussi de vérifier si un document d’évaluation (importation d’un document) est conforme à la norme et dans l'affirmative de l’afficher.

G-QTI s'intègre dans une plate -forme d'évaluation en ligne en cours de développement ; IntraQTI ; disponible à l'adresse http://www.evaluation-online.com. A terme cette plate-forme comprendra, les fonctionnalités de gestion (notation, sécurisation, partage) et communication (forum, courrier, chat) classiques sur les plates -formes sécurisées d' e-learning. Son atout majeur sera la prise en compte des outils d'évaluation et le respect de la spécification QTI.

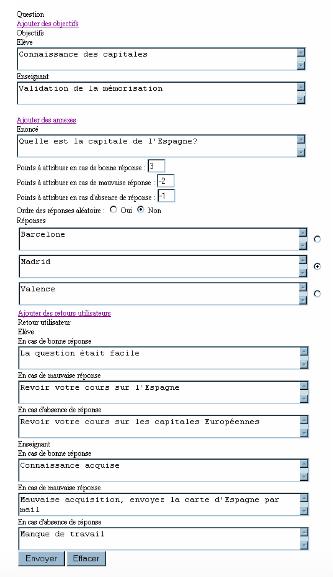

La génération de documents dans G-QTI

La génération de documents d'évaluation conformes à QTI se fait grâce à une interface web présentée sous la forme d'un formulaire de saisie. L'auteur du questionnaire peut indiquer, pour chaque question les objectifs visés tant au niveau de l'élève que pour l'enseignant, l'énoncé de la question, le nombre de points attribués en cas de bonne, mauvaise ou absence de réponse, l'ordre des réponses et les choix de réponses possibles. Ainsi dans l'exemple ci-dessus pour la capitale de l'Espagne, l'écran de saisie sera le suivant :

Grâce à un script ASP, le système G-QTI stocke les paramètres saisis et les utilise pour construire le code XML correspondant Le résultat est affiché directement, l'auteur peut donc le copier et l'enregistrer dans un fichier. C'est ce fichier qui est réutilisable dans une plate-forme ou tout autre outil logiciel conforme et permettant

l'importation de document de type QTI. Nous avons testé la validité du code XML produit automatiquement dans le cas de la question sur la capitale de l'Espagne (code XML 4 présenté dans la partie 2). Pour ce faire nous l'avons importé chez l'éditeur de logiciels QuestionMark[7] qui annonce la conformité de leur produit Perception[8] à IMS-QTI. Dans la copie d'écran suivante, nous pouvons voir à gauche notre code généré par G-QTI, chargé dans l'afficheur "Question Mark QTI Xml Viewer"[9] et le résultat dans la partie droite parfaitement lisible.

Figure 7

L'importation, la vérification et l'affichage de code dans G-QTI

L'interface de saisie du fichier à importer, vérifier et afficher se présente sous la forme d'un formulaire simple comme ci -dessous : Figure 8 Le document importé est étudié de manière à vérifier s’il est « conforme » à la spécification. Dans le cas favorable le document importé est alors affiché par le prototype.

Les développements futurs de G-QTI

Comme nous l'avons dit les outils logiciels de génération automatique de balises doivent être plus évolués que les éditeurs XML actuellement proposés et dépasser le stade de la gestion de simples objets comme les formulaires à compléter et fournir une aide réelle comme les systèmes auteurs le font. Les premiers développements de G-QTI vont dans ce sens avec la possibilité qui est donnée aux auteurs de spécifier les objectifs pédagogiques à valider par le formulaire, les notations et les rétro-actions à effectuer selon les questions. Les futurs développements vont concerner une prise en compte générale de la spécification IMS-QTI.

Ces développements seront alors repris pour intégrer la plate-forme IntraQTI d'évaluation des connaissances en ligne. Cette plate-forme proposera à terme les fonctionnalités suivantes :

- Un forum

- Un système de news (actualités)

- Une gestion d'articles scientifiques publiés sur la plate-forme

- Une messagerie privée entre les différents utilisateurs du système (étudiants, apprenants, concepteurs, enseignants, administrateurs)

- La gestion des utilisateurs (création de comptes)

- La gestion de groupes d'utilisateurs (classes, sections, groupes de travail)

- La gestion des résultats des apprenants

- La gestion complète des évaluations (interroger un groupe d'étudiants, partager les tests avec d'autres concepteurs/enseignants, permettre un accès libre à certains tests)

- La création des tests et incorporation dans la base de données IntraQTI

- Importation et exportation avec conformité à la spécification IMS-QTI

Conclusion

La nécessité de développer des outils d'évaluation dans des contextes ouverts s'accélère en mettant en évidence le besoin de décrire de manière stable des contenus à évolution rapide (comme pour les outils d'évaluation des connaissances dans le domaine de la bureautique par exemple). L’ajout de nouvelles caractéristiques, comme celles présentées dans IMS-QTI, est devenu nécessaire. La mise en place d'évaluations diagnostiques et formatives peut améliorer considérablement la personnalisation des systèmes destinés à l'évaluation des connaissances dans un contexte web en leur donnant une dimension interactive et dynamique supplémentaire. Il semble alors difficile de dissocier le support de cours (contenu pédagogique) de l'évaluation des connaissances acquises. Les deux volets doivent être envisagés de manière globale or les plates-formes pédagogiques comme WebCT[10] n'ont jusque là développé que la première partie, c'est à dire la présentation des cours. Les éditeurs de plate-formes s'engagent de plus en plus dans réalisation de produits d'échange de contenus en conformité avec les spécifications, et en particulier QTI, de manière à permettre l'importation et l'utilisation de ressources plus élaborées que celles actuellement usuellement disponibles[11]. La spécification IMS-QTI, encore à ses débuts, est très prometteuse car elle prend en compte des contextes extrêmement variés. Paradoxalement, cette grande diversité peut être un frein à son développement, comme cela a été le cas pour SGML, s'il n'y a pas d'éditeur, capable d'aider à la caractérisation de ces ressources. Le prototype que nous proposons G-QTI, permet non seulement de concevoir des ressources d'évaluation compatibles avec la spécification QTI mais aussi de favoriser l'interopérabilité en validant la conformité de ressources déjà développées et d'être un point de départ pour l'intégration des spécifications dans la plate-forme IntraQTI.

La recherche restant à mener dans cette voie repose sur les processus d'aide à la création de ressources d'évaluation et la génération automatisée de documents. Cette génération de document d'évaluation pourra se faire en se basant sur la spécification étudiée en permettant une réutilisation dans des contextes différents aussi bien au niveau matériel (écran, environnement graphique) qu'au niveau utilisateur (profil de l'apprenant).

Références bibliographiques

[AIC03] ↑ AICC, Aviation Industry CBT (Computer Based Training) Committee

<http://www.aicc.org>(consulté en janvier 2003)

[AND01a] ↑ Anderson T., McKell M., IMS Content Packaging Information Model, Final Specification, Version 1.1.2, IMS, août 2001 (a)

[AND01b] ↑ Anderson T., McKell M., IMS Content Packaging XML Binding, Final Specification, Version 1.1.2, IMS, août 2001 (b)

[AND01c] ↑ Anderson T., McKell M., IMS Content Packaging Best Practice Guide, Final Specification, Version 1.1.2, IMS, août 2001 (c)

[BOU00] ↑ Bouda Y., Hélier M., Métadonnées et XML : applications aux "objets pédagogiques", Colloque International Technologies de l'Information et de la Communication dans les Enseignements d'Ingénieurs et dans l'industrie, 18-20 octobre 2000, Troyes

[DUV01] ↑ Duval E., Normalisation des technologies éducatives : à quoi bon ?, Hypermédias et apprentissage, 9-11 avril 2001, Grenoble

[ELE01] ↑ eLearning - Penser l'éducation de demain, communication de la Commission des Communautés européennes, COM(2001) 172 final, 28 mars 2001,

- < http://europa.eu.int/eur-lex/fr/com/cnc/2001/com2001_0172fr01.pdf > (consulté en mars 2002)

[HAD97] ↑ Hadji C., L’évaluation démystifiée, ESF, Paris, 1997

[HAD00] ↑ Hadji C., Les voies de l’évaluation, sciences humaines n°12, février/mars 1996, texte revu et corrigé par l’auteur, décembre 2000, dans Eduquer et former, éditions sciences humaines, Jean-Claude Ruano-Borbalan (coord. par), 2001, p. 131-138.

[HIL01] ↑ Hillmann D., Guide d'utilisation du Dublin Core, 2001,

- < http://www.bibl.ulaval.ca/DublinCore/usageguide-20000716fr.htm > (document consulté en janvier 2003)

[LOM02] ↑ IEEE Learning Technology Standards Committee (LTSC) P1484.12.1-2002 Learning Object Metadata Working Group, “Draft Standard for Learning Object Metadata”,

[MCK01a] ↑ McKell M., Thropp S., IMS Learning Resource Meta-Data Information Model, Final Specification, Version 1.2.1, IMS, septembre 2001

[MCK01b] ↑ McKell M., Thropp S., IMS Learning Resource Meta-Data XML Binding, Final Specification, Version 1.2.1, IMS, septembre 2001

[MCK01c] ↑ McKell M., Thropp S., IMS Learning Resource Meta-Data Best Practice and Implementation Guide, Final Specification, Version 1.2.1, IMS, septembre 2001

[MIC02] ↑ Michel C., Rouissi S., Etude de l'organisation et caractérisation de l'information pédagogique pour construire des documents hypermédias adaptatifs diffusés sur le Web, Conférence Internationale sur le Document Électronique, 20-23 octobre 2002, Hammamet (Tunisie)

[NKA96] ↑ Nkambou R., " Modélisation des connaissances de la matière dans un système tutoriel intelligent, modèles, outils et applications" Thèse présentée à l’Université de Montréal en Avril 1996

[SMY02a] ↑ Smythe C., Shepherd E., Brewer L., Lay S., IMS Question & Test Interoperability : An Overview, Final Specification Version 1.2, IMS, février 2002

[SMY02b] ↑ Smythe C., Shepherd E., Brewer L., Lay S., IMS Question & Test Interoperability: ASI Information Model, Final Specification, Version 1.2, IMS, février 2002

[SMY02c] ↑ Smythe C., Shepherd E., Brewer L., Lay S., IMS Question & Test Interoperability: ASI XML Binding Specification, Final Specification, Version 1.2, IMS, février 2002

[SMY02d] ↑ Smythe C., Shepherd E., Brewer L., Lay S., IMS Question & Test Interoperability: ASI Best Practice & Implementation Guide, Final Specification, Version 1.2,IMS, février 2002

[SMY02e] ↑ Smythe C., Shepherd E., Brewer L., Lay S., IMS Question & Test Interoperability: ASI Selection & Ordering Specification, Final Specification, Version 1.2, IMS, février 2002

[SMY02f] ↑ Smythe C., Shepherd E., Brewer L., Lay S., IMS Question & Test Interoperability: ASIOutcomes Proces sing Specification, Final Specification, Version 1.2, IMS, février 2002

[SMY02g] ↑ Smythe C., Shepherd E., Brewer L., Lay S., IMS Question & Test Interoperability: Results Reporting Information Model, Final Specification, Version 1.2, IMS, février 2002

[SMY02h] ↑ Smythe C., Shepherd E., Brewer L., Lay S., IMS Question & Test Interoperability: Results Reporting XML Binding, Final Specification, Version 1.2, IMS, février 2002

[SMY02i] ↑ Smythe C., Shepherd E., Brewer L., Lay S., IMS Question & Test Interoperability: Results Reporting Best Practice & Implementation Guide, Final Specification, Version 1.2, IMS, février 2002

[SMY02j] ↑ Smythe C., Shepherd E., Brewer L., Lay S., IMS Question & Test Interoperability: QTILite Specification, Final Specification, Version 1.2, IMS, février 2002 (j)

Notes

- ↑ IMS : Instructional Management Systems

- ↑ IEEE : <http://www.ieee.org>

- ↑ ISO, JTC1 : <http://jtscl36.org>

- ↑ PCIE : <http://www.pcie.tm.fr>

- ↑ IMS, <http://www.imsproject.org> (site consulté en février 2003)

- ↑ XML NotePad, éditeur XML de MicroSoft, version Beta 1.5

- ↑ http://www.questionmark.com/

- ↑ http://www.questionmark.com/fra/perception/index.htm

- ↑ L'outil de visualisation est librement télédéchargeable depuis le site de Questionmark <http://www.questionmark.com/perception/help/v2/qtixml.html>

- ↑ WebCT, Web Course Tools plate-forme d'enseignement à distance largement diffusée dans le contexte universitaire : <http://www.webct.com/compagny/>

- ↑ WebCT IMS Content Migration Utility, outil d'échange de contenus de cours et/ou d'évaluations : <http://download.webct.com/utility/1_2_2_cmu_release_notes_feb20.html>