Piia de Majorque (2024) Ducloy

Piia de Mallorca est un groupe de travail sur les pratiques informationnelles à l'heure de l'Intelligence Artificielle.

Sommaire

- 1 Vers un cinquième paradigme avec Wikipédia et l'IA

- 2 Les comportements informationnels, de l'antiquité au temps de l'intelligence artificielle

- 2.1 Les livres et leur diffusion depuis l'antiquité

- 2.2 Rassembler les livres dans les bibliothèques

- 2.3 Rassembler les connaissances dans un catalogue, une collection, une encyclopédie ou une histoire naturelle

- 2.4 L'imprimerie au service de la connaissance

- 2.5 Les pionniers de la programmation au début des ordinateurs

- 2.6 Les grandes applications pour quelques pionniers des humanités numériques

- 2.7 Des progiciels pour maitriser les mutations numériques

- 2.8 Stations de travail sous Unix un socle pour aborder l'intelligence artificielle

- 2.9 Unix et Xml pour l'appropriation du numérique par les praticiens de l'IST

- 2.10 Des progiciels pour les archives ouvertes, les revues numériques et les données de la recherche

- 2.11 Le World Wide Web du rêve utopique à la confrontation à la désinformation

- 2.12 Des outils informationnels de plus en plus performants

- 2.13 Les wikis programmables et sémantiques pour les humanistes du XXIe siècle

- 2.14 Explorer les nouveaux comportements informationnels avec Wicri

- 2.15 Les comportements informationnels collectifs et politique à l'heure du numérique et de l'IA

- 2.16 Bibliographie

Vers un cinquième paradigme avec Wikipédia et l'IA

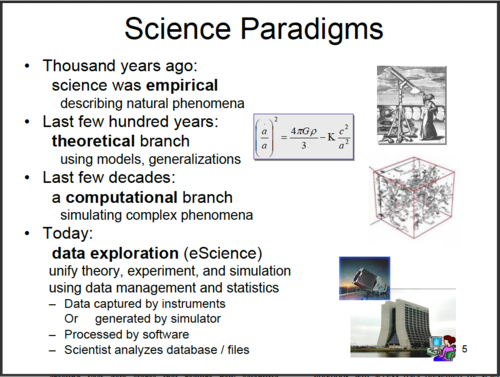

L'hypothèse de Jim Gray sur les pratiques scientifiques met en perspective quatre changements de paradigmes dans les pratiques scientifiques :

La groupe de réflexion Piia de Mallorca explore un cinquième paradigme induit par les pratiques numériques coopérativo-sémantique et par l'intelligence artificielle.

Notons déjà que la notion de constante de temps se mesure maintenant en années, et déjà plus en décades.

Les comportements informationnels, de l'antiquité au temps de l'intelligence artificielle

Depuis l'an 2000, la simple phrase « J'ai lu dans Google que... » remplace « J'ai lu dans le Larousse que ... » dans les années 90. Elle montre déjà, pour le public, les très grandes difficultés rencontrées pour évaluer la fiabilité d'un message. En 2024, dans la recherche de connaissance, ou plus généralement dans les pratiques de lecture dans le numérique, comment est vécue l'explosion de l'intelligence artificielle ?

Or justement, dans ses missions éducatives, l'Université doit enseigner comment lire dans un monde informationnel qui devient totalement débordé par la désinformation. Elle doit le faire dans un paysage technologique de plus en plus complexe, celui de l'hypertexte, de l'hypermédia, des robots informationnels et maintenant de l'IA.

Mais, en même temps, l’université doit maitriser une autre explosion, celle de l'évaluation par indicateurs numériques qui entraîne un déluge d'articles de 9-12 pages en double aveugle, et donc, coupés de leur contexte. Ce phénomène met à mal sa disponibilité pour répondre aux défis les défis de l'information numérique. Au moment où la science ouverte met ses données à la disposition de le sociétés, celles-ci deviennent de plus en plus incompréhensibles pour un public non spécialiste.

Or le numérique offre une gigantesque palette de possibilités avec le multimédia, l'écriture numérique, l'écriture collaborative, l'écriture programmatique, l'hypertexte et maintenant l'IA. Comment repenser l'écriture numérique de la science, de la technique et de la culture face à cette explosion de nouveaux mécanismes grammaticaux-linguistiques ?

Les chercheurs, praticiens et médiateurs de l'information (conservateurs, éditeurs, bibliothécaires, archivistes, rédacteurs de l'innovation) ont su faire évoluer leurs pratiques sur plusieurs millénaires en fonction de l'évolution des supports. Ils disposent d'une offre d'outils de plus en plus sophistiquée avec les logiciels d'édition, les systèmes de gestion de contenu, wikis programmables et sémantiques, et maintenant l'IA. Comment former les ingénieurs de la connaissances pour qu'ils encadrent les praticiens et les chercheurs pour qu'ils s'approprient des nouvelles pratiques informationnelles en pleine mutation ?

Enfin l'IA est de fait alimentée par des gigantesques corpus de données textuelles. Les algorithmes d'apprentissage sont particulièrement consommateurs de données de synthèse : résumés, indexation et ontologies. Comment produire des ensembles informationnels de haute qualité, de bonne fiabilité pour un bon usage de l'intelligence artificielle.

Nous proposons une réflexion historique pour mieux comprendre ces multiples évolutions des comportements informationnels. Elle inclura quelques témoignages de l'auteur de cet article, qui a connu une enfance sans ordinateurs et a rejoint, en 1967, les équipes de pionniers qui ont affrontés diverses marches successive de de nouveau changement de paradigme.

Les livres et leur diffusion depuis l'antiquité

La fabrication des premiers supports d'écriture (tablette, papyrus ou parchemin) était complexe (et coûteuse). La pratique de l'écriture était limitée à la caste des érudits. Mais déjà, les premiers auteurs ont du faire évoluer leurs comportements, par exemple pour passer de la tablette au volumen, puis au codex. Ce dernier modèle, très proche du livre actuel, et toujours adapté à la rédaction d'un roman ou d'un poème épique, ouvrait la porte à de nouvelles pratiques de lecture comme le feuilletage.

Le monde de l'édition était représenté par les scribes et les copistes.

En effet les seules façons de diffuser un livres étaient de le déclamer ou de le copier.

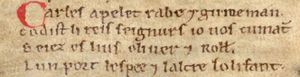

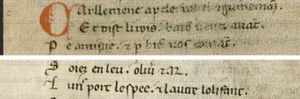

Avec ce type de pratique, une œuvre littéraire pouvait évoluer assez naturellement dans le temps. En effet, chaque copiste pouvant introduire des modifications (ou faire des erreurs). Voici un exemple sur la Chanson de Roland.

|

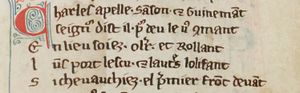

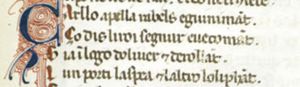

Manuscrit d'Oxford : 2ème quart du XIIe siècle. Carles apelet Rabe 7 Guineman ; |

Manuscrit de Châteauroux : XIIIe siècle. Carllemene apele Rabel et Guineraant |

|

Manuscrit de Paris : XIIIe siècle. Charles apelle Sanson et Guinemant : |

Manuscrit de Venise IV : : XIIIe siècle, dialecte franco-italien. Çarllo apella Rabels e Guinimant. |

Il s'agit bien du même passage. Charlemagne de retour à Roncevaux demande à deux de ses pairs de prendre la place d'Olivier et de Roland (l'un portant l'épée et l'autre l’olifant). Chaque version est adaptée à différents niveaux de langue. On notera des différences sensibles (par exemple, Rebel devient Sanson). Le style des lettrines évolue.

Rassembler les livres dans les bibliothèques

La multiplication des livres a entrainé des problèmes de stockage, et d'usage collectif.

Par exemple, à Ninive des archéologues ont retrouvé vingt-deux mille tablettes d'argile dans les ruines d'un palais.

La bibliothèque d'Alexandrie contenait, suivant les auteurs, de 40.000 à 400.000 ouvrages. Plus modestement la bibliothèque de Celsus à Éphèse contenait 12.000 volumens (soit un investissement d'environ 1000 hommes-années avec les évaluations technocratiques du XXIe siècle).

Le profil des bibliothèques s'est progressivement diversifié en fonctions des usages.

Par exemple, en Grèce, dans l'île de Kos, l’École d'Hippocrate produit un ensemble d'ouvrages médicaux. La bibliothèque est au cœur du dispositif hospitalier.

Dans la Rome antique l'usage des bibliothèque s'est démocratisé chez les romains fortunés, mais également dans des lieux publics comme les thermes.

Au Moyen Âge, ce sont essentiellement les monastères (et les universités) qui entretiennent et enrichissent les bibliothèques. En Tunisie, la Grande Mosquée de Kairouan date de 670. Elle devient un centre de formation dont la bibliothèque était célèbre dès le IXe siècle.

Rassembler les connaissances dans un catalogue, une collection, une encyclopédie ou une histoire naturelle

Depuis plus de deux millénaires les érudits ont inventé des dispositifs artificiels pour se repérer dans un univers de connaissance supérieur à leur propre mémoire humaine.

Pour se repérer dans les bibliothèques, ils ont écrit (γραφία) des livres sur les livres (βιβλίον), autrement dit des bibliographies ( Βιβλιογραφία ). Par exemple, au troisième siècle avant J.-C., Callimaque aurait rédigé une bibliographie sur la littérature grecque de la bibliothèque d'Alexandrie. De même par exemple à Kairouan un inventaire de la bibliothèque a été établi (mais en en 1294).

Les textes de lois et ensembles religieux introduisent des contraintes de cohérence et de stabilité. Les tables de Moise sont gravées dans la pierre. En Crète au début du Ve siècle avant Jésus-Christ, un recueil de lois, est gravé sur sur un mur de Gortyne.

Toujours au Ve siècle, toujours en Grèce mais à Athènes maintenant, Socrate crée un mouvement philosophique historique, tout en ayant laissé aucun écrit, et donc avec un comportement informationnel totalement oral. Un peu plus tard son disciple Platon fonde une académie et crée des productions littéraires déjà complexes d'un point de vue éditorial comme les dialogues.

Au delà des poèmes, des textes administratifs ou religieux, la volonté de rassembler des connaissances a provoqué la naissance des encyclopédies. Dès le troisième millénaire avant Jésus-Christ, on trouve en Mésopotamie des tablettes contenant des listes (par exemple de noms de villes). Mais, dans la dynamique de l'Académie, Aristote aborde une nouvelle forme de construction informationnelle avec, par exemple, son histoire des animaux qui implique par exemple un travail conséquent de classification.

On retrouve cette dynamique avec l'Histoire naturelle de Pline l'Ancien qui marque une recherche d'exhaustivité dans la production de connaissances. Cette tradition se poursuit au Moyen Âge avec par exemple Etymologiae d'Isidore de Séville. Cet ouvrage comporte 20 livres et 448 chapitres et a fait l'objet de plus d'un millier de copies. En Perse, vers 1020, Avicenne rédige le Kitab Al Qanûn fi Al-Tibb ( Le Livre de la Loi concernant la médecine - كتاب القانون في الطب).

Cela dit, le classement alphabétique, qui est devenu banal n'est en fait réellement apparu qu'au XIIIe siècle, peu avant l'arrivée de l'imprimerie qui va introduire un changement de paradigme majeur dans les comportements informationnels.

L'imprimerie au service de la connaissance

Vers 1450, Gutenberg initialise donc un changement de paradigme majeur dans les pratiques rédactionnelles avec l'invention de l'imprimerie.

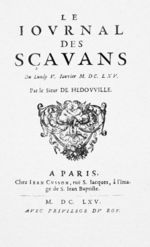

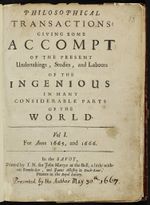

En fait cette mutation s'est étalée sur cinq siècles. Par exemple, le coût d'une édition était considérable au départ. Et il a fallu de nombreuses innovations pour arriver à une démocratisation. La première parution du journal des Sçavants (et des Philosophical Transactions of the Royal Society) date de 1665 (soit deux siècles plus tard). Dans les années 1700, en musique, les livrets étaient imprimés mais les partitions pour les orchestres étaient encore recopiées.

Du texte, des images et de la musique

Pour le grand public, la bibliothèque bleue (de colportage) démarre de 1602 et trouve son apogée au XVIIIe siècle.

L'accès du public à des images de qualité date pratiquement de la Révolution avec, par exemple, l'imagerie d’Épinal. La fabrication du papier va bénéficier de multiples améliorations au XIXe siècle qui va notamment conduire aux formats de type livres de poche qui se généralisent vers 1925.

Contrairement aux pratiques des copistes, l'imprimerie produit une reproduction à l'identique quelle que soit la culture de la cible...

Du côté des auteurs, l'imprimerie favorise l'apparition des « éditeurs imprimeurs bibliothécaires » qui favorisent l'émergence d'auteurs identifiés (Montaigne en 1580). Elle s'adapte aux pratiques spécialisées comme la musique. En effet, les compositeurs de la Renaissance peuvent faire imprimer leurs partitions, grâce à Pierre Attaingnant qui invente un procédé d'impression des notes sur une portée par caractères mobiles.

Avant l'invention des phonographes vers 1870, la lecture musicale collective est le seul moyen de découvrir une œuvre. L'émergence des éditeurs est corrélée avec celle de la propriété intellectuelle et droits d'auteurs. Paradoxalement une technologie qui favorise la diffusion à grande échelle induit des pratiques sévères de restriction d'accès, par exemple avec la censure ou la difficulté de trouver des financements.

Dictionnaires, encyclopédies et... Histoire naturelle

L'imprimerie va naturellement soutenir le développement des outils de diffusion de la connaissance avec un auditoire de plus en plus large. En 1674, Jehan Lagadeuc publie le Catholicon (du grec Καθολικόν, « universel »), premier dictionnaire trilingue du monde (breton-français-latin). Il sera imprimé en 1499 (et réimprimé en 1521).

| Le Catholicon | ||

Il faut attendre encore un siècle pour voir apparaitre les dictionnaires monolingues qui associent un mot à une définition. Le premier est le Tesoro de la lengua castellana o española (Sebastián de Covarrubias, 1611). Un peu avant, en France Jean Nicot avait composé le Thresor de la langue françoyse tant ancienne que moderne (qui contient à la fois des traductions franco latines et des définitions). L'Académie française démarre en 1638 la rédaction d'un dictionnaire qui sera imprimé en 1694. Elle obtient un privilège de l'interdiction de vente en France d'autres dictionnaires (En 1680 César-Pierre Richelet imprime un tel dictionnaire depuis Genève). Ce phénomène s'accentue au XVIIIe avec par exemple celui de Trévoux (1704). Le petit Larrousse illustré, à grande diffusion est rédigé en fait par Claude Augé parait en 1905.

En parallèle avec les dictionnaires de langue, les encyclopédies et les dictionnaires se multiplient et se complexifient. En 1620, Francis Bacon réfléchit à la façon d'organiser les sujets scientifiques. Il démarre une encyclopédie le Novum Organum dont seulement 2 volumes (sur 6 prévus) seront réalisés. En Italie, Vincenzo Coronelli, projette, en 1701, une encyclopédie en quarante-cinq volumes. Seuls les sept premiers ont été réalisés. En effet, les encyclopédies deviennent quasiment des projets industriels de grande ampleur à long terme où il faut animer une équipe de collaborateurs et faire imprimer des collections d'ouvrages considérables.

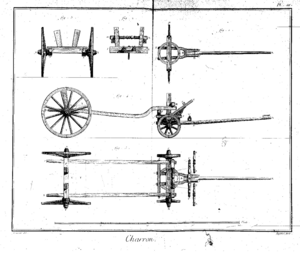

L’Encyclopédie ou Dictionnaire raisonné des sciences, des arts et des métiers est une gigantesque aventure éditoriale menée par Diderot et d'Alembert. Un aspect innovant la forte utilisations des illustrations.

Le premier volume parait en 1751. Avec de multiples confrontation avec la censure, l'édition complète représente 35 volumes.

Le projet démarre en fait en 1746, il rassemblera 150 collaborateurs et un millier d'ouvriers. Le traitement des illustrations en volumes séparés reste problématique. En effet, les renvois entre les articles et leurs illustrations sont des prévisions qui ne seront pas toujours respectées lors de la réalisation des ouvrages d'illustration.

Le tirage de plusieurs éditions sera de 4.255 exemplaires.

Un siècle plus tard Pierre Larousse, de 1866 à 1876, entreprendra le Grand Dictionnaire universel du XIXe siècle (15 volumes, 24.000 pages).

Ici la gestion des illustrations semble résolue.

Dans la continuité des approches initiées par Aristote ou Pline l'Ancien, l'imprimerie va favoriser la reprise des éditions de type histoire naturelle. On y retrouve un objectif d'exhaustivité mais avec une ligne éditoriale plus complexe. Au XVIe siècle, Pierre Belon en France et Konrad Gessner écrivent des ouvrages allant de la botanique à la zoologie. Les illustrations y jouent un rôle important.

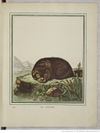

Mais l'entreprise la plus spectaculaire est l'Histoire naturelle de Buffon. Elle est monumentale par son volume où 36 ouvrages ont été publiés de son vivant (de 1749 à 1789) et 8 après sa mort. Par rapport aux recommandations actuelles des directions scientifiques sur les données de la recherche, le squelette de cette collection est le catalogue intitulé « description du Cabinet du Roy ». Pratiquement toutes les pièces majeures sont décrites par Daubenton avec des précisions anatomiques destinées aux spécialistes. De son côté Buffon rédige des articles qui doivent visiblement être lisibles par le Roy (qui finance l'entreprise) et donc par le grand public. Ajoutons que les premiers tomes ont une grande ambition épistémologique. L'ensemble ressemble quelque part à un hypertexte réparti dans une collection de codex.

|

|

|

| Buffon et deux visions de la loutre | ||

Comment Buffon aurait-il rédigé cet ouvrage avec des outils numériques ? Ce type de question sera évoqué dans la suite.

Les revues

Mais à côté des grands ouvrages de référence, la science avance avec des échanges permanents. En parallèle avec les livres, les revues et périodiques se développent, là encore avec une évolution continue sur plusieurs siècles.

De façon plus générale, au départ, les nouvelles se diffusaient essentiellement par voie orale (avec une assistance par des manuscrits pour l'orateur). Les placards imprimés ou manuels étaient affichés sur les murs généralement à l'initiative du pouvoir. La première gazette connue est un hebdomadaire de 4 pages publié à Strasbourg en 1605 par Johann Carolus (Relation aller Fürnemmen und gedenckwürdigen Historien). Les premiers grands titres de la presse pré-contemporaine datent du début du XIXe siècle comme par exemple Le Figaro en 1826.

|

|

Pour les sciences, à la suite du Journal des Sçavants, des revues spécialisées apparaissent au XVIIIe comme, en médecine, le titre Medical Essays and Observations a été publié à Édimbourg en 1731. Aux États-Unis, la première revue médicale est The Medical Repository, dont le premier numéro date de 1797. Au XIXe les revues scientifiques « générales » se développent dans la mouvance des sociétés scientifiques, comme les Comptes rendus hebdomadaires des séances de l'Académie des sciences en 1835.

Le prix des livres est encore élevé et souvent inabordable au niveau individuel. En revanche, il devient très acceptable au niveau collectif et les bibliothèques se multiplient et s'agrandissent. De plus l'instauration du dépôt légal par François Ier en 1537 va conduire à la création de la bibliothèque du Roi qui, depuis le site de la rue Vivienne, sera ouverte au public en 1692 (sous Louis XIV). Dans les domaines scientifiques les bibliothèques se développent, citons par exemple La bibliothèque du Surgeon General's Office en 1835 à Washington qui deviendra la National Library of Medicine (NLM).

L'Information scientifique et technique

La taille croissante de ces bibliothèques entraînent le développement d'outil assistance à la mémoire humaine dans sa dimension collaborative quand le nombre de bibliothécaires se multiplie dans les établissements. Les premiers catalogues accompagnés de fichiers matière sont manuscrits et utilisent parfois des supports originaux comme des cartes à jouer recyclées sous la révolution française.

|

|

La multiplication des écrits sous forme de livres ou de revues va entrainer le développement de publications relevant de l'information scientifique (au sens bibliographique du terme). Voici quelques exemples. En 1672, Laurent d'Houry, imprimeur-libraire publie un petit catalogue (4 pages) sur les livres de médecine consultable dans sa bibliothèque. Il publie également des journaux de médecine de 1683 à 1709 (Observations des plus fameux médecins, chirurgiens & anatomistes de l'Europe, tirées des journaux des pays étrangers, et des mémoires particuliers envoyez à Monsieur l'abbé de La Roque). Toujours en médecine, un siècle plus tard (en 1879) la NLM publie l'Index Medicus qui sera la fondation de la base MEDLINE en 1972. En Allemagne, mais en chimie cette fois, la revue signalétique Chemisches Zentralblatt démarre en 1830.

En 1545, un siècle après la création de l'imprimerie, à Zurich, Conrad Gessner produit le Bibliotheca universalis, premier catalogue complet et universel des ouvrages imprimés en grec, en latin ou en hébreu. Bien entendu, une des plus importantes références avant l'apparition des ordinateurs est Paul Otlet en Belgique qui invente la classification décimale universelle (CDU) avec le projet de cataloguer la production imprimée mondiale à l'Office international de bibliographie à Bruxelles,

Pour ces derniers exemples qui préfigurent les bases de données, il ne s'agit pas d'intelligence artificielle proprement dite mais de la volonté de créer une mémoire universelle pour gérer et explorer la connaissance publiée.

Les pionniers de la programmation au début des ordinateurs

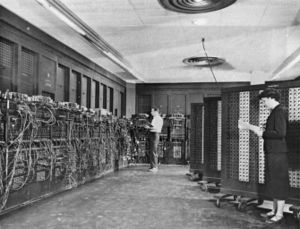

A la fin de la deuxième guerre mondiale, un ordinateur comme l'ENIAC est plutôt dédié à la construction de la bombe nucléaire avec des applications relevant de l'Analyse numérique. Mais la manipulation de ces machines était très complexe et très proche du hardware.

De son côté, au Royaume-Uni, Alan Turing travaille sur le déchiffrage des codes allemands, dans une démarche qui, ici, préfigure l'intelligence artificielle, mais dans un contexte purement algorithmique.

Assez rapidement, avec les architectures Von Neumann, les langages de programmation émergent dans les années 50. En 1954 (ou plus précisément 1957 pour une version opérationnelle) le langage Fortran a permis une première démocratisation des pratiques numériques vers quelques ingénieurs. Signalons également Algol 60 qui introduit la structure de bloc (et la récursivité), mais qui dans sa version de base est limité au numérique. La société Burroughs Large Systems a lancé une gamme de machines à pile (B5000...) dont le système était écrit avec un sur-ensemble d'Algol (ESPOL). A la même époque le langage Lisp a ouvert la voie aux travaux d'informatique théorique et d'intelligence artificielle. Ces langages ont encore un champ d'application relativement cerné : la résolution d'équations.

Citons également la comptabilité (comme les tablettes numériques servaient au départ à compter les animaux d'un troupeau). Mais il s'agit bien de langages avec des vocabulaires, des grammaires, de la syntaxe, et de la sémantique.

Dans ce paysage très spécialisé, quelques ingénieurs souvent issus de l’analyse numérique ont appliqué leur expérience sur des actions culturelles. Ils écrivent des programmes pour résoudre des problème rencontrés dans les SHS. La Chanson de Roland a par exemple inspiré Joseph J. Duggan (![]() ) qui a publié en 1969 des concordances sur le manuscrit d'Oxford. Sur ce même sujet, en Italie, Gian Piero Zarri a tenté des rapprochements entre plusieurs manuscrits.

) qui a publié en 1969 des concordances sur le manuscrit d'Oxford. Sur ce même sujet, en Italie, Gian Piero Zarri a tenté des rapprochements entre plusieurs manuscrits.

Cela dit, ces innovations n'étaient réservés qu'à une toute petite élite, et pendant une période relativement longue. Par exemple, en 1965, dans les concours de grandes écoles, les épreuves de calcul numérique étaient basés sur la règle à calcul ou sur les tables de logarithmes. Sur une ville comme Nancy quelques établissements (école d'ingénieur, institut de calcul) disposaient parfois d'un ordinateur (CAE 510, IBM 1401) avec un lecteur de carte et une machine à écrire (et sans disque). En France, dans la mouvance du Plan Calcul, il faudra arriver, dans les années 72, à l'apparition des systèmes en multiprogrammation et temps partagé sur les ordinateurs de la Cii (Siris 7, Siris 8, sur 10070 puis Iris 80) pour que l'on puisse monter des séances de travaux pratiques à plus grande échelle dans les universités.

Les centres de calcul interuniversitaires (comme l'IUCAL à Nancy) avaient mis en place des services dits « de clinique » où des ingénieurs assuraient des permanences pour accompagner leurs (souvent jeunes) collègues qui découvraient la programmation.

Les relations hiérarchiques ont commencé à être bousculées de façon significative. En électricité par exemple, le passage des lampes aux transistors (qui impliquait une maitrise du calcul matriciel) avait déjà été assez mal vécue par quelques vieux scribes de laboratoire. Le passage des règles aux cartes perforées a été parfois été vécue comme catastrophique par une majorité de mandarins totalement incapables d'évaluer les travaux de leurs subordonnés.

Les grandes applications pour quelques pionniers des humanités numériques

A la même période, à Nancy, le CNRS crée le CRTLF (Centre de Recherche pour un Trésor de la langue française). Cette unité va réaliser le dictionnaire Trésor de la langue française. Pour ce projet, programmé sur 20 ans, il fait l'acquisition d'un Gamma 60, l'ordinateur le plus puissant réalisé en France et lance des développements qui préfigurent l'intelligence artificielle. Le lancement du Plan Calcul va conforter ce projet.

L'idée générale était de créer un vaste corpus en numérisant, avec des machines à écrire, des centaines d'ouvrages du XIXe et du XXe siècle. Les termes étaient catégorisés. L'ordinateur devait explorer ce « thrésor » pour donner des exemples significatifs aux rédacteurs humains du dictionnaire.

Les concepteurs informatiques étaient de véritables pionniers du numérique. Ils devaient maitriser un langage machine complexe (et acrobatique pour gérer une synchronisation avec un tambour numérique). En revanche, les rédacteurs travaillaient uniquement sur des listings et n'avaient aucun autre « contact physique » avec le numérique.

Les techniques utilisées étaient essentiellement basées sur les listes de concordances. Cette approche était sans problème pour les termes de faible fréquence dans le corpus. Pour les termes de fortes fréquences, une stratégie nommée « groupe binaire » avait été développée. En fait, il s'agissait d'un algorithme de classification basé sur les co-occurences (simple lien). Dans les années 1970, environ 1000 textes avait été saisis (et catégorisés). Les traitements informatiques étaient réalisés par des opérateurs qui manipulaient des bandes magnétiques (il fallait par exemple 6 dérouleurs pour réaliser un tri). Un traitement de type groupe binaire s'étalait sur environ un mois, par une équipe d'opérateurs, sur une machine dont le coût se chiffrait en million de dollars. Il ne faut que quelques minutes en 2020 à un chercheur isolé sur un ordinateur portable à mille euro.

Dans la mouvance du TLF, une version du jeux du mot le plus long a été développée vers 1975 (par le rédacteur de cet article). L’algorithme utilisait des « données de la recherche » issues des textes du TLF : un fichier (sur bande naturellement) qui inventoriait toutes les formes fléchies des termes issus des textes du trésor. La résolution informatique du jeu était basée sur un mécanisme de parcours dans un arbre des anagrammes triés de ces formes fléchies (exemple : « aaabc » pour « abaca », « aaabcs » pour « abacas » puis « aabcit » pour « acabit » etc). Relativement simple à écrire à partir de 1990 avec la taille actuelle des mémoires, il avait du être optimisé pour que ce parcours se traduise par un accès séquentiel à un fichier disque. La fabrication de l'arbre trié demandait plusieurs heures de calcul. En revanche il était accessible en temps partagé et donnait tous les anagrammes d'un terme en quelques secondes. Il était notamment destiné aux visites des écoles et du grand public dans notre centre de calcul universitaire. Pour ce public étonné (le jeu était alors très populaire à la télévision) il s'agissait évidemment d'intelligence artificielle car l'ordinateur battait l'homme dans une démarche apparemment « intellectuelle ».

Plus centré vers l'intelligence artificielle, dans les années 70 des réalisations nommées « système expert » émergent. Un des plus célèbre est Mycin à l'Université de Stanford (Stanford University School of Medicine). Ecrit en Lisp, il utilise un mécanisme de chaînage en amont pour identifier les bactéries causant des infections graves.

Du côté des publications bibliographiques, en 1966 aux États-Unis, le Lockheed Palo Alto Research Laboratory, soutenu par la NASA, développe Dialog, le premier grand système de recherche d'information. Son architecture était basée sur un moteur de recherche avec fichier inverse qui rappelle naturellement les fichiers auteurs ou matière d'une grande bibliothèque de l'époque. Comme pour le TLF, on traite de larges corpus. En revanche le résultat final devient interactif pour l'utilisateur qui peut exprimer une équation de recherche.

Dans les domaines d'application, en médecine, le système MEDLARS (Medical Literature Analysis and Retrieval System) a été lancé en 1964 par la National Library of Medicine à partir de l'Index medicus. En 1965 environ 170.000 articles par an sont traités. Le service sera accessible à distance en 1971 vers quelques sites privilégiés au départ (bibliothèques) avant un plus large déploiement à partir de 1975 (via des services comme Dialog).

En 1965, à la Library of Congress, Henriette Avram développe les formats MARC pour l'informatisation des bibliothèques, dans la perspective d'échanges de catalogues. Ces formats sont basés sur une norme ISO (2709). Celle-ci est très riche dans ses possibilités de décrire n'importe quel type de document mais elle est relativement complexe à manipuler d'un point de vue informatique.

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| Notice bibliographique en Unimarc |

En France et au CNRS, Nathalie Dusoulier et Pierre Buffet réalisent l'informatisation des bulletins signalétiques du CNRS (400.000 analyses pas an) pour fabriquer la base Pascal avec un formalisme basé précisément sur la norme ISO 2709. Pascal sera accessible sur le réseau Cyclades avec le logiciel MISTRAL. Cependant la rédaction des notices bibliographiques reste manuelle. En effet, les ingénieurs analystes rédigent des bordereaux qui sont traités par un imprimeur (Jouve SA).

En France, en 1965, Jacques-Émile Dubois met au point le système DARC (acronyme de « Description, acquisition, restitution, corrélation ») qui permet d'explorer les relations entre structure et propriétés. Il permet notamment d'effectuer des recherche de structures chimiques dans des bases de données.

Toutes les applications citées dans cette section sont opérées par des équipes d'informaticiens autour de gros systèmes informatiques (mainframe). Les compétences requises d'un point de vue algorithmiques doivent être fortes compte tenu de la complexité des formats Marc, de la multiplicité des systèmes de codification (ASCII, EGCDIC, caractères grecs...) et des contraintes techniques (volumétrie à la limite des ordinateurs disponibles).

Une évolution s'amorcent avec l'apparition de progiciels, toujours sur gros systèmes mais qui peuvent être opérées par des bibliothécaires ou par des documentalistes.

Des progiciels pour maitriser les mutations numériques

En 1973, aux États-Unis,la compagnie IBM lançait le logiciel STAIRS (Storage and Information Retrieval System). Sa mise en œuvre sous CICS (gestionnaire de transactions) avec des moniteurs orientés gestion (IBM 3270) pour la gamme IBM/360 était complexe.

En France, dans la dynamique du Plan Calcul, pour répondre aux besoins du CNEXO (qui est devenu l'IFREMER), la Cii lançait sur IRIS 80 le logiciel MISTRAL. La première version (cartes perforées - imprimante) était très complexe (quasiment inutilisable) à mettre en œuvre (bandes magnétiques uniquement). Mais très rapidement (1973-1974), une version basée sur la mémoire disque, préfigurait les moteurs de recherche des années 2000.

Voici un nouveau témoignage de l'auteur qui était à l'époque ingénieur système chargé de la mise en place des progiciels, notamment pour le TLF. À Nancy, en 1973, les étudiants de l'IUT en option documentation ont pu expérimenter des fonctionnalités qui ne sont devenues disponibles dans les humanités numériques que dans les années 2000. En effet, les étudiants ont bénéficié en fait d'un protocole étudié pour le TLF. Les premiers essais avec des programmes fortran pour lire des cartes et produire des extractions sur imprimantes ont été un peu « acrobatiques ».

|

|

| Les travaux pratiques avec cartes perforées... | |

Puis, en 1975, grâce notamment au TLF, le centre de calcul de Nancy est devenu testeur d'une version avancée du système de temps partagé (Siris 8) avec une version expérimentale de MISTRAL. Celle-ci offrait une navigation interactive avec des requêtes booléennes, des recherches plein texte et une navigation dans un thésaurus. Nous n'avions pas encore de corpus réel à offrir aux étudiants. Nous avons monté des séances de travaux pratiques (sur les bandes dessinées) où les étudiants pouvaient expérimenter une démarche complète (paramétrage, saisie de documents et de relations, interrogation). Deux ans plus tard, en 1976, nous avons monté avec le TLF une base bibliographique réelle sur le BALF (bulletin analytique de la langue française). Les étudiants ont alors expérimenté des recherches documentaire en vraie grandeur, et, par leurs erreurs ou approximations, découvrir la sérendipité. De plus, en 1979, dans un contexte différent (l'ANL - voir plus loin) les étudiants ont navigué dans un ensemble plus complexe : un inventaire de logiciels issus de la recherche en génie logiciel et intelligence d'une part, et l'ensemble des laboratoires producteurs d'autre part. Nous avons pu montrer aux étudiants qu'un système documentaire pouvant traiter d'autres types de données que des références bibliographiques (association fiche logiciel et fiche organisme).

Malheureusement, avec l'arrêt du plan calcul, l'aventure du progiciel MISTRAL s'est également achevée. En effet, l'équipe MISTRAL a été débauchée par la société TéléSystèmes pour devenir Questel. Avec une facturation au temps de connexion, la navigation sur le thésaurus n'était plus utilisée, et cette fonctionnalité a été arrêtée. Ce type d'interrogation est devenu financièrement inaccessible pour les étudiants jusqu'en 2000. Concernant les logiciels, nous nous sommes recentré sur TEXTO, plus facile à mettre en œuvre mais avec de nombreuses restrictions, notamment l'absence de navigation dans une ontologie. Il faudra quasiment attendre MediaWiki en 2005 pour retrouver le niveau de fonctionnalité de MISTRAL en 1980 (avec un saut offert par les extensions sémantiques).

La proximité avec les sociétés informatiques ouvrait des perspectives intéressantes. Nous avions des contacts avec les auteurs de MISTRAL, des informaticiens qui s'étaient complètement approprié les problématiques des Systèmes de Recherche d'information (SRI). Du côté des bibliothèques, grâce à l'INIST (voir plus loin) nous avons pu travailler avec les équipes de la société canadienne GEAC qui avaient le même type d'expertise. Ils ont su monter des applications que des bibliothécaires pouvaient totalement s'approprier.

Quelques réserves cependant. Les praticiens des bibliothèques (Geac) ou de la documentation (MISTRAL) sont totalement autonomes sur ce type de système. Mais leurs pratiques sont en réalité très proches de celles qu'ils avaient avant le numérique avec la maintenance des fichiers matière. Les modes d'actions sont plus rapides, plus efficace mais l'appréhension du système est presque la même. Avec le TLF, nous avons rencontré une autre difficulté liée au contexte d'une organisation taylorienne. Au centre de calcul, nous avions organisé une formation à l'interrogation MISTRAL du BALF pour le service documentation. L'accès au système se faisait par des télétypes qui ressemblaient au matériel utilisé par l'atelier de saisie. Du coup, une partie des documentalistes ont refusé une situation qu'elles jugeaient dévalorisantes et ont mis en place un système par bordereaux pour que les requêtes soient saisies par la secrétaire du service. Là encore, pour un autre phénomène que celui cité plus haut avec Questel, la navigation dans le thésaurus n'était pas utilisée...

Stations de travail sous Unix un socle pour aborder l'intelligence artificielle

Une étape très importante a été franchie dans l'ingénierie éditoriale ou documentaire avec les stations de travail sous Unix qui démocratisaient les prémices de l'intelligence artificielle.

En 1980, les chercheurs en intelligence artificielle étaient très dépendants des gros systèmes universitaires, avec plusieurs types de restrictions. Par exemple, la disponibilité d'un logiciel de bon niveau (exemple LISP) était différente sur un Vax, un Iris 80 ou un IBM 370. De plus les travaux informatiques étaient « partiellement financés » par un ticket modérateur. Une erreur dans un programme de calcul numérique se traduit généralement par un arrêt au bout de quelques secondes. Une erreur dans un programme LISP se traduit souvent par une boucle qui peut n'être détectée qu'au bout de quelques minutes et donc coûter relativement cher. Enfin, même dans des conditions de gratuité (mini-ordinateur de laboratoire), deux chercheurs travaillant simultanément en LISP (ou Prolog) pouvaient saturer la machine.

Les stations de travail, comme Sun aux Etats-Unis, ou, en France, la SM 90 ont transformé leur vie, et pas seulement du côté du hardware. En effet, le système Unix s'avérait particulièrement commode pour explorer ou gérer des corpus. Ce système avait été conçu dans les années 70 par une équipe d'ingénieurs du Bell Labs mené par Ken Thompson. Ils avaient participé à l'expérience Multics et ont cherché à faire plus simple en introduisant des dispositifs particulièrement bien adaptés aux traitements de textes. Citons par exemple le mécanisme des pipes qui permet un mode de modularité par programme ou la banalisation d'outils de compilation comme l'analyseur lexical lex.

Au même moment, Charles Goldfarb qui avait conçu chez IBM un langage de balisage nommé GML Generalized Markup Language conçoit SGML (Standard Generalized Markup Language), publié en 1986 comme norme ISO (ISO 8879:1986). Puis Tim Berners-Lee invente HTML pour le web et Lou Burnard anime le projet TEI.

Du côté du TLF, Jacques Dendien conçoit le moteur Stella pour explorer Frantext qui contient les textes qui ont servi à constituer le dictionnaire dans une normalisation XML/TEI. Ce moteur permet des recherches avancées (avec notamment des expressions régulières).

Même si elles sont relativement coûteuses dans les années 80, les solutions Unix deviennent à la portée de petites équipes pour des développements innovants. Voici deux témoignages consécutifs.

En 1980 le CNRS et l'Agence de l'Informatique ont soutenu un groupement scientifique (ANL - Association Nationale du Logiciel - dont j'étais le directeur) pour la diffusion de logiciels issus de recherche en Génie Logiciel et intelligence artificielle. Dans le cadre de l'expérience SM 90, L'ANL a donc constitué un ensemble informationnel associant des dossiers produits et des dossiers d'institutions. Il a permis de réaliser, sur un système Unix, un ensemble éditorial avec la production de multiples catalogues papier et un serveur, au départ sur Cyclades, puis sur Minitel. Pour faire des démonstrations, nous avions hébergé sur cette machine un ensemble de logiciels issus de laboratoires et notamment Prolog, LeLisp, Aïda ou LaTeX. Nous avons utilisé notre ensemble informationnel comme support de démonstrations et nous rencontré de nombreux problèmes d’interopérabilité. Ils ont été résolus assez facilement par un balisage encore approximatif et une utilisation assez conséquente de lex (et de l'éditeur emacs). Même en dehors du contexte strict de la compilation, dans une préfiguration de XSLT, la programmation en lex se fait en associant des actions à un ensemble de règles.

Mais, dans les années 87, Alain Madelin a supprimé l'Agence de l'Informatique - ce qui a entraîné l'arrêt de l'ANL. Une partie de l'équipe a rejoint l'INIST en cours création.

Unix et Xml pour l'appropriation du numérique par les praticiens de l'IST

Sous la direction de Goéry Delacôte et de Nathalie Dusoulier j'ai eu la chance de diriger la création de l'informatique à l'Inist. Le démarrage fut une réussite technique, avec le premier système de fourniture de documents totalement numérisé.

Mais, pour les bases de données, l'informatique de l'Inist était encore très dépendante de sociétés extérieures. Goéry Delacôte avait créé un "Département Recherche et Produits Nouveaux" (DRPN) à l'imitation des centres de recherche et développements des opérateurs anglais ou américains (notamment le centre de recherche de l'OCLC). Il m'avait demandé de travailler sur l'autonomie numérique de l'INIST et sur l'indexation assistée par des techniques relevant de l'intelligence artificielle. Je lui ai proposé de prendre la direction, alors vacante, du DRPN pour développer une action de recherche et développement dans cette direction.

L'Inist manipulait donc des formats ISO 2709 : unimarc pour la bibliothèque et un format proche du CCF (Current Communication Format) de l'UNESCO pour les bases de données. D'un point de vue informatique, les notices MARC ont une structure arborescente apparemment simple mais qui se manipule assez mal dans les SGBD relationnels. Par exemple, le contenu d'une sous-zone peut modifier le type de la zone, ce qui est très difficile à formaliser dans un modèle conceptuel. Or le manuel Unimarc contient 700 pages de spécifications. Une bibliothèque peut décider de se focaliser que sur quelques zones pour construire un modèle de données. Mais pour un organisme comme l'INIST qui recevait des notices du monde entier, il était impossible de prévoir a priori, dans un protocole de type MERISE, comment le MCD pouvait prendre en compte un flot des données entrantes avec de multiples inconnues. En plus certaines zones (900) contiennent des informations propres à chaque bibliothèque.

Or, le langage SGML pouvait manipuler des arbres complexes (avec notamment des attributs). J'ai donc lancé un ensemble d'actions basées sur ce formalisme. De plus, au CDST (ancêtre de l'INIST) William Turner avait instruit une réflexion sur la bibliométrie. Cette activité avait été reprise par le DRPN et offrait un excellent terrain d'application pour une première étape vers l'indexation assistée. En 1991, le DRPN a donc développé une bibliothèque de composants XML pour traiter notamment des fichiers MARC. Cette boîte à outils permettait de créer des systèmes de recherche d'information (je me suis notamment inspiré de la structure interne de MISTRAL). Du côté de l'infométrie, je me suis inspiré des groupes binaires du TLF.

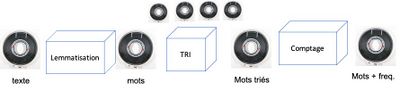

La figure ci-dessous montre une partie des chaines du TLF avec des bandes magnétiques où des programmes assez simples entourent des tris.

La plupart des algorithmes disponibles au DRPN étaient implémentés sous la forme de grands programmes assez complexes où les données étaient soumises à de nombreuses manipulations de type tri de données. Curieusement, le mécanisme de pipe d'unix a permis de développer une forme de modularité par programme directement inspiré des chaînes TLF. Voici une extrait d'un programme d'affichage des termes d'un corpus par fréquence décroissante.

cat myCorpusUnimarc.xml

| SxmlSelect -p notice/f200/sA -p @1

/* extraire les titres (zone f200 - sous zone A)

et le numéro interne de notice noté par @1 */

| sort /* donne des couples triés tels que :

« chanson 000100 » « Roland 000100 » */

| BuildIndex

| SxmlIndent /*. =>

<index><terme>chanson</terme>

<freq>50</freq>

<list><i>000100</i> ...

En même temps, ce type de traitement statistique intéressait les ingénieurs documentalistes. Au CDST, puis à l'INIST, pour 300 ingéniers, environ trois informaticiens étaient affectés aux extractions et statistiques sur les bases. Or, fallait environ 3 jours pour satisfaire une demande, avec des délais importants dus aux files d'attente.

Le développement du noyau de la boîte à outils demande de fortes compétences en algorithmique, compilation, architecture informatique. En revanche, son utilisation est accessible à des bibliothécaires et ingénieurs des domaines d'application avec une formation de quelques semaines. Nous avons testé à Nancy un plan de formation de 120 ingénieurs documentalistes. Après l'équivalent de trois semaines de formation et un accompagnement, ils étaient autonomes pour réaliser des sélections, des corrélation et lancer das serveurs d'exploration de corpus bibliographique.

L'analyse des corpus d'information scientifique devient donc accessible à l'ensemble des acteurs de la recherche qui font l'effort de se former aux technologies numériques.

Cette progression est concomitante avec la généralisation des logiciels pour la science ouverte.

Des progiciels pour les archives ouvertes, les revues numériques et les données de la recherche

Les réflexions sur la science ouverte sont déjà anciennes. Le site ArXiv a été créé par Paul Ginsparg en 1991. Les réflexions de Richard Stallman sur le logiciel libre datent de 1983 (Unix BSD date de 1977). Les premiers programmes d'analyse numérique figuraient parfois en annexe d'articles être réutilisés. Par exemple, dès 1962 en chimie théorique, le Quantum Chemistry Program Exchange (QCPE) est un service d'échange de programmes qui a débouché sur une revue en 1963.

Mais la technologie n'était pas toujours au rendez-vous. Par exemple, en 1967 à Nancy, sur une CAE 510, les chercheurs pouvaient reproduire des programmes exécutables en copiant des rubans perforés. Mais il n'était pas encore possible, faute d'un terminal de perforation de cartes, de reproduire les fonctions mathématiques... En 1971, sur un CII 10070, Jean-Marc Villard avait fait réaliser un bulletin nommé crésus. En effet, dans les files d'entrée, une carte « !JOB » servait à séparer les travaux. En ajoutant une carte « !CRESUS » à la suite le chercheur pouvant faire imprimer une gazette sur la deuxième page de son résultat sur imprimante[1]. Dans les années 1980, des revues scientifiques (papier) diffusaient parfois des articles imprimés en majuscules et même partfois, issus d'imprimantes à aiguille. En effet, les systèmes unix depuis 1970 disposaient d'une série de logiciels de composition (nroff, troff, groff...). Pour les mathématiciens TEX (1976), puis LATEX (1980) ont permis de produire des articles avec une qualité éditoriale professionnelle. Mais la production d'un document étaient réservé aux informaticiens ou aux chercheurs qui faisaient l'effort de se former à la manipulation d'un langage de commande balisé.

Il a fallu attendre 1985 pour disposer de solutions type Macintosh avec imprimante à laser pour que « n'importe qui puisse produire facilement un article imprimable dans une revue ».

Mais les revues étaient encore imprimées et diffusées de façon très classique, comme avant avec l'imprimerie. Avec cependant une innovation majeure dans les pratiques : les chercheurs devaient envoyer des « prêts à tirer ». Ceci impliquait par exemple une formation minimale aux règles typographiques.

Le World Wide Web du rêve utopique à la confrontation à la désinformation

Bien entendu, une étape décisive est arrivée avec la création du World Wide Web en 1991 (avec le premier site français à l'IN2P3 - en 1992).

Il a été conçu pour le Monde académique où les ordinateurs achetés par les universités devenaient utilisables, sans contraintes financières et sans limitations par des utilisateurs dûment identifiés. A une époque où les communications téléphoniques à grande distance étaient encore très couteuses les chercheurs découvraient des services apparemment gratuits mais de fait financés et contrôlés par les réseaux universitaires.

La première revue française (Solaris) a été créée en 1994 par Ghislaine Chartron, Jean-Max Noyer et Sylvie Fayet-Scribe. Ce n'était pas encore à la portée de tout un chacun. En effet, il fallait alors mettre en ligne les articles en codant directement en HTML (sous emacs par exemple). Des premiers services, opérés par des spécialistes du numérique, ont alors émergé (Erudit au Canada, la mise en ligne des thèses à Lyon).

A la même époque, en 1995, le moteur de recherche AltaVista faisait son apparition. Dans un espace encore presque totalement académique, et donc totalement transparent, il offrait la perspective d'un monde informationnel totalement ouvert.

Du côté des archives ouvertes, le site arXiv a été développé par Paul Ginsparg en 1991. Il était encore basé sur un modèle centralisé. Très rapidement, Carl Lagoze à Cornell développait DIENST, ancêtre de Fedora, basé sur un modèle de métadonnées qui permet (comme pour DSpace) de développer des applications intégrant des contraintes locales dans une perspective de moissonnage sur un sous-ensemble commun.

Mais rapidement, les opérateurs privés se sont emparé de ce protocole peu coûteux pour y développer des services payants ou financés par la publicité. Avec la croissance progressive de l'IA nous assistons à une situation ou les avantages d'une démocratisation de l'information sont menacés par l'explosion de la désinformation.

Des outils informationnels de plus en plus performants

A la suite des premières réalisations des années 95, l'apparition du langage PHP, des solutions type MySQL et la stabilisation de quelques schémas XML ont favorisé une explosion de l'offre de solutions collectives pour créer des sites web et des revues.

Au niveau des comportements informationnels plusieurs tendances fortement différentes se dégagent.

De nombreux chercheurs souhaitent « ne rien changer à leurs pratiques de recherche » tout en bénéficiant des améliorations du numérique. Pour un chercheur, qui veut simplement déposer un article, un service comme OpenEdition (ou HAL) répond parfaitement à cette situation.

Du côté des institutions, une nouvelle génération de CMS, (de Spip à Omeka en passant par Lodel) permet à une entité (équipe, laboratoire) de former un secrétaire de rédaction qui peut créer et gérer un service éditorial simple sans passer obligatoirement par une forme de sous-traitance. De même, un chercheur ou un praticien peut d'intervenir directement sans passer obligatoirement par un secrétaire de rédaction.

Les systèmes centralisés posent d'autres problèmes. Par exemple dans HAL, le modèle de données du SGBD gère à la fois les transactions (dépôt...) et la structure des documents. Le dépôt est une opération technique relativement facile. En revanche, une université ou un laboratoire qui souhaite une évolution dans le modèle se heurte à un barrière très complexe. En effet, elle doit négocier avec le CCSD pour introduire sa requête dans la version suivante. Le passage à la DTD TEI a apporté une certaine souplesse par rapport au schéma initial.

Nous avons évoqué le Dublin Core avec des logiciels comme Fedora qui permettent de créer assez facilement des réseaux d'archives ouvertes. Avec des dispositifs de normalisation comme l'ISNI, la gestion des publications de la recherche est un champ d'application relativement maitrisé. L'analyse de ces documents par des outils d'intelligence artificielle avec des restitutions graphiques est offerte par de nombreux systèmes (comme par exemple à partir des collections ISTEX). Cela dit nous avons montré, par exemple avec le projet LorExplor, que le problème se situait maintenant au niveau de la fiabilité statistique des corpus. Analyser cette fiabilité implique une démarche exploratoire qui sera explorée dans la section suivante.

Les laboratoires disposent d'une offre assez large d'outils clé en main allant de la création d'ontologies (avec Protégé) la constitution de corpus en TEI (ou en Dublin Core) de multiples outils d'exploration de corpus, les solutions Google pour l'édition collaborative etc. Ces outils résolvent des problèmes ponctuels mais obligent les équipes de recherche à des nombreuses manipulations, parfois complexes, pour relier ces données.

Enfin toutes les recherches qui intègrent une analyse de documents, de la philologie à exploitation d'exploration maritimes en océanographie, soulèvent rapidement des besoins d'expertise algorithmique. En France l'infrastructure Huma-Num offre des services de ce type, mais avec des moyens limités par rapport à la multiplicité des besoins.

Pour les chercheurs et praticiens qui veulent dominer leurs besoins informationnels, les wikis sémantiques sont un exemple pour une nouvelle façon de faire de la science et de la rédiger.

Les wikis programmables et sémantiques pour les humanistes du XXIe siècle

Le terme wiki recouvre des logiciels sensiblement différents. Ils ont en commun une grande aptitude aux traitements collaboratifs dans un espace hypertexte. Mais tous n'offrent pas les mêmes possibilités.

Un wiki offre au minimum des solutions simples à mettre en œuvre pour des pratiques courantes. Par exemple, Confluence permet à un enseignant, sans formation particulière, de déposer des cours dans des espace ouvert.

Cela dit, la simple écriture collective dans un espace hypertexte en vraie grandeur offre déjà des problèmes intéressants. En effet, le passage de la rédaction dans « codex en format word » à la même action dans l'hypertexte est déjà un changement de paradigme. Par exemple, la page blanche en début de rédaction d'un article est parfois vécue comme un évènement difficile mais facilement maîtrisable. La première page blanche dans un dossier hypertexte vide ou dans un wiki à sa création) ouvre un espace de doute quasi infini...

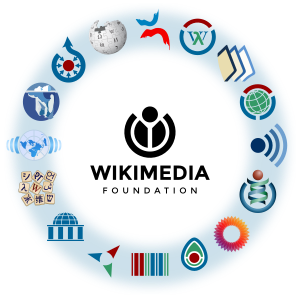

Mais surtout, les outils comme MediaWiki offrent aux contributeurs des mécanismes qui relèvent de la programmation. Elle peut alors libérer les chercheurs du recours à la sous-traitance informatique. Par exemple, sur Wikipédia, toute la gestion de la cartographie a été assurée par des contributeurs. La figure ci-dessous montre l'ensemble des applications produites par la Wikimedia foundation et utilisant MediaWiki. On y retrouve les grandes applications informationnelles dans leur diversité : encyclopédie, dictionnaire, bibliothèque etc. Notons le rôle croissant de la base WikiData pour assurer une cohérence sémantique de cet ensemble.

Grâce aux mécanismes d'extension, l'écriture scientifique ou culturelle intègre alors une tout autre dimension.

Explorer les nouveaux comportements informationnels avec Wicri

Pour explorer les utilisations avancées des wikis, nous avons créé un démonstrateur nommé Wicri (wikis pour les communautés de la recherche et de l'innovation). Le réseau Wicri est un ensemble de wikis par discipline scientifique ou zone géographique. Nous y expérimentons le moteur MediaWiki notamment pour les multiples multiples possibilités d’adaptations aux problématiques de chaque champ disciplinaire. Nous utilisons également les extensions sémantiques qui ajoutent la possibilité de développer des ontologies.

L'expérimentation Wicri a permis notamment d'explorer les possibilités d'extension, leur difficulté éventuelle d'installation et la façon de se les approprier.

Un premier niveau, celui des extensions, est réservé aux administrateurs systèmes. D'un point de vue technique, une extension est généralement un code PHP qui doit être installé dans le système de gestion de fichier de l'ordinateur avec une modification du fichier de paramétrage. Sa mise en œuvre peut devenir très complexe quand il faut installer un autre ensemble informatique. Par exemple, pour disposer des écritures de formules mathématiques en LaTeX, il faut également installer un système LaTex dans l'espace Unix et paramétrer l'interface. De même l'écriture musicale demande l'installation de l'ensemble LilyPond. Au 25 janvier 2024, 1438 extensions sont disponibles sur le site MediaWiki. Une université qui veut offrir un service adaptable aux problématiques de chaque discipline doit mettre en place un service d'installation et de support qui ne demande que peu d'interventions à cette étape mais qui doit être de haut niveau.

Une fois le système installé, MediaWiki offre un large ensemble de dispositifs directement manipulables par les contributeurs. Par exemple, un contributeur peut de créer à n'importe quel moment des catégories qui indexent les articles dans un graphe hiérarchique. Avec une extension comme Semantic MediaWiki il peut créer, là encore à n'importe quel moment, de nouveaux et types et nouvelles relations sémantiques.

Depuis sa création, MediaWiki offre surtout la possibilité de définir des modèles. Du point de vue informatique, un modèle est un sous-programme ouvert où il est notamment possible de faire des calculs. La programmation de ces modèles est parfois un peu fastidieuse avec une multiplicité des contraintes lexicographiques (avec les accolades et crochets). Depuis une dizaine d'année il est possible de programmer des modules qui sont de véritables fonctions (au sens informatique) avec un langage de programmation (Lua) de bon niveau (récursivité par exemple).

Il est alors possible aux contributeurs formés de réaliser des environnements de haut niveau. Par exemple, sur Wikipédia, les contributeurs « de base » ont réalisé l'ensemble des outils du système de cartographie. Le différentes structures de page d'information sont réalisés par des infobox (boîte d'information) généralement développées par des contributeurs avertis et utilisables par des contributeurs débutants. Par exemple, pour un ensemble de 2 millions de pages « lisibles et de contenu significatifs » la version française de Wikipédia offre 10 millions de pages techniques (déclarations de catégories, modèles et modules réutilisables, redirection etc...).

Pour des développement de type intelligence artificielle, avons évoqué plus haut, une boîte à outil XML pour construire des systèmes d'analyse de corpus. Les développements réalisés dans le cadre d'ISTEX ont montré la complémentarité des outils. Autrement dit, à côté des contributions humaines, il est possible de faire travailler des robots. Le rôle des informaticiens va donc bien au delà des installations. Ils doivent aussi développer des outils génériques pour aider à la création de traitements automatiques. Ils doivent surtout assurer un accompagnement permanent des chercheurs et praticiens qui enrichissent et organisent ces ensembles informationnels dans l'immense diversité des disciplines scientifiques et culturelle, et particulièrement dans un paysage où l'intelligence artificielle est omniprésente.

Les sciences humaines sont soumises depuis 20 ans en fait à une évolution majeure comparable à celle du passage de l'alchimie à la chimie. L'algorithmique devient un élément fondamental de la culture un chercheur en humanités confronté au numérique. La domination du numérique implique une véritable révolution dans le comportement informationnel des nouveaux humanistes.

Les comportements informationnels collectifs et politique à l'heure du numérique et de l'IA

Nous avons évoqué la position très forte de la France dans le monde de l'information depuis les grandes encyclopédies jusqu'au positionnement du système d'IST français jusqu'en début des années 90.

Malheureusement, l'arrêt du Plan Calcul, puis la disparition de l'Agence de l'Informatique ont porté un coup très important au dynamisme des années 75 85.

Après un incontestable succès initial, le CNRS n'a pas pu s'approprier le niveau d'expertise ainsi créé. Ses deux opérateurs, l'INIST d'un côté et TLF de l'autre, ont rencontré des difficultés croissantes pour aborder les mutations informatiques, après le départ des concepteurs initiaux. Concernant le CDST, nous avons mentionné le piège lié au progiciel MISTRAL. Initialement conçu pour être opéré par une institution il est devenu un service totalement contrôlé par un opérateur (Télésystèmes, qui deviendra Questel). Le CNRS avait ainsi perdu la maitrise de la conception de ses produits. Par exemple le CSDT n'a pu utiliser l'opportunité de la fonction thésaurus (supprimé par Télésystèmes pour raisons commerciales à court terme). Pendant ce temps là, la NLM développait le MeSH qu'elle exploitait sur son système.

De plus, pendant des années (de 1992 à 2000) les EPST comme l'INSERM (ou le CEDOCAR pour les armées) ont été invités à sous-traiter leur activité d'IST vers l'INIST qui argumentait de l'intérêt d'un opérateur unique pour un traitement optimal. Le ralentissement, puis l'arrêt des bases du CNRS, dans les années 2015 a donc entraîné la chute de l'ensemble du dispositif français.

Pendant ce temps, aux USA, dans cette même période (en 90), la DARPA, la NASA et la NSF lançaient le programme Digital Library Initiative. la philosophie était radicalement différente avec un soutien conséquent aux actions sur les métadonnées. Les opérateurs se sont multipliés. Sur ce terreau, en 1998, deux étudiants de Stanford, Sergey Brin et Lawrence Page présentaient à Brisbane pour la conférence WWW un prototype ayant bénéficié de ce programme et nommé... Google.

Du côté des sociétés savantes, l'espace numérique est dominé par deux sociétés (non-profit) américaines, l'ACM et l'IEEE. Au temps du Plan Calcul puis de l'Agence de l'Informatique, la France bénéficiait de l'action de l'AFCET. Pour faciliter les transferts entre la Recherche et l'industrie, l'ADI s'appuyait sur l'AFECT notamment par l'organisation d'expositions en parallèle avec les colloques organisés par cette association. L'ADI avait également étendu cette politique avec les colloques de l'IEEE en software engeneering (avec une exposition conséquente à Orlando en 84, et deux stands pour les chercheurs à Londres en 85 puis Monterey en 86). Ce type de partenariat a disparu avec le démontage de l'ADI, et l'AFCET a fini par faire faillite en 1998.

Du côté de l'information citoyenne. la croissance de la Wikimedia Foundation, basée à San Francisco est spectaculaire (de 10 personnes au départ à plus de 300 personnes avec maintenant des filiales commerciales travaillant notamment avec Google). Cette entreprise a ruiné la possibilité de lancer des projets rentables sur des dictionnaires ou des encyclopédies. Wikipédia a su mobiliser une ensemble considérable de contributions volontaires avec malheureusement des zones d'ombre. En effet, la qualité de nombreux secteurs est menacée par les effets réseaux dus notamment à l'anonymat des contributions. Outre la désinformation de type fakenews, il y a également des politiques de contrôle de secteurs sensibles par des industriels qui mettent en avant leur technologie.

Cet état de fait est peut-être intéressant pour provoquer un choc du côté des politiques de l'innovation et de l'information citoyenne.

Pour un redémarrage, l'Europe dispose encore de ressources expertes. Par exemple l'Allemagne est encore présente avec le FIZ. Les universités européennes savent former des experts d'excellents niveaux. Olivier Bodenreider qui a dirigé le département linguistique de la NLM a été formé à Nancy. Tim Berners-Lee est britannique. Le moteur MediaWiki a été développé par Magnus Manske, un étudiant allemand de l’université de Cologne. L'INIST disposait de solides atouts dans une stratégie XML pour les bibliothèques avec une longueur d'avance par rapport aux américains.

Le réseau Wicri donne une preuve de concept et un cadre d'expérimentation pour un déploiement à grande échelle d'un réseau de sites avancés dans tous les domaines de la science et de la culture. Le plus, les établissements publics disposent très souvent d'un cadre très sécurisé sur l'identification des contributeurs potentiels. Une dynamique proche de celle de Wikipédia est donc possible sur une base fiabilisée.

Bibliographie

Déroche François. Autour de l'inventaire médiéval de la bibliothèque de la mosquée de Kairouan : livres et mosquées au Maghreb. In: Lieux de cultes : aires votives, temples, églises, mosquées. IXe Colloque international sur l’histoire et l’archéologie de l’Afrique du Nord antique et médiévale (Tripoli, 19-25 février 2005) Préface de Jean-Luc Sibiude, ambassadeur de France en Libye. Paris : Éditions du Centre National de la Recherche Scientifique, 2008. pp. 247-255. (Études d'antiquités africaines) https://www.persee.fr/doc/etaf_0768-2352_2008_act_1_1_914

- ↑ La formule publicitaire était « pauvre comme Job, riche comme Crésus ».