H2PTM (1997) Grivel

Analyse de l'information par cartographie neuromimétique et requêtes SQL sur le Web

|

Sommaire

- Résumé

- Nous décrivons ici des outils de cartographie neuromimétique ainsi qu'un générateur d'applications hypertextes pour le Web (HENOCH) basé sur un modèle relationnel adapté à l'analyse de l'information. Ces outils font partie d'une plate-forme informatique opérationnelle basée sur SGML comprenant également des outils linguistiques et statistiques. Nous appliquons les réseaux de neurones artificiels PERCEPTRON et KOHONEN au domaine de la cartographie. Nous les comparons sur un exemple avec une carte obtenue par ACP. Nous décrivons ensuite le système HENOCH. Celui ci assure deux fonctions principales : alimenter un SGBD à partir de documents SGML et établir une interface WWW-SGBD. Un exemple illustre deux types de navigation complémentaires pour l'analyse de l'information : l'exploration intuitive basée sur la métaphore de la carte, la recherche d'informations orientée par la question « Qui fait Quoi et Où, ..».

- Mots-clés (auteur)

- cartographie neuromimétique, réseaux de neurones artificiels, PERCEPTRON, KOHONEN, analyse de l'information , WWW, SGBD, hypertexte, HENOCH.

- Mots-clés (pascal)

- Réseau neuronal; Information; Analyse; Réseau WWW; Internet; Système gestion base donnée; Hypertexte; PERCEPTRON; KOHONEN; HENOCH; SGBD (Système de Gestion de Base de Données); SQL (Structured query langage); ACP (Analyse en composantes principales); Cartographie neuromimétique

- Abstract

- We describe here neural networks based mapping tools and a generator of Web hypertexts based on a relational model specially adapted to information analysis. They are part of an effective SGML based platform including also linguistic and statistical tools. We first present the application of Artificial Neural Networks (ANNs) to map information. The tested and compared ANNs are a Multilayer Perceptron (MLP), and an associative network with unsupervised learning (KOHONEN). We then describe HENOCH, designed to easily store any SGML document in a relational database, and to make these data accessible via the World Wide Web. It is exemplified by two complementary types of navigation for information analysis: an intuitive exploration mode based on the map metaphor and an assisted searching mode based on the "Who does What, and Where, with Whom" question.

- Keywords

- neural mapping, Artificial Neural Networks, PERCEPTRON, KOHONEN, information analysis, WWW, RDBMS, hypertext, HENOCH.

Introduction

La fonction générale que nous souhaitons réaliser d'un point de vue technologique est l'analyse de l'information. L'analyse appartient au processus d'acquisition et d'appropriation du contenu cognitif et factuel de l'information. L'analyse cherche à identifier l'information utile, c'est-à-dire celle qui comporte un intérêt pour l'utilisateur à partir d'une somme importante d'information. Nos travaux ont pour objectif la réalisation informatique de cette fonction générale à travers la mise en oeuvre d'algorithmes de classification automatique des données (génération de clusters c'est-à-dire de classes) et ensuite de représentation des classes par des cartes en présentant l'information ainsi structurée sous la forme d'hypertexte.

Nous avons aussi défini l'analyse de l'information comme l'application des techniques de traitement automatique du langage naturel dans le but de traiter le texte intégral, afin d'opérer une extraction terminologique et de s'affranchir de l'indexation manuelle. Ici nous cherchons à définir des indicateurs linguistiques de connaissance plus complexes que les simples mots-clés. Aujourd'hui nous disposons d'une plate-forme d'ingénierie linguistique permettant de traiter le texte intégral et qui fournit aux programmes infométriques un moyen d'extraction terminologique (en français et anglais). Ces recherches d'informatique linguistique sont menées en coopération avec le CRIN-CNRS/INRIA-Lorraine. Nous n'aborderons pas cet aspect du problème dans cet article. On trouvera dans (Polanco, 1995); (Royaute, 1996); (Toussaint, 1997) des présentations détaillées de l'approche linguistique.

Il s'agit ici de présenter deux autres démarches caractéristiques de nos recherches visant à donner une assise technologique à la notion d'analyse de l'information. Dans la section 2, nous exposons l'application de réseaux de neurones artificiels non supervisés au domaine de la cartographie. Puis nous présenterons dans la section 3, un générateur d'application hypertextes combinant les technologies SGBD et WWW pour la diffusion et l'exploitation des résultats de la classification et de la cartographie.

Cartographie

Nos premières études d’application des réseaux de neurones artificiels à l'infométrie ont abouti à définir la méthode de classification des k-means axiales. Cette méthode s’inspire du formalisme neuronal du modèle de KOHONEN et applique une loi d'apprentissage d'Oja modifiée, du type "winner takes all" (Lelu, 1993); (Balpe, 1996). Notre implémentation, de nom NEURODOC, applique une analyse en composantes principales (ACP) pour la cartographie. L'ACP traite l'ensemble de classes générées par la méthode de k-means axiales, comme un nuage de points dans un espace à dimensions réduites aux axes factoriels (selon les valeurs propres exprimées en % de l'inertie totale). L'ACP recherche les directions d'allongement maximum du nuage définissant les axes ou plans factoriels sur lesquels les points sont projetés orthogonalement.

Les cartes ne sont pas seulement un moyen de visualisation, elles représentent aussi une méthode d'analyse dans la mesure où elles permettent d'évaluer la position des thèmes entre eux dans un espace géométrique de représentation. L’utilisation de l'ACP dans le domaine des données bibliographiques est confrontée au fait que les données sont très multidimensionnelles, et creuses. La représentativité des deux premiers axes mesurée en pourcentage d'inertie est toujours faible (environ 10 à 20%). Il existe toujours un certain nombre de thèmes isolés dans l’espace multidimensionnel qui sont regroupés dans une partie de la carte de façon abusive par la projection orthogonale. A la recherche d'un meilleur système de représentation des classes générées par la méthode des k-means axiales, nous avons testé un PERCEPTRON multicouche utilisé en auto-association, et un réseau de KOHONEN permettant de réaliser des cartes auto-adaptatives (Kohonen, 1982); (Kohonen, 1995). Nous menons ces recherches en coopération avec le groupe CORTEX de l'Equipe RFIA (CRIN-CNRS/INRIA-Lorraine).

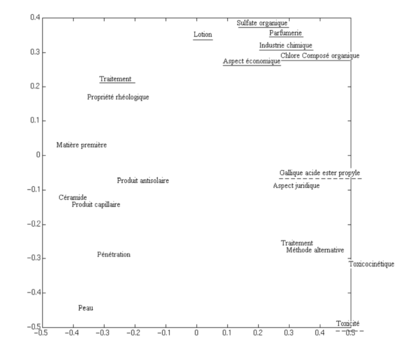

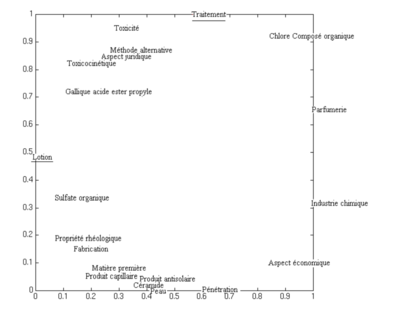

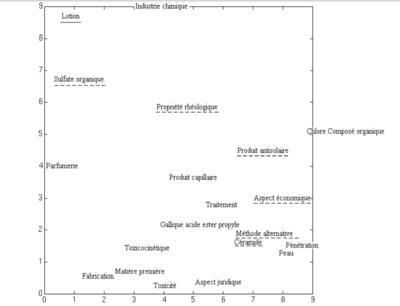

Le corpus de références bibliographiques utilisé pour tester ces algorithmes provient de la base PASCAL produite par l'INIST. Ces références correspondent au domaine la cosmétologie. Ce corpus contient 276 références indexées provenant à plus de 95% de 85 publications en série. La classification a permis d'identifier 20 thèmes présentés sur les cartes des figures 1, 2 et 3. Nous pouvons fournir ce corpus comme corpus de test. Les données proposées en entrée des réseaux sont représentées sous forme d’une matrice dont les lignes correspondent aux 20 thèmes et les colonnes aux 272 mots-clés.

PERCEPTION à trois couches

Nous n'utilisons pas le PERCEPTRON pour sa capacité d'association, mais pour ses propriétés de projection spatiale. Nous voulons retrouver en sortie le même signal qu'en entrée, en passant par une couche intermédiaire réduite à deux neurones. Ce réseau est donc obligé de réduire un vecteur n-dimensionnel en un vecteur à deux dimensions, puis de redresser l'information en n dimensions. Cette topologie permet d'obtenir deux coordonnées : les valeurs d'activation des neurones centraux pour chaque thème. Le niveau d'apprentissage du réseau est connu grâce à l'erreur quadratique moyenne (EQM) qui est calculée périodiquement. Cette EQM correspond à la distance euclidienne entre les vecteurs d’entrée et de sortie.

Nous avons vérifié si les regroupements et éloignements des thèmes reflétaient le contenu du corpus en soumettant les cartes avec leurs hypertextes à des experts documentalistes. Nous avons défini un protocole d’évaluation séparé en trois phases. (1) Les distances euclidiennes entre les vecteurs de toutes les classes sont calculées. (2) La position des thèmes a été vérifiée de la façon suivante : pour chaque classe étudiée, les positions de toutes les autres classes étaient considérées comme bonne ; ainsi nous avons déterminé si chaque classe était bien centrée par rapport à ses thèmes les plus proches, et bien éloignée de ses thèmes les plus en opposition. Un thème est bien positionné si ces deux critères sont respectés, et modérément bien placé si un seul critère est respecté. (3) Considérant globalement le résultat de la deuxième phase, nous avons pu déterminer la qualité de chaque carte.

En comparant la carte obtenue par ACP (figure 1) et celle obtenue par le PERCEPTRON (figure 2), nous remarquons que : [1] il existe moins de thèmes "mal positionnés" selon le critère défini ci-dessus sur la carte obtenu par le PERCEPTRON ; [2] les thèmes très isolés dans le N-espace sont regroupés dans la partie en haut à droite sur la figure 1, tandis qu'ils se répartissent sur toute la partie droite de la carte de la figure 2, dans ce dernier cas leur isolement est mieux représenté ; [3] les regroupements identifiés sur la figure 1 par des experts du domaine ("Dermatologie" en bas à droite et "Fabrication des cosmétiques" en bas à gauche) sont respectés sur la figure 2. La carte obtenue par le PERCEPTRON à trois couches semble donc meilleure que celle obtenue par l'ACP. Les distances sur ces cartes ne sont pas proportionnelles aux distances calculées dans le N-espace, mais les oppositions sont quasiment toutes respectées.

Réseau de KOHONEN

Le réseau de KOHONEN a une topologie en deux couches, une couche en entrée et une grille de sortie, et apprend de manière non-supervisée. Cette structure va permettre de placer directement les données à n dimensions dans le plan représenté par la grille. Le suivi de l'apprentissage s'est fait de la même manière qu'avec le PERCEPTRON, c'est-à-dire d'après l'évolution de l'EQM. Dans le cas du PERCEPTRON, nous avons présenté en entrée les vecteurs représentant les classes, mais dans le cas de KOHONEN, nous avons présenté les vecteurs représentant les mots-clés, c’est à dire la matrice transposée, ceci pour des raisons de performance. Nous avons construit une carte des mots-clés. Les coordonnées des thèmes sur la carte ont été calculées de la façon suivante : la position du thème correspond au barycentre des coordonnées de tous les mots-clés constituant ce thème. Nous avons constaté que la méthode de KOHONEN permet d'obtenir des résultats bien plus vite qu'avec le PERCEPTRON. Cependant l'erreur quadratique finale est plus élevée qu'avec le PERCEPTRON à trois couches. Le protocole d’évaluation des cartes est le même que celui utilisé pour le PERCEPTRON à 3 couches. La qualité de la carte (figure 3) est proche de celle obtenue par le PERCEPTRON à 3 couches (figure 2). Peu de classes sont franchement mal placées, mais les regroupements observés précédemment sont moins évidents.

Ce que nous venons d'illustrer sur un exemple doit être suivi de tests d’évaluation plus approfondis du point de vue statistique, afin de comparer les cartes obtenues par les méthodes statistiques et neuronales PERCEPTRON et KOHONEN. Ces tests pourraient se baser sur les distances euclidiennes entre thèmes et valoriser les rapprochements et/ou les oppositions, mesurer l'occupation de la carte, le respect de l'ordre des proximités. Afin de comparer les capacités de cartographie des réseaux PERCEPTRON et KOHONEN, nous avons appliqué ces deux algorithmes sur la matrice des classes, cependant la réalisation des cartes auto-adaptatives de KOHONEN directement en fonction des documents semble plus prometteuse.

Notre intérêt pour les algorithmes neuronaux s'appuie sur les liens qui existent entre l'analyse des données et l'approche connexionniste sur le plan statistique de la classification automatique et des représentations factorielles. L'analyse quantitative de l'information (infométrie) peut être complétée par des réseaux de neurones artificiels (modèles essentiellement non linéaires et à seuils).

Une architecture mixte base de données et hypertexte

Si les classes sont indicateurs des thèmes ou des centres d’intérêt autour desquels s’agrège l’information, la carte représente un indicateur stratégique dans la mesure où elle permet d’apprécier la position relative des classes dans l’espace de connaissance. Les données bibliographiques ou textuelles constituent la matière première à partir de laquelle nous nous proposons d'extraire la connaissance en utilisant ces indicateurs. Le problème est alors de savoir comment stocker cette information élaborée dans une base de données accessible à l'utilisateur par hypertexte et offrant la possibilité de faire des requêtes. L'expérience nous a montré que le processus d'analyse de l'information structurée, dans une démarche de veille, est un mélange d'exploration informelle intuitive et de requêtes spécifiques du type "qui fait quoi, en collaboration avec qui, où et quand". Afin de satisfaire ce double aspect "exploration/requête", nous avons développé une architecture mixte combinant les technologies SGBD et Hypertexte (WWW).

Ici, l'analyse de l'information est opérationnelle au sein d'une chaîne de traitement basée sur SGML (ISO 8879), langage de description de la structure logique de modèles de documents (Goldfarb, 1990). (Herwijnen, 1990) a montré la dualité existant entre structure d'arbre SGML et schéma E/A (Entité/Association)(Chen, 1976). Si l'on considère ces deux arguments, de nature différente, un couplage des technologies "base de données et hypertextes" doit permettre de répondre au type de requêtes décrites plus haut, en donnant la possibilité de mettre en relation tout élément constitutif d'une information structurée (référence bibliographique, brevet) avec les thèmes (clusters) obtenus par classification automatique. Ainsi le système doit gérer au moins deux types de documents que nous voulons pouvoir croiser : les clusters et les données structurées (qui peuvent d'ailleurs être de différents types). L'idée est donc de modéliser les données structurées et les clusters obtenus à partir de ces données, de tel façon que la plupart des opérations d'analyse puissent être exécutées par des requêtes SQL (Structured Query Langage).

Le deuxième point important de notre dispositif est le système hypertexte. En effet, celui-ci doit pouvoir communiquer avec le SGBD. Le World Wide Web (WWW) répond à ce besoin. Ce système hypertexte distribué, largement connu maintenant du grand public, peut facilement être étendu au moyen de plug-ins, applets java, ActiveX, CGI, notamment pour communiquer avec les SGBD. Nous ne ferons pas ici la description technique des principales solutions de passerelle entre un SGBD et un serveur WWW. Il existe une littérature abondante sur ce sujet (livres pédagogiques ou documents sur INTERNET). D'ailleurs les solutions techniques ont énormément évolué depuis 1995, année de naissance de notre passerelle. Le principal moyen de communication entre un serveur WWW et un programme externe était alors le standard "Common Gateway Interface" dit CGI, communément utilisé par les formulaires. C'est donc ce moyen que nous avons utilisé.

Les avantages d'une passerelle WWW-SGBD sont énormes par rapport à une structure arborescente de documents hypertextes (construite automatiquement ou non). L'administration du site des données et des utilisateurs est facilitée car les liens entre documents sont calculés dynamiquement et n'ont pas à être maintenus. De plus, un simple export de la base suffit à préserver le site. Un bon niveau de confidentialité peut être garanti car les autorisations d'accès peuvent être gérées au niveau du serveur WWW et du SGBD. Toutes ces caractéristiques sont essentielles lorsqu'on envisage de fournir un service sur l'INTERNET ; dans notre cas, mettre à la disposition des utilisateurs des analyses sur des sujets les intéressant.

Nous allons décrire maintenant les bases logicielles sur lesquelles s'appuie ce système mixte (nommé HENOCH) pour répondre à ces besoins.

Composants techniques du système

Le système assure deux fonctions principales : (1) alimenter le SGBD à partir de documents SGML et (2) établir une interface WWW-SGBD. Pour assurer la réutilisabilité de ce développement, nous nous sommes fixés deux contraintes supplémentaires, à savoir : (a) être le plus indépendant possible du SGBD et ainsi ne pas retomber dans un débat objet-relationnel, et (b) pouvoir traiter tout type de document structuré conforme à la norme SGML

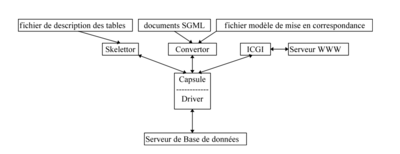

Pour respecter le premier point, nous avons défini une "capsule", une couche abstraite qui rend transparent les appels aux fonctions du SGBD. Cette interface, implémentée par une classe C++, comprend les fonctions de création et de manipulation d'une base de données ainsi que les fonctions de consultations (requêtes SQL). Les trois programmes (Skelettor, Convertor et ICGI) qui constituent HENOCH font donc appel à cette Capsule (Figure 4). Seul le Driver est spécifique du SGBD choisi.

Le deuxième point repose sur la manipulation des arbres SGML. La structure d'arbre permet un accès direct à tout noeud de l'arbre. Nous avons défini une sorte de langage applicatif qui permet d'associer une variable à un noeud, cette variable étant un paramètre d'une procédure (PL/SQL en l'occurrence), qui est exécutée lorsqu'elle est complètement instanciée. Un noeud (élément de données dans la terminologie SGML) peut être qualifié par un symbole d'occurrence. Par exemple, un noeud déclenche autant d'appels de la procédure qu'il y a de valeurs répétable (c'est le cas par exemple d'une liste de mots-clés ou d'affiliations). Nous n'exploitons pas toutes les possibilités offertes par SGML pour décrire les relations entre les éléments de données. Nous nous sommes limités à un sous ensemble qui, pour l'instant, semble suffire pour traiter les données structurées de types bibliographiques ou brevets.

Ainsi que le montre la figure 4, Skelettor prend en entrée la description des tables et des procédures d'insertion qui leur sont associées. Convertor lit le fichier modèle de mise en correspondance avec le type de document traité. Grâce à celui-ci, il détermine tous les noeuds qui contiennent des données qui doivent être extraites, ainsi que les procédures à exécuter. Il parse ensuite les documents SGML et exécute les procédures d'insertions requises.

La passerelle ICGI est une classe C++ dont le rôle principal est d'aiguiller les paramètres reçus par le serveur WWW vers la classe qui saura les interpréter. Cette classe hérite de la classe Capsule et sait donc se connecter au SGBD, soumettre des requêtes SQL, récupérer le résultat, se déconnecter. Potentiellement, tous les traitements sont possibles ; par exemple, lire un modèle de page HTML (Hypertext Markup Language) intégrant des requêtes SQL, construire une carte, un histogramme.

Interface hypertexte

L'interface utilisateur propose deux types de navigations complémentaires : [1] une exploration intuitive basée sur la métaphore de la carte, et [2] un mode de recherche basé sur la métaphore "qui fait quoi, où, avec qui, quand, dans quelles sources (revue, congrès, ...)". Dans les deux cas, la navigation est assurées par l'exécution de requêtes SQL sur la base de données infométriques. Si les coordonnées des clusters ont été précalculées par des programmes de cartographies (section 2), la construction de la carte est en revanche dynamique, grâce aux possibilités combinées de notre passerelle ICGI qui récupérant le résultat de l'exécution d'une requête SQL, est capable de générer un graphique au format GIF. Depuis cette carte (figure 5), l'analyste peut cliquer sur un nom de cluster (ici "Enzyme inhibitor") et accéder à différents types de noeuds - description du cluster par une liste de mots-clés ordonnés et valués (figure 6), titres des documents, auteurs, affiliations. En mode de recherche, l'interface utilisateur a été adaptée pour que l'exécution de cette fonction soit la plus simple et la plus conviviale possible. L'objectif est de pouvoir positionner très facilement les auteurs, les affiliations, les périodiques, ou autres entités dans les thèmes (clusters). Ainsi, pour avoir une idée globale des centres d'intérêts d'une société, l'utilisateur peut, par un simple chemin de navigation, exprimer des requêtes plus ou moins complexes sans avoir à connaître SQL. Il peut savoir dans quelles thèmes cette société est positionnée et le nombre de documents qui est à l'origine de ce positionnement dans le corpus pour chaque thème, puis naviguer vers ces documents.

Conclusions et perspectives

La démarche que nous avons exposé dans la section 2 s’inscrit dans le cadre d’un projet de recherche orientée vers l’application d’algorithmes neuronaux pour la classification et la cartographie. Nous mettons au point actuellement des tests d’évaluation plus approfondis du point de vue statistique, afin de comparer les cartographies obtenues par les méthodes statistiques (ACP) et neuronales PERCEPTRON et KOHONEN. Ces tests pourraient se baser sur les distances euclidiennes entre thèmes et valoriser les rapprochements et/ou les oppositions, mesurer l'occupation de la carte, le respect de l'ordre des proximités. Afin de comparer les capacités de cartographie des réseaux PERCEPTRON et KOHONEN, nous avons appliqué ces deux algorithmes sur la matrice des classes, cependant la réalisation des cartes auto-adaptatives de KOHONEN directement en fonction des documents semble plus prometteuse.

Dans la section 3, nous avons voulu souligner l'intérêt d'une architecture mixte SGBD-Hypertexte et l'apport de la structure d'arbre SGML pour la conversion de documents vers les SGBD. En fait, nous avons montré comment le système HENOCH assure deux fonctions principales : [1] alimenter un SGBD à partir de documents SGML produits par la plate-forme infométrique, et [2] établir une interface WWW-SGBD. Les perspectives d'évolution de ce système se situent surtout du côté des améliorations à effectuer pour que l'hypertexte généré soit aussi un environnement de création (auteur) et pas seulement un environnement de consultation (utilisateur), comme c'est le cas aujourd'hui. Cela demande de résoudre le problème de la mise à jour de la base de données (ajout de nouveaux documents) sans avoir à recharger tout le système et celui de la gestion de plusieurs auteurs effectuant un travail coopératif.

- Remerciements

- Nous remercions André KAPLAN et Jean-Philippe KEIM pour leur contribution dans la mise en oeuvre des démarches ici présentées.

Bibliographie

[Chen, 1976] ↑ Chen P.P.S., « The Entity-Relationships Model. Towards an Unified View of Data », ACM TODS, v.1, n°1, p. 9-36, 1976.

[Balpe, 1996] ↑ Balpe J.P., Lelu A., Papy F. et Saleh I., « Techniques avancées pour l'hypertexte », Paris, Editions Hermès, 1996.

[Goldfarb, 1990] ↑ Goldfarb C., « The SGML Handbook », Oxford, Oxford University Press, 1990.

[Herwijnen, 1990] ↑ Herwijnen E., « Practical SGML », Kluwer Academic Publishers, 1990.

[Kohonen, 1982] ↑ Kohonen T., « Self-Organized Formation of Topologically Correct Feature Maps », Biol. Cybern. v. 43, p. 59-69, 1982.

[Kohonen, 1995] ↑ Kohonen T., « Self-Organized Maps », Berlin, Springer, 1995.

[Lelu, 1993] ↑ Lelu A., « Modèles Neuronaux pour l'Analyse de Données Documentaires et Textuelles », Thèse de l'Université de Paris 6, 1993.

[Polanco, 1995] ↑ Polanco X., Grivel L. et Royaute J., « How to Do Things with Terms in Informetrics: Terminological Variation and Stabilization as Science Watch Indicators », Proceedings of the Fifth Biennial Conference of the International Society for Scientometrics and Informetrics. Edited by M.E.D. Koening & A. Bookstein. Medford, NJ, Learned Information Inc., p. 435-444, 1995.

[Royaute, 1996] ↑ Royaute J., Muller C. et Polanco X., « Une approche linguistique infométrique de la variation terminologique pour l'analyse de l'information », Colloque ILN'96, Informatique et Langage Naturel, Institut de Recherche en Informatique de Nantes, Université de Nantes, 9-10 octobre 1996.

[Toussaint, 1997] ↑ Toussaint Y., Royaute J., Muller C. et Polanco X., « Analyse linguistique et infométrique pour l'acquisition et la structuration de connaissances », Deuxièmes Rencontres Terminologie et Intelligence Artificielle, Université Toulouse-Le Mirail, 3-4 avril 1997.

Ce qui suit ne fait pas partie de l'article publié

Compléments

Cet article est utilisé pour mettre au point l'alignement d'un wiki avec le serveur d'exploration sur l'hypertexte.