CIDE (2007) Pierrel

Valorisation et exploitation scientifiques de documents numériques pour la recherche en linguistique : l’exemple du CNRTL

Affiliation:Jean-Marie Pierrel, ATILF & CNRTL, CNRS – Nancy Université, Etienne Petitjean, ATILF & CNRTL, CNRS – Nancy Université.

|

Sommaire

- 1 Introduction

- 2 Importance de la valorisation et de l’exploitation de documents numériques pour la recherche linguistique

- 3 Quelles contraintes pour de tels documents numériques ?

- 4 Exemple de valorisation d’un document électronique : le TLFi

- Résumé

- Créé en 2005 à l’initiative du Centre National de la Recherche Scientifique, le CNRTL propose une plate-forme unifiée pour l’accès aux ressources et documents électroniques destinés à l’étude et l’analyse de la langue française. Les services du CNRTL comprennent le recensement, la documentation (métadonnées), la normalisation, l’archivage, l’enrichissement et la diffusion des ressources. La pérennité du service et des données est garantie par le soutien institutionnel du CNRS, l’adossement à un laboratoire de recherche en linguistique et informatique du CNRS et de Nancy Université (ATILF – Analyse et Traitement Informatique de la Langue Française), ainsi que l’intégration dans les réseaux européens CLARIN et DARIAH.

- Abstract

- Founded in 2005 under the auspices of the French National Centre for Scientific Research (CNRS), the CNRTL offers a unified platform to access electronic resources and documents for linguistic research on the French language. Provided services include identification, documentation (metadata), standardisation, archiving, enrichment and distribution of resources. The sustainability of services and data is ensured through the CNRS institutional support, the hosting by a public research institute in linguistics and NLP of CNRS and Nancy University (ATILF – Analyse et Traitement Informatique de la Langue Française), and integration into the european networks of resource centres for the humanities (CLARIN and DARIAH).

Introduction

Dans le cadre des travaux de recherche en Sciences Humaines et Sociales, les aspects de valorisation et exploitation scientifiques de documents sont particulièrement importants et stratégiques pour servir de support à la fois : aux travaux de recherche : la notion de corpus d’étude est en effet très présente dans la plupart des disciplines en SHS, que cela soit en linguistique, et plus spécifiquement en linguistique de corpus, en langue, en littérature, en histoire, en droit, en didactique, etc.

à la diffusion des résultats de ces travaux qui passe le plus souvent par la production de documents textuels : articles et livres bien sûr, mais aussi documents plus spécialisés tels des dictionnaires ou des lexiques.

Aujourd’hui, un des aspects essentiels pour l’exploitation et la valorisation de tels documents est leur informatisation et leur disponibilité sur le Web sous forme de documents numériques permettant, grâce à des outils intelligents de recherche et de navigation qui ne se limitent pas à l’exploitation de simples mots clés ou d’informations décrivant leurs structures, un véritable accès par le contenu à travers soit une recherche plein texte, soit une exploitation d’annotations et de balisages représentatifs de ce contenu informationnel.

Dans cet article, après avoir discuté de l’intérêt de proposer une valorisation ou exploitation de documents numériques pour la recherche en SHS, et plus particulièrement dans le champ de la linguistique, nous nous interrogerons sur les contraintes que doivent, à nos yeux, respecter de tels documents numériques. Puis en nous limitant à des documents numériques relatifs à notre domaine de compétence, la linguistique et plus particulièrement le lexique français, nous détaillerons deux exemples de structuration et d’exploitation de documents numériques : le TLFi (www.atilf.fr/tlfi), version informatisée du Trésor de la Langue Française(1), l’un des plus grands dictionnaires de langue du français et le portail lexical du Centre National de Ressources Textuelles et Lexicales (CNRTL : www.cnrtl.fr), récemment mis en place, au sein de l’ATILF, sous l’égide du CNRS. Avertissement Nous illustrerons au maximum cet article par un certain nombre de figures reflétant divers usages de ces documents numériques, néanmoins nous conseillons au lecteur d’ouvrir une fenêtre sur son navigateur préféré pour mieux percevoir l’intérêt de telles exploitations de documents structurés en suivant les liens indiqués dans le texte.

Importance de la valorisation et de l’exploitation de documents numériques pour la recherche linguistique

Les enjeux de la linguistique de corpus et du traitement automatique des langues

Le traitement automatique des langues (TAL) et la linguistique de corpus sont devenus, au cours des dernières années, des domaines-clés pour répondre aux besoins de notre société en terme d’analyse et d’exploitation de gisements d’information, le plus souvent sous forme textuelle, et aujourd’hui largement disponibles, en particulier sur le Web (2). Une analyse de l’évolution de la linguistique au cours du dernier demi-siècle montre que sa confrontation avec l’informatique et les mathématiques lui a permis de se définir de nouvelles approches. C’est ainsi qu’au-delà d’une simple linguistique descriptive s’est développée une linguistique formelle, couvrant aussi bien les aspects lexicaux que syntaxiques ou sémantiques, qui tend à proposer des modèles s’appuyant sur une double validation, explicative d’un point de vue linguistique, opératoire d’un point de vue informatique. Par ailleurs la disponibilité de ressources textuelles électroniques de grandes tailles (corpus, bases de données textuelles, dictionnaires et lexiques) et les progrès de l’informatique, tant en matière de stockage que de puissance de calcul, ont créé, au cours des années 1990, un véritable engouement pour les approches statistiques et probabilistes sur « corpus » (3). Ainsi se structura petit à petit un nouveau champ de recherche : la linguistique de corpus (4) permettant au linguiste d’aller au-delà de l’accumulation de faits de langue et de confronter ses théories à l’usage effectif de la langue.

Ces études et recherches en TAL et en linguistique de corpus nécessitent de plus en plus l’usage de vastes ressources linguistiques : textes et corpus, si possible annotés, dictionnaires, outils de gestion et d’analyse de ces ressources. Le coût de réalisation de telles ressources justifie pleinement des efforts de normalisation et de mutualisation pour permettre à la communauté de recherche de bénéficier, pour le français, de ressources comparables à celles existant pour d’autres grandes langues tel l’anglais.

Par ailleurs, ce champ de la linguistique de corpus et du TAL est porteur d’enjeux incontournables tant pour une meilleure connaissance et modélisation de la langue que pour nous permettre de progresser vers une véritable exploitation du contenu informationnel le plus souvent sous formes langagières ou textuelles, ou de valider, échanger et confronter nos résultats en TAL.

Quelles ressources et corpus pour l’étude des langues aujourd’hui ?

Corpus textuels

Le premier type de ressources, indispensable pour le développement de nombreuses études sur la langue, son analyse et son traitement, concerne les corpus textuels. Leur rôle est en effet central pour permettre la construction de modèles représentatifs de l’usage effectif de la langue. Il s’agit le plus souvent de faire émerger des invariants ou, au contraire, des comportements particuliers d’entités linguistiques. Si, pendant longtemps, ce type d’activité a pu se satisfaire des connaissances intrinsèques sur la langue qu’a le chercheur, les besoins de validation objective du monde scientifique nécessitent de plus en plus le maniement de vastes ensembles d’exemples attestés. La question fondamentale est alors de savoir comment recueillir des données fiables sur l’usage effectif de la langue. Le Web est aujourd’hui une source importante d’extraction de corpus, mais deux travers de taille caractérisent les textes disponibles sur le Web (5) :

- Leur qualité est souvent très discutable. Sans parler des nombreuses fautes qui demeurent dans bien des textes disponibles sur la toile, on y retrouve un mélange de textes, de formes, de genres et de niveaux de langue ou d’époques très disparates, incompatible avec la nécessité de travailler sur des corpus homogènes de référence pour pouvoir tout à la fois construire des modèles pertinents, les valider et les confronter.

- La pérennité de leur disponibilité n’est pas toujours assurée. Le propre du Web est de fournir des informations en constante évolution et, dans le cadre de projets de recherche, leur durée de vie est souvent inférieure à la durée de vie des projets qu’elles sous-tendent, ce qui rend très souvent impossible des comparaisons objectives de résultats.

La question de la qualité et de la disponibilité de corpus de référence reste donc importante et, pour s’en convaincre, il suffit d’analyser certains projets nationaux ou internationaux. Ainsi en France le projet « technolangue » , lancé par le Ministère français de la Recherche et des nouvelles Technologies, indiquait parmi ses quatre thèmes d’appel à proposition un volet sur les ressources linguistiques dont l’objectif était de stimuler la production, la validation et la diffusion de ressources linguistiques pour répondre aux besoins minimaux pour l’étude de la langue française, favoriser la réutilisabilité de ces ressources et diminuer le coût du « ticket d’entrée » dans le secteur. Les besoins sont en effet très diversifiés : que ce soit en terme de types de textes (littéraires, scientifiques ou techniques, mono et multilingues), ou en termes d’usages (professionnels ou grand public), la nécessité de vastes corpus normalisés, annotés et validés s’impose.

Dictionnaires et lexiques

Le second type de ressources concerne les dictionnaires et les lexiques. Bon nombre des arguments développés ci-dessus peuvent aussi s’appliquer à ce domaine. Or aucun traitement automatique de la langue ne peut se passer du niveau lexical, et la disponibilité de ressources de ce type est unanimement reconnue comme indispensable pour la plupart des traitements. Là encore les besoins sont très divers dans un contexte mono ou multilingue : dictionnaires spécialisés et dictionnaires généraux de langue, lexiques techniques ou bases terminologiques, par exemple.

Si, une fois de plus, la toile offre des réponses diversifiées à ce besoin, nombre de questions demeurent concernant tout à la fois la qualité, la richesse, la couverture et la disponibilité de telles ressources. Il suffit pour s’en convaincre d’analyser les réponses que l’on peut obtenir après une interrogation de la toile à partir, par exemple, de « dictionnaire + langue française » ! Nous sommes pour notre part convaincus qu’il importe de développer et partager des ressources de ce type et c’est cette conviction qui nous amena à proposer une version informatisée du Trésor de la Langue Française (www.tlfi.fr) et d’en dériver un lexique ouvert des formes fléchies du français (540 000 formes issues de 68 000 lemmes : http://www.cnrtl.fr/lexiques/morphalou/).

Des outils d’accès et de traitements

Un troisième type de ressources, complément des deux précédents, concerne les outils d’accès et de traitement de ces ressources. Deux types d’outils méritent une attention toute particulière :

- Les outils de gestion et d’exploitation des ressources textuelles, lexicales ou dictionnairiques. Que seraient en effet des ressources textuelles ou dictionnairiques du type de celles envisagées ci-dessus sans les logiciels d’exploration de ces ressources ?

- Les outils de base indispensables pour permettre à une équipe de recherche de proposer des avancées sur tel ou tel point : lemmatisation, conjugaison ou étiquetage morphosyntaxique.

Une fois de plus on ne peut que noter, tout en le regrettant, le manque de disponibilité d’outils fiables et généraux de ce type. Faute de cette disponibilité, la première tâche d’une équipe de recherche ou de développement travaillant sur des ressources linguistiques et plus généralement sur la langue consiste souvent, aujourd’hui, à redévelopper de tels outils !

Une nécessité : mutualiser les ressources et mieux prendre en compte leur production dans l’évaluation des chercheurs

En conclusion de ce paragraphe introductif, nous souhaitons faire partager notre conviction de la nécessité de mutualiser, au sein de la communauté francophone des sciences du langage, des ressources de références (corpus textuels, dictionnaires et lexiques, outils d’exploitation de ces ressources) pour la construction de modèles ou outils linguistiques, leur validation et leur comparaison.

Le coût de définition et de production de vastes ressources linguistiques de qualité (corpus, dictionnaires et lexiques) est important et c’est un gâchis énorme de vouloir, pour chaque projet de TAL ou de linguistique, redéfinir l’ensemble des ressources dont on a besoin. A titre d’exemple, la construction d’un dictionnaire de langue tel le Trésor de la Langue française a nécessité près de cent personnes durant trente ans, et l’établissement d’une base de données textuelle tel FRANTEXT (www.atilf.fr/frantext) s’est chiffré aussi en dizaines d’hommes-an. Sans vouloir plaider ici pour une rentabilisation extrême de la recherche à travers une taylorisation complète de notre domaine, il convient néanmoins de prendre conscience que sans une véritable mutualisation de telles ressources, dans un domaine aussi vaste que les sciences du langage qui nécessite d’aborder des aspects aussi divers que le lexique, la syntaxe, la sémantique, la pragmatique, chaque équipe de recherche ou chaque chercheur se verrait dans l’obligation de tout réinventer, alors même que nul ne peut être spécialiste de chacun de ces sous-domaines.

Un second point plaidant pour la mutualisation de ressources concerne l’évaluation, de plus en plus indispensable, de nos productions de recherche (analyseurs, système de traitement), qui nécessite, pour des besoins de comparaison, la disponibilité de ressources de référence (corpus textuels, corpus d’exemples sur un phénomène de langue, ressources dictionnairiques) accessibles, partagées et clairement identifiables. Enfin, il convient de noter qu’en termes de valorisation de la recherche et de partage de connaissances avec nos concitoyens, une disponibilité accrue, en particulier sur le web, de nos productions de recherche est indispensable. Outre le fait que cela peut permettre un meilleur partage entre le monde de la recheche et la société civile, cela répond aussi à un besoin de plus en plus grand de connaissances chez nos concitoyens.

Mais ne nous leurrons pas, la constitution et la valorisation de telles ressources de qualité nécessitent des investissements en temps importants. Si l’on souhaite que des chercheurs puissent consacrer une partie de leur temps à de telles tâches au service de l’ensemble de la communauté scientifique, il convient de mieux prendre en compte cette activité de production des documents et ressources numériques dans leur évaluation et de mettre en place une structure servant à la fois de validation et de diffusion de ces productions. C’est en partie du moins le rôle que le CNRS a confié aux Centres Nationaux de Ressources, dont le CNRTL (cf. $5), qu’il a mis en place au sein des SHS au cours des derniers 18 mois.

Quelles contraintes pour de tels documents numériques ?

Une nécessité de normalisation

L’une des caractéristiques essentielles de la recherche, à laquelle les sciences du langage n’échappent pas, est donc la nécessité de permettre à la communauté scientifique de pouvoir échanger, évaluer, confronter et reproduire des résultats de recherche ou d’analyse à partir de données de référence. Cela nécessite le développement et l’usage de normes pour les ressources linguistiques et textuelles. Aujourd’hui, dans le cadre des documents numériques, XML s’impose. Mais au-delà d’une simple utilisation d’un langage commun, il convient aussi de partager, voire normaliser, les schémas de balisage (ou DTD). La communauté française est fort bien placée en ce domaine que ce soit dans le cadre du comité technique TC 37 de l’ISO (le sous-comité dédié aux ressources linguistiques et à leur normalisation (SC4)) ou dans le cadre de la Text Encoding Initiative (TEI) [(6), (7)], consortium international qui définit des recommandations de codage de ressources textuelles (www.tei-c.org). Ainsi à travers un partenariat entre trois laboratoires, l’ATILF, l’INIST et le LORIA, Nancy est devenu centre européen support de cette initiative et aujourd’hui cette tâche est plus spécifiquement confiée au CNRTL.

Une transparence nécessaire des outils informatiques pour l’exploitation de tels documents informatiques

Une autre caractéristique indispensable au partage de ressources linguistiques (corpus, dictionnaires et lexiques) sous forme de documents électroniques au sein de la communauté SHS est la transparence des outils et structures informatiques. L’immense majorité des usages potentiels de tels documents numériques viennent en effet de collègues qui ne sont pas informaticiens et pour lesquels d’ailleurs l’outil informatique, au-delà des fonctions de base de la bureautique, fait peur. La solution que nous préconisons donc est d’offrir des services et des outils qui, en aucun cas, ne nécessitent un équipement logiciel spécifique pour les exploiter. La solution technique existe, c’est celle que nous utilisons dans les deux exemples que nous présentons ci-après, elle consiste à assurer cette diffusion à travers des applications Web qui ne nécessite aucun équipement autre, chez l’utilisateur, qu’un navigateur internet quel qu’il soit (Explorer, Netscape, Mozilla ou autre).

Exemple de valorisation d’un document électronique : le TLFi

Caractéristique du TLFi

Reflet fidèle de la version papier [(1)], jusque dans sa présentation typographique à l’écran, le TLFi se caractérise, comme le TLF, par la richesse de son matériau et la complexité de sa structure :

Importance de sa nomenclature :100 000 mots avec leur étymologie et leur histoire, et 270 000 définitions. Richesse des objets méta-textuels inclus dans chaque article (vedettes, codes grammaticaux, indicateurs sémantiques ou stylistiques, indicateurs de domaines, définitions, exemples référencés…).

Richesse des 430 000 exemples, tirés de deux siècles de production littéraire française. Diversité des rubriques : une rubrique synchronie couvrant la période 1789 à nos jours, une rubrique étymologie et histoire, et une rubrique bibliographie pour les principaux articles.

La version informatique du TLF [(8)] intègre de plus des accès à très haut niveau de tolérance permettant une insensibilité aux accents, une tolérance aux fautes d’orthographe courantes, un traitement phonétique et un traitement morphologique. Ainsi, on peut offrir une correction automatique des fautes et permettre des accès à partir de formes et non plus uniquement de lemmes ou de vedettes et proposer des procédures d’accès diversifiées pour une consultation humaine.

Quels accès au TLFi ?

Le TLFi correspond à une rétro-conversion de la version papier du TLF pour laquelle, par des procédures de repérage semi-automatique des objets textuels composant les articles du dictionnaire original, nous avons introduit un balisage fin, tant typographique (de manière à conserver une image 100 % fidèle du TLF) que sémantique (repérage des principaux objets textuels au sein de chaque article). Quelques chiffres peuvent donner un aperçu de la finesse de ce balisage : après validation sur l'ensemble des seize tomes, 36 613 712 balises XML ont été positionnées : 17 364 854 balises typographiques, 1 070 224 balises décrivant la hiérarchie, 18 178 634 balises repérant les objets textuels, dont 92 997 entrées et 64 346 locutions faisant l'objet de 271 166 définitions et illustrées par 427 493 exemples.

C’est ce balisage fin du TLF et l’exploitation du document XML correspondant qui nous permet de proposer divers accès possibles à l’ensemble du dictionnaire, cumulant les avantages d’un dictionnaire avec ceux d’une ressource textuelle et d’une véritable base de données lexicales :

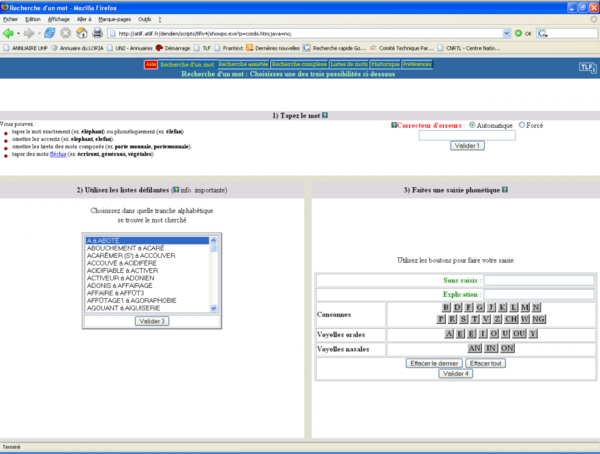

Recherche d’un mot, d’une expression ou d’une forme lexicale plus ou moins bien orthographiés, avec possibilité, via un « panneau de réglage », de mettre en évidence divers champs dans le résultat de la recherche (définition, code grammatical, domaine spécifique, exemple, auteur d’exemple, construction, indicateur, etc.).

¬Possibilité d’hyper-navigation à l’intérieur du dictionnaire permettant en un clic souris de passer d’un mot à sa définition. Interrogations assistées ou requêtes complexes exploitant l’ensemble de la structure du dictionnaire à travers le croisement de multiples critères.

Exemples de recherches dans le TLFI

On peut trouver à l’adresse www.tlfi.fr une présentation et des démonstrations sur les recherches offertes dans le TLFi, mais la meilleure façon de se rendre compte de l’intérêt d’une telle transformation du TLF en document numérique consiste soit à accéder au Cédérom du TLFi [9], soit à se connecter directement à l’adresse : http://atilf.atilf.fr/tlf.htm. Trois principaux types d’accès sont alors proposés : la recherche d’un mot, la recherche assistée et la recherche complexe