CIDE (2011) Boubekeur : Différence entre versions

imported>Jacques Ducloy |

imported>Jacques Ducloy |

||

| (106 révisions intermédiaires par 2 utilisateurs non affichées) | |||

| Ligne 5 : | Ligne 5 : | ||

;titre: [[A pour titre::Indexation sémantique de documents textuels | ;titre: [[A pour titre::Indexation sémantique de documents textuels | ||

]] | ]] | ||

| − | ;auteurs: [[A pour premier auteur::Fatiha | + | ;auteurs: [[A pour premier auteur::Fatiha Boubekeur]](1), [[A pour auteur::Wassila Azzoung]](1) et [[A pour auteur::Sarah Chiout]](1)et [[A pour auteur::Mohand Boughanem ]](2) |

;Affiliations: | ;Affiliations: | ||

| − | :(1):[[A pour affiliation auteur::Université Mouloud Mammeri|Université Mouloud Mammeri]], [[Tizi Ouzou]],[[Algérie]]. | + | :(1):[[A pour affiliation auteur::Université Mouloud Mammeri|Université Mouloud Mammeri]], [[Tizi Ouzou]], [[Algérie]]. |

| − | :(2):[[A pour affiliation auteur::IRIT-SIG]], [[A pour affiliation auteur::Université Paul Sabatier de Toulouse|Université Paul Sabatier de Toulouse]], [[Toulouse]],[[France]]. | + | :(2):[[A pour affiliation auteur::IRIT-SIG]], [[A pour affiliation auteur::Université Paul Sabatier de Toulouse|Université Paul Sabatier de Toulouse]], [[Toulouse]], [[France]]. |

;In:[[Est dans les actes::CIDE 2011 Rabat|CIDE.14 (Rabat)]], 2011 | ;In:[[Est dans les actes::CIDE 2011 Rabat|CIDE.14 (Rabat)]], 2011 | ||

| − | ;En PDF : [[Media:CIDE (2011) Boubakeur.pdf|CIDE (2011) | + | ;En PDF : [[Media:CIDE (2011) Boubakeur.pdf|CIDE (2011) Boubekeur.pdf]] |

;Mots-clés :Recherche d’information, indexation sémantique, désambiguïsation, WordNet, WordNetDomains. | ;Mots-clés :Recherche d’information, indexation sémantique, désambiguïsation, WordNet, WordNetDomains. | ||

;Keywords : Information retrieval, semantic indexing, disambiguation, WordNet, WordNetDomains. | ;Keywords : Information retrieval, semantic indexing, disambiguation, WordNet, WordNetDomains. | ||

| Ligne 18 : | Ligne 18 : | ||

<div style="text-align:justify;"> | <div style="text-align:justify;"> | ||

;Résumé:This paper describes a document semantic indexing approach. We propose to use WordNet as linguistic resource for retrieving the representative concepts of a document. Our contribution in this paper is threefold: we propose (1) an approach for identifying concepts using WordNet lexical database, (2) a disambiguation approach based on the joint use of WordNet and WordNetDomains, and (3) a concept weighting approach based on a novel definition of concept importance. | ;Résumé:This paper describes a document semantic indexing approach. We propose to use WordNet as linguistic resource for retrieving the representative concepts of a document. Our contribution in this paper is threefold: we propose (1) an approach for identifying concepts using WordNet lexical database, (2) a disambiguation approach based on the joint use of WordNet and WordNetDomains, and (3) a concept weighting approach based on a novel definition of concept importance. | ||

| − | + | </div> | |

{{CIDE début corps}} | {{CIDE début corps}} | ||

| Ligne 24 : | Ligne 24 : | ||

==Introduction et problématique== | ==Introduction et problématique== | ||

| − | Un processus de recherche d'information (RI) a pour but de sélectionner l'information pertinente pour un besoin en information exprimé par l’utilisateur sous forme de requête. Une étape clé dans ce processus de RI, est l’indexation. L’indexation consiste à représenter requêtes et documents par un ensemble de termes (généralement des mots simples) pondérés, sensés définir au mieux leurs contenus sémantiques. | + | Un processus de recherche d'information (RI) a pour but de sélectionner l'information pertinente pour un besoin en information exprimé par l’utilisateur sous forme de requête. Une étape clé dans ce processus de RI, est l’indexation. L’indexation consiste à représenter requêtes et documents par un ensemble de termes (généralement des mots simples) pondérés, sensés définir au mieux leurs contenus sémantiques. Les termes sont automatiquement extraits ou manuellement assignés aux documents et aux requêtes, puis pondérés par des valeurs numériques qui traduisent leur importance dans le document. De la qualité de l’indexation dépend en grande partie la qualité de la recherche. |

| + | {{CIDE texte brut}} | ||

| + | Un facteur clé impactant la qualité de l’indexation concerne la capacité du système à traiter avec l’ambiguïté de la langue naturelle et à comprendre les sens des mots dans les documents. Il ne s’agit plus alors de représenter le document par de simples chaines de caractères (entités lexicales), mais bien par des entités véhiculant des sens (entités sémantiques): les concepts. L’indexation sémantique, se base sur les concepts plutôt que sur les mots pour indexer les documents. Pour ce faire, les approches d’indexation sémantiques se basent globalement sur trois étapes : (1) une première étape d’identification des termes à l’issue de laquelle les mots (simples ou composés) contenus dans le document sont identifiés. Cette étape se base sur des techniques linguistiques classiques (tokénisation, lemmatisation, élimination de mots vides) et sur quelques techniques plus avancées d’identification des collocations de mots, (2) une seconde étape de désambiguïsation des sens des mots qui a pour objet de retrouver le sens correct d’un mot dans un contexte donné. Pour ce faire, les approches de désambiguïsation s’appuient sur des ressources linguistiques telles que les corpus d’apprentissage ({{CIDE lien citation|Cuadros, 2004}}), ({{CIDE lien citation|Leacock, 1998}}), ({{CIDE lien citation|Mihalcea, 2000}}), dictionnaires automatisés ({{CIDE lien citation|Guthrie, 1991}}), ({{CIDE lien citation|Lesk, 1986}}), ({{CIDE lien citation|Voorhees, 1993}}), ({{CIDE lien citation|Wu, 1994}}), ou encore les ontologies ({{CIDE lien citation|Resnik, 1999}}), ({{CIDE lien citation|Uzuner, 1999}}), et autres [[Wikipédia]] ({{CIDE lien citation|Medelyan, 2009}}), qui constituent des sources d’évidence pour les définitions et sens d’un mot. Le principe de la désambiguïsation consiste en général à associer un score de désambiguïsation aux différents sens possibles d’un mot (fournis par les dictionnaires et autres ressources…). La précision de la désambiguïsation dépend non seulement de la ressource linguistique utilisée mais aussi en grande partie du score de désambiguïsation établi. (3) Dans la troisième étape, il s’agit de pondérer les concepts identifiés à l’issue de l’étape précédente. La pondération a pour objet d’associer à chaque concept un poids numérique représentant son degré d’importance dans le document. La pondération est un problème crucial en RI. La qualité de la recherche dépend de la qualité de la pondération adoptée. | ||

| − | + | Ce papier présente la formalisation d’une approche d'indexation sémantique de documents. Dans cette approche, nous proposons d’utiliser WordNet ({{CIDE lien citation|Miller, 1995}}) et son extension WordNetDomains comme source d’évidence pour l’identification des sens des mots et pour leur pondération. Les mots sont alors désambiguïsés par rapport à leurs domaines associés dans WordNetDomains. La pondération d’un concept s’appuie sur une notion revisitée de l’importance d’un concept. | |

| − | + | Le papier est structuré comme suit : Après une introduction, nous présentons en section 1<ref>La numérotation des paragraphes est décalée par rapport à celle qui est générée automatiquement par le wiki.</ref> une synthèse des travaux dans le domaine, puis nous situons notre contribution. En section 2, nous donnons quelques notions préliminaires sur WordNet et WordNetDomains, puis des définitions utilisées dans la suite du papier. Notre approche d’indexation sémantique est détaillée en section 3. La section 4 présente une illustration. La section 5 conclut le papier. | |

| − | + | ==État des lieux de l’indexation conceptuelle== | |

| − | + | L’indexation conceptuelle représente les documents par des concepts. Ces concepts sont extraits d’ontologies et autres ressources linguistiques. Pour ce faire, le processus d’indexation s’appuie en générale sur deux étapes : l’identification des concepts et leur pondération. Le processus clé dans l’étape d’identification des concepts concerne la désambiguïsation des sens des mots. De nombreuses approches existantes se basent sur WordNet comme source d’évidence pour la désambiguïsation. C’est ainsi que pour désambiguïser un mot ambigu, Voorhees ({{CIDE lien citation|Voorhees, 1993}}) classe chaque synset (sens correspondant à une entrée de WordNet) de ce mot en se basant sur le nombre de mots co-occurrents entre un voisinage (Voorhees l'a appelé ''hood'') de ce synset et le contexte local (la phrase où l’occurrence du mot apparaît) du mot ambigu correspondant. Le synset le mieux classé est alors considéré comme sens adéquat de l’occurrence analysée du mot ambigu. Les concepts sont ensuite pondérés en utilisant un schéma de pondération classique <math>tf*idf</math> normalisé. Dans une approche différente, Katz et al ({{CIDE lien citation|Uzuner, 1999}}) proposent aussi une approche basée sur le contexte local. Le contexte local d'un mot est défini comme étant la liste ordonnée des mots démarrant du mot utile le plus proche du voisinage gauche ou droit jusqu'au mot cible. L’hypothèse de Katz et al. est que des mots utilisés dans le même contexte local (appelés ''sélecteurs'') ont souvent des sens proches. Les sélecteurs des mots d’entrée sont extraits des contextes locaux gauche et droit, puis l’ensemble S de tous les sélecteurs obtenus est comparé avec les synsets de WordNet. Le synset qui a le plus de mots en commun avec S est sélectionné comme sens adéquat du mot cible. Ce principe est repris dans l’approche d’indexation de Baziz et al. ({{CIDE lien citation|Baziz, 2005}}). Les auteurs considèrent ainsi que parmi les différents sens possibles (concepts candidats) d’un terme donné, le plus adéquat est celui qui a le plus de liens sémantiques ({{CIDE lien citation|Lesk, 1986}}), ({{CIDE lien citation|Lin, 1998}}), ({{CIDE lien citation|Sussna, 1993}}) avec les autres concepts du même document. L’approche consiste à affecter un score à chaque concept candidat d’un terme d’indexation donné. Le score d'un concept candidat est obtenu en sommant les valeurs de similarité qu'il a avec les autres concepts candidats correspondant aux différents sens des autres termes du document. Le concept candidat ayant le plus haut score est alors retenu comme sens adéquat du terme d’indexation associé. Les concepts sont ensuite pondérés sur la base d’un schéma de pondération dit <math>Cf*idf</math>, qui étend la pondération <math>tf*idf</math> pour tenir compte des termes composés. L’approche de Baziz et al. a été reprise dans Boughanem et al. ({{CIDE lien citation|Boughanem, 2010}}), avec une nouvelle définition de la pondération. En effet, dans ({{CIDE lien citation|Boughanem, 2010}}), les auteurs introduisent les notions de centralité et de spécificité d’un concept. La centralité définit le nombre de relations de ce concept avec les autres concepts du document. Sa spécificité définit son degré de « spécialité ». Le schéma de pondération utilisé est basé sur la combinaison de ces deux mesures. Dans notre approche d’indexation sémantique proposée dans ({{CIDE lien citation|Boubekeur, 2010 (1)}}), ({{CIDE lien citation|Boubekeur, 2010 (2)}}), le choix du concept correct dans un contexte s’appuie sur un score basé sur la somme des valeurs de similarité que le concept cible a avec les concepts les plus fréquents dans le document. Les concepts sont alors pondérés sur la base d’une mesure de leur importance dans le document, quantifiée au travers de leur proximité sémantique aux autres concepts du document. Dans une approche plus récente ({{CIDE lien citation|Kolte, 2008}}) les auteurs proposent une approche intéressante de désambiguïsation à deux niveaux : d’abord retrouver le domaine correct d’un mot dans le document, puis désambiguïser ce mot dans le domaine ainsi identifié. Le domaine correct d’un mot est celui qui maximise ses occurrences dans le contexte local du mot cible. Les auteurs utilisent WordNetDomains, qui permet de classifier les différentes entrées de WordNet dans des domaines prédéfinis. | |

| − | + | '''Positionnement de notre proposition''' | |

| − | + | Notre approche proposée dans ce papier tente de combiner notre approche d’indexation conceptuelle dans ({{CIDE lien citation|Boubekeur, 2010 (1)}}), ({{CIDE lien citation|Boubekeur, 2010 (2)}}) et l’approche de désambiguïsation par les domaines au sein d’un paradigme unifié. L’objectif est de représenter de manière précise le document par un noyau sémantique composé de concepts pondérés. Dans notre proposition, les termes d’indexation sont d’abord extraits en se basant sur des étapes d’indexation classiques. Cette étape inclut en outre une nouvelle proposition pour la détection des collocations à partir d’une liste pré-établie des collocations de WordNet ; à l’issue de cette étape, trois listes sont construites : la liste des collocations, la liste des mots simples ayant des entrées correspondantes dans WordNet, et la liste des mots simples n’ayant pas d’entrée dans WordNet (ces mots seront dits des mots orphelins). Puis chaque mot non vide identifié dans WordNet est désambiguïsé dans son contexte global dans le document. La désambiguïsation d’un mot se base d’abord sur sa désambiguïsation de domaine (ie. trouver le domaine correcte du mot dans le document), puis sa désambiguïsation sémantique dans le domaine choisi. | |

| − | |||

*La désambiguïsation du domaine se base sur une mesure de probabilité d’appartenance du mot cible et des mots du contexte à un domaine donné. Le domaine qui maximise cette mesure est retenu comme domaine correct du terme dans le document. | *La désambiguïsation du domaine se base sur une mesure de probabilité d’appartenance du mot cible et des mots du contexte à un domaine donné. Le domaine qui maximise cette mesure est retenu comme domaine correct du terme dans le document. | ||

*La désambiguïsation des concepts est basée sur l’intuition que les concepts appartenant à un même domaine sont fortement (sémantiquement) liés et doivent renforcer la désambiguïsation sémantique du concept cible par rapport à des concepts qui ne sont pas dans le même domaine que lui. | *La désambiguïsation des concepts est basée sur l’intuition que les concepts appartenant à un même domaine sont fortement (sémantiquement) liés et doivent renforcer la désambiguïsation sémantique du concept cible par rapport à des concepts qui ne sont pas dans le même domaine que lui. | ||

| − | L’approche de pondération des concepts est basée sur une nouvelle définition de la notion de centralité d’un concept. La centralité dépend | + | L’approche de pondération des concepts est basée sur une nouvelle définition de la notion de centralité d’un concept. La centralité dépend de la pertinence d’un concept dans le document et sur sa fréquence. Ces notions seront définies en section suivante. |

| − | |||

Dans ce qui suit, nous décrivons les différentes étapes de notre approche d’indexation sémantique. Mais d’abord, nous présentons quelques notions préliminaires sur WordNet, ainsi que des définitions et notations utilisées dans la suit de notre papier. | Dans ce qui suit, nous décrivons les différentes étapes de notre approche d’indexation sémantique. Mais d’abord, nous présentons quelques notions préliminaires sur WordNet, ainsi que des définitions et notations utilisées dans la suit de notre papier. | ||

| Ligne 50 : | Ligne 50 : | ||

===WordNet=== | ===WordNet=== | ||

| − | WordNet est un réseau lexical électronique qui couvre la majorité des noms, verbes, adjectifs et adverbes de la langue Anglaise, qu’il structure en un réseau de | + | WordNet est un réseau lexical électronique qui couvre la majorité des noms, verbes, adjectifs et adverbes de la langue Anglaise, qu’il structure en un réseau de nœuds et de liens. |

| − | * Les | + | * Les nœuds sont constitués par des ensembles de termes synonymes appelés synsets. |

| − | + | ** Un synset représente un concept. | |

| − | + | **Un concept est une entité sémantique, lexicalement représentée par un terme. | |

| − | + | **Un terme peut être un mot simple ou une collocation de mots. | |

| − | * Les liens représentent des relations sémantiques entre concepts, dont par exemple les relations d’hyponymie-hyperonymie suivantes : | + | * Les liens représentent des relations sémantiques entre concepts, dont par exemple les relations d’hyponymie-hyperonymie suivantes : |

| − | + | **la relation de subsumption entre noms, (relation is-a) qui permet d’associer un concept classe (l’hypernyme) à un concept sous-classe (l’hyponyme). Par exemple, le nom tower#1 a pour hyponymes silo, minaret, pylon… Cette relation permet d’organiser les concepts de WordNet en une hiérarchie. | |

| − | + | **la relation d’instanciation (instance) qui permet d’associer un concept et son instance. Par exemple, le nom tower#1 a pour instance hyponyme tour Eiffel. | |

Un exemple de hiérarchie de synsets correspondant au nom « bank » est donné en Table 1. | Un exemple de hiérarchie de synsets correspondant au nom « bank » est donné en Table 1. | ||

| − | |||

| + | [[Image:Concepts.PNG|540px|thumb|center|Table 1 : Les concepts de WordNet correspondants au mot bank]] | ||

| + | |||

| + | ''WordNetDomains'' est une extension de WordNet dans laquelle les synsets ont été étiquetés par des labels de domaines. Un exemple de domaines associés au synsets du mot ''bank'' est donné en Table 2. | ||

| + | Ces domaines sont organisés selon une hiérarchie définissant la relation de spécialisation/généralisation entre les domaines. Par exemple, le domaine ''Tennis'' est plus spécifique que le domaine ''Sport'', et le domaine ''Architecture'' est plus général que le domaine ''Buildings''. Une partie de la hiérarchie de WordNetDomains est donnée en Table 3. Le domaine ''Top-Level'' représente la racine de cette hiérarchie. Le domaine ''Factotum'' de WordNetDomains est un domaine fonctionnel (par opposition à sémantique) qui regroupe tous les sens des mots qui n’appartiennent à aucun domaine particulier mais qui peuvent apparaître avec des termes associés à d’autres domaines. ''Factotum'' constitue un domaine particulier, indépendant du domaine ''Top-Level'' et de sa hiérarchie. | ||

| + | [[Image:Bank.PNG|540px|thumb|center|Table 2 : Les domaines associés dans WordNetDomains, aux synsets du mot bank]] | ||

| − | + | ===Définitions et notations=== | |

| − | + | Soit <math>m_i</math> un mot d’un texte à analyser. | |

| + | <br/>a. On appelle occurrence de <math>m_i</math>, toute instance de <math>m_i</math> dans le texte. | ||

| + | <br/>b. Une instance de <math>m_i</math> apparaît dans une seule phrase. L’ensemble des mots de cette phrase constitue son contexte local. On note le contexte local de l’instance <math>m_i</math> par <math>\zeta_i</math> | ||

| + | <br/>c. On appelle contexte local droit de l’instance <math>m_i</math>, l’ensemble des mots à droite de <math>m_i</math> jusqu’à la prochaine ponctuation. Le contexte local droit de l’instance <math>m_i</math> sera noté : <math>\zeta_{di}</math> | ||

| + | <br/>d. On appelle expression locale de l’instance <math>m_i</math>, la chaîne de caractères concaténant, par le biais du souligné ( _ ), le mot <math>m_i</math> avec les mots de contexte local droit successivement. La taille d’une expression locale est le nombre de mots qui la composent. | ||

| + | <br/>e. On appelle contexte global du mot <math>m_i</math>, l’union de tous ses contextes locaux dans le texte du document. Le contexte global du mot sera noté par : <math>\zeta_{Gi}</math> | ||

| − | + | [[Image:Hiérarchie.PNG|540px|thumb|center|Table 3 : Extrait de la hiérarchie de WordNetDomains]] | |

| − | |||

| − | |||

| + | ==Indexation sémantique des documents== | ||

| + | L’indexation sémantique vise à représenter un document par un ensemble de concepts pondérés qui décrivent au mieux son contenu. | ||

| − | + | Le processus d'indexation du document s’effectue en trois étapes : (1) l’identification des termes d’index, (2) la désambiguïsation des termes d’index et (3) la pondération des concepts. | |

| − | + | ===Identification des termes d’index=== | |

| − | + | Le but de cette étape est d'identifier : | |

| + | #l’ensemble <math>\xi_{Expres}</math> des expressions du document, correspondant aux collocations de WordNet. | ||

| + | #l’ensemble <math>\xi_{Simples}</math> des mots simples ayant une entrée dans WordNet, | ||

| + | #l’ensemble <math>\xi_{Orphel}</math> des mots orphelins (mots simples n’ayant pas d’entrée dans WordNet). | ||

| + | Cette étape débute par l’identification des expressions. Pour cela, nous avons d’abord construit la liste <math>\varphi_{Coloc}</math> de toutes les collocations existantes dans WordNet. Puis, pour une occurrence de mot à analyser, on extrait de <math>\varphi_{Coloc}</math> l’ensemble <math>\varsigma_i</math> de toutes les collocations qui commencent par <math>m_i</math>. On ordonne <math>\varsigma_i</math> par tailles décroissantes de ses éléments, puis on projette chaque élément de <math>\varsigma_i</math> sur des expressions locales <math>E_i</math> de <math>m_i</math>. Si une expression locale s’apparie avec une collocation, elle est retenue comme expression et insérée dans l’ensemble <math>\xi_{Expres}</math>. Si aucune collocation de <math>\varsigma_i</math> ne s’apparie avec une expression locale de <math>m_i</math>, alors <math>m_i</math> est un mot simple. Si <math>m_i</math> possède une entrée dans WordNet, il sera inséré dans l’ensemble <math>\xi_{Simples}</math> ; sinon il sera mis dans l’ensemble des orphelins <math>\xi_{Orphel}</math>. | ||

| − | + | Le principe de l’identification des termes est décrit à travers l’algorithme de la Table 4. | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| + | [[Image:Algorithme.PNG|540px|thumb|center|Table 4: Algorithme de détection des termes d’index]] | ||

| + | ===Désambiguïsation des termes=== | ||

| + | Les collocations étant des expressions quasiment désambiguïsées, l’étape d’indexation concernera uniquement les mots simples ayant des entrées dans WordNet, soit donc l’ensemble des termes de <math>\xi_{Simples}</math>. | ||

| − | + | Chaque terme de <math>\xi_{Simples}</math> peut avoir plusieurs sens possibles. Le but de cette étape est de sélectionner le meilleur sens du terme dans le document. L’approche de désambiguïsation proposée est une approche à trois niveaux : | |

| + | :(1) dans le premier niveau, il s’agit de déterminer la forme grammaticale (nom, verbe, …) du mot <math>m_i</math> dans le document, en utilisant le Stanford POS Tagger. | ||

| + | :(2) le second niveau, permet d’identifier le domaine d’usage du mot dans le document. L’identification des domaines s’appuie sur l’utilisation de ''WordNetDomains''. Ce niveau de désambiguïsation permettra de limiter le nombre de sens du terme qui seront examinés dans le niveau suivant de désambiguïsation. | ||

| + | :(3) le troisième niveau de désambiguïsation consiste alors à sélectionner parmi les sens possibles du terme dans le domaine sélectionné, celui qui est censé le définir au mieux dans le document. | ||

| − | + | ====Identification de la forme grammaticale des mots simples==== | |

| + | Les sens d’un mot <math>m_i</math> dans WordNet sont classés selon ses différentes catégories grammaticales possibles. Ainsi, nous utilisons le Stanford POS Tagger pour identifier la catégorie grammaticale du mot <math>m_i</math> dans le document afin de déterminer les sens appartenant à cette forme grammaticale. Cette étape permet de limiter le nombre de sens du terme qui seront utilisés dans la désambiguïsation et de récupérer les domaines qui correspondent à ses sens dans WordNetDomains. | ||

| + | ====Désambiguïsation au niveau des domaines==== | ||

| − | + | Chaque mot dans <math>\xi_{Simples}</math> possède plusieurs sens dans WordNet. Les sens de WordNet sont étiquetés dans ''WordNetDomains'' par des labels de domaines. Ainsi, un sens peut appartenir à un ou plusieurs domaines. | |

| + | |||

| + | On note : | ||

| − | + | <math>S_i</math> l’ensemble de tous les synsets associés au mot <math>m_i</math>, | |

| − | |||

| − | + | <math>D</math> l’ensemble, non redondant, de tous les domaines associés aux éléments de <math>S_i</math>, | |

| − | + | <math>S_{i(j)}</math> est l’ensemble des synsets de <math>S_i</math> appartenant au domaine <math>D_j</math>, | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| + | <math>S_{i(j)}[k]</math> le kième élément de l’ensemble <math>S_{i(j)}</math> | ||

| + | Partant de l’hypothèse que le domaine probable d’un mot est celui qui maximise sa similarité avec les autres domaines des autres mots du même | ||

| + | contexte, nous attribuons à chaque domaine <math>D_j</math> associé à un sens du mot <math>m_i</math>, un score basé sur la somme de ses similarités avec les différents domaines associés aux sens des autres termes <math>t_k</math> (( <math>t_k</math> <math>\in</math> <math>\{</math> <math>\xi_{Simples}</math> <math>\cup</math> <math>\xi_{Expres}</math> } )) d’index. Le domaine ayant le plus grand score est sélectionné comme domaine adéquat pour le mot <math>m_i</math> dans le document. | ||

| − | + | Formellement : | |

| − | + | [[Image:Score.PNG|400px|center]] | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | Où : | |

| − | + | <math>Sim(Dj, D_k)</math> désigne la similarité entre les domaines <math>D_j</math> et <math>D_k</math>. | |

| − | |||

| − | |||

| − | |||

| + | Pour mesurer la similarité entre les domaines <math>D_j</math> et <math>D_k</math>, nous utilisons et adaptons la formule de Wu-Palmer ({{CIDE lien citation|Wu, 1994}}) à la hiérarchie Top-Level de WordNetDomains, ce qui donne : | ||

| + | [[Image:profondeur.PNG|400px|center]] | ||

| − | + | Où : | |

| − | |||

| − | |||

| − | |||

| − | + | <math>D^*</math> : est le domaine le plus spécifique qui subsume <math>D_j</math> et <math>D_k</math> dans la hiérarchie de WordNetDomains. | |

| − | |||

| − | + | <math>profondeur(D^*)</math> : est le nombre d’arcs entre la racine de WordNetDomains et le domaine <math>D^*</math>. | |

| − | + | <math>profondeur(D_j)</math> : est le nombre d’arcs entre la racine de WordNetDomains et le domaine <math>D_j</math> en passant par le domaine <math>D^*</math>. | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| + | '''Remarque :''' | ||

| − | domaines | + | La formule de similarité est appliquée aux seuls domaines de la hiérarchie Top-Level. Le domaine factotum, indépendant de cette hiérarchie est un domaine fonctionnel (non sémantiquement informatif). Il ne sera pas considéré dans cette désambiguïsation. |

| − | |||

| − | dans | ||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | ====Désambiguïsation des sens des mots==== | |

| − | + | À l’issue de l’étape précédente, tout mot <math>m_i</math> de <math>\xi_{Simples}</math> est associé à un seul domaine <math>D_j</math> dans le document. Deux cas peuvent se présenter : | |

| − | |||

| − | |||

| − | |||

| − | + | - soit <math>m_i</math> possède un seul sens dans <math>D_j</math>, dans ce cas il est désambiguïsé. | |

| + | - soit <math>m_i</math> possède plusieurs sens dans <math>D_j</math>, dans ce cas il est ambigu. Il faut le désambiguïser. | ||

| − | + | Nous proposons une désambiguïsation sur les seuls sens appartenant à <math>D_j</math>, soit donc aux seuls éléments <math>S_{i(j)}[k]</math> de l’ensemble <math>S_{i(j)}</math>. L’objectif est alors de sélectionner parmi ces sens le sens correct pour le mot <math>m_i</math> dans le document. | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | Pour désambiguïser le mot <math>m_i</math> dans son domaine, on associe à chacun de ses sens <math>S_{i(j)}[k]</math> de l’ensemble <math>S_{i(j)}</math>, un score basé sur sa proximité sémantique avec les autres sens associés aux mots de son contexte global dans leurs domaines respectifs. Le concept <math>S_{i(j)}[k]</math> ayant le plus grand score est alors retenu comme sens adéquat pour le mot <math>m_i</math> dans ''d''. | |

| − | |||

| − | |||

| − | |||

| + | Formellement : | ||

| + | [[Image:argmax.PNG|400px|center]] | ||

| − | + | Où <math>sim(S_{i(j)}[k],S_{l(m)}[n])</math> est la similarité sémantique entre les concepts <math>S_{i(j)}[k]</math> et <math>S_{l(m)}[n]</math>. | |

| − | + | L’ensemble des concepts retenus constituera le noyau sémantique ''N(d)'' | |

| − | + | du document ''d''. Pour des raisons de simplification, on utilisera la notation <math>C^i</math> pour désigner le ième élément de ''N(d)''. | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | L’ensemble des concepts retenus constituera le noyau sémantique | ||

| − | du document d. Pour des raisons de simplification, on utilisera | ||

===Pondération des concepts=== | ===Pondération des concepts=== | ||

| − | Partant de l’idée qu’un concept est d’autant plus représentatif du contenu du document qu’il est fréquent et pertinent dans ce document, nous proposons de pondérer | + | Partant de l’idée qu’un concept est d’autant plus représentatif du contenu du document qu’il est fréquent et pertinent dans ce document, nous proposons de pondérer un concept avec un poids basé sur : |

| + | |||

Sa pertinence, que nous définissons sa proximité sémantique aux autres concepts du document, | Sa pertinence, que nous définissons sa proximité sémantique aux autres concepts du document, | ||

| + | |||

Sa fréquence dans le document. | Sa fréquence dans le document. | ||

| − | |||

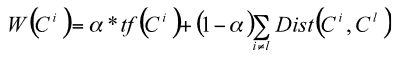

| + | Formellement, le poids <math>W(C^i)</math> du concept <math>C^i</math> est défini par : | ||

| + | |||

| + | [[Image:Pondération concepts.PNG|400px|center]] | ||

Où α est un facteur de pondération qui permet de balancer la fréquence par rapport à la pertinence. Ce facteur pourra être fixé expérimentalement. | Où α est un facteur de pondération qui permet de balancer la fréquence par rapport à la pertinence. Ce facteur pourra être fixé expérimentalement. | ||

| − | |||

| − | |||

| + | Le schéma de pondération que nous proposons permet outre la pondération des concepts, la pondération des collocations et des termes orphelins. Dans ce dernier cas, seule la fréquence est considérée, les proximités sémantiques inexistantes, sont initialisées à zéro. | ||

| + | Le noyau sémantique de ''d'' est alors construit en gardant seulement les concepts dont les poids sont plus grands qu'un seuil fixé. Nous proposons, dans un premier temps, de garder tous les concepts dont le poids est différent de zéro. | ||

| − | + | ==Illustration== | |

| − | |||

| + | Dans le paragraphe suivant, nous montrons la faisabilité de notre approche d’indexation sémantique en l’appliquant sur un exemple. Nous focalisons en particulier sur la désambiguïsation puisque de sa précision dépend en grande partie la précision de l’indexation. | ||

| − | + | Étant donné le texte suivant (extrait du document ''Arthroskopie.00130003.eng.abstr'' de la collection Muchmore<ref>http://muchmore.dfki.de/</ref>) | |

| − | + | ''“The posterior cruciate ligament (PCL) is the strongest ligament of the human knee joint. Its origin is at the lateral wall of the medial femoral condyle and the insertion is located in the posterior part of the intercondylar area. The posterior cruciate ligament consists of multiple small fiber bundles.”'' | |

| − | |||

===Détection des concepts=== | ===Détection des concepts=== | ||

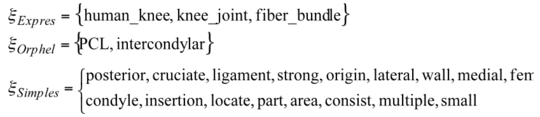

| − | Notre | + | Notre algorithme de détection des concepts retourne les trois ensembles suivants : <math>\xi_{Expres}</math>, <math>\xi_{Simples}</math>, <math>\xi_{Orphel}</math> suivants : |

| + | [[Image:Détection concepts.PNG|540px|center]] | ||

===Désambiguïsation des termes simples=== | ===Désambiguïsation des termes simples=== | ||

| Ligne 247 : | Ligne 205 : | ||

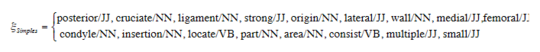

En utilisant le Stanford POS Tagger, on obtient la forme grammaticale de chaque mot simple dans le document comme suit : | En utilisant le Stanford POS Tagger, on obtient la forme grammaticale de chaque mot simple dans le document comme suit : | ||

| − | + | [[Image:Forme grammaticale.PNG|540px|center]] | |

| − | |||

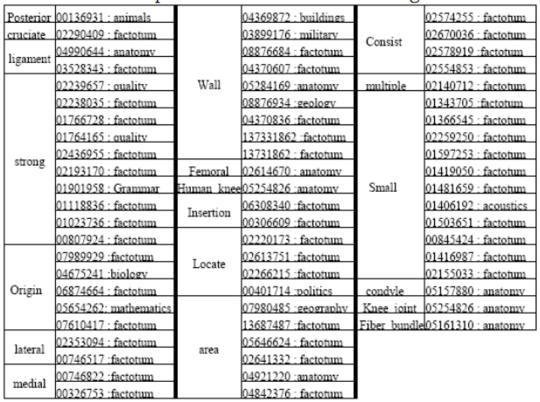

| − | + | ====Désambiguïsation au niveau des domaines==== | |

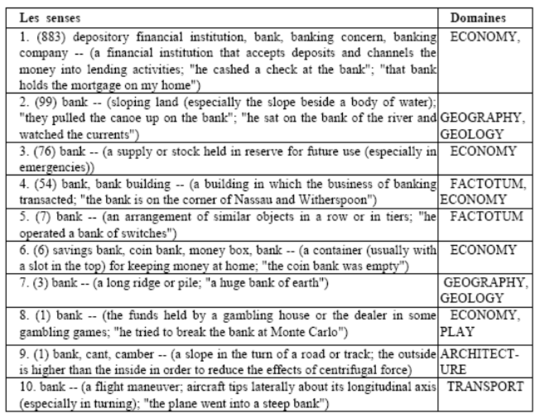

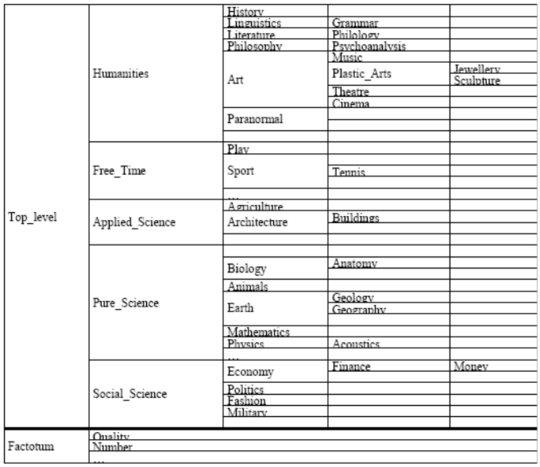

| − | Nous retrouvons pour chaque terme d’index l’ensemble des domaines associés à ses différents sens. Puis nous désambiguïsons au niveau des | + | Nous retrouvons pour chaque terme d’index l’ensemble des domaines associés à ses différents sens. Puis nous désambiguïsons au niveau des domaines. La désambiguïsation au niveau des domaines permet d’associer les domaines adéquats aux termes d’index. Les numéros des sens et les domaines associés aux termes d’index sont présentés dans les tableaux de la figure 1 suivante. Les résultats de la désambiguïsation des domaines sont récapitulés dans les tableaux de la figure 2. |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | domaines. La désambiguïsation au niveau des domaines permet | ||

| − | |||

| − | Figure 1 : Sens et domaines associés aux termes d’index | + | [[Image:Sens et domaines.PNG|540px|thumb|center|Figure 1 : Sens et domaines associés aux termes d’index]] |

====Désambiguïsation des sens des mots==== | ====Désambiguïsation des sens des mots==== | ||

| − | A l’issue de l’étape précédente, chaque terme d’index est associé aux seuls sens liés au domaine sélectionné. Seuls ces sens sont | + | A l’issue de l’étape précédente, chaque terme d’index est associé aux seuls sens liés au domaine sélectionné. Seuls ces sens sont désambiguïsés. Pour le calcul du score de désambiguïsation des sens des mots, nous nous basons sur la mesure de similarité de Lesk. Dans les tableaux de la figure 2 suivante, nous représentons pour chaque terme d’index, son domaine sélectionné ainsi que ses sens associés dans ce domaine. Le sens grisé dans le tableau représente le sens désambiguïsé (sens adéquat du terme dans le document). Un examen rapide des résultats, appuyé par une désambiguïsation manuelle, nous permet de voir que : |

- La désambiguïsation au niveau des domaines a permis d’associer les domaines adéquats aux termes d’index. C’est ainsi par exemple que les termes d’index wall, area et ligament se sont vus assigner le domaine anatomy qui est le domaine le plus probable du texte indexé. | - La désambiguïsation au niveau des domaines a permis d’associer les domaines adéquats aux termes d’index. C’est ainsi par exemple que les termes d’index wall, area et ligament se sont vus assigner le domaine anatomy qui est le domaine le plus probable du texte indexé. | ||

| − | - La désambiguïsation au niveau des sens donne aussi des sens corrects dans le document. Pour vérifier cela, nous avons comparé nos résultats avec ceux obtenus par l’approche de Baziz et al. | + | - La désambiguïsation au niveau des sens donne aussi des sens corrects dans le document. Pour vérifier cela, nous avons comparé nos résultats avec ceux obtenus par l’approche de Baziz et al. ({{CIDE lien citation|Baziz, 2005}}) pour le même texte. Les résultats obtenus montrent que nous retrouvons plus de sens corrects que dans ({{CIDE lien citation|Baziz, 2005}}). A titre d’exemple, le mot wall est désambiguïsé par wall#a#1 (définit dans WordNet par : an architectural partition …) dans ({{CIDE lien citation|Baziz, 2005}}), alors que notre approche nous retourne wall#a#5 (défini par : (anatomy) a layer (a lining or membrane)…) plus proche sémantiquement de la thématique (médicale) du document. Les résultats de notre approche sont encourageants mais doivent néanmoins être vérifiés sur une collection de taille réelle. |

| − | |||

| − | |||

| − | |||

| − | |||

| − | corrects que dans | ||

| − | |||

| − | |||

| − | |||

| + | [[Image:Présentation des domaines.PNG|540px|thumb|center|Figure 2 : Présentation des domaines et des sens désambiguïsés]] | ||

==Conclusion== | ==Conclusion== | ||

Nous avons présenté dans ce papier, les fondements théoriques d’une nouvelle approche d’indexation sémantique basée sur l’utilisation conjointe de WordNet et de WordNetDomains. Notre contribution porte sur les trois aspects de l’indexation sémantique : la détection des termes d’index, la désambiguïsation des termes et la pondération des concepts. En particulier, nous avons proposé une nouvelle approche de détection des concepts incluant la détection des collocations, une approche de désambiguïsation par les domaines et dans les domaines, et enfin un nouveau schéma de pondération des concepts. Nous avons montré la faisabilité de notre approche en la déroulant sur un exemple. Des travaux sont en cours en vue de sa validation expérimentale. | Nous avons présenté dans ce papier, les fondements théoriques d’une nouvelle approche d’indexation sémantique basée sur l’utilisation conjointe de WordNet et de WordNetDomains. Notre contribution porte sur les trois aspects de l’indexation sémantique : la détection des termes d’index, la désambiguïsation des termes et la pondération des concepts. En particulier, nous avons proposé une nouvelle approche de détection des concepts incluant la détection des collocations, une approche de désambiguïsation par les domaines et dans les domaines, et enfin un nouveau schéma de pondération des concepts. Nous avons montré la faisabilité de notre approche en la déroulant sur un exemple. Des travaux sont en cours en vue de sa validation expérimentale. | ||

| − | |||

| − | |||

| − | |||

==Bibliographie== | ==Bibliographie== | ||

| − | M. | + | {{CIDE biblio |

| − | : Fifth International Conference on Conceptions of Libraries and Information Science, Glasgow, UK, 4 juin 8 juin 2005. F. Crestani, | + | |id=Baziz, 2005 |

| − | I. Ruthven (Eds.), Lecture Notes in Computer Science | + | |id édité=[[A pour auteur cité::Mustapha Baziz|Baziz, M.]], [[A pour auteur cité::Mohand Boughanem|Boughanem, M.]], [[A pour auteur cité::Nathalie Aussenac-Gilles|Aussenac-Gilles, N.]], 2005 |

| + | |texte=''A Conceptual Indexing Approach based on Document Content Representation'' Dans : ''CoLIS5: Fifth International Conference on Conceptions of Libraries and Information Science, Glasgow, UK, 4 juin 8 juin 2005''. F. Crestani, I. Ruthven (Eds.), Lecture Notes in Computer Science LNCS Volume 3507/2005, Springer-Verlag, Berlin Heidelberg, p. 171-186.}} | ||

| − | F. | + | {{CIDE biblio |

| + | |id=Boubekeur, 2010 (1) | ||

| + | |id édité=[[A pour auteur cité::Fatiha Boubekeur|Boubekeur, F.]], [[A pour auteur cité::Mohand Boughanem|Boughanem, M.]], [[A pour auteur cité::Lynda Tamine-Lechani|Tamine-Lechani, L.]], 2010 | ||

| + | |texte=''De l’utilisation de WordNet pour l’indexation conceptuelle des documents''. 13<sup>e</sup> Colloque International sur le Document Électronique. 16-17 Décembre 2010, INHA, Paris}} | ||

| − | F. | + | {{CIDE biblio |

| + | |id=Boubekeur, 2010 (2) | ||

| + | |id édité=[[A pour auteur cité::Fatiha Boubekeur|Boubekeur, F.]], [[A pour auteur cité::Mohand Boughanem|Boughanem, M.]], [[A pour auteur cité::Lynda Tamine-Lechani|Tamine-Lechani, L.]], [[A pour auteur cité::Mariam Daoud|Daoud, M.]], 2010 | ||

| + | |texte=''Using WordNet for Concept-based document indexing in information retrieval''. Dans: Fourth International Conference on Semantic Processing (SEMAPRO 2010), Florence, Italy, Octobre 2010}} | ||

| − | M. | + | {{CIDE biblio |

| + | |id=Boughanem, 2010 | ||

| + | |id édité=[[A pour auteur cité::Mohand Boughanem|Boughanem, M.]], [[A pour auteur cité::Ihab Mallak|Mallak, I.]], [[A pour auteur cité::Henri Prade|Prade, H.]], 2010 | ||

| + | |texte=''A new factor for computing the relevance of a document to a query'' (regular paper). Dans : IEEE World Congress on Computational Intelligence (WCCI 2010), Barcelone, 18/07/2010- 23/07/2010, 2010}} | ||

| − | M. | + | {{CIDE biblio |

| + | |id=Cuadros, 2004 | ||

| + | |id édité=[[A pour auteur cité::Montse Cuadros|Cuadros, M.]], [[A pour auteur cité::Jordi Atserias|Atserias, J.]], [[A pour auteur cité::Mauro Castillo|Castillo, M.]], [[A pour auteur cité::German Rigau|Rigau, G.]], 2004 | ||

| + | |texte=''Automatic acquisition of sense examples using exretriever''. In IBERAMIA Workshop on Lexical Resources and The Web for Word Sense Disambiguation. Puebla, Mexico.}} | ||

| − | J.A | + | {{CIDE biblio |

| + | |id=Guthrie, 1991 | ||

| + | |id édité=[[A pour auteur cité::Joe A. Guthrie|Guthrie, J.A.]], [[A pour auteur cité::Louise Guthrie|Guthrie, L.]], [[A pour auteur cité::Yorick Wilks|Wilks, Y.]], [[A pour auteur cité::Homa Aidinejad|Aidinejad, H.]], 1991 | ||

| + | |texte=''Subject- dependant cooccurrence and word sense disambiguation''. In Proceedings of the 29th Annual Meeting of the Association for Computational Linguistics, Berkley, CA. 146-152.}} | ||

| − | S. G. | + | {{CIDE biblio |

| + | |id=Kolte, 2008 | ||

| + | |id édité=[[A pour auteur cité::Sopan Govin Kolte|Kolte, S.G.]], [[A pour auteur cité::Sunil G. Bhirud|Bhirud, S.G.]], 2008 | ||

| + | |texte=''Word Sense Disambiguation using WordNetDomains''. In First International Conference on Emerging Trends in Engineering and Technology. 2008 IEEE DOI 10.1109/ICETET.2008.231.}} | ||

| − | C. | + | {{CIDE biblio |

| + | |id=Leacock, 1998 | ||

| + | |id édité=[[A pour auteur cité::Claudia Leacock|Leacock, C.]], [[A pour auteur cité::George A. Miller|Miller, G.A.]], [[A pour auteur cité::Martin Chodorow|Chodorow, M.]], 1998 | ||

| + | |texte=''Using corpus statistics and WordNet relations for sense identification''. Comput. Linguist. 24, 1 (Mar. 1998), 147-165.}} | ||

| − | M.E. | + | {{CIDE biblio |

| + | |id=Lesk, 1986 | ||

| + | |id édité=[[A pour auteur cité::Michael E. Lesk|Lesk, M.E.]], 1986 | ||

| + | |texte=''Automatic sense disambiguation using machine readable dictionaries: How to tell a pine cone from a nice cream cone''. In Proceedings of the SIGDOC Conference. Toronto, 1986.}} | ||

| − | D. | + | {{CIDE biblio |

| − | + | |id=Lin, 1998 | |

| + | |id édité=[[A pour auteur cité::Dekang Lin|Lin, D.]], 1998 | ||

| + | |texte=''An information-theoretic definition of similarity''. In Proceedings of 15<sup>th</sup> International Conference On Machine Learning, 1998.}} | ||

| + | {{CIDE biblio | ||

| + | |id=Medelyan, 2009 | ||

| + | |id édité=[[A pour auteur cité::Olena Medelyan|Medelyan, O.]], [[A pour auteur cité::David Milne|Milne, D.]], [[A pour auteur cité::Catherine Legg|Legg, C.]], [[A pour auteur cité::Ian H. Witten|Witten, I.H.]], 2009 | ||

| + | |texte=''Mining meaning from Wikipedia''. In International Journal of Human-Computer Studies archive, Volume 67, Issue 9 (September 2009). Pages: 716-754. Year of Publication: 2009. ISSN: 1071-5819}} | ||

| + | {{CIDE biblio | ||

| + | |id=Mihalcea, 2000 | ||

| + | |id édité=[[A pour auteur cité::Rada Mihalcea|Mihalcea, R.]], [[A pour auteur cité::Dan Moldovan|Moldovan, D.]], 2000 | ||

| + | |texte=''Semantic indexing using WordNet senses''. In Proceedings of ACL Workshop on IR & NLP, Hong Kong, October 2000.}} | ||

| − | + | {{CIDE biblio | |

| + | |id=Miller, 1995 | ||

| + | |id édité=[[A pour auteur cité::George A. Miller|Miller, G. A.]], 1995 | ||

| + | |texte=''WordNet: A Lexical database for English''. Actes de ACM 38, pp. 39-41.}} | ||

| − | + | {{CIDE biblio | |

| + | |id=Resnik, 1999 | ||

| + | |id édité=[[A pour auteur cité::Philip Resnik|Resnik, P.]], 1999 | ||

| + | |texte=''Semantic Similarity in a Taxonomy: An Information-Based Measure and its Application to Problems of Ambiguity in Natural Language''. Journal of Artificial Intelligence Research (JAIR), 11, 1999, (p. 95-130).}} | ||

| − | + | {{CIDE biblio | |

| + | |id=Sussna, 1993 | ||

| + | |id édité=[[A pour auteur cité::Michael Sussna|Sussna, M.]], 1993 | ||

| + | |texte=''Word sense disambiguation for free-text indexing using a massive semantic network''. 2<sup>nd</sup> International Conference on Information and Knowledge Management (CIKM-1993), 67–74.}} | ||

| − | + | {{CIDE biblio | |

| + | |id=Uzuner, 1999 | ||

| + | |id édité=[[A pour auteur cité::Ozlem Uzuner|Uzuner, O.]], [[A pour auteur cité::Boris Katz|Katz, B.]], [[A pour auteur cité::Deniz Yuret|Yuret, D.]], 1999 | ||

| + | |texte=''Word Sense Disambiguation for Information Retrieval''. AAAI/IAAI 1999 : 985.}} | ||

| − | M. | + | {{CIDE biblio |

| + | |id=Véronis, 1990 | ||

| + | |id édité=[[A pour auteur cité::Jean Véronis|Véronis, J.]], [[A pour auteur cité::Nancy M. Ide|Ide, N. M.]], 1990 | ||

| + | |texte=''Word sense disambiguation with very large neural networks extracted from machine readable dictionaries''. 13<sup>th</sup> International Conference on Computational Linguistics (COLING-1990), 2, 389–394. 1990.}} | ||

| − | + | {{CIDE biblio | |

| + | |id=Voorhees, 1993 | ||

| + | |id édité=[[A pour auteur cité::Ellen M. Voorhees|Voorhees, E. M.]], 1993 | ||

| + | |texte=''Using WordNet to disambiguate word senses for text retrieval''. Association for Computing Machinery Special Interest Group on Information Retrieval. (ACM-SIGIR-1993) : 16<sup>th</sup> Annual International Conference on Research and Development in Information Retrieval, 171–180. (1993).}} | ||

| − | + | {{CIDE biblio | |

| + | |id=Wilks, 2000 | ||

| + | |id édité=[[A pour auteur cité::Yorick Wilks|Wilks, Y.]], [[A pour auteur cité::Mark Stevenson|Stevenson, M.]], 2000 | ||

| + | |texte=''Combining independent knowledge source for word sense disambiguation''. Conference « Recent Advances in Natural Language Processing », 1–7.}} | ||

| − | + | {{CIDE biblio | |

| + | |id=Wu, 1994 | ||

| + | |id édité=[[A pour auteur cité::Zhibiao Wu|Wu, Z.]], [[A pour auteur cité::Martha Palmer|Palmer, M.]], 1994 | ||

| + | |texte=''Verb semantics and Lexical selection''. Proceedings of the 32<sup>th</sup> Annual Meetings of the Association for Computational Linguistics, pp. 133-138. 1994}} | ||

| − | + | {{CIDE fin corps}} | |

| − | + | ==Notes et références== | |

| − | |||

| − | |||

| − | ==Notes== | ||

<references/> | <references/> | ||

| − | |||

Version actuelle datée du 30 juin 2019 à 09:40

Indexation sémantique de documents textuels

|

Sommaire

- Résumé

- This paper describes a document semantic indexing approach. We propose to use WordNet as linguistic resource for retrieving the representative concepts of a document. Our contribution in this paper is threefold: we propose (1) an approach for identifying concepts using WordNet lexical database, (2) a disambiguation approach based on the joint use of WordNet and WordNetDomains, and (3) a concept weighting approach based on a novel definition of concept importance.

Introduction et problématique

Un processus de recherche d'information (RI) a pour but de sélectionner l'information pertinente pour un besoin en information exprimé par l’utilisateur sous forme de requête. Une étape clé dans ce processus de RI, est l’indexation. L’indexation consiste à représenter requêtes et documents par un ensemble de termes (généralement des mots simples) pondérés, sensés définir au mieux leurs contenus sémantiques. Les termes sont automatiquement extraits ou manuellement assignés aux documents et aux requêtes, puis pondérés par des valeurs numériques qui traduisent leur importance dans le document. De la qualité de l’indexation dépend en grande partie la qualité de la recherche.

Un facteur clé impactant la qualité de l’indexation concerne la capacité du système à traiter avec l’ambiguïté de la langue naturelle et à comprendre les sens des mots dans les documents. Il ne s’agit plus alors de représenter le document par de simples chaines de caractères (entités lexicales), mais bien par des entités véhiculant des sens (entités sémantiques): les concepts. L’indexation sémantique, se base sur les concepts plutôt que sur les mots pour indexer les documents. Pour ce faire, les approches d’indexation sémantiques se basent globalement sur trois étapes : (1) une première étape d’identification des termes à l’issue de laquelle les mots (simples ou composés) contenus dans le document sont identifiés. Cette étape se base sur des techniques linguistiques classiques (tokénisation, lemmatisation, élimination de mots vides) et sur quelques techniques plus avancées d’identification des collocations de mots, (2) une seconde étape de désambiguïsation des sens des mots qui a pour objet de retrouver le sens correct d’un mot dans un contexte donné. Pour ce faire, les approches de désambiguïsation s’appuient sur des ressources linguistiques telles que les corpus d’apprentissage (Cuadros, 2004), (Leacock, 1998), (Mihalcea, 2000), dictionnaires automatisés (Guthrie, 1991), (Lesk, 1986), (Voorhees, 1993), (Wu, 1994), ou encore les ontologies (Resnik, 1999), (Uzuner, 1999), et autres Wikipédia (Medelyan, 2009), qui constituent des sources d’évidence pour les définitions et sens d’un mot. Le principe de la désambiguïsation consiste en général à associer un score de désambiguïsation aux différents sens possibles d’un mot (fournis par les dictionnaires et autres ressources…). La précision de la désambiguïsation dépend non seulement de la ressource linguistique utilisée mais aussi en grande partie du score de désambiguïsation établi. (3) Dans la troisième étape, il s’agit de pondérer les concepts identifiés à l’issue de l’étape précédente. La pondération a pour objet d’associer à chaque concept un poids numérique représentant son degré d’importance dans le document. La pondération est un problème crucial en RI. La qualité de la recherche dépend de la qualité de la pondération adoptée.

Ce papier présente la formalisation d’une approche d'indexation sémantique de documents. Dans cette approche, nous proposons d’utiliser WordNet (Miller, 1995) et son extension WordNetDomains comme source d’évidence pour l’identification des sens des mots et pour leur pondération. Les mots sont alors désambiguïsés par rapport à leurs domaines associés dans WordNetDomains. La pondération d’un concept s’appuie sur une notion revisitée de l’importance d’un concept.

Le papier est structuré comme suit : Après une introduction, nous présentons en section 1[1] une synthèse des travaux dans le domaine, puis nous situons notre contribution. En section 2, nous donnons quelques notions préliminaires sur WordNet et WordNetDomains, puis des définitions utilisées dans la suite du papier. Notre approche d’indexation sémantique est détaillée en section 3. La section 4 présente une illustration. La section 5 conclut le papier.

État des lieux de l’indexation conceptuelle

L’indexation conceptuelle représente les documents par des concepts. Ces concepts sont extraits d’ontologies et autres ressources linguistiques. Pour ce faire, le processus d’indexation s’appuie en générale sur deux étapes : l’identification des concepts et leur pondération. Le processus clé dans l’étape d’identification des concepts concerne la désambiguïsation des sens des mots. De nombreuses approches existantes se basent sur WordNet comme source d’évidence pour la désambiguïsation. C’est ainsi que pour désambiguïser un mot ambigu, Voorhees (Voorhees, 1993) classe chaque synset (sens correspondant à une entrée de WordNet) de ce mot en se basant sur le nombre de mots co-occurrents entre un voisinage (Voorhees l'a appelé hood) de ce synset et le contexte local (la phrase où l’occurrence du mot apparaît) du mot ambigu correspondant. Le synset le mieux classé est alors considéré comme sens adéquat de l’occurrence analysée du mot ambigu. Les concepts sont ensuite pondérés en utilisant un schéma de pondération classique normalisé. Dans une approche différente, Katz et al (Uzuner, 1999) proposent aussi une approche basée sur le contexte local. Le contexte local d'un mot est défini comme étant la liste ordonnée des mots démarrant du mot utile le plus proche du voisinage gauche ou droit jusqu'au mot cible. L’hypothèse de Katz et al. est que des mots utilisés dans le même contexte local (appelés sélecteurs) ont souvent des sens proches. Les sélecteurs des mots d’entrée sont extraits des contextes locaux gauche et droit, puis l’ensemble S de tous les sélecteurs obtenus est comparé avec les synsets de WordNet. Le synset qui a le plus de mots en commun avec S est sélectionné comme sens adéquat du mot cible. Ce principe est repris dans l’approche d’indexation de Baziz et al. (Baziz, 2005). Les auteurs considèrent ainsi que parmi les différents sens possibles (concepts candidats) d’un terme donné, le plus adéquat est celui qui a le plus de liens sémantiques (Lesk, 1986), (Lin, 1998), (Sussna, 1993) avec les autres concepts du même document. L’approche consiste à affecter un score à chaque concept candidat d’un terme d’indexation donné. Le score d'un concept candidat est obtenu en sommant les valeurs de similarité qu'il a avec les autres concepts candidats correspondant aux différents sens des autres termes du document. Le concept candidat ayant le plus haut score est alors retenu comme sens adéquat du terme d’indexation associé. Les concepts sont ensuite pondérés sur la base d’un schéma de pondération dit , qui étend la pondération pour tenir compte des termes composés. L’approche de Baziz et al. a été reprise dans Boughanem et al. (Boughanem, 2010), avec une nouvelle définition de la pondération. En effet, dans (Boughanem, 2010), les auteurs introduisent les notions de centralité et de spécificité d’un concept. La centralité définit le nombre de relations de ce concept avec les autres concepts du document. Sa spécificité définit son degré de « spécialité ». Le schéma de pondération utilisé est basé sur la combinaison de ces deux mesures. Dans notre approche d’indexation sémantique proposée dans (Boubekeur, 2010 (1)), (Boubekeur, 2010 (2)), le choix du concept correct dans un contexte s’appuie sur un score basé sur la somme des valeurs de similarité que le concept cible a avec les concepts les plus fréquents dans le document. Les concepts sont alors pondérés sur la base d’une mesure de leur importance dans le document, quantifiée au travers de leur proximité sémantique aux autres concepts du document. Dans une approche plus récente (Kolte, 2008) les auteurs proposent une approche intéressante de désambiguïsation à deux niveaux : d’abord retrouver le domaine correct d’un mot dans le document, puis désambiguïser ce mot dans le domaine ainsi identifié. Le domaine correct d’un mot est celui qui maximise ses occurrences dans le contexte local du mot cible. Les auteurs utilisent WordNetDomains, qui permet de classifier les différentes entrées de WordNet dans des domaines prédéfinis.

Positionnement de notre proposition

Notre approche proposée dans ce papier tente de combiner notre approche d’indexation conceptuelle dans (Boubekeur, 2010 (1)), (Boubekeur, 2010 (2)) et l’approche de désambiguïsation par les domaines au sein d’un paradigme unifié. L’objectif est de représenter de manière précise le document par un noyau sémantique composé de concepts pondérés. Dans notre proposition, les termes d’indexation sont d’abord extraits en se basant sur des étapes d’indexation classiques. Cette étape inclut en outre une nouvelle proposition pour la détection des collocations à partir d’une liste pré-établie des collocations de WordNet ; à l’issue de cette étape, trois listes sont construites : la liste des collocations, la liste des mots simples ayant des entrées correspondantes dans WordNet, et la liste des mots simples n’ayant pas d’entrée dans WordNet (ces mots seront dits des mots orphelins). Puis chaque mot non vide identifié dans WordNet est désambiguïsé dans son contexte global dans le document. La désambiguïsation d’un mot se base d’abord sur sa désambiguïsation de domaine (ie. trouver le domaine correcte du mot dans le document), puis sa désambiguïsation sémantique dans le domaine choisi.

- La désambiguïsation du domaine se base sur une mesure de probabilité d’appartenance du mot cible et des mots du contexte à un domaine donné. Le domaine qui maximise cette mesure est retenu comme domaine correct du terme dans le document.

- La désambiguïsation des concepts est basée sur l’intuition que les concepts appartenant à un même domaine sont fortement (sémantiquement) liés et doivent renforcer la désambiguïsation sémantique du concept cible par rapport à des concepts qui ne sont pas dans le même domaine que lui.

L’approche de pondération des concepts est basée sur une nouvelle définition de la notion de centralité d’un concept. La centralité dépend de la pertinence d’un concept dans le document et sur sa fréquence. Ces notions seront définies en section suivante. Dans ce qui suit, nous décrivons les différentes étapes de notre approche d’indexation sémantique. Mais d’abord, nous présentons quelques notions préliminaires sur WordNet, ainsi que des définitions et notations utilisées dans la suit de notre papier.

Préliminaires

WordNet

WordNet est un réseau lexical électronique qui couvre la majorité des noms, verbes, adjectifs et adverbes de la langue Anglaise, qu’il structure en un réseau de nœuds et de liens.

- Les nœuds sont constitués par des ensembles de termes synonymes appelés synsets.

- Un synset représente un concept.

- Un concept est une entité sémantique, lexicalement représentée par un terme.

- Un terme peut être un mot simple ou une collocation de mots.

- Les liens représentent des relations sémantiques entre concepts, dont par exemple les relations d’hyponymie-hyperonymie suivantes :

- la relation de subsumption entre noms, (relation is-a) qui permet d’associer un concept classe (l’hypernyme) à un concept sous-classe (l’hyponyme). Par exemple, le nom tower#1 a pour hyponymes silo, minaret, pylon… Cette relation permet d’organiser les concepts de WordNet en une hiérarchie.

- la relation d’instanciation (instance) qui permet d’associer un concept et son instance. Par exemple, le nom tower#1 a pour instance hyponyme tour Eiffel.

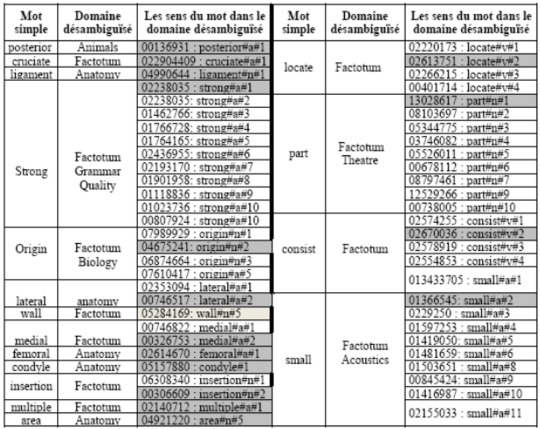

Un exemple de hiérarchie de synsets correspondant au nom « bank » est donné en Table 1.

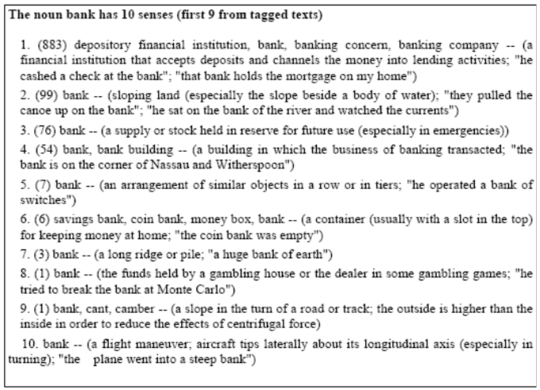

WordNetDomains est une extension de WordNet dans laquelle les synsets ont été étiquetés par des labels de domaines. Un exemple de domaines associés au synsets du mot bank est donné en Table 2. Ces domaines sont organisés selon une hiérarchie définissant la relation de spécialisation/généralisation entre les domaines. Par exemple, le domaine Tennis est plus spécifique que le domaine Sport, et le domaine Architecture est plus général que le domaine Buildings. Une partie de la hiérarchie de WordNetDomains est donnée en Table 3. Le domaine Top-Level représente la racine de cette hiérarchie. Le domaine Factotum de WordNetDomains est un domaine fonctionnel (par opposition à sémantique) qui regroupe tous les sens des mots qui n’appartiennent à aucun domaine particulier mais qui peuvent apparaître avec des termes associés à d’autres domaines. Factotum constitue un domaine particulier, indépendant du domaine Top-Level et de sa hiérarchie.

Définitions et notations

Soit un mot d’un texte à analyser.

a. On appelle occurrence de , toute instance de dans le texte.

b. Une instance de apparaît dans une seule phrase. L’ensemble des mots de cette phrase constitue son contexte local. On note le contexte local de l’instance par

c. On appelle contexte local droit de l’instance , l’ensemble des mots à droite de jusqu’à la prochaine ponctuation. Le contexte local droit de l’instance sera noté :

d. On appelle expression locale de l’instance , la chaîne de caractères concaténant, par le biais du souligné ( _ ), le mot avec les mots de contexte local droit successivement. La taille d’une expression locale est le nombre de mots qui la composent.

e. On appelle contexte global du mot , l’union de tous ses contextes locaux dans le texte du document. Le contexte global du mot sera noté par :

Indexation sémantique des documents

L’indexation sémantique vise à représenter un document par un ensemble de concepts pondérés qui décrivent au mieux son contenu.

Le processus d'indexation du document s’effectue en trois étapes : (1) l’identification des termes d’index, (2) la désambiguïsation des termes d’index et (3) la pondération des concepts.

Identification des termes d’index

Le but de cette étape est d'identifier :

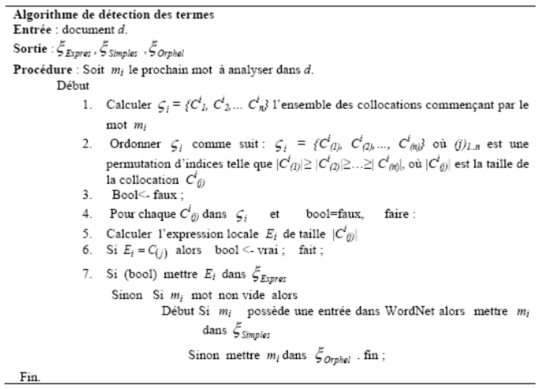

- l’ensemble des expressions du document, correspondant aux collocations de WordNet.

- l’ensemble des mots simples ayant une entrée dans WordNet,

- l’ensemble des mots orphelins (mots simples n’ayant pas d’entrée dans WordNet).

Cette étape débute par l’identification des expressions. Pour cela, nous avons d’abord construit la liste de toutes les collocations existantes dans WordNet. Puis, pour une occurrence de mot à analyser, on extrait de l’ensemble de toutes les collocations qui commencent par . On ordonne par tailles décroissantes de ses éléments, puis on projette chaque élément de sur des expressions locales de . Si une expression locale s’apparie avec une collocation, elle est retenue comme expression et insérée dans l’ensemble . Si aucune collocation de ne s’apparie avec une expression locale de , alors est un mot simple. Si possède une entrée dans WordNet, il sera inséré dans l’ensemble ; sinon il sera mis dans l’ensemble des orphelins .

Le principe de l’identification des termes est décrit à travers l’algorithme de la Table 4.

Désambiguïsation des termes

Les collocations étant des expressions quasiment désambiguïsées, l’étape d’indexation concernera uniquement les mots simples ayant des entrées dans WordNet, soit donc l’ensemble des termes de .

Chaque terme de peut avoir plusieurs sens possibles. Le but de cette étape est de sélectionner le meilleur sens du terme dans le document. L’approche de désambiguïsation proposée est une approche à trois niveaux :

- (1) dans le premier niveau, il s’agit de déterminer la forme grammaticale (nom, verbe, …) du mot dans le document, en utilisant le Stanford POS Tagger.

- (2) le second niveau, permet d’identifier le domaine d’usage du mot dans le document. L’identification des domaines s’appuie sur l’utilisation de WordNetDomains. Ce niveau de désambiguïsation permettra de limiter le nombre de sens du terme qui seront examinés dans le niveau suivant de désambiguïsation.

- (3) le troisième niveau de désambiguïsation consiste alors à sélectionner parmi les sens possibles du terme dans le domaine sélectionné, celui qui est censé le définir au mieux dans le document.

Identification de la forme grammaticale des mots simples

Les sens d’un mot dans WordNet sont classés selon ses différentes catégories grammaticales possibles. Ainsi, nous utilisons le Stanford POS Tagger pour identifier la catégorie grammaticale du mot dans le document afin de déterminer les sens appartenant à cette forme grammaticale. Cette étape permet de limiter le nombre de sens du terme qui seront utilisés dans la désambiguïsation et de récupérer les domaines qui correspondent à ses sens dans WordNetDomains.

Désambiguïsation au niveau des domaines

Chaque mot dans possède plusieurs sens dans WordNet. Les sens de WordNet sont étiquetés dans WordNetDomains par des labels de domaines. Ainsi, un sens peut appartenir à un ou plusieurs domaines.

On note :

l’ensemble de tous les synsets associés au mot ,

l’ensemble, non redondant, de tous les domaines associés aux éléments de ,

est l’ensemble des synsets de appartenant au domaine ,

le kième élément de l’ensemble

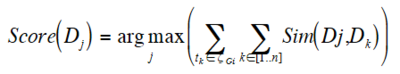

Partant de l’hypothèse que le domaine probable d’un mot est celui qui maximise sa similarité avec les autres domaines des autres mots du même contexte, nous attribuons à chaque domaine associé à un sens du mot , un score basé sur la somme de ses similarités avec les différents domaines associés aux sens des autres termes (( } )) d’index. Le domaine ayant le plus grand score est sélectionné comme domaine adéquat pour le mot dans le document.

Formellement :

Où :

désigne la similarité entre les domaines et .

Pour mesurer la similarité entre les domaines et , nous utilisons et adaptons la formule de Wu-Palmer (Wu, 1994) à la hiérarchie Top-Level de WordNetDomains, ce qui donne :

Où :

: est le domaine le plus spécifique qui subsume et dans la hiérarchie de WordNetDomains.

: est le nombre d’arcs entre la racine de WordNetDomains et le domaine .

: est le nombre d’arcs entre la racine de WordNetDomains et le domaine en passant par le domaine .

Remarque :

La formule de similarité est appliquée aux seuls domaines de la hiérarchie Top-Level. Le domaine factotum, indépendant de cette hiérarchie est un domaine fonctionnel (non sémantiquement informatif). Il ne sera pas considéré dans cette désambiguïsation.

Désambiguïsation des sens des mots

À l’issue de l’étape précédente, tout mot de est associé à un seul domaine dans le document. Deux cas peuvent se présenter :

- soit possède un seul sens dans , dans ce cas il est désambiguïsé.

- soit possède plusieurs sens dans , dans ce cas il est ambigu. Il faut le désambiguïser.

Nous proposons une désambiguïsation sur les seuls sens appartenant à , soit donc aux seuls éléments de l’ensemble . L’objectif est alors de sélectionner parmi ces sens le sens correct pour le mot dans le document.

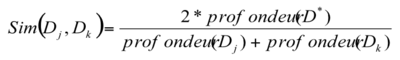

Pour désambiguïser le mot dans son domaine, on associe à chacun de ses sens de l’ensemble , un score basé sur sa proximité sémantique avec les autres sens associés aux mots de son contexte global dans leurs domaines respectifs. Le concept ayant le plus grand score est alors retenu comme sens adéquat pour le mot dans d.

Formellement :

Où est la similarité sémantique entre les concepts et . L’ensemble des concepts retenus constituera le noyau sémantique N(d) du document d. Pour des raisons de simplification, on utilisera la notation pour désigner le ième élément de N(d).

Pondération des concepts

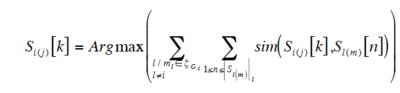

Partant de l’idée qu’un concept est d’autant plus représentatif du contenu du document qu’il est fréquent et pertinent dans ce document, nous proposons de pondérer un concept avec un poids basé sur :

Sa pertinence, que nous définissons sa proximité sémantique aux autres concepts du document,

Sa fréquence dans le document.

Formellement, le poids du concept est défini par :

Où α est un facteur de pondération qui permet de balancer la fréquence par rapport à la pertinence. Ce facteur pourra être fixé expérimentalement.

Le schéma de pondération que nous proposons permet outre la pondération des concepts, la pondération des collocations et des termes orphelins. Dans ce dernier cas, seule la fréquence est considérée, les proximités sémantiques inexistantes, sont initialisées à zéro.

Le noyau sémantique de d est alors construit en gardant seulement les concepts dont les poids sont plus grands qu'un seuil fixé. Nous proposons, dans un premier temps, de garder tous les concepts dont le poids est différent de zéro.

Illustration

Dans le paragraphe suivant, nous montrons la faisabilité de notre approche d’indexation sémantique en l’appliquant sur un exemple. Nous focalisons en particulier sur la désambiguïsation puisque de sa précision dépend en grande partie la précision de l’indexation.

Étant donné le texte suivant (extrait du document Arthroskopie.00130003.eng.abstr de la collection Muchmore[2])

“The posterior cruciate ligament (PCL) is the strongest ligament of the human knee joint. Its origin is at the lateral wall of the medial femoral condyle and the insertion is located in the posterior part of the intercondylar area. The posterior cruciate ligament consists of multiple small fiber bundles.”

Détection des concepts

Notre algorithme de détection des concepts retourne les trois ensembles suivants : , , suivants :

Désambiguïsation des termes simples

Identification de la forme grammaticale

En utilisant le Stanford POS Tagger, on obtient la forme grammaticale de chaque mot simple dans le document comme suit :

Désambiguïsation au niveau des domaines

Nous retrouvons pour chaque terme d’index l’ensemble des domaines associés à ses différents sens. Puis nous désambiguïsons au niveau des domaines. La désambiguïsation au niveau des domaines permet d’associer les domaines adéquats aux termes d’index. Les numéros des sens et les domaines associés aux termes d’index sont présentés dans les tableaux de la figure 1 suivante. Les résultats de la désambiguïsation des domaines sont récapitulés dans les tableaux de la figure 2.

Désambiguïsation des sens des mots

A l’issue de l’étape précédente, chaque terme d’index est associé aux seuls sens liés au domaine sélectionné. Seuls ces sens sont désambiguïsés. Pour le calcul du score de désambiguïsation des sens des mots, nous nous basons sur la mesure de similarité de Lesk. Dans les tableaux de la figure 2 suivante, nous représentons pour chaque terme d’index, son domaine sélectionné ainsi que ses sens associés dans ce domaine. Le sens grisé dans le tableau représente le sens désambiguïsé (sens adéquat du terme dans le document). Un examen rapide des résultats, appuyé par une désambiguïsation manuelle, nous permet de voir que : - La désambiguïsation au niveau des domaines a permis d’associer les domaines adéquats aux termes d’index. C’est ainsi par exemple que les termes d’index wall, area et ligament se sont vus assigner le domaine anatomy qui est le domaine le plus probable du texte indexé. - La désambiguïsation au niveau des sens donne aussi des sens corrects dans le document. Pour vérifier cela, nous avons comparé nos résultats avec ceux obtenus par l’approche de Baziz et al. (Baziz, 2005) pour le même texte. Les résultats obtenus montrent que nous retrouvons plus de sens corrects que dans (Baziz, 2005). A titre d’exemple, le mot wall est désambiguïsé par wall#a#1 (définit dans WordNet par : an architectural partition …) dans (Baziz, 2005), alors que notre approche nous retourne wall#a#5 (défini par : (anatomy) a layer (a lining or membrane)…) plus proche sémantiquement de la thématique (médicale) du document. Les résultats de notre approche sont encourageants mais doivent néanmoins être vérifiés sur une collection de taille réelle.

Conclusion

Nous avons présenté dans ce papier, les fondements théoriques d’une nouvelle approche d’indexation sémantique basée sur l’utilisation conjointe de WordNet et de WordNetDomains. Notre contribution porte sur les trois aspects de l’indexation sémantique : la détection des termes d’index, la désambiguïsation des termes et la pondération des concepts. En particulier, nous avons proposé une nouvelle approche de détection des concepts incluant la détection des collocations, une approche de désambiguïsation par les domaines et dans les domaines, et enfin un nouveau schéma de pondération des concepts. Nous avons montré la faisabilité de notre approche en la déroulant sur un exemple. Des travaux sont en cours en vue de sa validation expérimentale.

Bibliographie

[Baziz, M., Boughanem, M., Aussenac-Gilles, N., 2005] ↑ A Conceptual Indexing Approach based on Document Content Representation Dans : CoLIS5: Fifth International Conference on Conceptions of Libraries and Information Science, Glasgow, UK, 4 juin 8 juin 2005. F. Crestani, I. Ruthven (Eds.), Lecture Notes in Computer Science LNCS Volume 3507/2005, Springer-Verlag, Berlin Heidelberg, p. 171-186.

[Boubekeur, F., Boughanem, M., Tamine-Lechani, L., 2010] ↑ De l’utilisation de WordNet pour l’indexation conceptuelle des documents. 13e Colloque International sur le Document Électronique. 16-17 Décembre 2010, INHA, Paris

[Boubekeur, F., Boughanem, M., Tamine-Lechani, L., Daoud, M., 2010] ↑ Using WordNet for Concept-based document indexing in information retrieval. Dans: Fourth International Conference on Semantic Processing (SEMAPRO 2010), Florence, Italy, Octobre 2010

[Boughanem, M., Mallak, I., Prade, H., 2010] ↑ A new factor for computing the relevance of a document to a query (regular paper). Dans : IEEE World Congress on Computational Intelligence (WCCI 2010), Barcelone, 18/07/2010- 23/07/2010, 2010

[Cuadros, M., Atserias, J., Castillo, M., Rigau, G., 2004] ↑ Automatic acquisition of sense examples using exretriever. In IBERAMIA Workshop on Lexical Resources and The Web for Word Sense Disambiguation. Puebla, Mexico.

[Guthrie, J.A., Guthrie, L., Wilks, Y., Aidinejad, H., 1991] ↑ Subject- dependant cooccurrence and word sense disambiguation. In Proceedings of the 29th Annual Meeting of the Association for Computational Linguistics, Berkley, CA. 146-152.

[Kolte, S.G., Bhirud, S.G., 2008] ↑ Word Sense Disambiguation using WordNetDomains. In First International Conference on Emerging Trends in Engineering and Technology. 2008 IEEE DOI 10.1109/ICETET.2008.231.

[Leacock, C., Miller, G.A., Chodorow, M., 1998] ↑ Using corpus statistics and WordNet relations for sense identification. Comput. Linguist. 24, 1 (Mar. 1998), 147-165.

[Lesk, M.E., 1986] ↑ Automatic sense disambiguation using machine readable dictionaries: How to tell a pine cone from a nice cream cone. In Proceedings of the SIGDOC Conference. Toronto, 1986.

[Lin, D., 1998] ↑ An information-theoretic definition of similarity. In Proceedings of 15th International Conference On Machine Learning, 1998.

[Medelyan, O., Milne, D., Legg, C., Witten, I.H., 2009] ↑ Mining meaning from Wikipedia. In International Journal of Human-Computer Studies archive, Volume 67, Issue 9 (September 2009). Pages: 716-754. Year of Publication: 2009. ISSN: 1071-5819

[Mihalcea, R., Moldovan, D., 2000] ↑ Semantic indexing using WordNet senses. In Proceedings of ACL Workshop on IR & NLP, Hong Kong, October 2000.

[Miller, G. A., 1995] ↑ WordNet: A Lexical database for English. Actes de ACM 38, pp. 39-41.

[Resnik, P., 1999] ↑ Semantic Similarity in a Taxonomy: An Information-Based Measure and its Application to Problems of Ambiguity in Natural Language. Journal of Artificial Intelligence Research (JAIR), 11, 1999, (p. 95-130).

[Sussna, M., 1993] ↑ Word sense disambiguation for free-text indexing using a massive semantic network. 2nd International Conference on Information and Knowledge Management (CIKM-1993), 67–74.

[Uzuner, O., Katz, B., Yuret, D., 1999] ↑ Word Sense Disambiguation for Information Retrieval. AAAI/IAAI 1999 : 985.

[Véronis, J., Ide, N. M., 1990] ↑ Word sense disambiguation with very large neural networks extracted from machine readable dictionaries. 13th International Conference on Computational Linguistics (COLING-1990), 2, 389–394. 1990.

[Voorhees, E. M., 1993] ↑ Using WordNet to disambiguate word senses for text retrieval. Association for Computing Machinery Special Interest Group on Information Retrieval. (ACM-SIGIR-1993) : 16th Annual International Conference on Research and Development in Information Retrieval, 171–180. (1993).

[Wilks, Y., Stevenson, M., 2000] ↑ Combining independent knowledge source for word sense disambiguation. Conference « Recent Advances in Natural Language Processing », 1–7.

[Wu, Z., Palmer, M., 1994] ↑ Verb semantics and Lexical selection. Proceedings of the 32th Annual Meetings of the Association for Computational Linguistics, pp. 133-138. 1994

Notes et références

- ↑ La numérotation des paragraphes est décalée par rapport à celle qui est générée automatiquement par le wiki.

- ↑ http://muchmore.dfki.de/

![{\displaystyle S_{i(j)}[k]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/77646356fc6ec5edac0a8ae969b69b7eac09ca2b)

![{\displaystyle sim(S_{i(j)}[k],S_{l(m)}[n])}](https://wikimedia.org/api/rest_v1/media/math/render/svg/683f13dd3f9a6662339c448757ec64eeea9ea2d6)

![{\displaystyle S_{l(m)}[n]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/54592505d91770db03b6e1bc0b6c1f593c48acdb)