CIDE (2010) Habert

l'archivage numérique pérenne

| CIDE 13 Paris | |

|---|---|

Ce texte fait partie des actes de la conférence CIDE 13 Paris en tant que conférence invitée.

|

- Auteur

- Benoît Habert (benoit.habert@ens-lyon.fr)

- Affiliation

- ICAR – École Normale Supérieure de Lyon et EDF R&D.

| Supports de Présentation | |

|---|---|

Les diapositives sont en cours d'installation sur ce wiki

|

- Résumé

- Le numérique natif et la numérisation de données analogiques sont désormais conçus comme la manière privilégiée de transmettre l’existant. L’obsession mémorielle actuelle contribue à cette tendance. Les fragilités intrinsèques du numérique contraignent en fait à s’interroger sur les conditions techniques mais aussi et surtout sociales et humaines qui permettent de produire du « numérique durable », c’est-à-dire tel qu’il permette un accès maintenu, à long terme, des communautés aux connaissances et aux savoirs qui leur sont précieux. Les dimensions de cette pérennisation (le modèle utilisé pour ces opérations, sa mise en œuvre possible) sont abordées à partir d’un projet pilote d’archivage numérique de données orales, dans le cadre d’une Très Grande Infrastructure de Recherche en sciences humaines et sociales.

- Mots-clés

- archivage numérique pérenne, très grandes infrastructures de recherche, OAIS (Open Archival Information System), transmission des connaissances et des données

- Keywords

- digital archives, large research infrastructures, long-term preservation, OAIS (Open Archival Information System), data and knowledge transmission

- Abstract

- ‘Native’ digital data and digitized ones are nowadays given greater place in order to transmit research data and documents. This trend is strengthened by a current obsession with memory. However there is a dramatic discrepancy between the increasing role of digital information and its fragility. The standard abstract model for archival information systems is presented as well as the way it was instantiated in a pilot project for the long-term preservation of research data (spoken data) in the context of a large research infrastructure for social sciences and humanities. This leads to the factors that are bound to act upon the future of such projects: organizational behaviours, role of data and knowledge, communities of users, institutional issues.

Sommaire

- 1 Mauvais souvenirs numériques

- 2 Comprendre le problème posé par la pérennisation du numérique : le modèle de référence OAIS

- 3 Un projet pilote de pérennisation des données orales en SHS (2008-2010)

- 4 4 Du modèle OAIS à sa mise en œuvre

- 5 5 Construire des représentations partagées pour transmettre le numérique

- 6 6 Pérenniser la pérennisation…

- 7 7 Conclusion

- 8 Bibliographie

- 9 Notes

- Introduction

A l’URL <http://www.futura-sciences.com/fr/news/t/technologie-1/d/au-clair-de-la-lune-ecoutez-le-plus-vieil-enregistrement-sonore-du-monde_15096/>, si vous cliquez, vous entendez le plus vieil enregistrement sonore du monde. Il dure dix secondes et date très précisément du 9 avril 1860 (soit 17 ans avant le phonogramme d’Edison et 28 ans avant le premier enregistrement précédemment connu, celui d’un oratorio de Haendel sur un rouleau de cire). C’est probablement une femme qui chante un air simple : « Au clair de la lune, Pierrot répondit… » Edouard-Léon Scott de Martinville a « fixé » ce fragment grâce à son invention : le phonautographe. Cet appareil (Figure 1) inscrit au moyen d’un stylet relié à un résonateur une ligne blanche ondulant et analogue au son sur une bande papier recouverte de noir de fumée. David Giovannoni et Patrick Feaster, de l’association américaine First Sounds, qui se consacre à la reconstitution des plus anciens enregistrements connus, ont retrouvé les dépôts pour brevet d’E.-L. Scott de Martinville à l’INPI (Institut national de la propriété industrielle) et à l’Académie des sciences celui que vous pouvez écouter. L’inventeur avait mis au point un dispositif destiné à noter visuellement le son, pas à le rejouer, contrairement à T. Edison. D. Giovannoni et P. Feaster ont donc fait appel aux techniques mises au point et adaptées par Vitaliy Fadeyev et Carl Haber (Lawrence Berkeley National Laboratory). Ces techniques permettent de reconstituer à l’aide d’un laser la forme du sillon, analogue au signal sonore initial. Cette archéologie numérique fait que cette voix demeure et ne reste pas captive pour toujours d’une technique disparue. Il n’est pas sûr que le numérique que nous créons actuellement ait cette chance si nous ne mettons pas en place son archivage pérenne[1].

La partie 1 oppose la place grandissante du numérique pour la transmission de l’existant à sa fragilité largement méconnue. La partie 2 présente la norme OAIS, modèle de référence pour la pérennisation du numérique. La partie 3 introduit un projet pilote de pérennisation en sciences humaines et sociales, dans le cadre d’une très grande infrastructure de recherche. La partie 4 examine la mise en œuvre du modèle OAIS dans ce contexte. La partie 5 insiste sur les enjeux de l’archivage numérique en termes de représentations partagées. La partie 6 souligne les conditions de pérennisation d’un tel projet. La partie 7 conclut sur les changements de mode de travail qui résultent de l’archivage numérique pérenne et sur l’importance de réapprendre à oublier pour mieux pérenniser.

Mauvais souvenirs numériques

La première décennie du XXIe siècle prolonge la « compulsion mémorielle » qui s’installe dans le dernier quart du siècle précédent. R. Robin [1] et E. Hoog [2], parmi d’autres, analysent ce phénomène. Les signes en sont nombreux. Citons-en quelques-uns. « Selon les estimations du cabinet IDC, 420 milliards de photos ont été prises dans le monde en 2007, soit près de 50 millions par heure » [2]. P. Ricœur [3] cite P. Nora qui parle dans Les lieux de mémoire d’un « moment-mémoire » pour définir notre époque. Le succès de ce dernier ouvrage de 3 volumes et près de 5 000 pages est lui-même un symptôme. Paru initialement entre 1984 et 1992 en édition reliée, il est désormais disponible en « livre de poche ». Tout se passe comme si le peuple français, « recru d’histoire » (De Gaulle), se projetait malaisément dans le futur et se réfugiait dans le passé, sa conservation, voire son embaumement. Sans doute s’agit-il d’ailleurs d’une tendance –la recomposition des racines – partagée aussi bien par les « vieilles nations », en y incluant les Etats-Unis, que par les plus « récentes », comme celles issues de la réorganisation de l’ex-Europe de l’Est.

La généralisation du numérique ouvre des horizons nouveaux à cette obstination mémorielle. Le numérique dissocie en effet l’information représentée d’un support spécifique : une image, des sons, un texte, un programme se représentent uniformément par des suites de 0 et de 1. Celles-ci peuvent être stockées indifféremment sur des disquettes, des disques durs, des mémoires flash, des CD-Rom ou des DVD, etc., dont la capacité de stockage ne cesse d’augmenter. La numérisation de données analogiques répond alors à ce désir de ne pas perdre ses « souvenirs », à titre individuel mais surtout collectif. Les institutions patrimoniales nationales, comme la Bibiothèque Nationale de France (BNF) ou la DAF (Direction des archives de France), sont engagées fortement et depuis de nombreuses années dans ce mouvement. Les pouvoirs régionaux soutiennent également des actions nombreuses et importantes en ce sens. Le numérique « natif » a cru dans des proportions incomparablement plus fortes. Chacun(e) de nous dans sa vie professionnelle comme personnelle vit et produit du numérique et dépend crucialement des mémoires offertes par son/ses ordinateur(s), ses sauvegardes, comme les « pertes » accidentelles ou les vols le rappellent cruellement. Pour reprendre les mots d’A. Ernaux [4] : « La recherche du temps perdu passait par le web. [...] On était dans un présent infini. On n'arrêtait pas de vouloir le ‘sauvegarder’ en une frénésie de photos et de films visibles sur le champ. Des centaines d'images dispersées aux quatre coins des amitiés, dans un nouvel usage social, transférées et archivées dans des dossiers – qu'on ouvrait rarement – sur l'ordinateur. Ce qui comptait, c'était la prise, l'existence captée et doublée, enregistrée à mesure qu'on la vivait, des cerisiers en fleur, une chambre d'hôtel à Strasbourg, un bébé juste né. Lieux, rencontres, scènes, objets, c'était la conservation totale de la vie. Avec le numérique, on épuisait la réalité ».

Cet emballement à produire du numérique, par conversion ou nativement, s’accompagne curieusement d’une inconscience certaine quant à la durée de vie effective des données numériques résultantes. La peur de perdre « leur passé » travaille les individus et les peuples : ils risquent pourtant de se trouver confrontés très rapidement à de mauvais souvenirs numériques. Le numérique conjugue en effet les fragilités. Les supports physiques du numérique vieillissent mal. « Une étude réalisée par Google sur son propre parc informatique a ainsi révélé que 8% des disques vieux de deux à trois ans devaient être remplacés en raison de leur défaillance » [2]. D’une recopie d’un support à l’autre, un bit peut changer. Les formats évoluent rapidement et « piègent » l’information qui est représentée par leur intermédiaire. Les logiciels qui donnent accès à un moment donné à l’information numérisée meurent d’eux-mêmes. Enfin, l’information peut se retrouver inaccessible, parce qu’on ne sait plus qu’elle existe ou parce que les termes qui permettent d’y accéder (métadonnées) ont changé. Cette fragilité numérique se rapproche parfois des dégradations minimes observées pour l’analogique. C’est le cas lorsque les différences de ressources (polices, par exemple) d’un ordinateur à l’autre déforment le rendu. Figure 2, la flèche de réécriture (→) s’est ainsi métamorphosée inopinément en un D orné. Plus fréquemment la dégradation est « catastrophique ». Alors qu’un manuscrit endommagé, un papier jauni, cassant, une photographie ancienne et un peu effacée restent au moins partiellement lisibles, un fichier numérique devient souvent totalement inutilisable. Au total, sans pessimisme exagéré, on peut estimer que l’essentiel du numérique actuel (natif ou non) a une espérance de vie limitée, de 5 à 10 ans maximum. Nous produisons aujourd’hui sous forme numérique des données et des connaissances qui se révèleront inutilisables à long terme (une génération et plus) si nous ne prenons pas les mesures appropriées.

Comprendre le problème posé par la pérennisation du numérique : le modèle de référence OAIS

Le domaine spatial a été l’un des premiers à utiliser les technologies numériques de façon massive dès la fin des années 1960 : l’information transmise au sol par les sondes scientifiques spatiales était nécessairement de nature électromagnétique ; le volume d’information imposait des traitements automatisés. Les informations recueillies étaient le plus souvent uniques et irremplaçables. Lorsqu’on observe une comète qui passe au voisinage de la terre ou une éruption solaire, lorsqu’on établit une cartographie précise des forêts sur la terre à une date donnée, il ne sera pas possible de reconstituer ces informations si l’on a perdu les données correspondantes. Après qu’aient été accumulées des observations pendant plus de 20 ans, après qu’aient été subies les premières mutations technologiques du numérique, la question de la pérennisation de ce patrimoine d’observations scientifiques s’est posée avec acuité dès le début des années 1990. Les agences spatiales, la NASA aux Etats-Unis et le CNES en France en particulier, avaient commencé à apporter des réponses pragmatiques aux questions qui se posaient mais la nécessité d’une réflexion normative de fond sur le sujet s’est vite imposée.

Le CCSDS (Comité consultatif pour les systèmes de données spatiales) [5] est un organisme de standardisation commun aux agences spatiales. Il représente également le sous-comité de l’ISO (Organisation internationale de normalisation) dédié aux véhicules spatiaux. Les ingénieurs du CCSDS ont été sollicités en 1995 pour élaborer une norme en matière d’archivage long terme des observations spatiales. Ils ont alors eu l’intelligence de répondre de manière prospective sur deux points essentiels :

- La question de l’archivage à long terme d’informations sous forme numérique n’est en rien une question spécifique au domaine spatial et il convient d’associer à une telle réflexion, les représentants d’autres secteurs d’activité qui sont ou seront confrontés aux mêmes besoins de conservation numérique,

- Dans un contexte d’instabilité et d’obsolescence constante et rapide des technologies numériques, il est préférable de proposer un modèle de référence abstrait permettant de comprendre les spécificités particulières du numérique et de définir tous les concepts nécessaire à la compréhension et à la résolution du problème posé. Un tel modèle pourra être durablement stable alors que toute norme de mise en œuvre sera dépendante des technologies du moment et par conséquent éphémère.

C’est ainsi qu’est né le « Reference Model for an Open Archival Information System », appelé plus simplement Modèle OAIS, [6] standardisé par le CCSDS en 2002 puis normalisé par l’ISO en 2003 (ISO 14721). Nous en retiendrons ici les points essentiels.

L’archive (au singulier) est définie dans ce modèle comme une organisation chargée de conserver l'information pour permettre à une communauté d’utilisateurs cible d'y accéder et de l'utiliser. On y retrouve l’idée de la pérennisation de l’information mais aussi, très explicitement, la nécessité de faire en sorte que dans le futur, cette information puisse être retrouvée, récupérée, comprise, interprétée convenablement par des utilisateurs qui n’ont pas participé à sa création et qui utilisent d’autres moyens numériques – ordinateurs, systèmes d’exploitation, logiciels – que ceux qui ont été utilisés pour la création de cette information. Ceci nous amène tout de suite à une réflexion qui dépasse les questions purement technologiques : si nous considérons qu’un document est un ensemble d'informations enregistrées, considéré comme une unité, qu’est-ce qui permettra que ce document soit compréhensible dans le futur par ces utilisateurs ?

Les deux piliers du modèle OAIS sont constitués par un modèle d’information et un modèle fonctionnel. Le modèle d’information apporte certainement la contribution la plus cruciale. Nous voulons pérenniser des informations numériques représentées en pratique par des données constituées de séquences de 0 et de 1 (les bits). Le modèle identifie et conceptualise les catégories d’informations supplémentaires qu’il faudra obligatoirement conserver en complément des données pour atteindre l’objectif fixé. Au cœur de ces informations complémentaires se trouve l’information de représentation : elle concentre tout ce qu’il est nécessaire de savoir, aujourd’hui et dans le futur proche ou lointain, pour pouvoir passer des séquences de bits à une information intelligible. Vaste question, d’autant que cette information de représentation étant elle-même numérique, le problème devient récursif. A côté, se greffent également l’information de provenance (savoir d’où vient le document, être sûr de son authenticité), l’information d’identification (qui n’est pas un concept nouveau et qui existe depuis longtemps avec les ISBN, ISSN… mais en numérique, comment créer un identifiant à la fois unique et pérenne ?). L’information d’intégrité nous assure que le document n’a pas été modifié et l’information de contexte replace ce document dans le cadre général d’un ensemble de documents organisés, hiérarchisés, reliés entre eux. En matière de terminologie, la distinction est donc faite dans le modèle OAIS entre l’information, définie ici comme une connaissance susceptible d’être échangée, et la donnée qui n’est que la représentation formalisée de cette information – représentation adaptée à la communication, l’interprétation ou le traitement. La donnée est porteuse d’information. Une difficulté majeure sur le long terme sera donc de toujours être en mesure de passer de la donnée à l’information contenue dans cette donnée puisque c’est la préservation de l’information qui nous intéresse.

La Figure 3 donne un aperçu concret des « couches » qui s’empilent pour tout objet numérique, si simple soit-il. En a, un « train de bits », de 0 et de 1, très exactement 120. En b, le découpage en 15 octets (suite de 8 bits). En c, la représentation dans le système décimal du nombre correspondant à chaque octet dans le système binaire (c’est le même nombre dans 2 bases différentes : 2 versus 10). En d, chacun de ces numéros d’ordre est interprété comme un chiffre. On obtient en e un nombre en concaténant ces chiffres. Ce nombre serait susceptible des opérations habituelles de son type : sommation, multiplication, etc. Alternativement, et c’est une autre interprétation, en f, en ajoutant des espaces « pour l’œil » (elles ne figurent à aucun des niveaux du millefeuille numérique), on obtient un identifiant du type de celui qui figure sur la carte Vitale de chacun(e) de nous. Il s’agit très précisément d’un numéro d’inscription au répertoire (NIR), l’identifiant unique des individus inscrits au répertoire national d’identification des personnes physiques (RNIPP) géré par l’INSEE depuis 1946 <http://xml.insee.fr/schema/nir.html>. Le NIR est un numéro à treize caractères dont la composition est précisée dans l'article 4 du décret n° 82-103 du 22 janvier 1982 : « Le numéro attribué à chaque personne inscrite au répertoire comporte 13 chiffres. Ce numéro indique successivement et exclusivement le sexe (1 chiffre), l'année de naissance (2 chiffres), le mois de naissance (2 chiffres), et le lieu de naissance (5 chiffres ou caractères) de la personne concernée. Les trois chiffres suivants permettent de distinguer les personnes nées au même lieu, à la même période. » En f, se trouve donc un identifiant numérique de 15 chiffres composé du NIR (13 chiffres) et de sa clé (2 chiffres). Il permet de réduire les erreurs de saisie ou de transmission des identifiants NIR et est couramment utilisé dans le domaine médical, notamment dans les déclarations de sécurité sociale. La clé permet de vérifier que les 13 chiffres qui précèdent ont été transmis sans erreur. On calcule cette clé en soustrayant de 97 le reste de la division entière par 97 du nombre formé par les 13 chiffres précédents. Dans l’exemple présent : 97 – (1580875656192 modulo 97) = 97 – 23 = 65 → le NIR a bien été transmis. Supposons que l’identifiant transmis soit 158087564619265, c’est-à-dire la très minime erreur de recopie d’un bit sur 120 au 9e octet. 97 – (1580875646192 modulo 97) = 97 – 14 = 83 → ce qui a été transmis n’est pas un NIR.

| ||||||||||||||||||

La donnée est le train de 120 bits en a de la Figure 3. Les couches successives b, c, d, f sont autant d’informations de représentation nécessaires à la sauvegarde de l’information correspondant à cette donnée. Elles ne suffisent d’ailleurs pas à permettre de se servir de cette information : il manque le contexte (NIR et sa structure ; règle d’utilisation de la clé de contrôle, etc.).

Archiver, dans ce cadre, consiste tout d’abord à vérifier les données qui sont livrées (les trains de bits) en s’assurant qu’elles répondent effectivement au format qu’elles revendiquent. Dans le cas du NIR, c’est par exemple vérifier que le chiffre en première position est soit 1 ou 2 (codage du sexe), que celui en 3e et 4e position correspondent aux codages : 01, 02, 03, 04, 05, 06, 06, 08, 09, 10, 11, 12, c’est-à-dire à une représentation conventionnelle des mois de l’année, etc. Une archive accepte donc un nombre déterminé de formats d’archivage pour les données et opère au versement cette certification. Par exemple, pour reprendre l’exemple de la Figure 2, un fichier PDF peut ne pas contenir toutes les ressources nécessaires pour être utilisé sur toutes les plateformes. Son caractère « auto-porteur » va donc être examiné. L’archive vérifie également la bonne formation des métadonnées correspondantes. Comme on l’a vu dans l’exemple de la Figure 3, le contexte d’utilisation de la donnée doit être fourni, dans toute sa complexité éventuelle, et dans un format lui aussi standardisé (par exemple à partir du Dublin Core [7]). Concrètement, l’archive reçoit d’un service versant (Figure 4) un paquet de versement (Submission Information Package – SIP), associant données et métadonnées. Ce paquet correspond dans l’immédiat souvent à une « grammaire » XML qui fait l’objet d’un accord entre archive et service versant. Le service versant a pour fonction de faire le truchement entre les données et métadonnées parfois encore « désordonnées » des producteurs et les spécifications de l’archive. L’archive met en place des chaînes de traitement qui valident ou invalident le paquet de versement. En cas d’invalidation, le service versant est notifié et doit « revoir sa copie ». En cas de validation, le paquet est archivé avec un numéro unique (comme AIP – Archival Information Package).

La tâche centrale de l’archive – la certification – est complétée par d’autres volets. En premier lieu, l’archive et le service versant doivent s’accorder sur ce qui a été versé. Pour cela, les deux calculent avec le même algorithme une empreinte numérique du paquet de versement. L’archive envoie cette empreinte au service versant qui peut savoir alors si ce qui a été reçu et traité est bien ce qui a été envoyé. Cette propriété est particulièrement cruciale pour pouvoir remplir une des fonctions de l’archive, la réversibilité, c’est-à-dire la capacité à retourner à l’identique au service versant son paquet (par exemple, en cas de cessation de l’archive ou de changement d’archive pour le service versant). En second lieu, l’archive doit préserver les paquets archivés des destructions ou dégradations de support. Elle assure leur réplication sur un site distant. Elle vérifie régulièrement la stabilité de chaque paquet : elle compare l’empreinte numérique de départ du paquet et celle qu’on calcule – elles doivent être identiques, dans le cas contraire, elle restaure le paquet à partir de l’autre version. En troisième lieu, l’archive assure la migration des données et des métadonnées en fonction des évolutions des formats (ce qui suppose une activité de veille sur les formats). On notera ici un paradoxe au cœur même de l’archivage du numérique. La migration est nécessaire pour l’archive ne meure pas. Elle ne garantit pas pour autant la préservation exacte de l’information. Enfin, l’archive donne accès à l’information en diffusant des versions des paquets archivés (DIP – Dissemination Information Package).

Soulignons quelques distinctions de sens. Stocker n’est pas archiver, pas plus que sauvegarder, ou répliquer : c’est effectuer une « copie » (éventuellement multiple) de la donnée telle quelle, sans vérifier sa bonne conformité et sans lui associer obligatoirement des métadonnées (autres que celles du nom du fichier et de son type éventuel). Dans la pratique, hors le monde de l’archivage numérique pérenne, les mots s’emploient sans grande précaution, et l’on parle souvent d’archivage là où il ne s’agit guère que de sauvegarde ou de réplication.

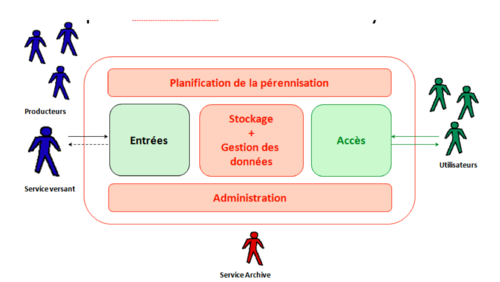

Le modèle fonctionnel (Figure 4) vise à délimiter les responsabilités entre l’archive et les intervenants externes que sont les producteurs d’information, le service versant, les utilisateurs et ce qui est appelé le management et qui correspond ici à l’entité qui définit le mandat de cette archive et qui, souvent, lui fournit les ressources nécessaires à son fonctionnement. Ce modèle fonctionnel identifie également les flux de données et les fonctions essentielles qui sont prises en charge par l’archive. Les entités fonctionnelles « Entrées », « Stockage », « Gestion des données », « Accès » parlent d’elles mêmes. L'entité « Administration » assure la supervision, la coordination continue du fonctionnement des autres entités de l’Archive. C’est elle qui prend les décisions internes. L'entité « Planification de la préservation » assure les fonctions relatives à la surveillance de l'environnement de l'archive et à la production de recommandations visant à ce que les informations archivées restent accessibles et compréhensibles sur le long terme dans un environnement en évolution permanente.

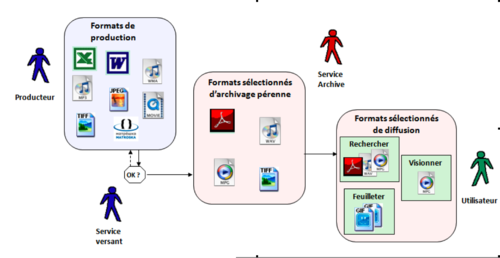

On voit la place centrale des formats. La Figure 5 matérialise la transformation entre les formats utilisés par le producteur, ceux acceptés par l’archive en entrée (Figure 6 – ceux de la plateforme d’archivage du CINES [8] – cf. infra § 4), et ceux fournis à l’utilisateur. Un format acceptable est un format largement utilisé, mais surtout dont les spécifications sont publiées, de telle manière qu’on puisse valider son respect par une donnée qui s’en réclame. Les formats normalisés sont donc privilégiés, ainsi que les formats non propriétaires. Ce n’est par exemple qu’assez récemment que le format Word a été publié et normalisé. La complexité actuelle de ce format n’en fait pas un candidat naturel à l’archivage. L’archivage peut donc contraindre à migrer des documents Word vers du PDF/A. Symétriquement, le format d’archivage n’est pas forcément celui dans lequel on donnera accès aux données. Par exemple, une image peut être archivée dans un format « lourd » comme TIFF tout en étant rendu accessible en PNG ou en JPEG pour des raisons de facilité de transfert, et assortie d’une vignette « dégradée » permettant le feuilletage commode des données archivées.

| ||||||||||

| Figure 6. Les formats acceptés au CINES |

|---|

Dès la fin des années 1990, avant même sa normalisation définitive, le modèle OAIS s’est imposé comme une base conceptuelle incontournable pour la pérennisation du patrimoine numérique. Il a donné lieu à un nombre important d’implémentations. Le service d’archivage numérique mis en place à la Bibliothèque nationale de France autour du système SPAR [9] (Système de préservation et d’archivage réparti) a poussé très loin la recherche d’une totale conformité au modèle.

Un projet pilote de pérennisation des données orales en SHS (2008-2010)

Les Très Grandes Infrastructures de Recherche (TGIR) ou Très Grands Equipements (TGE) répondent à la nécessité de mettre à la disposition de la communauté scientifique des moyens dépassant la programmation à relativement court terme (3 à 4 ans maximum) et les budgets correspondants. Ce sont donc des équipements « lourds », dont les financements dépassent ceux des laboratoires et des projets et qui sont conçus pour le moyen terme et un usage « transverse ». Ils sont pilotés par le Ministère de l’Enseignement et de la Recherche [10] et pour certains en charge du CNRS [11]. Les TGIR ont pris naissance, ce n’est pas surprenant, en physique. Ce modèle d’outillage scientifique s’est progressivement étendu à d’autres disciplines. La notion d’« instrument » s’en est élargie d’autant. C’est ainsi qu’ont émergé en astronomie les observatoires virtuels [12]. Il s’agit d’un réseau d’observatoires qui améliorent la mutualisation de leurs observations et qui combinent les observations provenant de plusieurs télescopes comme s’il n’existait qu’un seul instrument. La nécessité d’« équiper » de manière similaire les sciences humaines et sociales (SHS) a émergé progressivement. Au niveau européen, la feuille de route élaborée en 2006 par ESFRI [13] (European Strategy Forum on Research Infrastructures) et actualisée en 2008, planifie la stratégie européenne de financement de la construction des futures TGIR. Elle comprend plusieurs TGIR destinées aux SHS, dans des degrés variés de « construction » [14]. Le CNRS a créé début 2007 le TGE Adonis [15], consacré à l’accès unifié aux données et documents numériques en SHS. Pour remédier à la situation esquissée dans la première section, un objectif privilégié par le TGE Adonis a été la pérennisation des données numériques, avec deux visées : la sûreté et la fiabilité ; la réduction – à terme – des coûts par la mise en commun des moyens et des ressources humaines compétentes.

Le TGE Adonis a lancé en novembre 2007 une étude sur les besoins et les offres en archivage numérique pour les SHS. Pour éviter une expertise mêlant juges et parties, cette étude a été confiée à O. Bärring, du CERN (Genève). Les conclusions de l’étude ont été prêtes début février [16]. O. Bärring conseillait de ne pas créer d’entité nouvelle dédiée à la pérennisation numérique, mais bien plutôt de s’appuyer sur des centres de calcul « lourds » déjà existants, bien munis en compétences et en équipements. L’idée était de faire des économies d’échelle : l’archivage SHS constituerait une proportion relativement minime des activités de tels centres et ne nécessiterait dès lors pas d’investissements initiaux importants en matériel (serveurs, réseau) coûteux. Cette solution permettrait aussi de bénéficier de compétences en matière de stockage et d’échanges massifs de données et de dégager des forces spécifiques pour le volet Archivage numérique à proprement parler.

L’hétérogénéité de départ des SHS conjuguée à un contexte de restructurations fortes interdisaient l’idée d’une solution globale d’archivage numérique. L’instance décisionnelle du TGE Adonis, son Comité de pilotage, a opté en mars 2008 pour un projet pilote d’archivage limité à un secteur particulier : les données orales. Par données orales, on entend des enregistrements de parole (des conversations, des monologues) qui servent à la recherche en linguistique (apprentissage du langage, fonctionnement de l’oral, etc.) ou en ingénierie linguistique (données d’entraînement de systèmes de reconnaissance de la parole). Il s’agit donc en général d’enregistrements sonores, mais les enregistrements vidéo se font de plus en plus fréquents : ils fournissent des renseignements supplémentaires sur les interactions entre les interlocuteurs, sur la complémentarité entre ce qui se dit par la voix, par le geste et par le corps. À cela peuvent s’ajouter des mesures de paramètres physiologiques associés à la production de parole : électroglottographie, articulographie, palatographie etc. Ces données ne sont pas « nues », elles sont assorties d’annotations ou d’enrichissements : transcriptions textuelles de l’échange ou de la prise de parole, découpage en « sons » (phonèmes) et en syllabes, etc. Enfin des métadonnées riches permettent d’identifier ces données et leurs annotations : langue concernée, période et région d’enregistrement (par exemple, pour pouvoir étudier l’oral selon les régions de France ou de la francophonie), informations sur les locuteurs (âge, sexe, catégorie socio-professionnelle). Plusieurs raisons ont motivé la volonté du Comité de pilotage du TGE Adonis de partir de ce type de données pour montrer la faisabilité d’un dispositif d’archivage numérique en SHS. En premier lieu, plusieurs sous-communautés scientifiques produisent et/ou utilisent des données orales : psycholinguistes, syntacticiens, phonéticiens et phonologues, etc. Une même annotation ou un même enregistrement peuvent donc être utilisés et « enrichis » selon des angles différents. La coexistence de ces intérêts multiples et de données potentiellement partageables a conduit à des confrontations sur les manières d’annoter ces données, mais aussi de les recueillir, en vérifiant que l’on préserve à la fois les droits des personnes qui sont enregistrées et les nécessités de la recherche. Ces mises en regard ont conduit tout particulièrement à un Guide des bonnes pratiques [17]. L’usage des données orales va d’ailleurs au-delà de la communauté scientifique. Les langues de France font partie du patrimoine. C’est à ce titre que la DGLFLF [18] (la Délégation Générale à la Langue Française et aux Langues de France) a appuyé le travail de convergences qu’est le Guide des bonnes pratiques et qu’elle soutient depuis 5 ans le recueil et la mise à la disposition du grand public de données orales enrichies, via un portail dédié. En second lieu, le champ des données orales, comparativement à d’autres, était relativement structuré institutionnellement. La section 34 du CNRS – consacrée aux sciences du langage – a en effet créé deux fédérations de linguistique, l’une consacrée aux universaux de langage et à la typologique des langues, TUL, et l’autre, ILF, rassemblant les laboratoires travaillant en linguistique du français. Les deux fédérations animent un réseau d’équipes et de laboratoires producteurs et utilisateurs de corpus oraux. Elles travaillent avec la DGLFLF à la constitution de nouveaux corpus oraux mais aussi à la sauvegarde sous forme numérique de corpus analogiques. Elles ont contribué au Guide de bonnes pratiques. Par ailleurs, le CNRS a créé en 2006 des centres de ressources numériques [19] conçus pour faciliter l’utilisation mutualisée de données numériques. Ils ont été organisés par type de données : textuelles, géographiques, images et… orales. Un CRDO [20] (Centre de ressources pour la description de l’oral) a donc été mis sur pied, mais avec deux têtes, l’une au Laboratoire Parole et Langage d’Aix, l’autre alors au LACITO en région parisienne. Ces deux têtes ont agi, sinon de concert, du moins dans des directions finalement convergentes en mettant en ligne des données, en aidant au recueil et à la production de corpus. En troisième lieu, les données orales constituent un bon « banc d’essai ». Les données ne sont pas trop volumineuses ni trop complexes, par rapport par exemple aux données issues de la simulation en 3 dimensions. Dans le même temps, elles constituent déjà un défi sérieux. Au départ du projet, le volume à pérenniser avoisinait déjà les 2 téra-octets, soit deux mille milliards d’octets. Il mélangeait du son, de la vidéo et du texte. Les problèmes juridiques de la mise en ligne de ces données, s’ils avaient été défrichés par le Guide des bonnes pratiques, n’étaient pas pour autant entièrement résolus.

Volume et complexité « raisonnables » des données à pérenniser, structuration du champ, force des communautés scientifiques et d’usage, ces trois caractéristiques faisaient des données orales un point de départ propice pour la démarche expérimentale envisagée. Le Comité de pilotage a donc donné le feu vert au projet pilote en mars 2008. Il a fixé l’objectif d’une évaluation scientifique et technique à Pâques 2009. Il a donné mission de prendre contact avec la Direction des Archives de France (DAF). La DAF est en effet légalement en charge des données produites par les chercheurs dans le cadre de leurs fonctions : c’est donc cet organisme qui peut éventuellement donner délégation à un archiveur sur ce point. En reprenant une des conclusions du rapport Bärring , le Comité de Pilotage a en outre souhaité une solution assise sur deux importants centres de calcul, le CINES [21] à Montpellier et le CC-IN2P3 [22], à Villeurbanne.

La mise en place effective du projet pilote a débuté pendant l’été 2008. Alors directeur adjoint du TGE Adonis, j’ai assuré le suivi du projet au sein d’Adonis. Claude Huc, précédemment en charge de l’archivage numérique au CNES et responsable alors du groupe PIN – Préservation de l’informatique numérique [23], a accepté d’assurer la coordination technique et fonctionnelle du projet en tant que consultant. Les premières réunions ont été facilitées par les contacts pris à l’occasion de l’Université d’été organisée par le TGE Adonis en septembre 2008. Une évaluation à destination du Comité de Pilotage du TGE Adonis a été effectuée par Yves Marcoux, Professeur à l’Université de Montréal, en juin 2009. En octobre 2009, la DAF a examiné l’état du projet pilote. Le projet pilote s’est arrêté en juin 2010 : la mise en production de l’archivage des données orales en SHS a commencé alors.

La section suivante détaille les adaptations du modèle OAIS faites dans le cadre du projet pilote.

4 Du modèle OAIS à sa mise en œuvre

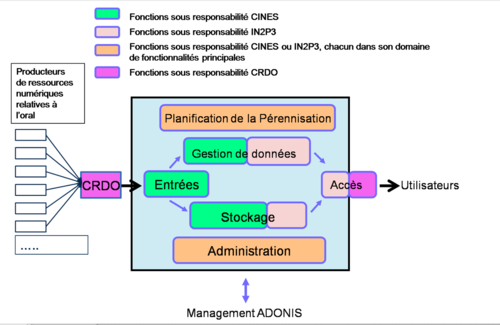

La mise en œuvre du modèle OAIS pour l’infrastructure mutualisée du TGE ADONIS s’appuie sur trois acteurs : le CRDO, porteur d’une expertise sur les données orales et deux centres informatiques majeurs, ce qui évite d’être contraint à des investissements initiaux importants. Une répartition des fonctions – et donc des responsabilités correspondantes – entre les acteurs est présentée Figure 7.

Le Centre Informatique de l’Enseignement Supérieur – CINES [21] est depuis plusieurs années en charge de l’archivage des thèses numériques des universités françaises, de celui des revues SHS numérisées hors embargo – Persée [24] et, plus récemment, de l’archive ouverte de pré-publications en ligne HAL [25]. Il dispose d’une compétence établie en matière de préservation de l’information numérique. Cette compétence, reconnue par la tutelle en 2007, couvre un large spectre d’activités : standardisation de la structure des « paquets de versement » transmis par les producteurs, définition des métadonnées de préservation indispensables, identification des formats de données recevables pour une préservation à long terme, contrôle et validation en profondeur de la conformité de toutes les données versées par rapport à ces formats, gestion multi-site du stockage, surveillance et renouvellement des supports physiques d’enregistrement, usage des empreintes numériques pour garantir l’intégrité des données, capacité de réversibilité consistant à restituer à l’identique, les données et métadonnées au producteur, etc. Cet ensemble opérationnel constitue la Plate-forme d’archivage du CINES – PAC [8]. Par contre, le CINES dispose d’une expérience moindre en matière de moyens de recherche, d’accès et de récupération des données. Cette fonction fondamentale d’accès à l’information est assumée par l’ABES (Agence bibliographique de l’enseignement supérieur) pour les thèses, par l’université Lyon 2 pour les revues du projet PERSEE [24], par HAL [25] pour les pré-publications en ligne ou par le CC-IN2P3 [22] pour l’infrastructure pilote d’archivage mise en place par le TGE ADONIS.

Le Centre de Calcul de l’Institut national de physique nucléaire et de physique des particules – CC-IN2P3 [22], lui-même une Très Grande Infrastructure de Recherche, est depuis longtemps en prise directe avec une large communauté d’utilisateurs (en France, 25 laboratoires et 2 500 personnes) dont il assure la gestion. Il a acquis des compétences solides en matière de virtualisation du calcul et du stockage de données. Cette virtualisation permet de s’abstraire des solutions ou technologies utilisées face à un problème donné, elle conduit les développeurs à réfléchir de façon indépendante des outils. En outre, il dispose d’une infrastructure de stockage phénoménale (en 2009 5 péta-octets – Po – de données en ligne ; 4 Po de disques ; 30 po sur cartouches) pour les besoins de la physique subatomique. Pour l’archivage Adonis, le CC-IN2P3 développe et opère tout ce qui peut être générique dans la fonction de gestion de données et d’accès : stockage en ligne et organisation des données au sein d’un modèle sous le logiciel Open source Fedora Commons [26], gestion des droits, transformations en vue de fournir aux utilisateurs des données au format souhaité, etc. A terme, le CC-IN2P3 pourrait offrir aussi des mécanismes de recherche transverses couvrant tous les domaines des SHS.

Le CINES et le CC-IN2P3 ne disposent pas de compétences métier particulières, tant pour ce qui concerne les données orales que pour les autres domaines des SHS. C’est ce qui confère une importance majeure au CRDO, dans une fonction de médiateur entre la communauté des corpus oraux et l’infrastructure d’archivage. Le CRDO est né du besoin – identifié par le CNRS – de concentrer une compétence technique en matière de corpus oraux, compétence souvent absente des laboratoires et des petites structures de recherche. Il concentre en pratique un savoir-faire technique sur les corpus oraux, sur les formats de données et les métadonnées associées ainsi que sur la manière d’agencer les données afin de produire des entités archivables. Il permet donc une collecte intelligente des corpus et leur mise en paquets de versement (SIP) conformes pour archivage après une validation technique. Emanation de la communauté des corpus oraux, le CRDO garde également la maîtrise de l’interface utilisateur pour la recherche et la récupération de données archivées. Pouvoir prendre en compte, dans cette interface, les spécificités et la terminologie habituelle de cette communauté est en effet essentiel. C’est pourquoi, Figure 7, le CRDO intervient aussi bien à l’entrée qu’à la sortie du dispositif d’archivage.

5 Construire des représentations partagées pour transmettre le numérique

L’archivage numérique pérenne n’est pas ni en première analyse ni sur le fond un problème technique, au sens étroit. La place réelle des infrastructures techniques (bande passante, système d’authentification, serveurs et dispositifs de stockage, etc.), celle des normes comme OAIS [6] et des standards de métadonnées comme Dublin Core [7] n’est en fait que l’aboutissement d’une démarche longue et délicate de co-construction d’une solution assumée par chacune des parties prenantes. Il ne s’agit donc pas simplement d’« instancier » le modèle OAIS, mais de trouver ensemble la manière de lui donner sens dans un contexte particulier. L‘inscription dans la durée d’une infrastructure de pérennisation de l’information numérique suppose, globalement la construction de représentations partagées entre les différentes parties prenantes. Il s’agit de s’accorder sur l’organisation des données et des métadonnées ainsi que sur le processus même d’archivage : responsabilités des différents acteurs ; ensemble des processus à mettre en place, avec leurs variantes ; indicateurs de bon fonctionnement, etc.

Pour que l’infrastructure fonctionne et apporte effectivement, de façon fiable, les services qui ont été définis, elle doit par conséquent résulter d’une étape de développement et de validation maîtrisée et conduite avec méthode. Dans le cadre du projet pilote, s’agissant d’une infrastructure multipartenaires, il était crucial de constituer une équipe cohérente, motivée, au sein de laquelle chacun dispose d’une vue claire de l’ensemble du projet et des fonctions et responsabilités qui lui sont confiées. Tout cela est passé par une définition précise et tenue à jour des tâches et du calendrier, par des réunions « physiques » toutes les six semaines et des téléconférences bimensuelles, toujours consignées par un compte-rendu, par la mise en place de moyens de communication et de collaboration (liste de diffusion, gestionnaire de projet, wiki [27]), et par une coordination fonctionnelle et technique rapprochée et neutre. Le coordinateur du projet avait donc la responsabilité de trouver des solutions aux désaccords éventuels entre partenaires, à ce titre, il doit être indépendant de ces partenaires. Dans ce cas comme de manière générale, la solidité ultime de la solution proposée repose sur celle de l’accord ainsi construit, sur la capacité des acteurs à s’entendre globalement comme dans le détail ainsi qu’à s’accorder sur des bonnes pratiques. La lenteur est de mise, sous peine de mécomptes.

On peut faire l’hypothèse que l’émergence d’une norme ou d’un standard dans un domaine correspond à une réification des conventions de la communauté sous-jacente. Cette émergence serait pour l’immatériel, pour les processus et les données numériques, l’équivalent de ce que Latour entend par « boîte noire » pour les instruments. La communauté scientifique a débattu sur ce qui était à mesurer, sur les erreurs de mesure acceptables, etc. Elle stabilise un consensus, éventuellement réexaminable, en un instrument, devenu « boîte noire » : le débat qui lui a donné naissance est clos, provisoirement au moins. On retrouve une situation proche de celle décrite par A. Desrosières [28] pour l’émergence des concepts et indicateurs statistiques : « La constitution d'un espace rendant possible le débat contradictoire sur les options de la cité suppose l'existence d'un minimum d'éléments de référence communs aux différents acteurs : langage pour mettre en forme les choses, pour dire les fins et les moyens de l'action, pour en discuter les résultats. Ce langage ne préexiste pas au débat. Il est négocié, stabilisé et inscrit, puis déformé et défait peu à peu, au fil des interactions propres à un espace et une période historique donnés. Ce n'est pas non plus un pur système de signes reflétant des choses existant en dehors de lui [...]. » Que l’on pense au taux de chômage par exemple. A. Desrosières souligne les liens complexes entre la stabilisation des catégories statistiques et l’évolution des appareils d’Etat : le besoin d’agir sur la réalité implique de s’accorder sur des notions et leur usage ; inversement disposer de notions et de « jurisprudences » sur leur emploi fournit des leviers sur le réel tout en transformant ce réel. C’est tout l’enjeu par exemple du débat récent sur les statistiques d’origine « ethnique ». Peut-on agir sur l’équité de l’accès aux emplois des Français de différentes origines sans disposer de « mesures » de ces origines et de leur répartition ? Mais inversement, de telles mesures constituent des « manières de voir » dont la maîtrise est problématique. A. Desrosières [29] conclut : « L'information statistique est un de ces langages, parmi d'autres, grâce auquel les acteurs sociaux peuvent se coordonner. ». Les normes et standards dans le domaine de l’archivage numérique comme ailleurs correspondent à une telle coordination. Mais pour qu’ils puissent jouer ce rôle, il faut que les acteurs d’un système de pérennisation donné les adaptent à leur « monde ». Le recours à des normes ou à des standards ne relève pas dans ce cas d’une simple « mise en musique », mais d’une démarche active mais lente d’appropriation. A. Desrosières (ibid.) ajoute : « ... ces espaces de formes durablement solidifiées [...] doivent à la fois être indiscutées pour que la vie suive son cours, et néanmoins discutables pour que la vie puisse changer de cours. » et invite à : « ... penser en même temps ces objets comme construits et réels, conventionnels et solides. ».

Le développement de l’archivage numérique pérenne depuis une quinzaine d’années dispose maintenant d’un corps de doctrine et d’expériences variées, y compris en France [30]. Ce développement peut être aussi considéré comme la conventionnalisation progressive d’un tel langage. Mais nous n’en sommes qu’aux premiers stades d’une telle évolution. Comme un instrument de mesure, le dispositif d’archivage, s’il réussit, devrait devenir une « boîte noire » pour les producteurs comme pour les utilisateurs de données, avec une vision et des protocoles clairs sur la manière d’y intégrer des données et d’y avoir accès. Nous n’en sommes pas là, loin s’en faut.

6 Pérenniser la pérennisation…

Les atouts du dispositif mis en place pour le projet pilote sont sa solidité, sa généricité et sa souplesse : solidité parce que le CINES et le CC-IN2P3 sont des structures stables, pérennes et expérimentées. Généricité parce que les moyens matériels et logiciels mis en œuvre pour l’archivage des données orales peuvent être utilisés sans changement pour les autres domaines des SHS quels qu’ils soient. Il s’ensuit une économie d’échelle considérable, et une réduction de la déperdition d'énergie au niveau des équipes de recherche, pour des activités qui ne relèvent pas des métiers des SHS. Souplesse parce que chaque domaine des SHS peut continuer à utiliser les métadonnées standards propres au domaine et disposer d’une interface d’accès aux données conforme à ses besoins. Cette souplesse est mise en évidence par le fait que les deux pôles du CRDO ont pour l’instant retenu deux localisations différentes pour l’implantation de leur application d’interface : l’une sera installée immédiatement sur le site du CC-IN2P3, l’autre pour quelque temps dans un laboratoire distant. Il en résulte, pour les autres domaines des SHS, que les autres centres de ressources numériques concernés (pour le texte, pour les images, etc.) pourront choisir la configuration la mieux adaptée à leur situation. Ces atouts du projet d’archivage ne doivent pas cacher les conditions à réunir pour le pérenniser.

Un premier volet concerne le dispositif humain et technique que préfigure le projet pilote. Il convient de fiabiliser les processus mis en œuvre : les logiciels (iRods [31] pour l’abstraction des systèmes de fichiers, des transferts et des actions déclenchées automatiquement par exemple pour préparer les données à diffuser ; Fedora Commons [26] pour les vues abstraites sur les données archivées) testés, installés, « réglés » pour un bon fonctionnement, incorporent, une fois opérationnels, toute une expérience à mémoriser (à archiver, donc…). Les choix techniques qui ont présidé à la sélection de tel ou tel composant doivent être documentés. Il en va de même des choix organisationnels. On l’a vu supra, il paraissait naturel de ne pas considérer directement les producteurs de données orales comme autant de « services versants » pour l’archive et de confier ce rôle à l’intermédiaire métier qu’est le CRDO. Maintenir la compréhension de ce positionnement compte pour le maintien et l’extension du projet pilote d’archivage : la situation est-elle comparable pour d’autres types de documents ? Pour les reconstitutions archéologiques en 3 dimensions, par exemple, faut-il parier également sur un truchement du même ordre ? Par ailleurs, une grande rigueur technique s’impose en matière de gestion des évolutions de l’infrastructure et de surveillance de la continuité du service. Pour cela, on doit s’appuyer sur des ressources stables et pérennes. C’est là un point critique qui concerne tous les partenaires. La faiblesse principale vient de l’absence de statut et de garantie de ressources pour le CRDO de la part de sa tutelle, fragilité qui caractérise l’ensemble des dispositifs du même type mis en place par le CNRS pour d’autres types de documents. La maîtrise de l’infrastructure mutualisée, la capacité à assurer une maintenance rapide et efficace, à gérer l’enrichissement de l’archive, impliquent des personnels permanents et parfaitement formés à ces tâches. On le sait, l’obtention de postes permanents pour des tâches nouvelles se heurte à l’orientation inverse des politiques publiques. Enfin, doit être progressivement dégagé un modèle financier viable, qui s’appuie sur l’évolution escomptable des volumes et des services nécessaires pour déterminer les coûts à consentir. De multiples études ont été déjà réalisées sur la question des coûts de l’archivage numérique. C’est le cas du projet LIFE (Life Cycle Information for E-literature) ou encore de la « Blue Ribbon Task Force » de la National Science Foundation. Malheureusement, ces projets n’abordent pas ou peu la phase cruciale et décisive de mise en place. Il faut pourtant le savoir, la mise en place d’un dispositif d’archivage ne sera pas immédiatement génératrice d’économies : les laboratoires et les individus conservent leurs équipements et leurs procédures de sauvegarde. Les économies d’échelle n’émergeront que progressivement, quand des transferts de charge pourront être effectuées. Ces transferts supposent une pédagogie de la mutualisation, qui là encore, construise une représentation partagée de la solution. Une première étape est sans doute de faire émerger les « coûts cachés » que représentent les sauvegardes désordonnées actuelles en matériel mais plus encore en temps de travail. La seconde revient à rapporter les coûts du dispositif mutualisé aux volumes sécurisés, à la fiabilité obtenue et au service fourni. Ce qui apparaît comme une dépense importante parce que globalisée l’est moins une fois rapporté aux dépenses invisibles actuelles et à l’apport pour la recherche.

En second lieu, cette infrastructure doit être reconnue, adoptée, soutenue par la communauté scientifique. Le choix d’une totale transparence a été retenu dès le début du projet. Cette transparence doit être aussi relayée par des actions de communication, de concertation, d’écoute auprès de la communauté. Cette visibilité du projet est essentielle et doit préparer la phase opérationnelle au cours de laquelle le pilotage sera scientifique. La finalité est scientifique et c’est l’intérêt de la communauté scientifique qui doit prévaloir à toutes les décisions essentielles, même si, en arrière plan, l’infrastructure s’appuie sur des compétences et des moyens techniques. L’identification de ce qui sera utile et précieux pour le futur, la définition des priorités dans les actions, la mise sur pied de coopérations, la participation à des projets internationaux doivent être guidées par les chercheurs.

En troisième lieu, les données archivées sont produites, pour la plupart, dans le cadre des activités d’équipes de recherches appartenant à des organismes publics. Leur conservation relève donc, en première analyse, de la responsabilité des Archives nationales. Leur prise en charge par l’infrastructure Adonis requiert un accord et une collaboration avec ces dernières afin de faire coïncider les impératifs de conservation du patrimoine et les exigences d’une base d’information scientifique vivante.

Un dernier volet de la stabilisation du dispositif d’archivage concerne le contexte de réorganisation de l’Etat et de la recherche. Mais ce contexte est générateur avant tout d’interrogations et d’inquiétudes. La première est celle de l’articulation inexistante actuellement entre ce dispositif à visée nationale, et les démarches qu’entament ou que ne manqueront pas d’entamer d’autres acteurs de la recherche : les nouveaux pôles universitaires (PRES et autres campus), les régions. La convergence des approches n’est pas assurée. Il n’existe d’ailleurs pas de « juge de paix » qui pourrait y œuvrer, et les forces centrifuges semblent dominer. La seconde inquiétude porte sur la volonté comme sur la capacité actuelle de l’Etat à une action cohérente et suivie en matière de Très Grandes Infrastructures et de Recherche en SHS. La lourdeur des investissements et les partenariats internationaux sécurisent pour une part les TGIR « historiques », en physique par exemple. Pour l’heure, malgré des effets d’annonce, les TGIR en activité en SHS occupent une portion congrue (1,5% du budget total annoncé des TGIR fin 2008…) et se résument sauf erreur… au TGE Adonis, lui-même menacé par les évolutions internes du CNRS, par la place mouvante et incertaine des SHS en son sein ainsi que par les désaccords entre ministère et CNRS tant sur la politique même d’équipement des SHS que sur les répartitions des rôles pour y parvenir.

7 Conclusion

La mise en place de l’archivage des données de la recherche en SHS peut contribuer à l’introduction de nouvelles manières de travailler. En concordance avec la mise en place du fonctionnement par projets « lourds » (à l’échelle des SHS…), l’archivage contribue à une vision « instrumentée » de la recherche qui dépasse le modèle de l’artisan ou de l’atelier d’artiste. C’est un tournant « industriel » qui s’esquisse peut-être. La préoccupation de la pérennisation, ici agissant a posteriori, sur des données déjà constituées, doit maintenant être intégrée dès l’amont : les projets ANR gagneraient à prévoir d’emblée les conditions de la pérennisation et du partage des données numériques qu’ils produisent. Cette évolution implique que la constitution de données « durables » soit considérée comme une dimension intrinsèque de l’activité de recherche, occupant une place spécifique dans l’évaluation des chercheurs et des laboratoires, sans quoi elle conservera une position ancillaire, gênant par là-même la perception des enjeux intellectuels sous-jacents. La stabilisation des données et de leur accès peut contribuer enfin à maintenir des liens étroits, directs (« cliquables ») entre les publications désormais souvent numériques et les données sur lesquelles elles s’appuient, à l’instar de ce qui a été exposé supra pour les observatoires virtuels en astronomie. Il en résulte de nouvelles manières de croiser les approches ou de vérifier les hypothèses et les conclusions d’une recherche.

Nous risquons aujourd’hui d’être submergés par un « tout numérique » qui ne réussit pas à déterminer vraiment ce qui est précieux, ce qui doit rester vivant et qui accumule les méga, les téra, les pétaoctets au motif que « ça peut toujours servir » : « … aujourd’hui, la technique incite à tout garder, quelle que soit la nature de l’objet concerné. […] on ne conserve plus parce que c’est important, mais c’est parce que l’on conserve que c’est important. Ou plutôt qu’on lui permet de le devenir » [2]. C’est La mémoire saturée [1], où le présent et les futurs possibles n’éclairent plus ce qui du passé est à conserver et ce dont il faut faire table rase. La taille de la Toile et les volumes nécessaires à son indexation en sont l’écho : « Les différents datacenters de Google représenteraient à eux seuls une capacité de 200 pétaoctets de stockage » [2], soit 200 000 téraoctets ou 200 millions de giga-octets, ce qui ramenés à notre échelle, à quelque chose de plus familier, correspond au moins à une centaine de milliards de livres de taille moyenne (en texte seul, hors mise en page et images). « Aujourd’hui, la mémoire et son culte font office d’“agents de liaison” entre un passé fantasmé, un présent inquiétant et un futur indéfinissable » [2]. P. Ricoeur [3], sous le titre « la mémoire empêchée » reprend à Freud [32] l’opposition entre la répétition du passé et sa remémoration, c’est-à-dire son élaboration, voire sa perlaboration, avec ce que cela suppose de choix et d’oubli. La répétition conduit à la pétrification du passé, la remémoration à sa réorganisation en fonction du présent et des futurs envisageables. L’hystérie mémorielle actuelle se conjugue aux nouvelles formes de momification que permet le numérique pour rendre difficiles histoire, oubli et élimination, alors que, pour reprendre M. Augé : « L'oubli est nécessaire à l'individu comme à la société » [33] et qu’« [il] est la force vive de la mémoire » (ibid.). Sans doute faut-il, dans le domaine de la recherche comme sur le plan personnel (ré)apprendre à oublier, pour savoir reconnaître et préserver ce qui est réellement précieux, ce qui doit rester vivant, puisqu’aussi bien « la mémoire est l’organisation collective d’un oubli sélectif » (Rony Brauman [34]).

- Remerciements

Je remercie Claude Huc pour m’avoir permis de reprendre une partie du matériel d’un commun article sur cette thématique [35]. Je remercie également pour leurs éclairants commentaires et suggestions tant mes collègues du projet pilote Adonis sur les données orales (Bernard Bel – LPL ; Pascal Dugénie – CINES ; Michel Jacobson – DAF ; Thomas Kachelhoffer – CC-IN2P3 ; Nicolas Larrousse – CINES) que ceux du projet archivage numérique d’EDF R&D (Ariane Bonneau ; Thierry Chauvier – à qui je dois les figures 4 et 5 ; Martine Le Corroller).

Bibliographie

- [1] Robin, R. (2003) La mémoire saturée. Paris : Stock.

- [2] Hoog, E. (2009) Mémoire année zéro. Paris : Seuil.

- [3] Ricoeur, P. (2000) La mémoire, l'histoire, l'oubli. Paris : Seuil.

- [4] A. Ernaux Les années Gallimard 2008

- [5] CCSDS – Consultative Committee for Space Data Systems. http://public.ccsds.org/

- [6] OAIS – CCSDS, 650.0-B-1, Reference Model for an Open Archival Information System (OAIS) ,ISO 14721, janvier 2002, http://public.ccsds.org/publications/archive/650x0b1.pdf

- [7] DUBLIN CORE – Jeu de métadonnées faisant l’objet d’un large consensus http://dublincore.org/

- [8] PAC – Plate-forme d’Archivage au CINES http://www.cines.fr/-l-application-PAC-.html

- [9] SPAR – Système de préservation et d’archivage réparti de la Bibliothèque nationale de France (BnF). http://www.bnf.fr/pages/infopro/numerisation/num_spar.htm

- [10] Site du Ministère de l’Enseignement Supérieur et de la Recherche (MESR) sur les TGIR http://www.roadmaptgi.fr/

- [11] Site du CNRS sur les TGIR http://www.cnrs.fr/fr/recherche/ups3019/feuilles-route-infrastructures.htm

- [12] OVS – Observatoire virtuel en astronomie – participation du CDS de Strasbourg http://cdsweb.u-strasbg.fr/CDS-f.gml

- [13] ESFRI – Coordination européenne des TGIR http://cordis.europa.eu/esfri/

- [14] Principales TGIR européennes en SHS : DARIAH http://www.dariah.eu/ ; CESSDA http://www.cessda.org/ ; CLARIN http://www.clarin.eu/

- [15] TGE Adonis – http://www.tge-adonis.fr/

- [16] Conclusions d’O. Bärring sur la mutualisation de l’hébergement et de l’archivage http://www.tge-adonis.fr/?Le-point-de-vue-d-Olof-Barring-du

- [17] Baude, O. (ed) (2006) Corpus oraux – Guide des bonnes pratiques 2006. Paris : Presses universitaires d'Orléans & CNRS Éditions. Egalement en ligne : http://hal.archives-ouvertes.fr/hal-00357706/fr/

- [18] DGLFLF – Délégation Générale à la Langue Française et aux Langues de France. http://www.dglf.culture.gouv.fr/ et ressources mises en place http://www.corpusdelaparole.culture.fr/

- [19] CRN – Centres de resources numériques SSH – pour les manuscrits : http://www.cn-telma.fr/ , les textes : http://www.cnrtl.fr/, les images : http://www.cn2sv.cnrs.fr/, et les données géographiques : http://www.m2isa.fr/ - pour l’oral, cf. [20].

- [20] CRDO – Centre de ressources pour la description de l’oral, dans son versant parisien : http://crdo.risc.cnrs.fr/ et aixois : http://crdo.fr/

- [21] CINES – Centre Informatique National de l’Enseignement Supérieur http://www.cines.fr/ et particulièrement http://www.cines.fr/-D-I-S-T-.html pour l’archivage pérenne

- [22] CC-IN2P3 – Centre de Calcul de l’Institut national de physique nucléaire et de physique des particules http://cc.in2p3.fr/

- [23] PIN] Groupe de travail sur la préservation de l’information numérique http://www-pin.aristote.asso.fr/

- [24] Persée – http://www.persee.fr/

- [25] HAL – http://hal.archives-ouvertes.fr/

- [26] FEDORA –. http://www.fedora-commons.org/

- [27] WIKI du projet pilote d’archivage des données orales au TGE Adonis – http://www.tge-adonis.fr/wiki/index.php/Accueil_Projet_pilote

- [28] Desrosières, A. (2000) La politique des grands nombres - Histoire de la raison statistique. Paris : La Découverte.

- [29] Desrosières, A. (2008) L'argument statistique, vol. I: Pour une sociologie historique de la quantification. Paris: Presses de l’École des Mines.

- [30] Banat-Berger, F. ; Duplouy, L. ; Huc, C. (2009) L'archivage numérique à long terme – les débuts de la maturité ? Paris : La Documentation Française.

- [31] iRODS – https://www.irods.org/

- [32] Freud, S. « Remémoration, répétition, perlaboration », in La technique psychanalytique, PUF, 1970

- [33] Augé, M. (1998) Les formes de l’oubli. Paris : Payot.

- [34] Brauman, R. & Finkielkraut, A. (2006) La discorde : Israël-Palestine, les Juifs, la France – Conversations avec Élizabeth Levy. Paris: Fayard.

- [35] B. Habert et C. Huc, Building together digital archives for research in social sciences and humanities, Social Science Information, vol. 49, n°3, septembre 2010, p. 415-443.

Notes

- ↑ Quelle est l’espérance de vie de l’URL mentionnée supra ?