Probabilité algorithmique : Différence entre versions

(→Probabilité algorithmique) |

(→Histoire et contexte scientifique) |

||

| Ligne 11 : | Ligne 11 : | ||

La probabilité algorithmique a été développée dans les années 1960 par [[Ray Solomonoff]], qui cherchait à établir une base mathématique pour l’[[Induction statistique]], c’est-à-dire la capacité à faire des prédictions à partir de données. Ses travaux ont été complétés par [[Andreï Kolmogorov]], qui a introduit la [[Complexité descriptive]], permettant de mesurer la longueur du plus court programme générant une donnée. [[Gregory Chaitin]] a approfondi cette théorie en étudiant les données incompressibles, c’est-à-dire celles ne pouvant être représentées par un programme plus court qu’elles-mêmes. Parallèlement, [[Leonid Levin]] a exploré les liens entre la complexité algorithmique et d’autres problèmes fondamentaux de l’informatique, influençant des domaines comme la [[Statistique bayésienne]] et la [[Philosophie de la connaissance]]. | La probabilité algorithmique a été développée dans les années 1960 par [[Ray Solomonoff]], qui cherchait à établir une base mathématique pour l’[[Induction statistique]], c’est-à-dire la capacité à faire des prédictions à partir de données. Ses travaux ont été complétés par [[Andreï Kolmogorov]], qui a introduit la [[Complexité descriptive]], permettant de mesurer la longueur du plus court programme générant une donnée. [[Gregory Chaitin]] a approfondi cette théorie en étudiant les données incompressibles, c’est-à-dire celles ne pouvant être représentées par un programme plus court qu’elles-mêmes. Parallèlement, [[Leonid Levin]] a exploré les liens entre la complexité algorithmique et d’autres problèmes fondamentaux de l’informatique, influençant des domaines comme la [[Statistique bayésienne]] et la [[Philosophie de la connaissance]]. | ||

| − | [[Fichier:Images?q=tbn-ANd9GcRKCaLD2IjWTBMQYnL4TkotjwB3m5mMBzrwrA&s.jpeg| | + | [[Fichier:Images?q=tbn-ANd9GcRKCaLD2IjWTBMQYnL4TkotjwB3m5mMBzrwrA&s.jpeg|200px|right|Machine de Turing universelle]] |

== Définition formelle et formules == | == Définition formelle et formules == | ||

Version du 28 avril 2025 à 07:37

Sommaire

Probabilité algorithmique

Introduction et définition

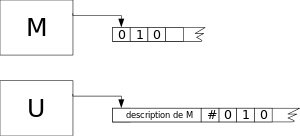

La probabilité algorithmique est un concept fondamental en Théorie de l'information et en Complexité algorithmique. Elle permet d’évaluer la simplicité d’une suite de symboles en mesurant la probabilité qu’une Machine de Turing universelle la génère à partir d’un programme choisi aléatoirement. L’idée principale repose sur le fait que les programmes les plus courts sont plus susceptibles de produire une sortie donnée que les programmes plus longs. Cela rejoint le Principe de parcimonie (ou rasoir d’Ockham), qui favorise les explications les plus simples. Ce concept a des applications en Statistique, en Apprentissage automatique et en modélisation des Systèmes complexes.

Histoire et contexte scientifique

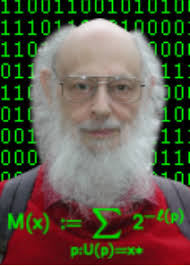

La probabilité algorithmique a été développée dans les années 1960 par Ray Solomonoff, qui cherchait à établir une base mathématique pour l’Induction statistique, c’est-à-dire la capacité à faire des prédictions à partir de données. Ses travaux ont été complétés par Andreï Kolmogorov, qui a introduit la Complexité descriptive, permettant de mesurer la longueur du plus court programme générant une donnée. Gregory Chaitin a approfondi cette théorie en étudiant les données incompressibles, c’est-à-dire celles ne pouvant être représentées par un programme plus court qu’elles-mêmes. Parallèlement, Leonid Levin a exploré les liens entre la complexité algorithmique et d’autres problèmes fondamentaux de l’informatique, influençant des domaines comme la Statistique bayésienne et la Philosophie de la connaissance.

Définition formelle et formules

La probabilité algorithmique d’une chaîne x se définit comme la somme des probabilités de tous les programmes p qui, lorsqu’ils sont exécutés sur une machine de Turing universelle U, produisent x. Cette relation est exprimée par la formule suivante :

- m(x) = ∑_{U(p)=x} 2^{-∣p∣}

où ∣p∣ représente la longueur du programme p en bits. Plus un programme est long, moins il a de chances d’être choisi aléatoirement, car chaque bit supplémentaire divise par deux sa probabilité. Cette somme ne donne pas toujours un total de 1, contrairement à une vraie probabilité, ce qui fait de m(x) une semi-mesure. Un résultat important de cette théorie est que la probabilité algorithmique est relativement indépendante du choix de la machine de Turing universelle utilisée, à une constante additive près.

Applications et liens avec d’autres domaines

La probabilité algorithmique est un outil fondamental dans plusieurs domaines. En Intelligence artificielle et Apprentissage automatique, elle sert de base à des méthodes de prédiction et d’induction. Dans le domaine de la Compression de données, elle permet d’identifier le programme le plus court capable de générer une séquence donnée. En Statistique, elle contribue à l’évaluation de la complexité des modèles, favorisant ceux qui offrent une explication plus simple des phénomènes observés. En Bioinformatique, elle est utilisée pour analyser les séquences génétiques et détecter des motifs pertinents. En Neurosciences, elle permet d’étudier la manière dont le cerveau traite l’information. Enfin, elle intervient en Économie et en Physique pour modéliser des systèmes complexes et analyser les phénomènes naturels.

Limites et perspectives

Bien que la probabilité algorithmique soit un concept puissant, elle présente plusieurs limites. L’un de ses principaux obstacles est l’impossibilité de calculer exactement la Complexité de Kolmogorov, ce qui rend son application directe difficile. Pour contourner ce problème, les chercheurs utilisent des approximations qui ne garantissent pas toujours une précision optimale. Une autre difficulté réside dans la dépendance au choix de la machine de Turing universelle, bien que cette dépendance soit limitée par une constante. De plus, les calculs impliqués nécessitent une grande puissance de traitement, ce qui complique leur mise en œuvre pratique. Les recherches actuelles se concentrent sur l’amélioration des méthodes d’estimation et sur le développement de modèles probabilistes plus faciles à manipuler. L’impact de cette approche sur l’Intelligence artificielle et la prise de décision automatique est également un sujet d’intérêt croissant. Malgré ces défis, la probabilité algorithmique reste une approche prometteuse pour comprendre la complexité et l’information dans de nombreux domaines scientifiques.