L'apprentissage automatique : Différence entre versions

(Page créée avec « = Probabilité algorithmique = == Introduction et définition == La '''probabilité algorithmique''' est un concept fondamental en Théorie de l'information et en ... ») |

|||

| (2 révisions intermédiaires par 2 utilisateurs non affichées) | |||

| Ligne 1 : | Ligne 1 : | ||

| − | + | "[[Fichier:apprentisage.png|300px|thumb]]" | |

| − | == | + | == Définition de l'apprentissage automatique == |

| + | L'apprentissage automatique, ou ''machine learning'' en anglais, est une branche de l'intelligence artificielle qui vise à développer des algorithmes permettant aux systèmes informatiques d'apprendre à partir de données et d'améliorer leurs performances sans être explicitement programmés. Il repose sur la création de modèles capables de généraliser des comportements ou des prédictions à partir d'exemples préalables. | ||

| − | + | == Types d'apprentissage automatique == | |

| + | Il existe plusieurs types d'apprentissage automatique, dont l'apprentissage supervisé, l'apprentissage non supervisé et l'apprentissage par renforcement. | ||

| + | * L'apprentissage supervisé utilise des données d'entraînement labellisées pour apprendre à faire des prédictions ou des classifications. | ||

| + | * L'apprentissage non supervisé, en revanche, s'appuie sur des données non labellisées afin d'identifier des structures ou des regroupements dans les données. | ||

| + | * L'apprentissage par renforcement repose sur un système de récompenses pour inciter le modèle à adopter des comportements optimaux. | ||

| − | == | + | == Applications de l'apprentissage automatique == |

| + | Les applications de l'apprentissage automatique sont vastes et touchent de nombreux domaines. Par exemple, il est utilisé dans : | ||

| + | * les systèmes de recommandation, | ||

| + | * la reconnaissance vocale, | ||

| + | * la vision par ordinateur, | ||

| + | * les voitures autonomes, | ||

| + | * et la détection de fraudes. | ||

| + | En exploitant de grandes quantités de données, ces systèmes peuvent améliorer continuellement leur précision et leurs performances. | ||

| − | + | == Défis et limites == | |

| + | Cependant, l'apprentissage automatique présente également des défis et des limites. Parmi ceux-ci figurent : | ||

| + | * la nécessité de grandes quantités de données, | ||

| + | * les biais algorithmiques, | ||

| + | * la difficulté d'interprétation des résultats, | ||

| + | * et les enjeux éthiques liés à l'utilisation de ces technologies. | ||

| + | Ces aspects font l'objet de recherches continues pour améliorer la fiabilité et la transparence des modèles. | ||

| − | == | + | == Perspectives et responsabilités == |

| − | + | En somme, l'apprentissage automatique représente une révolution dans le traitement de l'information et ouvre des perspectives immenses pour l'innovation technologique. Son développement s'accompagne néanmoins de responsabilités importantes afin d'assurer une utilisation éthique et inclusive. | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

Version actuelle datée du 28 avril 2025 à 07:35

"

"

Sommaire

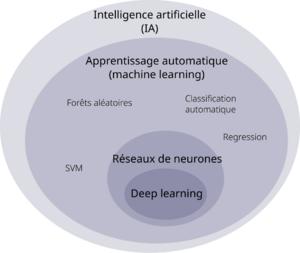

Définition de l'apprentissage automatique

L'apprentissage automatique, ou machine learning en anglais, est une branche de l'intelligence artificielle qui vise à développer des algorithmes permettant aux systèmes informatiques d'apprendre à partir de données et d'améliorer leurs performances sans être explicitement programmés. Il repose sur la création de modèles capables de généraliser des comportements ou des prédictions à partir d'exemples préalables.

Types d'apprentissage automatique

Il existe plusieurs types d'apprentissage automatique, dont l'apprentissage supervisé, l'apprentissage non supervisé et l'apprentissage par renforcement.

- L'apprentissage supervisé utilise des données d'entraînement labellisées pour apprendre à faire des prédictions ou des classifications.

- L'apprentissage non supervisé, en revanche, s'appuie sur des données non labellisées afin d'identifier des structures ou des regroupements dans les données.

- L'apprentissage par renforcement repose sur un système de récompenses pour inciter le modèle à adopter des comportements optimaux.

Applications de l'apprentissage automatique

Les applications de l'apprentissage automatique sont vastes et touchent de nombreux domaines. Par exemple, il est utilisé dans :

- les systèmes de recommandation,

- la reconnaissance vocale,

- la vision par ordinateur,

- les voitures autonomes,

- et la détection de fraudes.

En exploitant de grandes quantités de données, ces systèmes peuvent améliorer continuellement leur précision et leurs performances.

Défis et limites

Cependant, l'apprentissage automatique présente également des défis et des limites. Parmi ceux-ci figurent :

- la nécessité de grandes quantités de données,

- les biais algorithmiques,

- la difficulté d'interprétation des résultats,

- et les enjeux éthiques liés à l'utilisation de ces technologies.

Ces aspects font l'objet de recherches continues pour améliorer la fiabilité et la transparence des modèles.

Perspectives et responsabilités

En somme, l'apprentissage automatique représente une révolution dans le traitement de l'information et ouvre des perspectives immenses pour l'innovation technologique. Son développement s'accompagne néanmoins de responsabilités importantes afin d'assurer une utilisation éthique et inclusive.